感知器是一种可以直接得到线性判别函数

1.线性可分与线性不可分

首先,为了打好基础,我们将上面线性判别函数中的样本向量x增加一维常数,我们称为增广样本向量,并记为y: (1)

(1)

(1)

(1)

同样地,对于权向量,也做这样的增广,称之为增广权向量: (2)

(2)

(2)

(2)

因此,我们有了不一样的线性判别函数形式: (3)

(3)

(3)

(3)

对应的决策规则就变成:g(y)>0,则决策为w1类,g(y)<0,决策为w2类。

好了,现在我们可以来解释线性可分和不可分了:

假设一组样本y1,y2,yn,如果存在这样一个权向量 ,使得任何一个样本都满足“属于w1类,g(y)>0;属于w2类,g(y)<0”这样一个条件,那么我们就说这一组样本是线性可分的,即在样本特征空间中,至少会存在一个决策面可以将两类样本正确无误的区分开,反之找不到一个决策面来区分的话,就说样本是线性不可分的。

,使得任何一个样本都满足“属于w1类,g(y)>0;属于w2类,g(y)<0”这样一个条件,那么我们就说这一组样本是线性可分的,即在样本特征空间中,至少会存在一个决策面可以将两类样本正确无误的区分开,反之找不到一个决策面来区分的话,就说样本是线性不可分的。

,使得任何一个样本都满足“属于w1类,g(y)>0;属于w2类,g(y)<0”这样一个条件,那么我们就说这一组样本是线性可分的,即在样本特征空间中,至少会存在一个决策面可以将两类样本正确无误的区分开,反之找不到一个决策面来区分的话,就说样本是线性不可分的。

,使得任何一个样本都满足“属于w1类,g(y)>0;属于w2类,g(y)<0”这样一个条件,那么我们就说这一组样本是线性可分的,即在样本特征空间中,至少会存在一个决策面可以将两类样本正确无误的区分开,反之找不到一个决策面来区分的话,就说样本是线性不可分的。

对于感知器,我们要求样本必须是线性可分的,因为它作为一种最最简单的学习机器,目前还无法很好的解决线性不可分的情况(当然,有了解决不可分的算法),即便是不可分的情况,人们也更加倾向于使用其他算法,这也是感知器无法应用到更多实践场合的原因。

2.感知器的准则函数

对于一个新的样本Y,如果满足以下式子,就称之为规范化的增广样本向量:

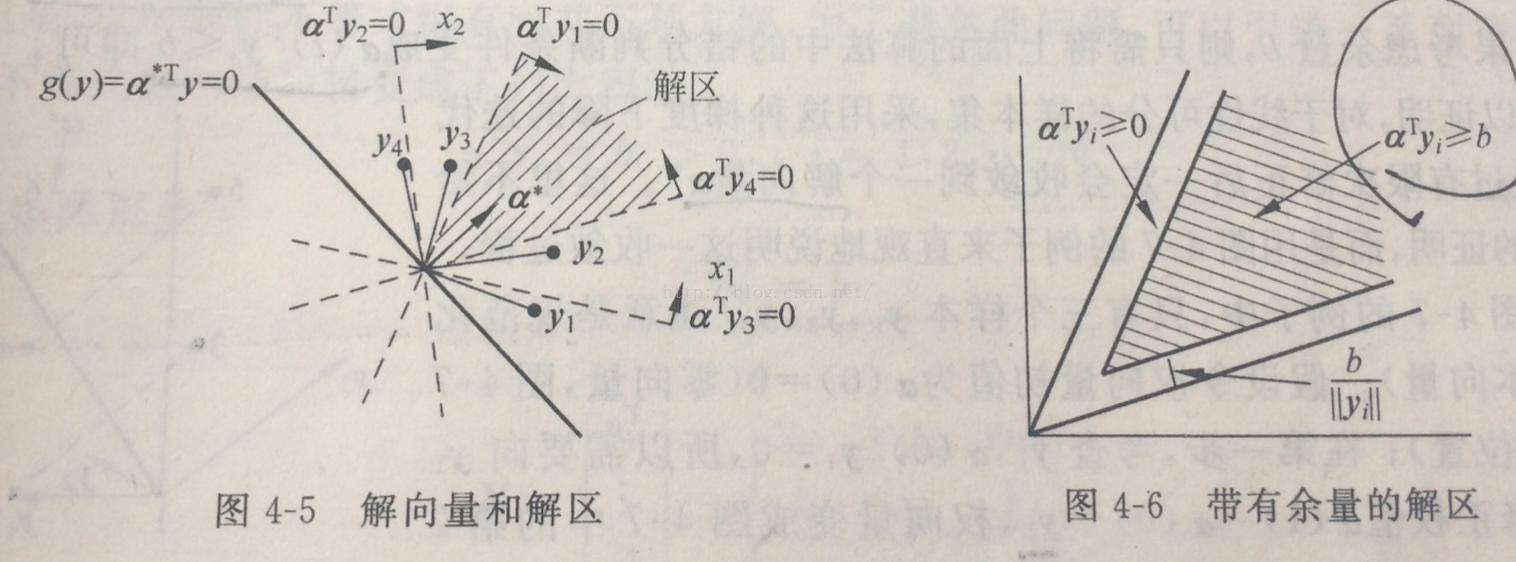

对于一组线性可分的样本y1,y2,yn(注,这里是已经规范化了的增广样本向量,只是为了统一记法而做的改变),如果一个权向量 满足

满足 ,则

,则 就是权值空间的一个解向量,所有的解向量组合起来形成的区域就叫解区。很明显,根据线性代数的知识,该解区位于所有样本对应的超平面(这个超平面由

就是权值空间的一个解向量,所有的解向量组合起来形成的区域就叫解区。很明显,根据线性代数的知识,该解区位于所有样本对应的超平面(这个超平面由 确定,过原点的)的正侧区域的交集,如下图左侧:

确定,过原点的)的正侧区域的交集,如下图左侧:

满足

满足 ,则

,则 就是权值空间的一个解向量,所有的解向量组合起来形成的区域就叫解区。很明显,根据线性代数的知识,该解区位于所有样本对应的超平面(这个超平面由

就是权值空间的一个解向量,所有的解向量组合起来形成的区域就叫解区。很明显,根据线性代数的知识,该解区位于所有样本对应的超平面(这个超平面由 确定,过原点的)的正侧区域的交集,如下图左侧:

确定,过原点的)的正侧区域的交集,如下图左侧:

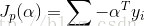

对此,有人提出了异议,他表示对于那些刚刚恰好大于0的样本来说,可能就未必是正确的分类,为什么呢,因为不可避免的会受到噪声、计算过程中的数值误差等因素的影响,所以这样得到的解区未必是完全正确的有效解,所以有人提出了‘余量’的概念,即在解区的靠近边缘部分留有一定冗余量(如上图右侧),得到更加靠近中间区域的解区,这样产生的结果也许更准确可靠。假设引入的余量为b,且大于0,此时所有的解向量均满足:

(4)

(4)

针对上式情况下,为了求解向量,先利用错误分类的样本进行求和运算来定义一个错分的惩罚函数,表示如下:

(5)

(5)

该公式便是感知器在线性可分样本下的准则函数。

3.准则函数的求解

为了求解感知器的准则函数,就是找到一个解向量,使得惩罚函数最小化。

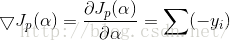

对于错分的样本都满足 ,很明显是当其值为0时最小,下面利用机器学习中常用的经典梯度下降方法来迭代;先给出惩罚函数对于解向量的梯度公式:

,很明显是当其值为0时最小,下面利用机器学习中常用的经典梯度下降方法来迭代;先给出惩罚函数对于解向量的梯度公式:

,很明显是当其值为0时最小,下面利用机器学习中常用的经典梯度下降方法来迭代;先给出惩罚函数对于解向量的梯度公式:

,很明显是当其值为0时最小,下面利用机器学习中常用的经典梯度下降方法来迭代;先给出惩罚函数对于解向量的梯度公式:

(6)

(6)

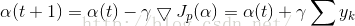

利用梯度下降,有:

(7)

(7)

其中,gamma是调整步长,第二项就是一个迭代的修正量;

当然,我们都知道这种对所有错分样本放到一起进行修正的做法是不妥当的,更妥当的办法是对每一个错分样本都单独修正,且每次都使用同一个固定步长,假如设步长为1:

step1:t=0时刻,初始权向量 ;

;

;

;

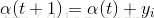

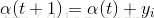

step2:对于样本yi,如果 ,就做如下修正:

,就做如下修正: ,否则的话继续;

,否则的话继续;

,就做如下修正:

,就做如下修正: ,否则的话继续;

,否则的话继续;

step3:对于后续样本跳到step2,直到所有样本都不满足 终止迭代;

终止迭代;

终止迭代;

终止迭代;

这样经过有限步的迭代修正,最终总能够收敛到一个解向量,另外还可以使用变步长来调整修正,公式如下:

(8)

(8)4.总结

感知器虽然简单,但是却是学习其他学习算法的基础,因此有必要掌握。

这里我们要求样本是线性可分的,没有考虑线性不可分的样本情况,如果你想尝试一下,将感知器利用到不可分的情况中的话,你就会慢慢发现,梯度下降的迭代过程是无法收敛的,即找不到一个收敛的解,这是没意义的。

2354

2354

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?