这篇文章和上一篇文章正是我所需要的内容,找到的时候非常高兴,特别感谢作者Clear-。

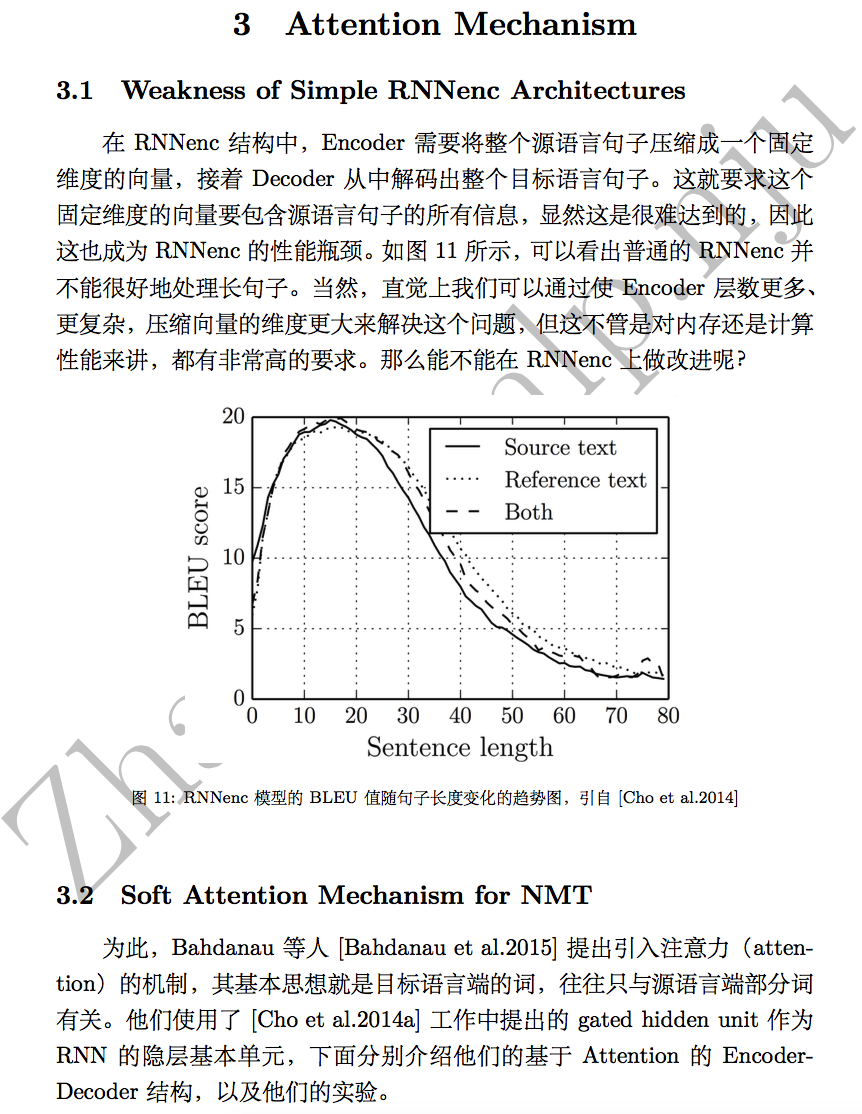

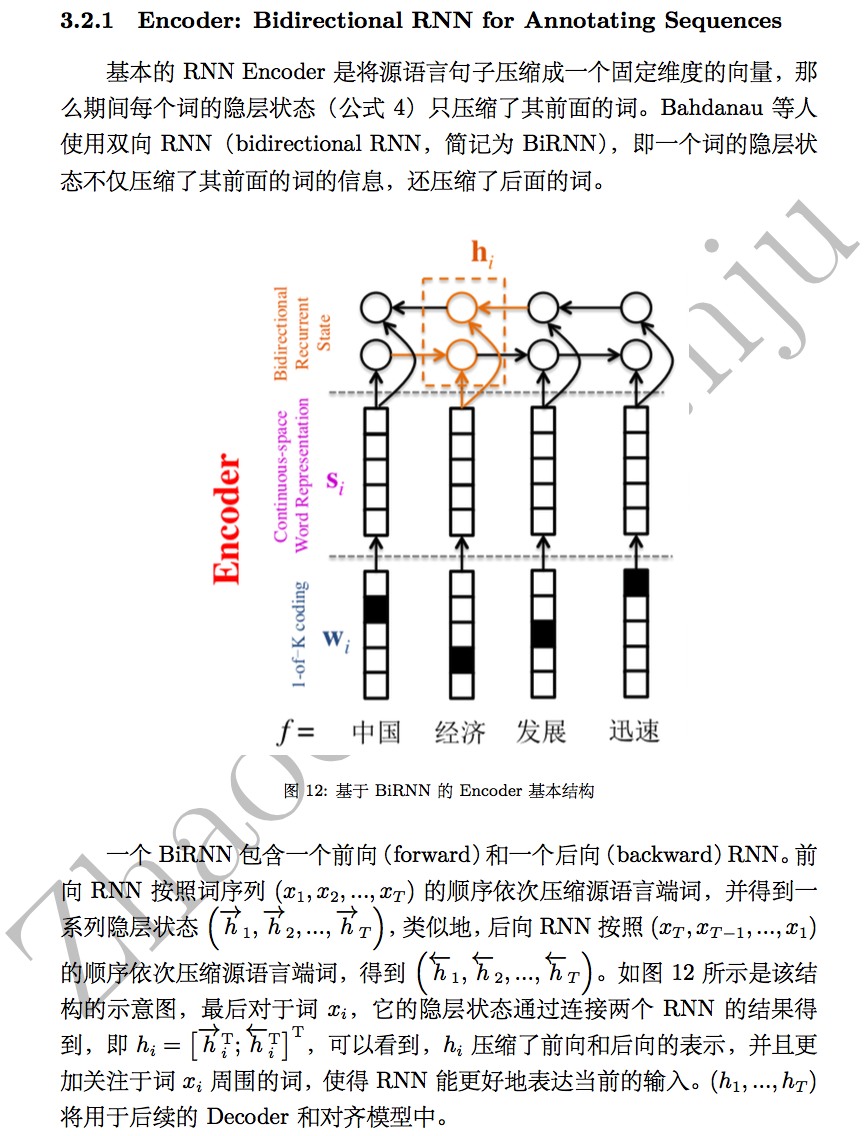

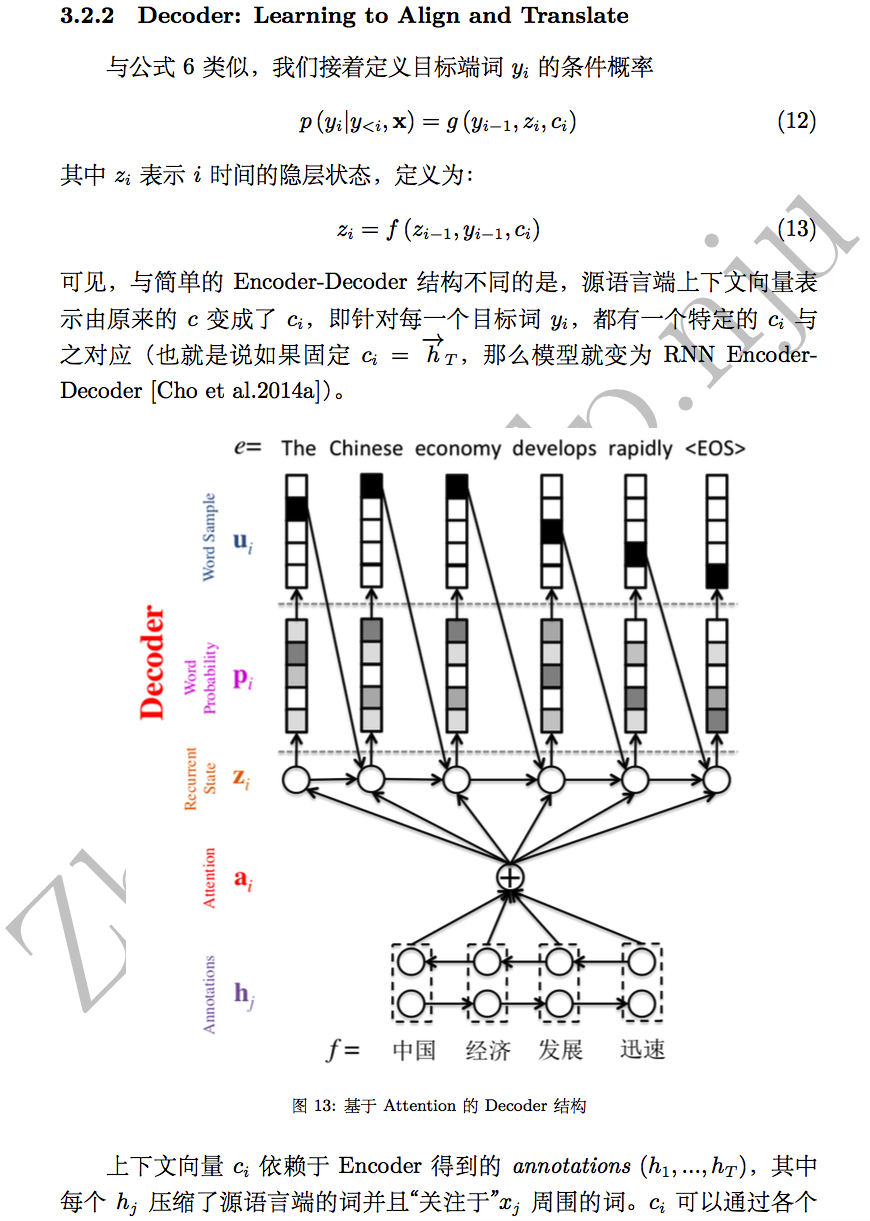

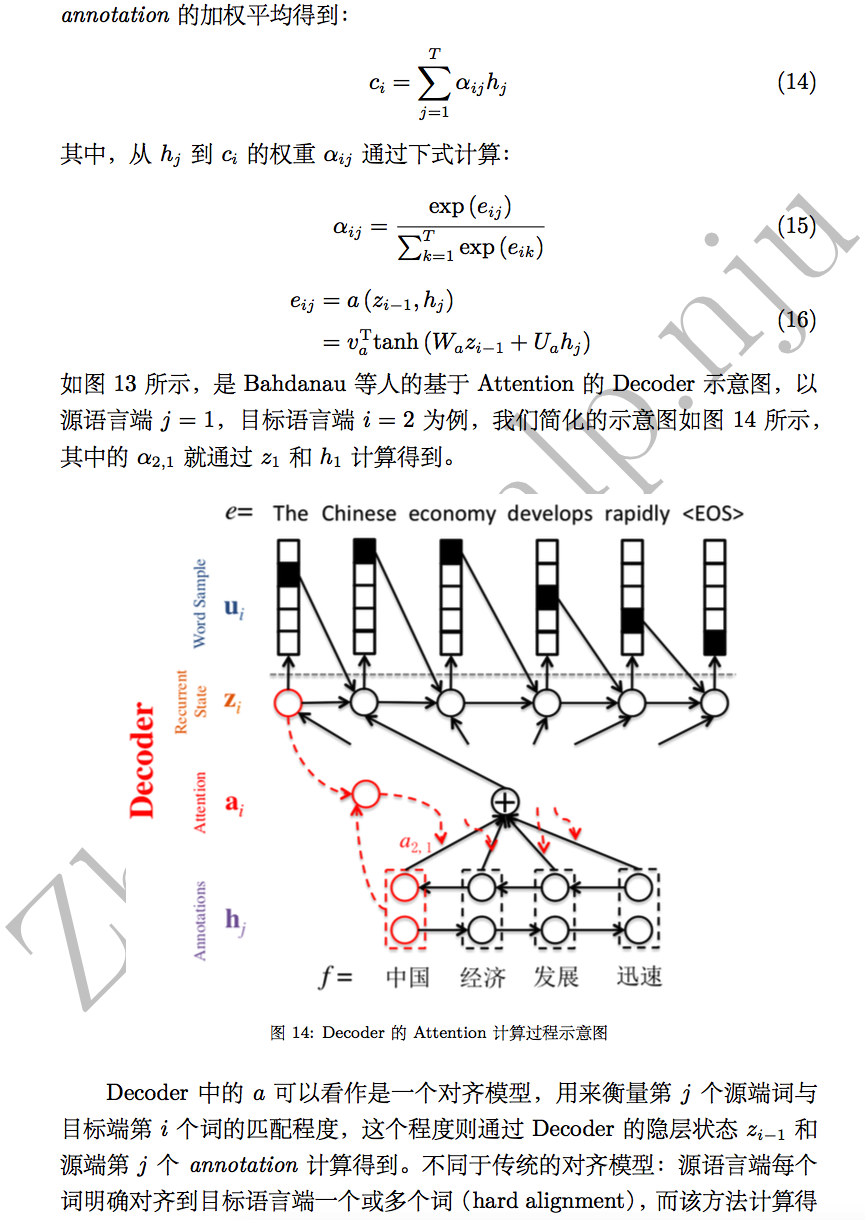

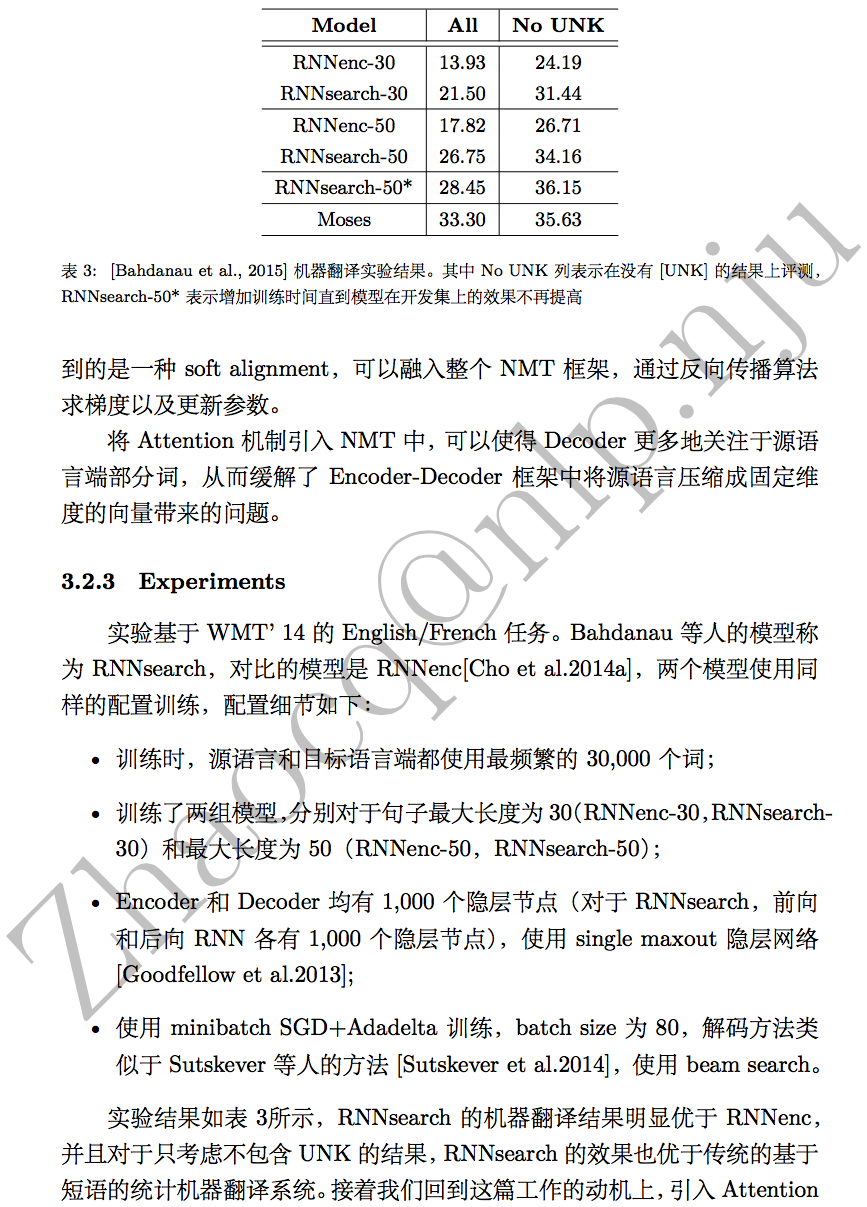

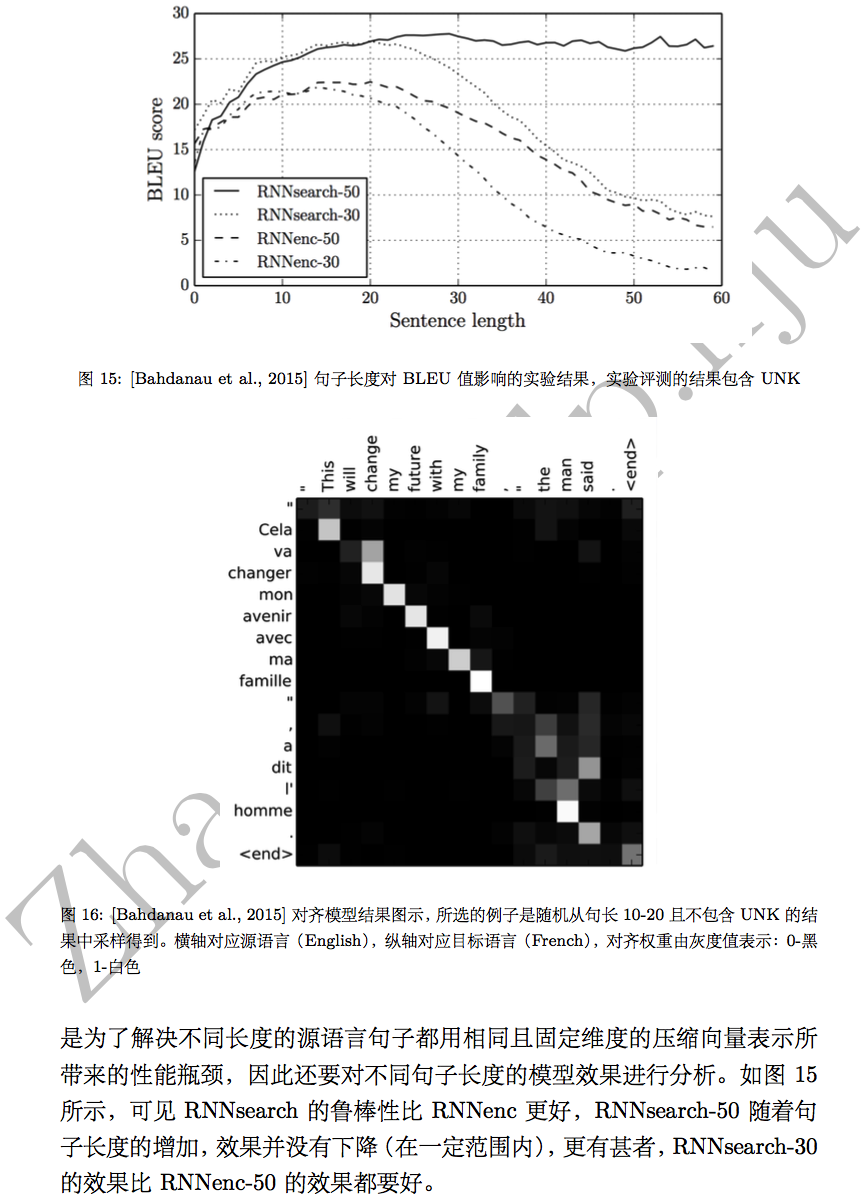

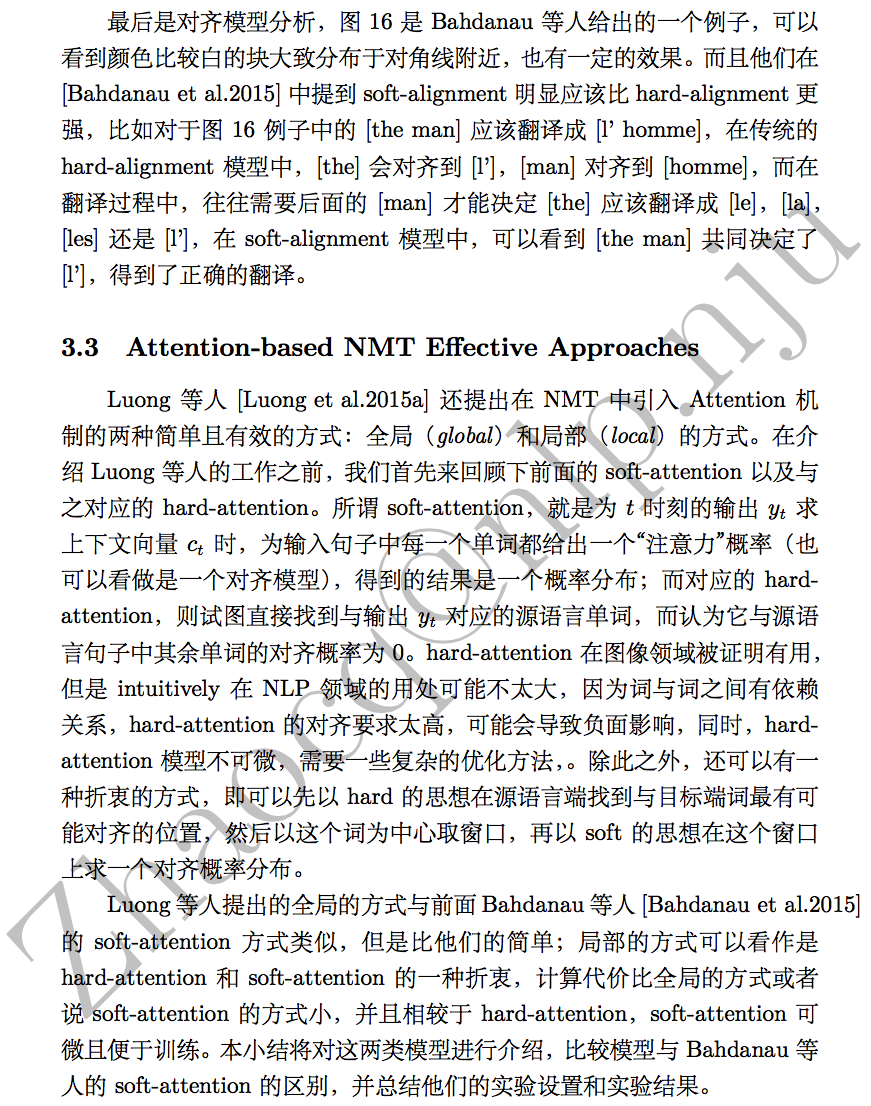

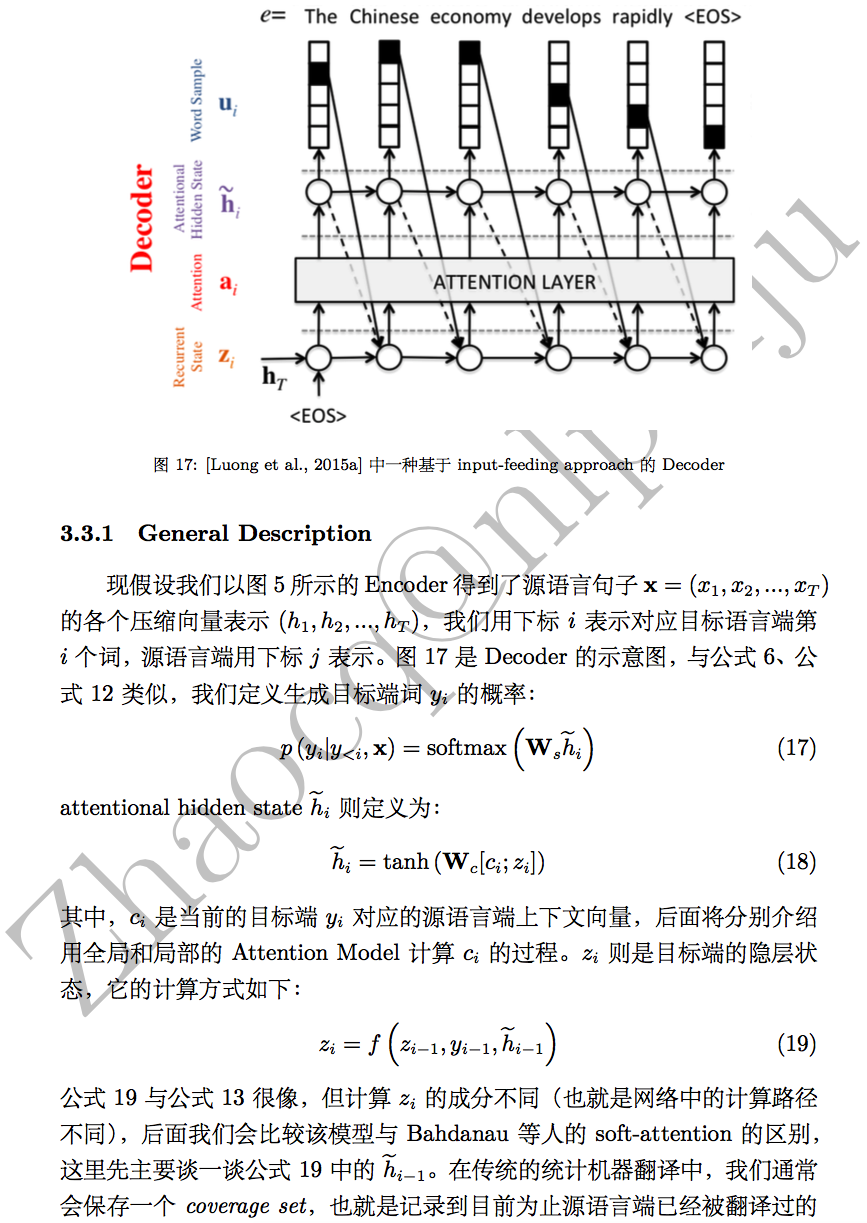

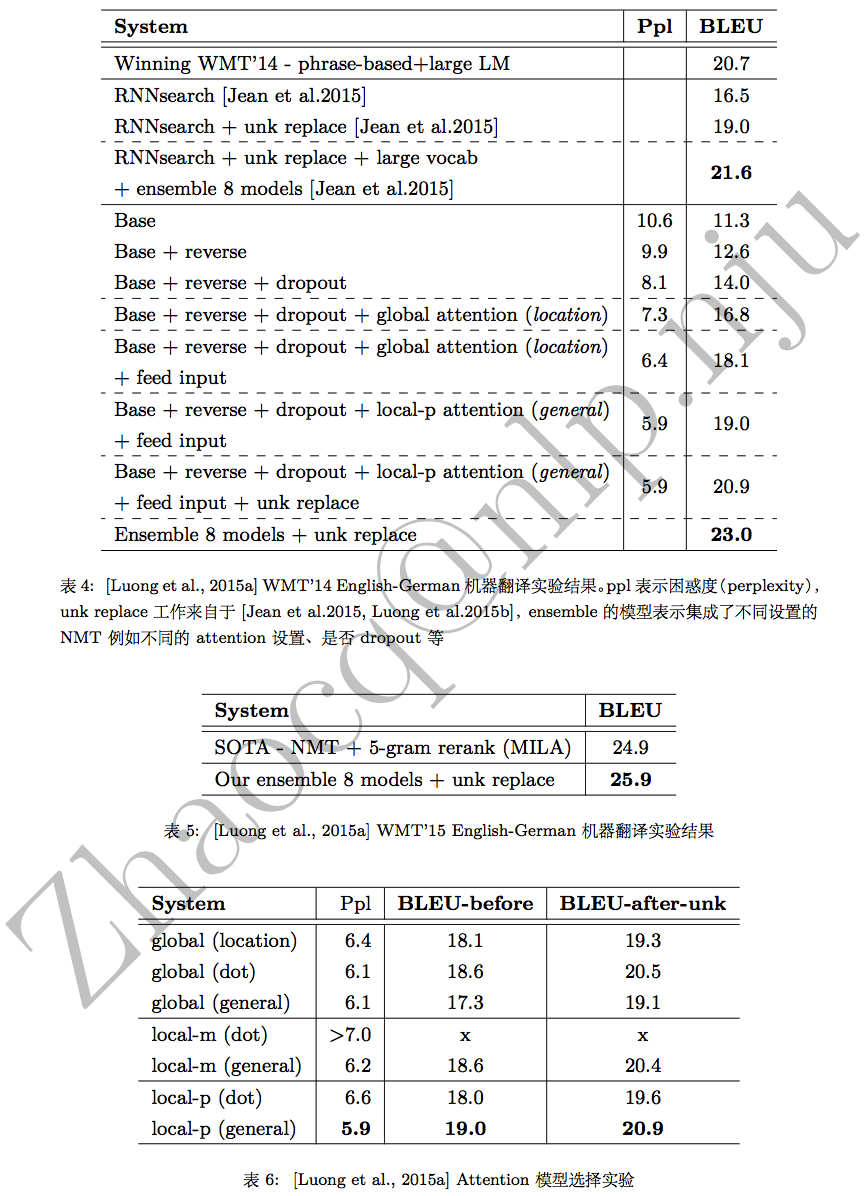

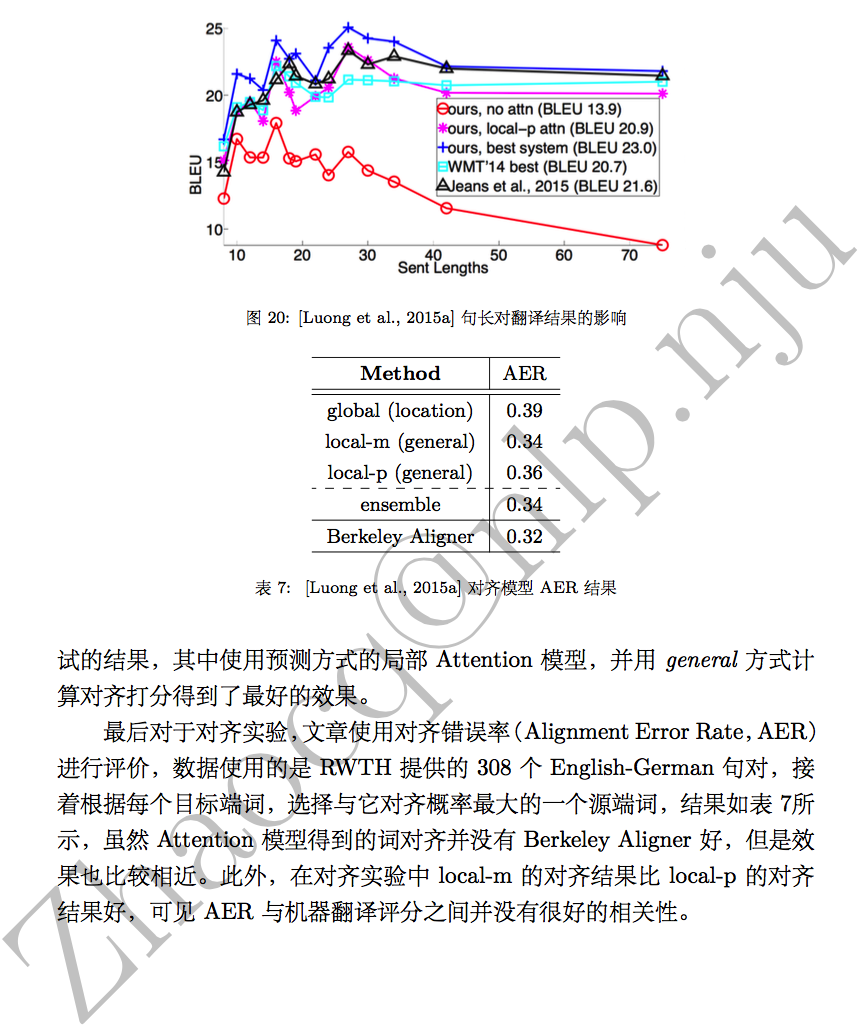

端到端的神经网络机器翻译(End-to-End Neural Machine Translation)是近几年兴起的一种全新的机器翻译方法。前篇NMT介绍的基本RNN Encoder-Decoder结构,RNNenc将源语言句子压缩成一个固定维度的向量是造成性能瓶颈的主要原因。为此,Bengio研究组提出基于注意力(Attention)的NMT,能较好的缓解这一问题并且能更好地处理长距离依赖。本文将介绍这项工作,以及后来Luong等人提出的引入Attention的两种不同的方式等。

转载请注明出处:http://blog.csdn.net/u011414416/article/details/51057789

本文详细介绍的工作有:

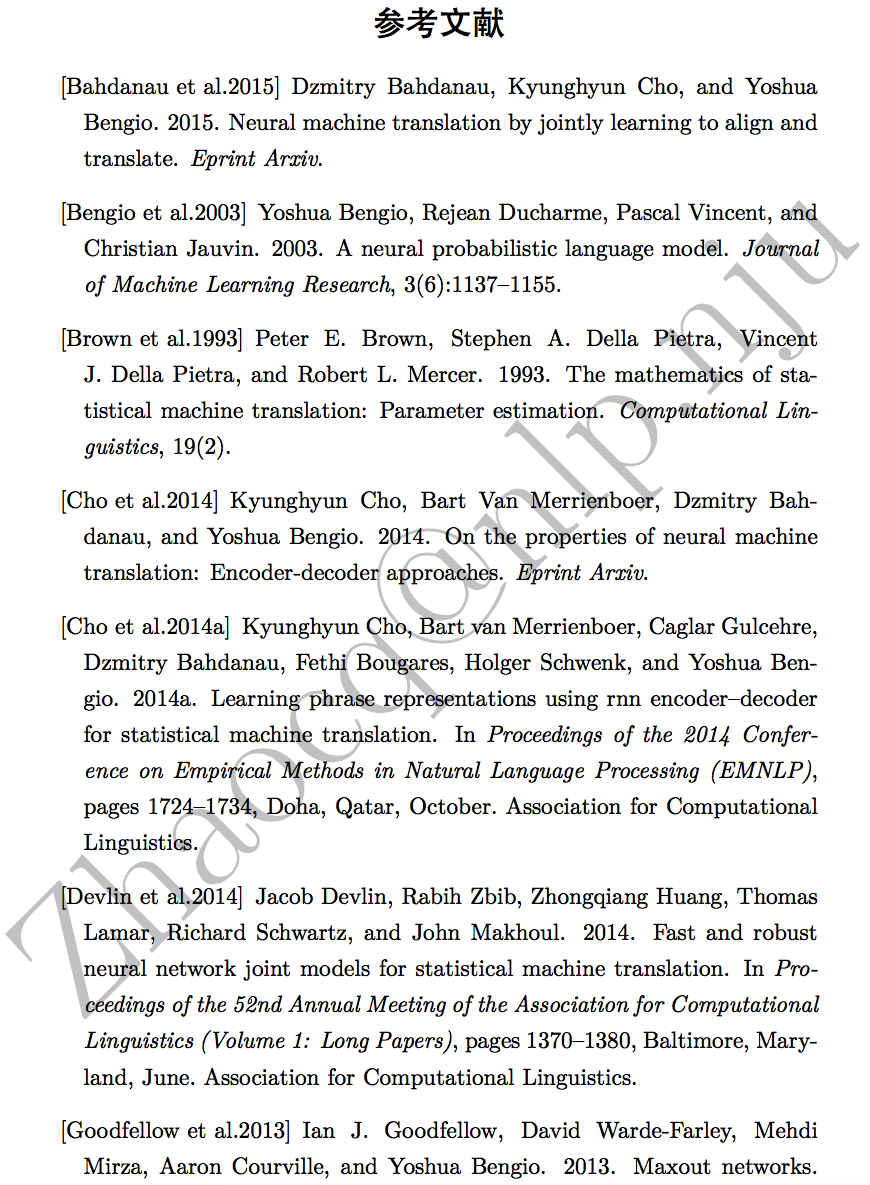

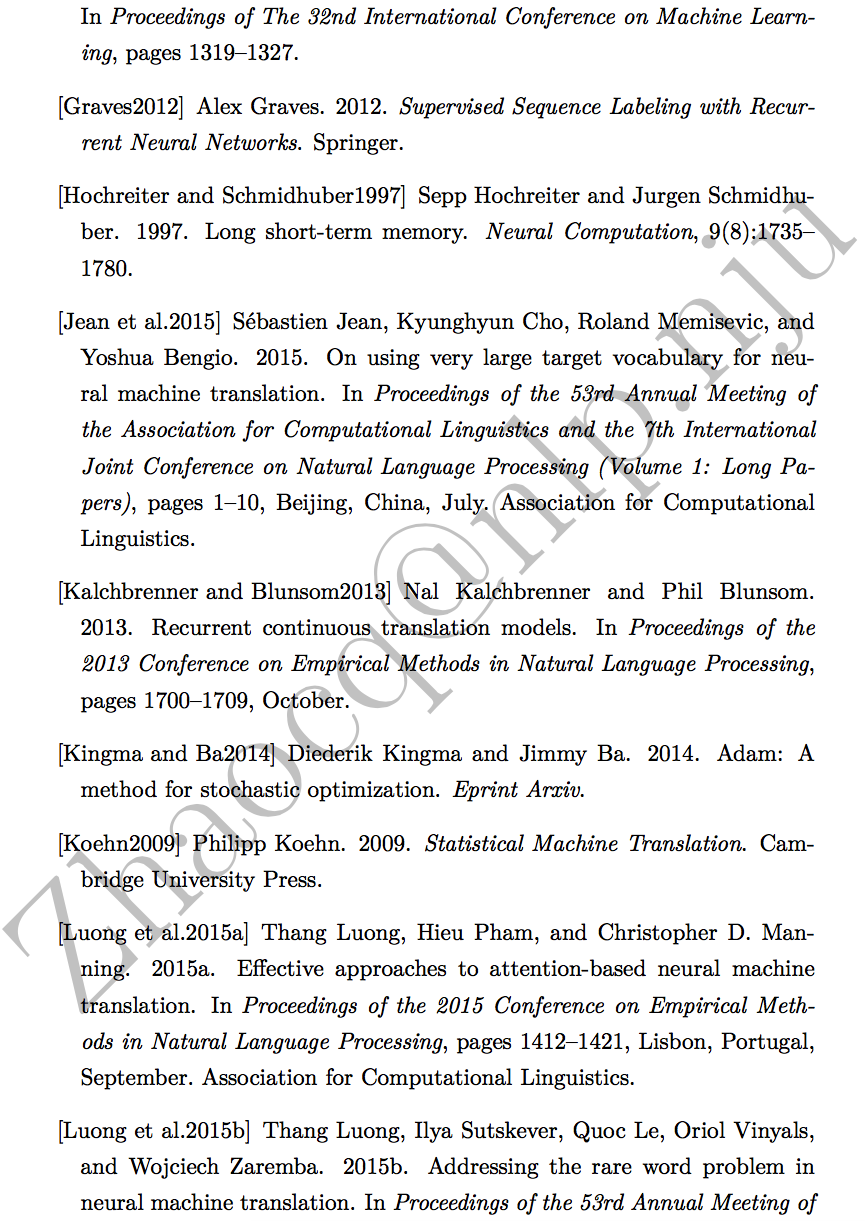

Dzmitry Bahdanau, Kyunghyun Cho, and Yoshua Bengio. 2015. Neural machine translation by jointly learning to align and translate. In ICLR.

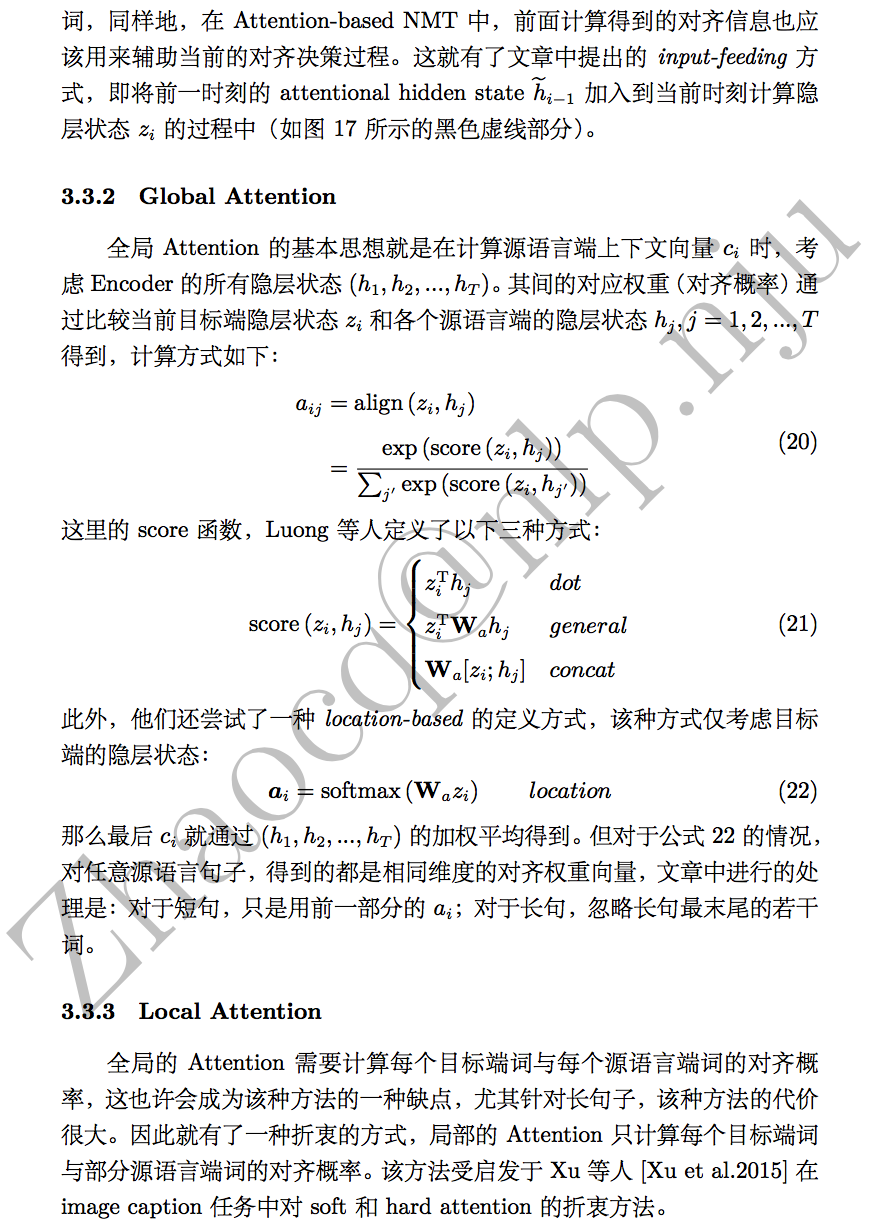

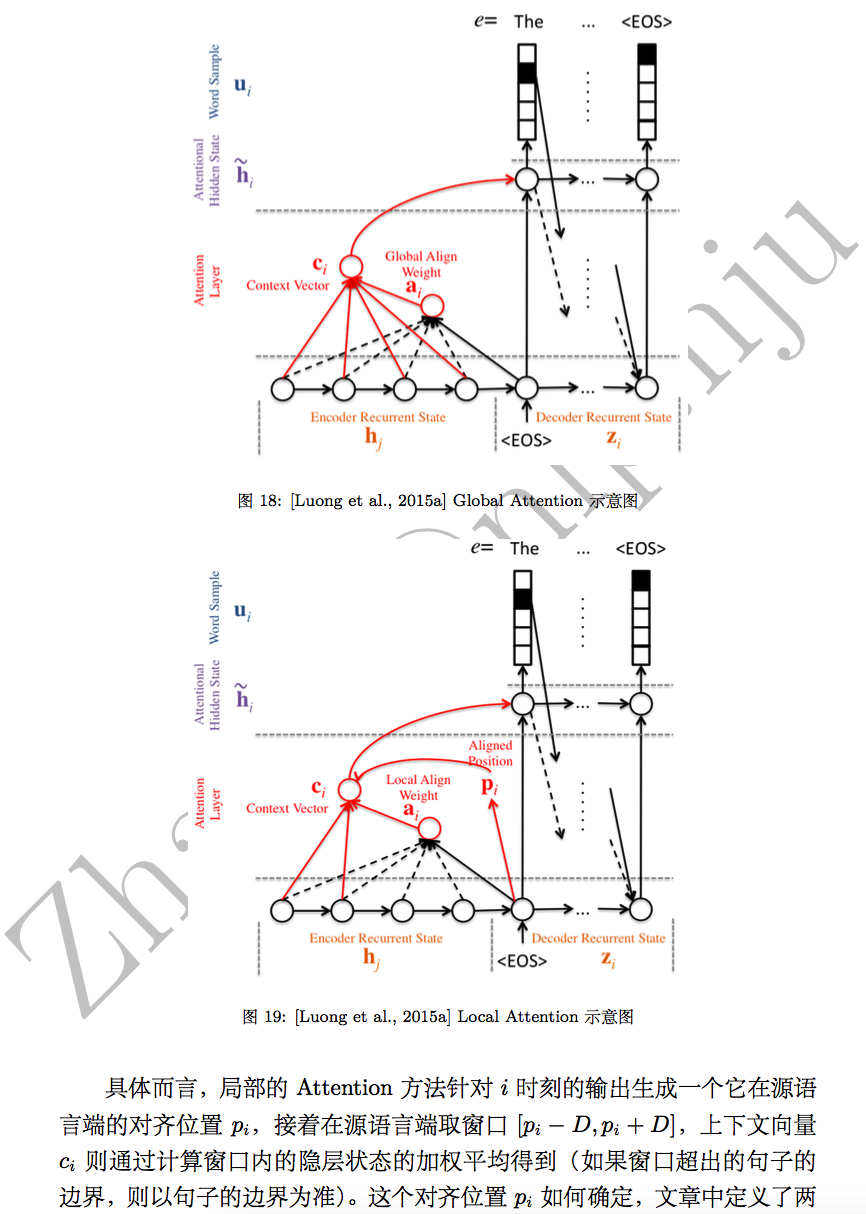

Thang Luong, Hieu Pham, and Christopher D. Manning. 2015a. Effective approaches to attention-based neural machine translation. In Proceedings of the 2015 Conference on EMNLP.

3537

3537

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?