神经网络反向传播算法的推导

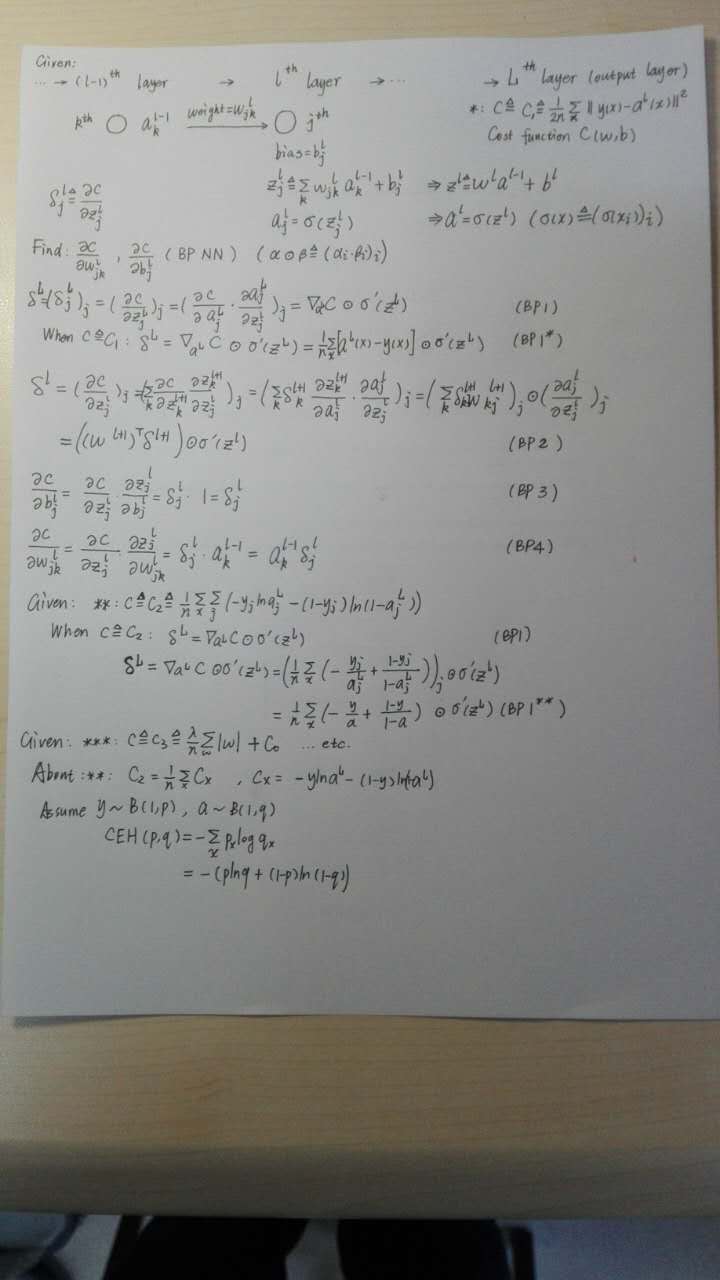

推导如下

其中考虑了代价函数 C = C 1 ( L 2 范 数 ) , C 2 ( 交 叉 熵 ) , C 3 ( 考 虑 权 重 L 1 范 数 的 代 价 ) C=C_1(L2范数),C_2(交叉熵),C_3(考虑权重L1范数的代价) C=C1(L2范数),C2(交叉熵),C3(考虑权重L1范数的代价)的情形,事实上对任意代价函数算法实现原理都一致,只需要实现算法时候更改调用的代价函数的关于对应 a a a的导数即可。

其中激活函数没有具体带入,可以是 σ ( x ) = s i g m o i d ( x ) o r t a n h ( x ) 或 者 再 进 行 一 次 s o f t m a x ( z ) \sigma(x)=sigmoid(x)\ or\ tanh(x)或者再进行一次softmax(z) σ(x)=sigmoid(x) or tanh(x)或者再进行一次softmax(z),事实上对任意激活函数算法实现原理一致,只需要实现算法时候更改调用的激活函数及其导数导数即可。

另外关于交叉熵,再最下面有一个小的说明。

交叉熵可在神经网络(机器学习)中作为损失函数,p表示真实标记的分布,q则为训练后的模型的预测标记分布(注意q为 s i g m o i d sigmoid sigmoid的输出永远不会为0或者1,所以交叉熵一直有意义),交叉熵损失函数可以衡量p与q的相似性。熵的本质就是香农信息量的期望,至于香农熵,对此定义比较清楚了,而且可以解函数方程解出唯一定义了,根据这个定义可以推出q分布的信息量的数学期望。

交叉熵作为损失函数还有一个好处是使用sigmoid函数在梯度下降时能避免均方误差损失函数学习速率降低的问题,因为学习速率可以被输出的误差所控制。

7806

7806

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?