Map端执行流程分析

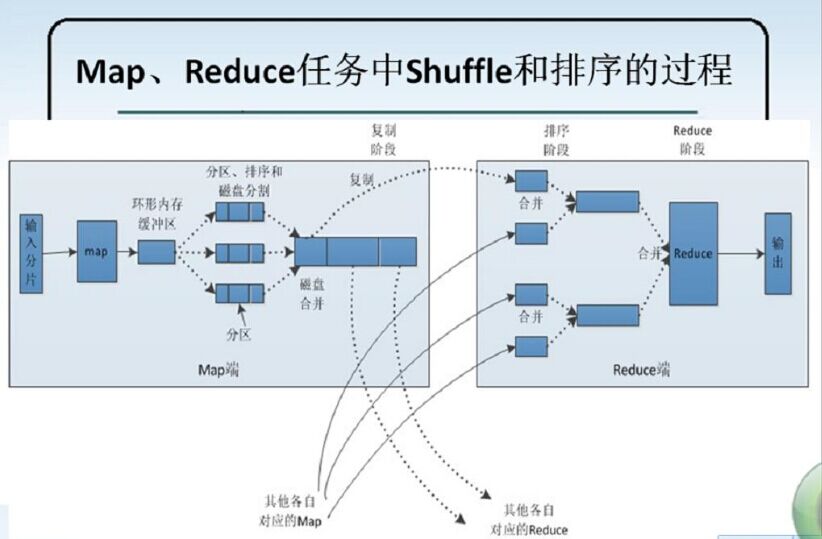

1、每个输入分片会让一个map任务来执行处理,默认情况下,以HDFS的一个块的大小(默认64M)为一个分片,当然我们也可以设置块的大小。Map输出的结果会暂且放在一个环形内存缓冲区中(该缓冲区的大小默认为100M,由io.sort.mb属性控制),当该缓冲区快要溢出来时(默认的缓冲区大小的80%,由io.sort.spill.percent属性控制),会在本地文件系统中创建一个溢出文件,将该缓冲区中的数据写入这个文件。

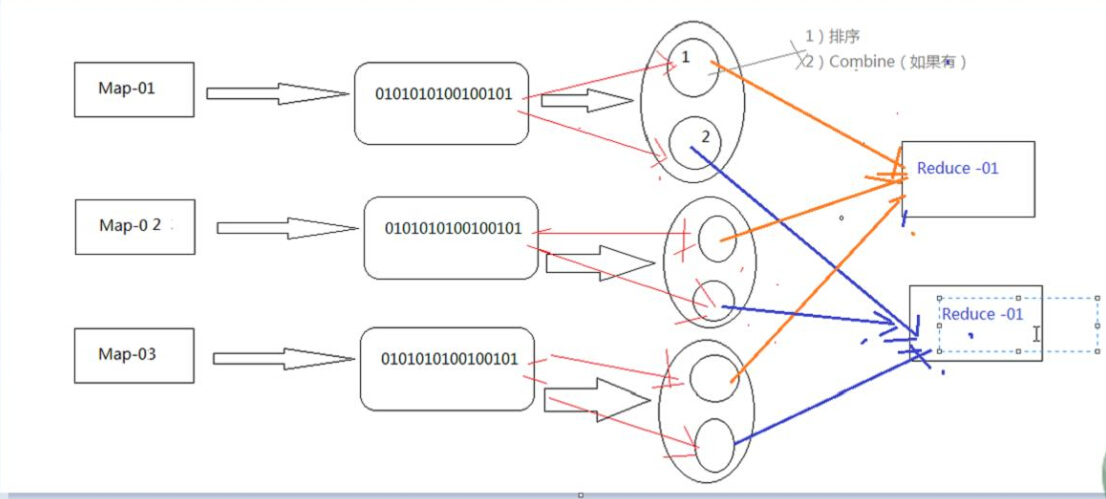

2、在写入磁盘之前,线程首先根据reduce任务的数目将数据划分为相同数目的分区,也就是一个reduce任务对应一个分区的数据。这样做事为了避免有些reduce任务分配到大量数据,而有些reduce任务却分到很少数据,甚至没有分到数据的尴尬局面。其实分区就是对数据进行hash的过程。人后对每个分区中的数据进行排序,如果此时设置了Combiner,将排序后的结果进行Combia操作,这样做的目的是让尽可能少的数据写入到磁盘。

3、当map任务输出最后一个记录时,可能会有很多溢出的文件,这是需要将这些文件合并。合并的过程中会不断的进行排序和combia操作,目的有两个:(1)、尽量减少每次写入磁盘的数据量;(2)、尽量减少下一个复制阶段网络传输的数据量。最后合并成一个已分区且已排序的文件。为了减少网络传输的数据量,这里可以将数据压缩,只要将mapred.copress.map.out设置为true就可以了。

4、将分区中的数据拷贝给相应的reduce任务。有人可能会问:分区中的数据怎么知道它对应的reduce是哪个呢?其实map任务一直和其父TaskTracker保持联系,而TaskTracker又一直和JobTracker保持心跳,所以JobTracker中保存了整个集群中的宏观信息。只要reduce任务向JobTracker获取对应的map输出位置就OK了。

5、Map端就分析完了,到底什么是Shuffle呢?Shuffle的中文意思是“洗牌”,也就是map之后reduce之前的过程。

以上就是map端执行流程分析全部内容了。参考了,云帆大数据视频课程。如果有错误或问题,评论留言一起积极讨论。

3803

3803

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?