简介

该文会介绍如何利用MatConvNet生成一个可供其他程序调用的DLL。主要内容有:MatConvNet的安装和配置、MatConvNet的手写体识别demo、编写数字识别函数、用MCC生成动态链接库、VC下的再次封装、使用以及常见错误。此外作者运行环境为:Win7 64位+VS2012+Matlab2005rb

注:因为所有的资料都可以在网上找到,所以有些过程描述的不够详尽,请自行百度或者留言交流。

MatConvNet的安装和配置

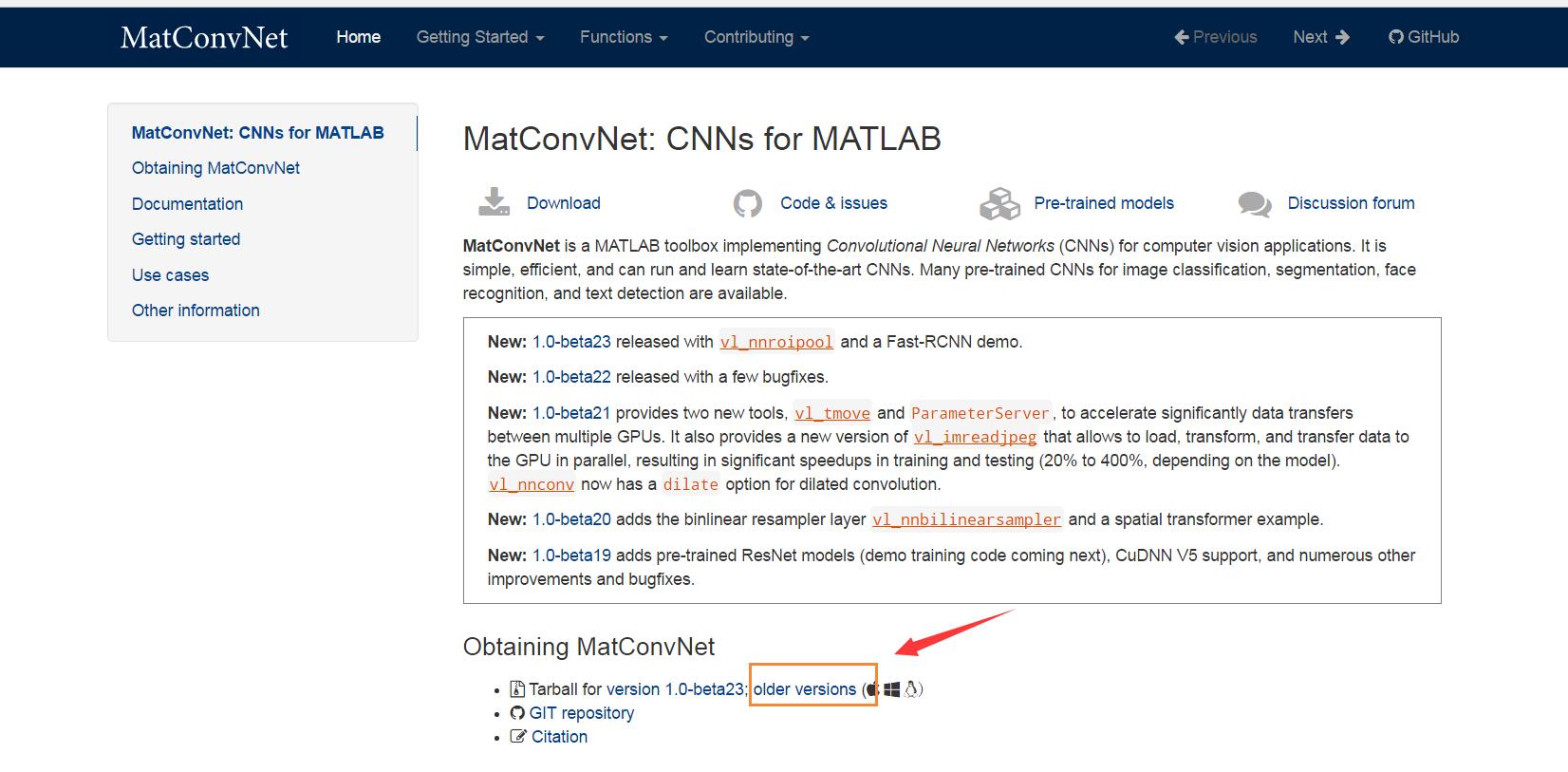

在MatConvNet官网中下载项目,建议下载最新版本(23版)。另提一句,如果你需要补一下CNN的基础理论,可以下载官网上的手册进行查阅。

解压后,用matlab进入项目根目录的matlab目录下。在命令行下运行vl_compilenn.m进行编译。

可能遇到的问题:

1.如果你是第一次用matlab混编,老版本matlab可能需要用 mex -setup命令 选择一下c++编译器

2.编译源码的时候可能会出现一些编译错误,此时可根据提示定位到c++源码中,进行适当的修改重新编译即可。本人遇到的问题有缺少round函数,因为VC的库没有这个函数,自己在该源码文件的头部添加一个round函数的实现即可。还有提示缺少 stdbool头文件,VC下不用这个直接注释。

编译完成后,运行 vl_setupnn 配置下运行环境

MatConvNet的手写体识别demo

进入项目根目录下的examples\mnist\目录。运行cnn_mnist_experiments

程序会自动下载mnist数据集,并用两种方式进行训练。默认的epoch次数是20,可以在cnn_mnist_init.m文件中进行修改。另外该文件是MatConvNet构建自己神经网络拓扑结构的范例,按照自己的理解加了注释,有问题欢迎留言指正。

function net = cnn_mnist_init(varargin)

% CNN_MNIST_LENET Initialize a CNN similar for MNIST

opts.batchNormalization = true ;%是否使用BN

opts.networkType = 'simplenn' ;%选用的网络结构 simplenn或dagnn,定义见手册"3.1 Wrappers"

opts = vl_argparse(opts, varargin) ;%整合输入参数

rng('default'); %随机数种子重置

rng(0) ;

f=1/100 ;

net.layers = {} ;

%添加卷积层 特征图20 卷积窗口大小5*5 滑动窗口步长1 不进行pading

net.layers{end+1} = struct('type', 'conv', ...

'weights', {{f*randn(5,5,1,20, 'single'), zeros(1, 20, 'single')}}, ...

'stride', 1, ...

'pad', 0) ;

%添加采样层 方法为最大池化 池化窗口2*2

net.layers{end+1} = struct('type', 'pool', ...

'method', 'max', ...

'pool', [2 2], ...

'stride', 2, ...

'pad', 0) ;

%添加卷积层 特征图50 卷积窗口大小5*5 滑动窗口步长1 不进行pading

net.layers{end+1} = struct('type', 'conv', ...

'weights', {{f*randn(5,5,20,50, 'single'),zeros(1,50,'single')}}, ...

'stride', 1, ...

'pad', 0) ;

%添加采样层 方法为最大池化 池化窗口2*2

net.layers{end+1} = struct('type', 'pool', ...

'method', 'max', ...

'pool', [2 2], ...

'stride', 2, ...

'pad', 0) ;

%添加卷积层 特征图500 卷积窗口大小*4 滑动窗口步长1 不进行pading

net.layers{end+1} = struct('type', 'conv', ...

'weights', {{f*randn(4,4,50,500, 'single'), zeros(1,500,'single')}}, ...

'stride', 1, ...

'pad', 0) ;

%添加ReLU层

net.layers{end+1} = struct('type', 'relu') ;

%全连接层

net.layers{end+1} = struct('type', 'conv', ...

'weights', {{f*randn(1,1,500,10, 'single'), zeros(1,10,'single')}}, ...

'stride', 1, ...

'pad', 0) ;

%评价函数为 softmax 的负对数

net.layers{end+1} = struct('type', 'softmaxloss') ;

%插入BN层

% optionally switch to batch normalization

if opts.batchNormalization

net = insertBnorm(net, 1) ;

net = insertBnorm(net, 4) ;

net = insertBnorm(net, 7) ;

end

% Meta parameters

net.meta.inputSize = [28 28 1] ; %输入图像大小 w*h*c

net.meta.trainOpts.learningRate = 0.001 ;%影响SGD

net.meta.trainOpts.numEpochs = 10 ;%epoch次数(训练集训练次数)

net.meta.trainOpts.batchSize = 100 ;%batch SGD 大小

% Fill in defaul values

net = vl_simplenn_tidy(net) ;

% Switch to DagNN if requested

switch lower(opts.networkType)

case 'simplenn'

% done

case 'dagnn'

net = dagnn.DagNN.fromSimpleNN(net, 'canonicalNames', true) ;

net.addLayer('top1err', dagnn.Loss('loss', 'classerror'), ...

{'prediction', 'label'}, 'error') ;

net.addLayer('top5err', dagnn.Loss('loss', 'topkerror', ...

'opts', {'topk', 5}), {'prediction', 'label'}, 'top5err') ;

otherwise

assert(false) ;

end

% --------------------------------------------------------------------

function net = insertBnorm(net, l)

% --------------------------------------------------------------------

assert(isfield(net.layers{l}, 'weights'));

ndim = size(net.layers{l}.weights{1}, 4);

layer = struct('type', 'bnorm', ...

'weights', {{ones(ndim, 1, 'single'), zeros(ndim, 1, 'single')}}, ...

'learningRate', [1 1 0.05], ...

'weightDecay', [0 0]) ;

net.layers{l}.biases = [] ;

net.layers = horzcat(net.layers(1:l), layer, net.layers(l+1:end)) ;

可自己根据要求修改网络结构训练,训练后把cnn_mnist函数的返回结果保存下来,我们后面要用。另外你应该能在训练结果的目录下看到imdb.mat文件,里面存的是mnist数据集。

编写数字识别函数

这一部分我们要写三个函数,加载神经网络参数、加载训练集图片均值、识别函数

function DUCO_LoadNet(netPath)

global g_net;

g_net=load(netPath);

endfunction DUCO_LoadImgAve(imgave_path)

global g_imgave;

g_imgave=load(imgave_path);

endfunction numeric=DUCO_OCRNum(img)

global g_imgave;

global g_net;

g_net.layers{1, end}.type = 'softmax';

%resize inuput img

img=rot90(img);%用matlab测试时,需要注释掉这句话

img = imresize(img, [28 28], 'bicubic');

img = single(img);

%debug

%imwrite(uint8(img),'imgd.bmp');

%enddebug

img = bsxfun(@minus, img, g_imgave.imgave);

res = vl_simplenn(g_net, img);

[~, ~, n] = size(res(end).x(1, 1, :));

tmp = 0.0;

for i = 1 : n

res(end).x(1, 1, i);

if tmp < res(end).x(1, 1, i)

numeric = i - 1;

tmp = res(end).x(1, 1, i);

end

end

end再写个主调函数测试一下

DUCO_LoadImgAve('imgave.mat');%训练集的图片均值,可在imdb中提取

DUCO_LoadNet('net1.mat');%训练好的神经网络参数

img=imread('5.png');

DUCO_OCRNum(img)%识别图像,返回数字值得注意的是,识别函数中对图像进行了旋转,这是因为该函数下一步会被封装给C++调用,c++中的二维数组是按行优先存储,而matlab测试按列优先存储。

3890

3890

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?