今天搭建了一个hadoop2.0(yarn集群平台),首先在上面测试了一个FileSystem实例程序,代码如下:

package IT0701;

import java.io.IOException;

import java.net.URISyntaxException;

import org.apache.commons.compress.utils.IOUtils;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataInputStream;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

public class FileSystemTest

{

public static void main(String[] args) throws IOException, URISyntaxException

{

Configuration conf = new Configuration();

FileSystem fileSystem = FileSystem.get(conf);

FSDataInputStream fr = fileSystem.open(new Path("hdfs://hadoop20:9000/word.txt"));

IOUtils.copy(fr, System.out);

}

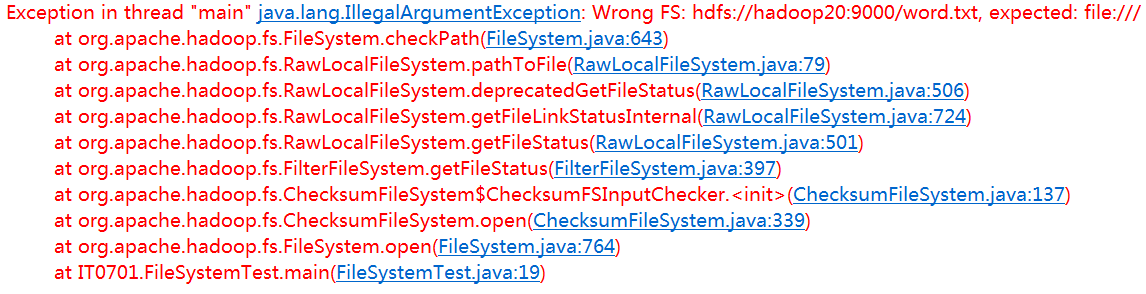

}然而eclipse中程序的运行结果如下:

抛出的异常显示:代码不能识别HDFS文件系统,期望用本地文件系统(file:///),于是我将代码进行了修改:

package IT0701;

import java.io.IOException;

import java.net.URISyntaxException;

import org.apache.commons.compress.utils.IOUtils;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataInputStream;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

public class FileSystemTest

{

public static void main(String[] args) throws IOException, URISyntaxException

{

Configuration conf = new Configuration();

FileSystem fileSystem = FileSystem.get(conf);

FSDataInputStream fr = fileSystem.open(new Path("file:///C:\\file.txt"));

IOUtils.copy(fr, System.out);

}

}

/*

运行结果:

Sometimes your plans don’t work out because God has better ones.

毅力和耐性在某种程度上将决定一个人会成为什么样的人。

*/果然程序不在抛出异常,然而file:///(本地文件系统)并不是我所需要的,所以代码还需要进一步的修改:既然代码不能识别HDFS文件系统,于是我在配置文件进行指定—识别HDFS分布式文件系统,从而获得(HDFS)相应的实例对象FileSystem,而不在获得本地文件系统的实例对象FileSystem。

package IT0701;

import java.io.IOException;

import java.net.URISyntaxException;

import org.apache.commons.compress.utils.IOUtils;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.FSDataInputStream;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

public class FileSystemTest

{

public static void main(String[] args) throws IOException, URISyntaxException

{

Configuration conf = new Configuration();

conf.set("fs.defaultFS", "hdfs://hadoop20:9000");//在配置文件conf中指定所用的文件系统---HDFS

FileSystem fileSystem = FileSystem.get(conf);

FSDataInputStream fr = fileSystem.open(new Path("hdfs://hadoop20:9000/word.txt"));

IOUtils.copy(fr, System.out);

}

}

/*

程序执行结果:

hello you

hello me

*/异常到此得到了解决,当然还有另一种解决方案:

将core-site.xml这个配置文件拷贝到src中:

core-site.xml中的内容如下:

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop20:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/hadoop/tmp</value>

</property>

</configuration>这样当程序在执行的过程,conf就会读取core-site.xml配置文件的内容,从而识别出HDFS文件系统。

275

275

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?