不同规则的中文分词对Lucene索引的影响

田春峰 欢迎订阅作者微博

在中文全文索引中为了建立反向索引需要对文档中的句子进行切分,相关理论请参见车东的介绍。

在lucene 1.3 以后的版本中支持中文建立索引了,他默认的切分规则是按一个个汉字分的。例子见后。

这里主要对比以下3种中文切分对lucene 索引的影响。

第一种:默认的单字切分;

第二种:二元切分(见车东的文章);

第三种:按照词义切分(使用小叮咚的逆向最大切分法)。

上面3种切分的效果如下:

原句:"搜索引擎的发展历史证明,没有做不到只有想不到,让人们更方便准确的获取信息是搜索引擎的使命。"

Lucene默认分词结果:

org.apache.lucene.analysis.standard.StandardAnalyzer:

[搜] [索] [引] [擎] [的] [发] [展] [历] [史] [证] [明] [没] [有] [做] [不] [到] [只] [有] [想] [不] [到] [让] [人] [们] [更] [方] [便] [准] [确] [的] [获] [取] [信] [息] [是] [搜] [索] [引] [擎] [的] [使] [命]

二元切分结结果:

org.apache.lucene.demo.CJKAnalyzer:

[搜索] [索引] [引擎] [擎的] [的发] [发展] [展历] [历史] [史证] [证明] [没有] [有做] [做不] [不到] [到只] [只有] [有想] [想不] [不到] [让人] [人们] [们更] [更方] [方便] [便准] [准确] [确的] [的获] [获取] [取信] [信息] [息是] [是搜] [搜索] [索引] [引擎] [擎的] [的使] [使命]

小叮咚切分结果:

org.apache.lucene.demo.ChineseAnalyzer:

[搜索] [引擎] [的] [发展] [历史] [证明] [有] [做] [不到] [只有] [想] [不到] [人们] [更] [方便] [准确] [的] [获取] [信息] [是] [搜索] [引擎] [的] [使命]

在Lucene索引中,最小的索引单位是Token。基本上可以这样理解Token,在英文中Token是一个单词,在汉语中是不同切分结果中[]内的单词。

我的测试数据:

今天各大网站和blog的新闻,包括经济、政治、教育、娱乐、科技等几大类总共212K的文本文件。

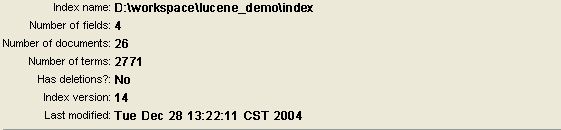

经过Lucene生成索引后的统计信息如下:

单字切分:

单字切分的前15个Term

词义切分:

词义切分的前15个Term

通过上面的对比可以看出: 单字切分的Term要比词义切分的Term少。原因很明显,汉语中常用的字大概4000多个,所以单字切分的Term上限也大概就是这么多,词义切分就不同了,我这里的词义词典大概有4万多个。

从直觉观察来看,索引文件中的Term越多,搜索结果也越快,搜索的相关性也越高。

另外一个有意思的情况是索引文件大小的变化。

在我得测试数据大概80K大小的时候,上面的两种方法产生的索引文件区别不大,可是当数据量大于100K的时候,单字切分的索引文件已经比词义切分索引文件大了30多K了。由于目前对索引文件格式还不了解,现在只能猜测为什么会出现这样的结果了。因为单字切分的Term少,那么指向这个Term的链接信息就越多,(搜索结果也越不相关)。反之亦然。

上面的测试数据中没有过滤常用的汉字。常用的汉字对搜索是没有作用的,比如:的,是等。

20041228

csdn 的blog 不稳定才发到这里,呵呵

798

798

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?