分类回归树

优点

(1)可自动忽略对目标变量没有贡献的属性变量,也为判断属性变量的重要性,减少变量数据提供参考;

(2)在面对诸如存在缺失值、变量数多等问题时C&RT 显得非常稳健(robust);

(3)估计模型通常不用花费很长的训练时间;

(5)比其他模型更易于理解——从模型中得到的规则能得到非常直观的解释,决策推理过程可以表示成

(6)目标是定类变量为分类树,若目标变量是定距变量,则为回归树;

(7)通过检测输入字段,通过度量各个划分产生的异质性的减小程度,找到最佳的一个划分。

(8)非常灵活,可以允许有部分错分成本,还可指定先验概率分布,可使用自动的成本复杂性剪枝来得到归纳性更强的树。

决策树生长的核心是确定决策树的分枝准则。

一、

也就是选择能使异质性下降最快的变量。

异质性的度量:GINI、TWOING、least squared deviation。

前两种主要针对分类型变量,LSD针对连续性变量。

代理划分、加权划分、先验概率

二、

(1)

A、数值型变量——对记录的值从小到大排序,计算每个值作为临界点产生的子节点的异质性统计量。能够使异质性减小程度最大的临界值便是最佳的划分点。

B、分类型变量——列出划分为两个子集的所有可能组合,计算每种组合下生成子节点的异质性。同样,找到使异质性减小程度最大的组合作为最佳划分点。

三、

满足以下一个即停止生长。

(1)

(2)

(3)

(4)

剪枝:完整的决策树对训练样本特征的描述可能“过于精确”(受噪声数据的影响),缺少了一般代表性而无法较好的用对新数据做分类预测,出现”过度拟合“。

——移去对树的精度影响不大的划分。使用 成本复杂度方法,即同时度量错分风险和树的复杂程度,使二者越小越好。

剪枝方式:

A、

B、后修剪(postpruning):在允许决策树得到最充分生长的基础上,再根据一定的规则,自下而上逐层进行剪枝。

预测:

回归树——预测值为叶节点目标变量的加权均值

分类树——某叶节点预测的分类值应是造成错判损失最小的分类值。

四、

减少在冒险因素或损失因素方面的不确定性。

不仅包括不同模型的比较,而且还要对模型产生结果的商业价值进行比较。

模型评价的角度

-风险(risk)

-收益(gain)

-利润(profits)

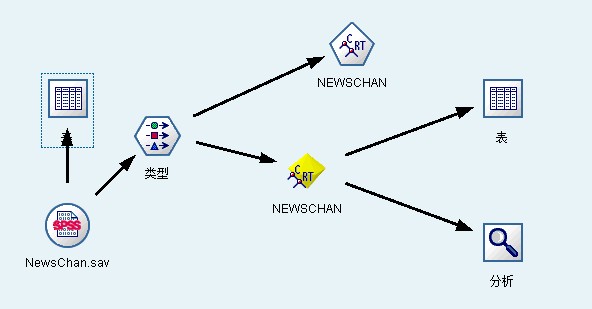

Type(类型节点) 设置:

4483

4483

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?