本期内容:

SparkStreaming另类在线实验

瞬间理解SparkStreaming本质

一、为何从Spark Streaming切入Spark源码定制?

1)Spark最开始没有其他子框架,只有一个原始的Spark Core.

SparkStreaming本身是Core上的一个框架,透过一个框架的彻底研究肯定可以精通Spark力量的源泉和所有问题的解决之道;

2)Spark SQL 涉及太多的SQL语法细节解析和优化,不适合作为子框架进行研究;SparkR 很不成熟,支持功能有限;

Spark GraphX最近几个版本中也无太多改进之处,有很多数学算法;SparkML 也涉及到很多数学知识。综合我们以SparkStreaming为切入点。

二、2015年Spark最火爆,大家考虑Spark主要也是因为Spark Streaming。

(1)流处理的时代:一切数据如果与流式处理不相关的话,都是无效的数据。

(2)Spark之所以强悍的在于,它的流式处理可以在线地使用图计算、机器学习、SparkSQL或者SparkR的成果,这得益于Spark一体化、多元化的基础架构设计。也就是在Spark Streaming中可以调用其它任何东西,无需任何设置。这是Spark的无可匹敌之处,也是Spark Streaming定将一统天下的根源。

(3)Spark Streaming的复杂性:整个Spark的程序中,Spark Streaming也是最容易出问题的,因为数据是不断地流进,动态控制数据流入、切分、数据处理。

(4)Spark Streaming更像是Spark Core上的一个应用程序。

三,另类实战

小技巧:将BatchInterval设置得足够大,1分钟或5分钟,

这样可以看清数据流入和数据处理各环节。

package com.dt.spark.sparksteaming

import org.apache.spark.SparkConf

import org.apache.spark.SparkContext

import org.apache.spark.rdd.RDD

import org.apache.spark.streaming.StreamingContext

import org.apache.spark.streaming.Seconds

/**

* 使用Scala开发集群运行的Spark 在线黑名单过滤程序

* 背景描述:在广告点击计费系统中,我们在线过滤掉黑名单的点击,进而保护广告商的利益,只进行有效的广告点击计费

* 或者在防刷评分(或者流量)系统,过滤掉无效的投票或者评分或者流量;

* 实现技术:使用transform Api直接基于RDD编程,进行join操作

*/

object OnlineBlackListFilter {

def main(args: Array[String]){

/**

* 第1步:创建Spark的配置对象SparkConf,设置Spark程序的运行时的配置信息,

* 例如说通过setMaster来设置程序要链接的Spark集群的Master的URL,如果设置

* 为local,则代表Spark程序在本地运行,特别适合于机器配置条件非常差(例如

* 只有1G的内存)的初学者 *

*/

val conf = new SparkConf() //创建SparkConf对象

conf.setAppName("OnlineBlackListFilter") //设置应用程序的名称,在程序运行的监控界面可以看到名称

conf.setMaster("spark://Master:7077") //此时,程序在Spark集群

val ssc = new StreamingContext(conf, Seconds(300))

/**

* 黑名单数据准备,实际上黑名单一般都是动态的,例如在Redis或者数据库中,黑名单的生成往往有复杂的业务

* 逻辑,具体情况算法不同,但是在Spark Streaming进行处理的时候每次都能工访问完整的信息

*/

val blackList = Array(("hadoop", true),("mahout", true))

val blackListRDD = ssc.sparkContext.parallelize(blackList, 8)

val adsClickStream = ssc.socketTextStream("Master", 9999)

/**

* 此处模拟的广告点击的每条数据的格式为:time、name

* 此处map操作的结果是name、(time,name)的格式

*/

val adsClickStreamFormatted = adsClickStream.map { ads => (ads.split(" ")(1), ads) }

adsClickStreamFormatted.transform(userClickRDD => {

//通过leftOuterJoin操作既保留了左侧用户广告点击内容的RDD的所有内容,又获得了相应点击内容是否在黑名单中

val joinedBlackListRDD = userClickRDD.leftOuterJoin(blackListRDD)

/**

* 进行filter过滤的时候,其输入元素是一个Tuple:(name,((time,name), boolean))

* 其中第一个元素是黑名单的名称,第二元素的第二个元素是进行leftOuterJoin的时候是否存在在值

* 如果存在的话,表面当前广告点击是黑名单,需要过滤掉,否则的话则是有效点击内容;

*/

val validClicked = joinedBlackListRDD.filter(joinedItem => {

if(joinedItem._2._2.getOrElse(false))

{

false

} else {

true

}

})

validClicked.map(validClick => {validClick._2._1})

}).print

/**

* 计算后的有效数据一般都会写入Kafka中,下游的计费系统会从kafka中pull到有效数据进行计费

*/

ssc.start()

ssc.awaitTermination()

}

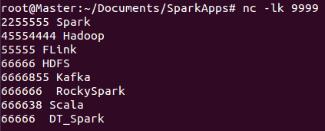

}- 启动nc -lk 9999,将应用打包发布至Spark集群上运行

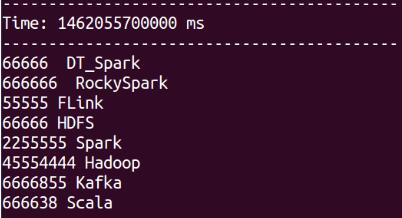

- SparkStreaming 根据设定的BatchInterval接收处理作业,打印的结果如下:

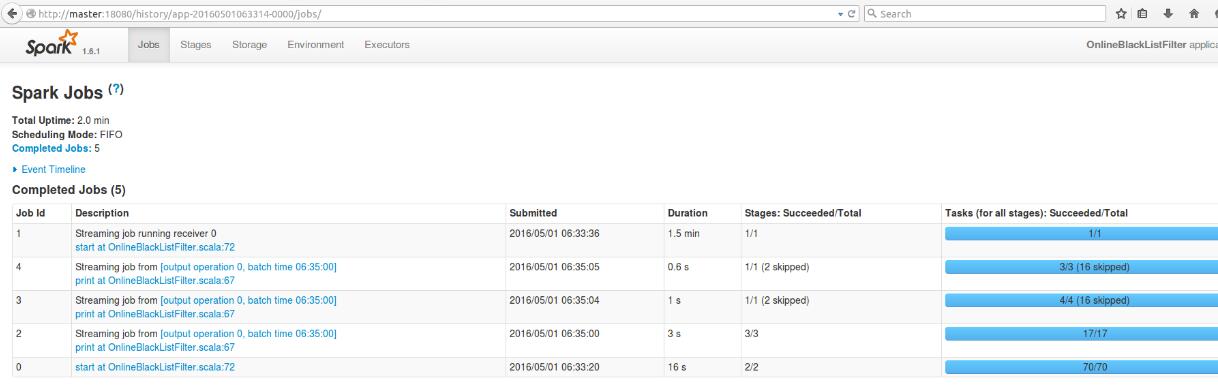

- 通过master:18080端口查看作业的运行,实质上运行了一个Job,具体如下:

上述Jobs包括1个 Start job、1个running receiver job及3个Print job。

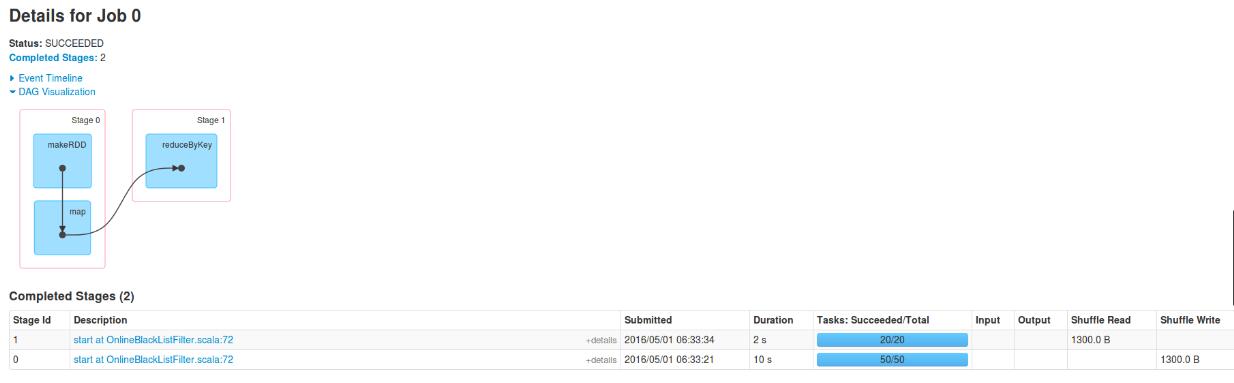

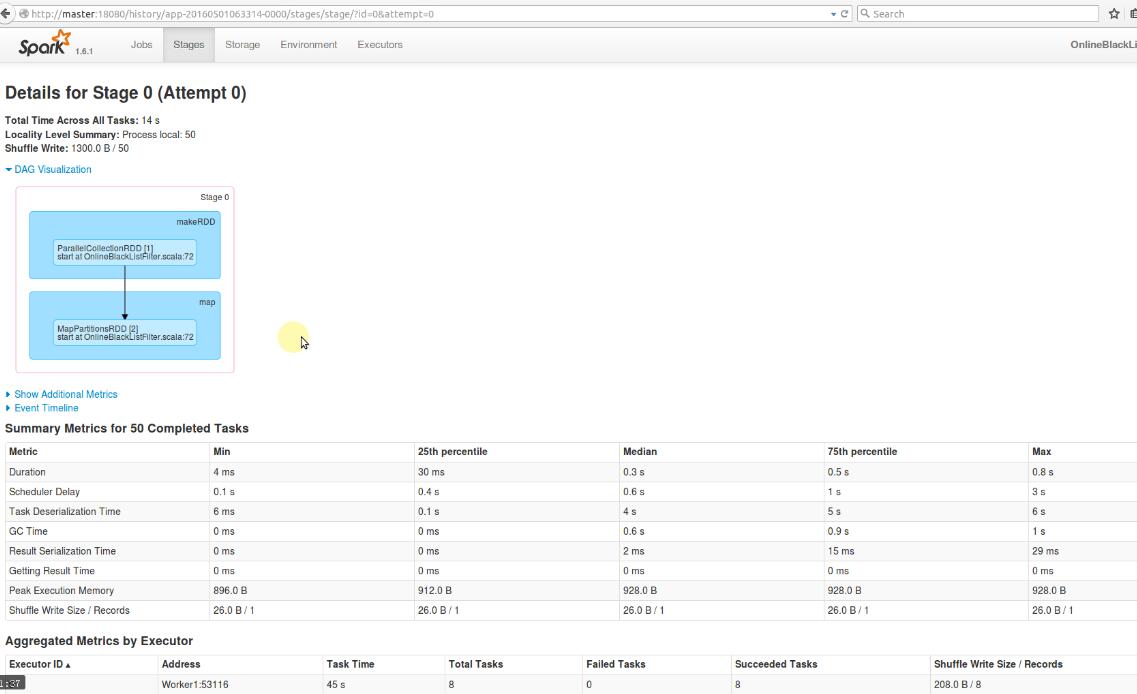

- Job 0 明细

- Stage 0 明细

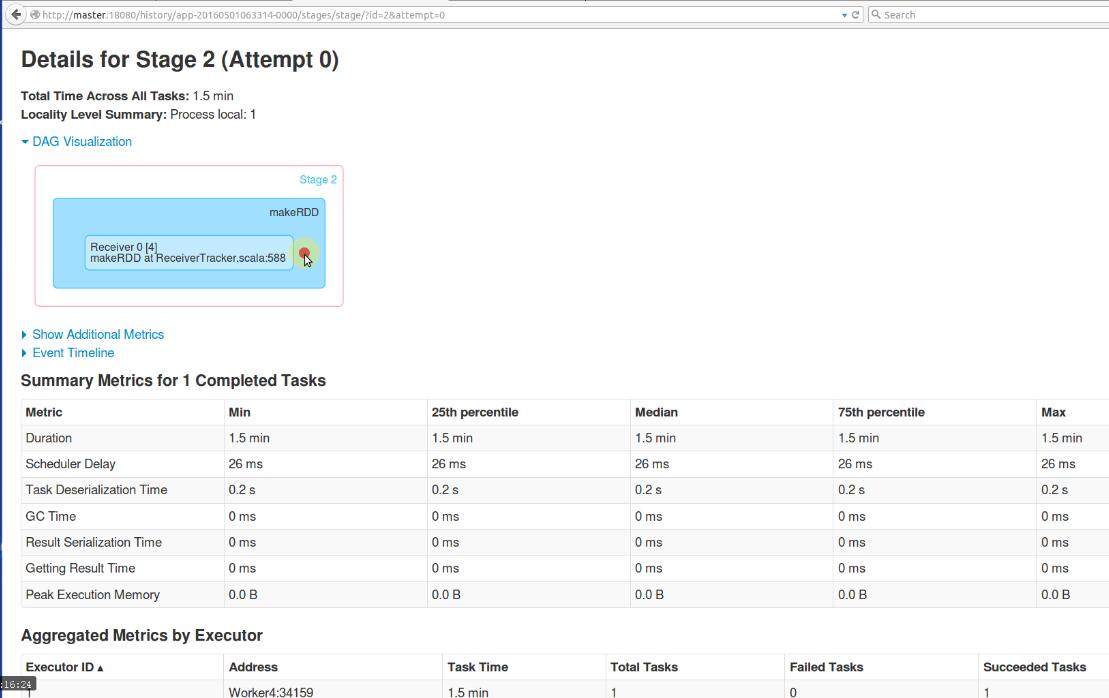

- 以下Receiver在整个JOB中耗时 1.5 分钟

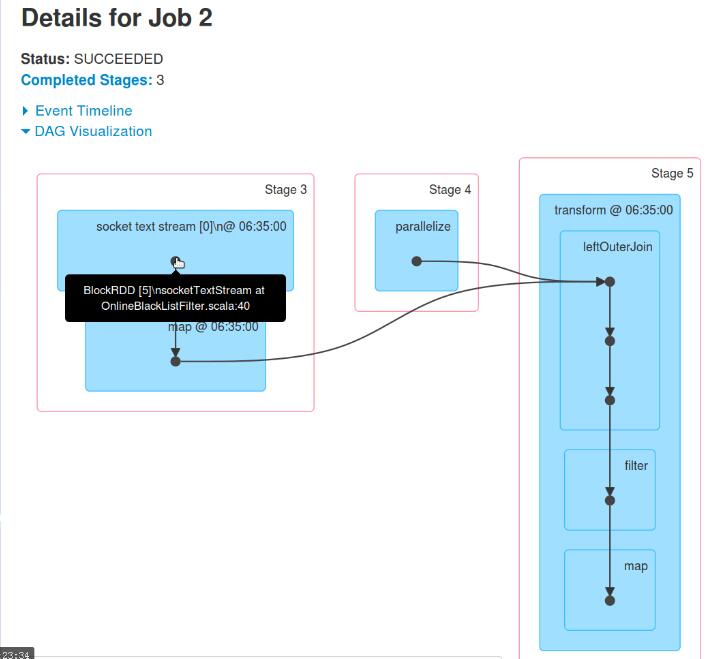

- JOB 2 DAG图

此时的BlockRDD来自于SocketTextStream,实质是InputDStream根据时间间隔产生RDD

后续DAG图(略)

四、Spark Streaming 本质

以上的连续4个图,分别对应以下4个段落的描述:

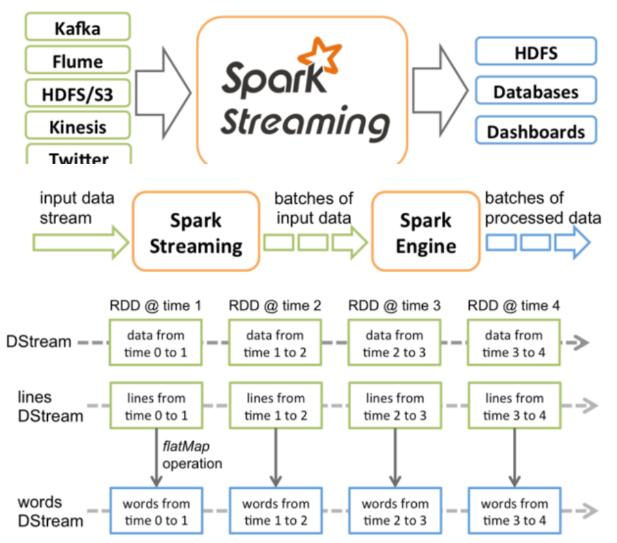

Spark Streaming接收Kafka、Flume、HDFS和Kinesis等各种来源的实时输入数据,进行处理后,处理结果保存在HDFS、Databases等各种地方。

Spark Streaming接收这些实时输入数据流,会将它们按批次划分,然后交给Spark引擎处理,生成按照批次划分的结果流。

Spark Streaming提供了表示连续数据流的、高度抽象的被称为离散流的DStream。DStream本质上表示RDD的序列。DStream中的每个RDD都包含来自一个时间间隔的数据。

Spark Streaming除了

使用数据源产生的数据流创建DStream,也可以在已有的DStream上使用一些操作来创建新的DStream。任何对DStream的操作都会转变为对底层RDD的操作。本图例子是对lines Dstream做了flatMap操作,生成words DStream操作。

在我们前面的实验中,每300秒会接收一批数据,基于这批数据会生成RDD,进而触发Job,执行处理。

DStream是一个没有边界的集合,没有大小的限制。

DStream代表了时空的概念。随着时间的推移,里面不断产生RDD。

锁定到时间片后,就是空间的操作,也就是

对本时间片的对应批次的数据的处理。

下面用实例来讲解数据处理过程。

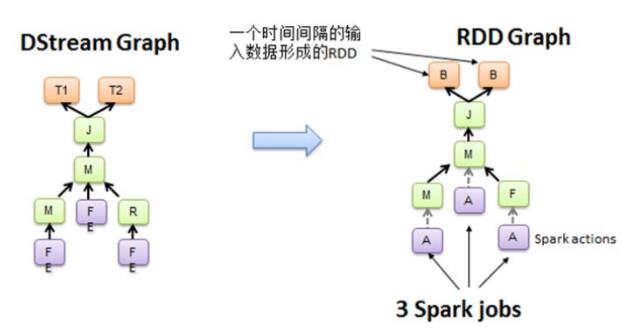

从Spark Streaming程序转换为Spark执行的作业的过程中,使用了DStreamGraph。

Spark Streaming程序中一般会有若干个对DStream的操作。DStreamGraph就是由这些操作的依赖关系构成。

从程序到DStreamGraph的转换,如以下图例所示:

空间维度确定之后,随着时间不断推进,会不断实例化RDD Graph,然后触发Job去执行处理。

下面是

SparkStreaming的官方说明信息

1941

1941

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?