Requests库官方中文文档

http://cn.python-requests.org/zh_CN/latest/

# coding:utf-8 Python2加

# 用requests库发送各种请求

import requests

#Requests拥有了urllib3的所有特性,Requests支持HTTP连接保持和连接池,支持使用cookie保持会话,支持文件上传,支持自动确定响应内容的编码,支持国际化的URL和POST数据自动编码

def simple_get(url): #统一资源定位符(Uniform Resource Locator)

resp = requests.get(url) #resp是response响应对象类型

print('status_code:\n',resp.status_code) #status_code获取状态码,查看网页请求是否成功

print('encoding:\n',resp.encoding) #encoding获取编码方式,不同网页编码方式不同

print('text:\n',resp.text) #text获取纯文本,str类型

print('content:\n',resp.content) #content获取二进制网页内容

print('cookie:\n',resp.cookies) #cookies获取cookie

#test

simple_get('http://httpbin.org/get') #该网址可用于熟悉各种http请求def get_with_parameters(url):

resp = requests.get(url, params={'key1':'Hello', 'key2':'世界'}) #带params参数的get,返回新的url中?后含params参数

print('url:\n',resp.url) #获取加了params参数后,修改的url

print('text\n',resp.text)

#test

get_with_parameters('http://httpbin.org/get')def get_with_ua(url):

resppre = requests.get(url)

ua = 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_12_5) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/59.0.3071.115 Safari/537.36'

resp = requests.get(url, headers={'user-agent':ua})

#直接对text里的headers属性项赋值,修改头部用户代理,把命令伪装成浏览器,反爬虫

print('text:\n',resp.text) #修改后user agent变化

print('headers:\n',resp.headers)

jdata = resp.json() #把resp里的json格式的'键值'对字符串转化成字典

print('User-Agent:\n',jdata['headers']['User-Agent'])

#test

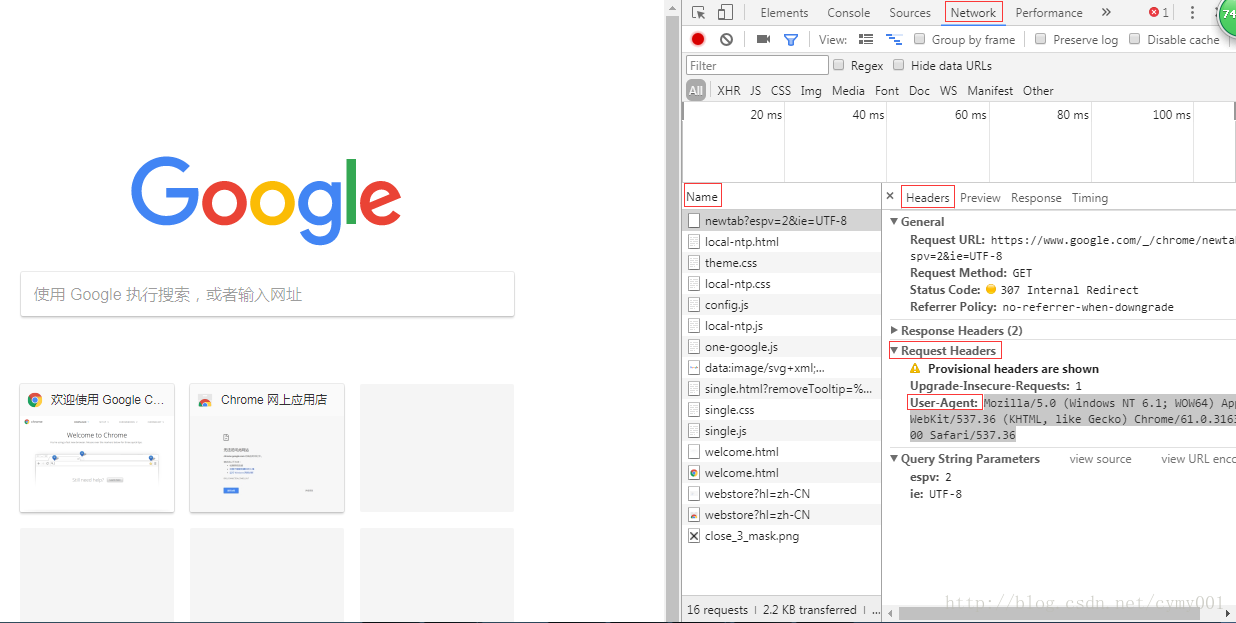

get_with_ua('http://httpbin.org/get')用户代理网页查取方法:

更多工具——>开发者工具

def get_using_cookie(url):

#cookie也是'键值'对字典表示字典,cookie用于网页广告推送

resp = requests.get(url, cookies={'key1':'hello', 'key2':'world'})

print(resp.cookies.items) #cookie部分用列表返回

for k, v in resp.cookies.items():

print(k, v)

#test

get_using_cookie('http://www.baidu.com')from PIL import Image

from io import BytesIO #二进制数据写入,操作二进制数据

def get_image(url):

resp = requests.get(url)

image = Image.open(BytesIO(resp.content)) #按字节流二进制格式读取图片

image.save('sample.jpg') #保存抓取图片

#test

get_image('http://n.sinaimg.cn/news/1_img/cfp/c4b46437/20171009/wZwz-fymrcpu8452587.jpg')# coding:utf-8

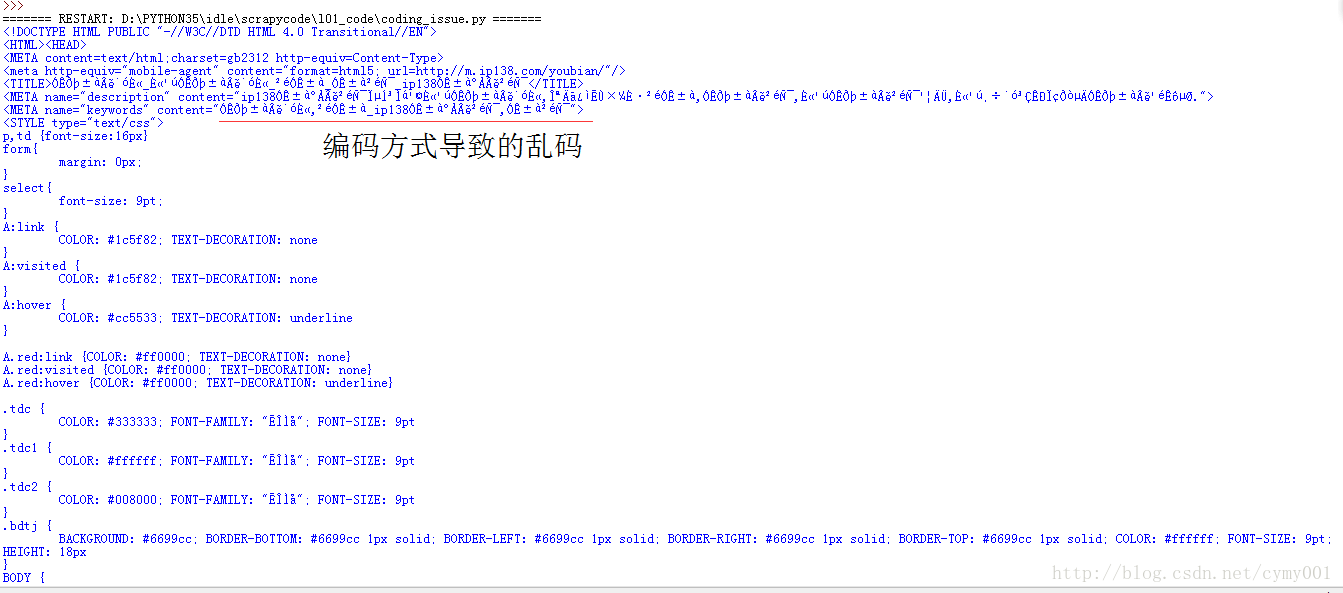

# 网页编码问题

import requests

resp = requests.get('http://www.ip138.com/post/')

print(resp.text)

print('encoding:\n',resp.encoding)

#查看网页编码方式,返回的不一定是页面真是编码

#输出encoding: ISO-8859-1

#但是,利用360浏览器查看网址真是编码是GBK编码,Chrome不能查看编码

byte = resp.text.encode('ISO-8859-1') #encode把网页输出的ISO-8859-1编码字符串,解码成原始的二进制字节

text = byte.decode('gbk') #利用网页真实的编码GBK编码,再编码成字符串

print(text)

1244

1244

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?