Hadoop配置

所有配置均在root下

关掉防火墙

1. 安装所需软件

Centos6.5(64位)

hadoop-2.6.0.x64.tar.gz

JDK:jdk1.7.0_80

三台虚拟机地址:192.168.1.71 192.168.1.72 192.168.1.73

2. 3台虚拟机实现ssh免密码登录

三台ip地址:192.168.1.71(master) 192.168.1.72(slaves1) 192.168.1.73(slaves2)

SSH协议分为客户端和服务端

(1) 在192.168.1.71中:

修改hosts文件

查询自己的hostname

将自己的hostname 写入 /etc/hosts

上述配置在192.168.1.72和192.168.1.73上面重复一遍操作。

(2) 客户端(192.168.1.71):

cd .ssh/ (进入 /root/.ssh/目录下)

ssh-keygen –t rsa (生成密钥)

ls (查看.ssh目录是否生成文件)

如下图,生成id_rsa , id_rsa.pub

以下分为两个部分:本机登陆和登录到别的虚拟机

本机登陆:

cat id_rsa.pub >> authorized_keys (将自己的公钥传至自己的服务器)

这样就可以免密码登录本机,如下图。

服务器登陆:

scp id_rsa.pub root@192.168.1.72:/root (将公钥传至服务器的root目录)

服务器端(192.168.1.72):

① cat id_rsa.pub >> .ssh/authorized_keys(该文件名一定要写正确)

chmod 600 authorized_keys

②修改服务器配置

Vim /etc/ssh/sshd_config

修改完成后如下图

③关闭SELinux服务

Vim /etc/selinux/config

修改完成后如下图

④重启reboot

⑤service sshd restart (重启sshd服务)

⑥ssh root@192.168.1.72

显示如下图说明成功

依次为192.168.1.72 和 192.168.1.73 进行与上述相同的配置,直到3台虚拟机的authorized_keys全部相同,如下图

root@slaves1.server 为 192.168.1.72

root@slaves2.server 为192.168.1.73

root@master.server 为 192.168.1.71

至此SSH安装完成。

3. jdk 安装

3台虚拟机都需要安装jdk

在安装之前先卸载掉本机的jdk

新建目录:/opt/hadoop/packages/ (建立在/opt下)

⑴mv jdk-7u80-linux-x64.tar.gz /opt/hadoop/packages/ (将压缩包放在该目录)进入该/opt/hadoop/packages/下

⑵tar -zvxf jdk-7u80-linux-x64.tar.gz (解压)

⑶vim /etc/profile

修改java_home等,完成后如下图

图片中的HADOOP_HOME后面会用到

⑷source /etc/profile

⑸要想让所有用户都可以使用java,操作如下:

Vim /etc/profile.d/java.sh

⑹chmod 755 /etc/profile.d/java.sh

⑺重启虚拟机

⑻ java -version

重复上述操作在其他两台虚拟机

Jdk 安装完成

4. Hadoop 配置

⑴将文件放在/opt/hadoop/packages/下

⑵解压hadoop压缩文件 tar -zvxf hadoop-2.6.0.tar.gz

解压完成后出现hadoop-2.6.0/目录

⑶进入hadoop-2.6.0/中,在该目录底下建立目录tmp, dfs/name, dfs/data

⑷进入etc/hadoop目录中,如下图:

在该目录下,进行以下操作:

① 配置 hadoop-env.sh文件-->修改JAVA_HOME

② 配置yarn-emv.sh文件--->修改JAVA_HOME

编写masters文件:

echo “192.168.1.71” >> masters

③ 编写slaves文件

echo “192.168.1.72” >> slaves

echo “192.168.1.73” >> slaves

④ Vim core-site.xml

⑤ Vim hdfs-site.xml

⑥vim mapred-site.xml

⑸将192.168.1.71上面的文件复制到192.168.1.72 和192.168.1.73两台虚拟机上

⑹对于192.168.1.71,进入bin 目录,格式化namenode

hadoop namenode -format

⑺对于192.168.1.72和192.168.1.73,进入bin目录,格式化datanode

hadoop datanode -format

⑻进入192.168.1.71,在bin里面,

hadoop dfsadmin -safemode leave

hadoop dfsadmin -report

至此hadoop安装成功

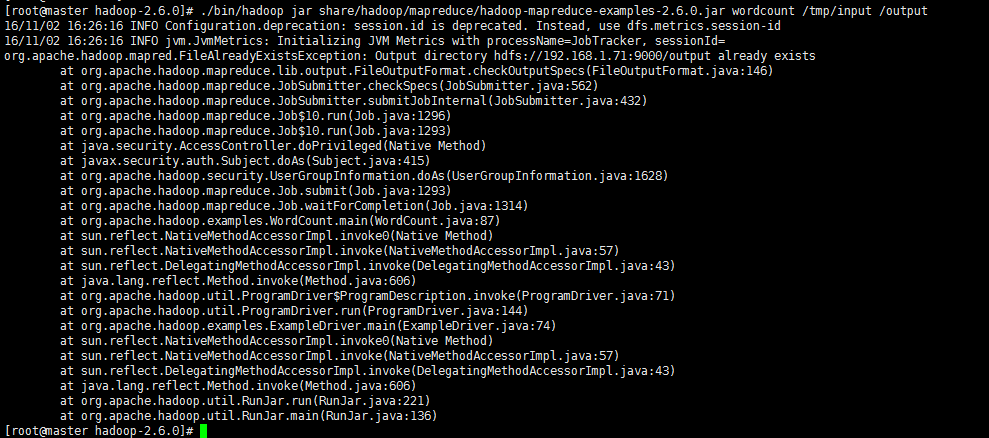

⑼测试wordcount

① 本地创建目录:

在该目录下建立文件file1,file2

② 在hdfs创建目录:

③ 上传本地文件

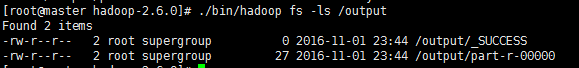

④ 查看文件是否上传

⑤ 在集群上运行wordcount程序

/tmp/input 为输入目录,/output为输出目录

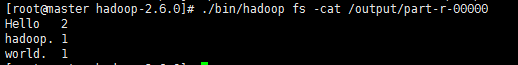

⑥ 查看结果

⑦查看输出内容

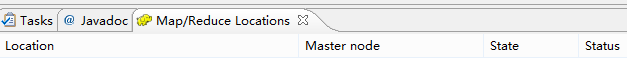

5. Eclipse 连接 Hadoop

本环节在windows下进行

⑴将插件hadoop-eclipse-plugin-2.6.0.jar,下载后放到eclipse/plugins目录。

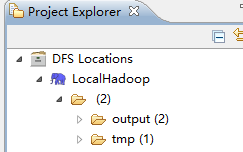

重启一下Eclipse,然后可以看到DFS Locations。

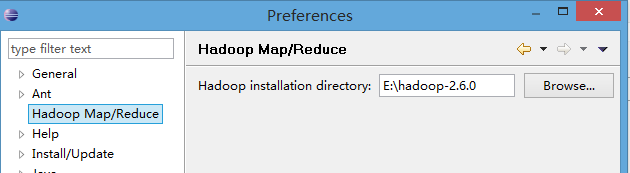

⑵打开Window-->Preferens,可以看到Hadoop Map/Reduce选项,然后点击,然后添加hadoop-2.6.0的主目录进来。

注意:这个hadoop-2.6.0的目录就是hadoop-2.6.0.x64.tar.gz解压的目录。

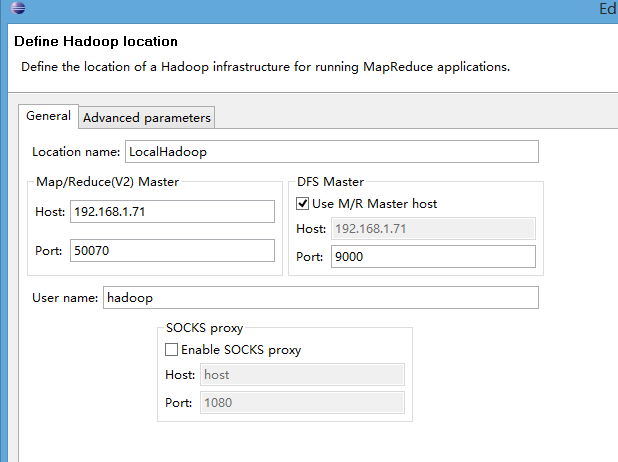

⑶配置Map/ReduceLocations

点击Window-->ShowView -->MapReduce Tools 点击Map/ReduceLocation

点击Map/ReduceLocation选项卡,点击右边小象图标,打开Hadoop Location配置窗口:输入Location Name,任意名称即可.配置Map/ReduceMaster和DFSMastrer,Host和Port配置成hdfs-site.xml与core-site.xml的设置一致。

⑷查看是否连接成功,当连接成功时就可以看到hdfs上面的文件

4626

4626

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?