课程简介:

本节课主要介绍人工神经网络.通过介绍评定模型,随机梯度下降法,生物启发和感知器系统,讲师用视图和数学解析式详细地讲解了神经网络的运行过程以及原理.

课程大纲:

1、Stochastic Gradient Descent ( 随机梯度下降法 )

2、Neural Network Model ( 神经网络模型 )

3、Backpropagation Algorithm ( 反向传播算法 )

4、Summarize

1、Stochastic Gradient Descent

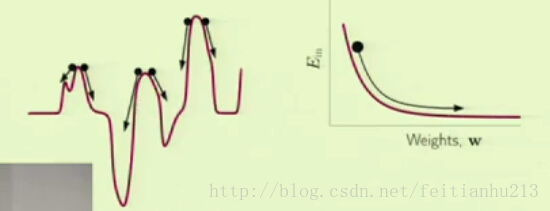

在上一节课里,我们利用梯度下降法找到最优的方向,然后向该方向移动一小步,但是很有可能会导致陷入一个差的局部最优解,而且每次移动都要计算全部的点,因此计算量大。那如果每次移动只看一个点,根据当前的点找到最优的方向进行移动,当所有的点都被选择后,理论上总的移动方向是跟之前的方法一致的,因为数学期望是相等的。但是利用随机的选取一个点,却有可能让我们逃脱非常差的局部最优点的陷阱,当然无法逃脱全部的陷阱。那是因为当你随便选取一点的时候,它的方向并不一定就是最优化的那个方向,因此下一步有可能移动到高点去,然后在新的位置重新寻找出路,这样就有更大的可能性获得较好的局部最优点。考虑下面的图片,在左图中,当我们第一次选择的初始化位置是第一个黑点的时候,那么根据整体梯度下降法,就会陷入那个非常糟糕的局部嘴有点去了。然而如果我们选择的是随机梯度下降法,就有可能因为某个点的方向是偏离最优点的而使得前进的方向是想着右边的,这样就可以跳过该陷阱了。由图中,根据整体梯度下降法,当遇到平缓区域的时候,该方法就会认为找到最优点了,就会停滞不前。而随机梯度下降法却由于不同点的方向不一致从而推动了算法继续向前移动,于是我们再次逃脱了该陷阱了。

应用随机梯度下降法有如下好处:

1、计算代价小,因为每次只选取一个点进行计算

2、随机性有助于逃脱局部最小点,找到较好的最小点

3、简单,因为每次只选取一个点进行计算

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2095

2095

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?