Spark是一个针对超大数据集合的低延迟的集群分布式计算系统,比MapReducer快40倍左右。

Spark是hadoop的升级版本,Hadoop作为第一代产品使用HDFS,第二代加入了Cache来保存中间计算结果,并能适时主动推Map/Reduce任务,第三代就是Spark倡导的流Streaming。

Spark兼容Hadoop的APi,能够读写Hadoop的HDFS HBASE 顺序文件等。

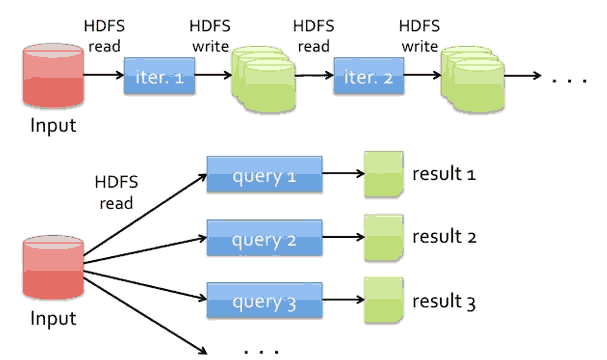

传统Hadoop如下图 性能慢原因有:磁盘IO 复制和序列化等等,涉及图中的HDFS

而在Spark中,使用内存替代了使用HDFS存储中间结果:

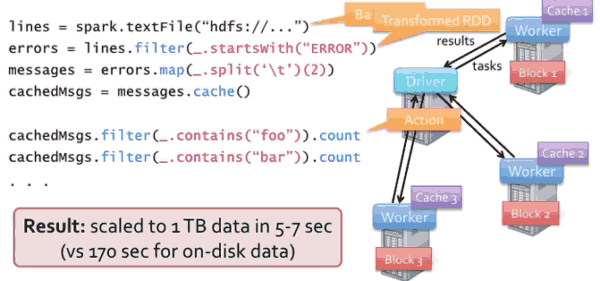

Spark架构图

Spark的编程模型

弹性的分布数据集(RDD) :分布式对象集合能够跨集群在内存中保存。多个并行操作,失败自动恢复。

使用内存集群计算, 内存访问要比磁盘快得多。有Scala Java Python API,能够从Scala和Python访问。

下面是一个简单的对日志log计数的代码:

/*** SimpleJob.scala ***/

import spark.SparkContext

import SparkContext._

object SimpleJob {

def main(args: Array[String]) {

val logFile = "/var/log/syslog" // Should be some file on your system

val sc = new SparkContext("local", "Simple Job", "$YOUR_SPARK_HOME",

List("target/scala-2.9.3/simple-project_2.9.3-1.0.jar"))

val logData = sc.textFile(logFile, 2).cache()

val numAs = logData.filter(line => line.contains("a")).count()

val numBs = logData.filter(line => line.contains("b")).count()

println("Lines with a: %s, Lines with b: %s".format(numAs, numBs))

}

}

运行原理图:

当进行filter操作是,是一种transformed RDD,RDD跟踪这种转换,当有数据丢失失败时,重新计算 得到这个数据。

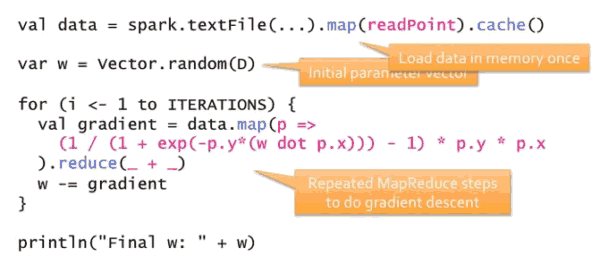

Spark支持物流logistic表达式,如下图:

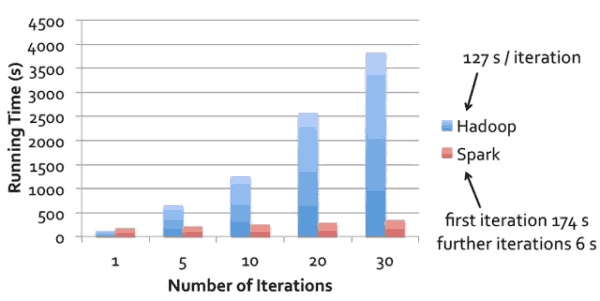

物流表达式相比Hadoop的遍历性能:

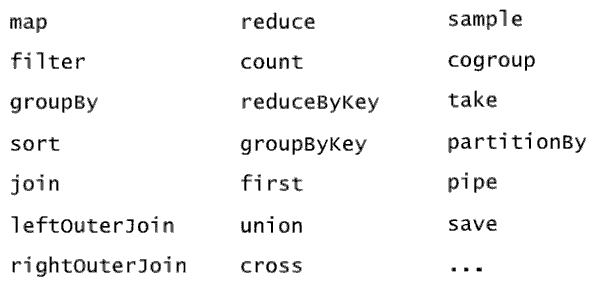

支持以下数据分析操作:

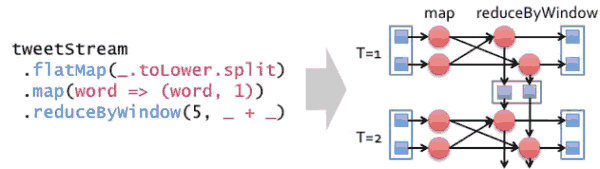

Spark流处理

以推流方式处理数据:

Shark

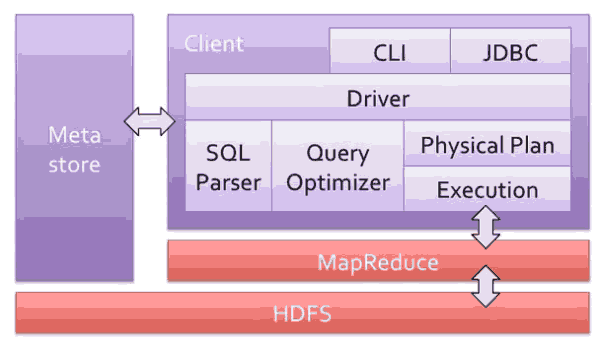

Shark是基于Spark上的“Hive”,看看基于hadoop的Hive:

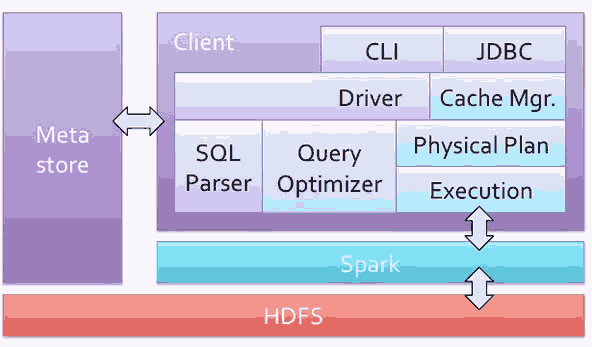

而Shark的结构图:

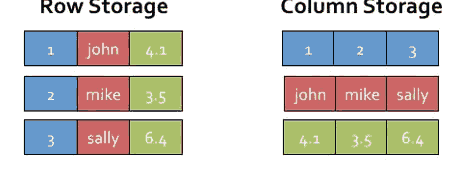

Hive是记录每行记录一个对象,而shark是每列记录:

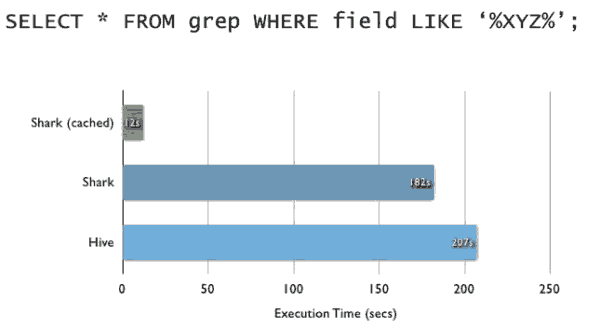

执行SQL时间对比:

641

641

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?