引用说明

本文所引用的分析来自于:

百科 信息熵

熵的定义

熵是对混乱程度的度量,熵值越大,说明混乱程度越大,越不确定,也就越随机, 则概率就越小。

通常,一个信源发送出什么符号是不确定的,衡量它可以根据其出现的概率来度量。概率大,出现机会多,不确定性小;反之不确定性就大。

不确定性函数

f

f

f是概率

P

P

P的减函数;两个独立符号所产生的不确定性应等于各自不确定性之和,即

f

(

P

1

,

P

2

)

=

f

(

P

1

)

+

f

(

P

2

)

f(P_1,P_2)=f(P_1)+f(P_2)

f(P1,P2)=f(P1)+f(P2),这称为可加性。同时满足这两个条件的函数f是对数函数,即 :

f

(

P

)

=

l

o

g

(

1

P

)

=

−

l

o

g

(

P

)

f(P)=log(\frac {1}{P}) = -log(P)

f(P)=log(P1)=−log(P)

P表示概率

离散型随机变量的熵

计算公式:

H

(

U

)

=

−

∑

i

=

1

n

P

i

∗

l

o

g

(

P

i

)

H(U) = -\sum_{i=1}^n P_i *log(P_i)

H(U)=−i=1∑nPi∗log(Pi)

若随机变量有n种取值: U 1 , . . . U i . . . U n U_1, ... U_i ... U_n U1,...Ui...Un,对应概率为: P 1 , . . . P i . . . P n P_1,...P_i ...P_n P1,...Pi...Pn,且各种变量的出现彼此独立。

连续型随机变量的熵

计算公式:

H

(

U

)

=

−

P

l

o

g

(

P

)

−

(

1

−

P

)

l

o

g

(

1

−

P

)

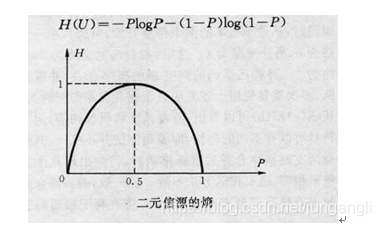

H(U) = -Plog(P) - (1-P)log(1-P)

H(U)=−Plog(P)−(1−P)log(1−P)

U表示随机变量;

P表示随机变量取值为U的概率, 也可以表示为P(U);

其中满足: 0 ≤ H ( U ) ≤ l o g ( U ) 0\le H(U) \le log(U) 0≤H(U)≤log(U)

熵的函数曲线

|

|---|

| 离散/连续型随机变量熵 |

由图可见,离散信源的信息熵具有:

- 非负性:即收到一个信源符号所获得的信息量应为正值,H(U)≥0;

- 对称性:即对称于P=0.5;

- 确定性:H(1,0)=0,即P=0或P=1已是确定状态,所得信息量为零;

- 极值性:因H(U)是P的上凸函数,且一阶导数在P=0.5时等于0,所以当P=0.5时,H(U)最大。

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?