1、安装zookeeper

步骤1:下载并解压zookeeper安装包

tar -zxvf zookeeper-3.4.11.tar.gz

步骤2:配置环境变量

export ZOOK=/opt/hadoop/zookeeper-3.4.11

步骤3:配置文件 zoo.cfg

cd conf/

复制配置文件:

cp zoo_sample.cfg zoo.cfg

修改配置文件:

#数据目录

dataDir=/home/admin/zookeeper/data

#日志目录

dataLogDir=/home/admin/zookeeper/logs

#心跳间隔时间,zookeeper中使用的基本时间单位,毫秒值。每隔2秒发送一个心跳

tickTime=2000

#leader与客户端连接超时时间。表示5个心跳间隔

initLimit=5

#Leader与Follower之间的超时时间,表示2个心跳间隔

syncLimit=2

#客户端连接端口

clientPort=2181

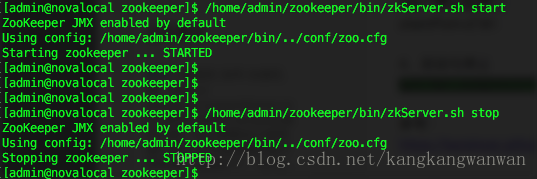

> bin/zkServer.sh start

**停止zookeeper:zkServer.sh stop

3、安装kafka

步骤1:下载并解压kafka

tar -xzvf kafka_2.11-1.0.0.tgz

步骤2:配置kafka,修改server.properties

mkdir /usr/local/kafka/log/kafka #创建kafka日志目录

cd /usr/local/kafka/config #进入配置目录

vi server.properties #编辑修改相应的参数

broker.id=0

port=9092 #端口号

host.name=10.8.5.101 #服务器IP地址,修改为自己的服务器IP

log.dirs=/usr/local/kafka/log/kafka #日志存放路径,上面创建的目录

zookeeper.connect=localhost:2181 #zookeeper地址和端口,单机配置部署,localhost:2181

步骤3、配置kafka下的zookeeper

mkdir /usr/local/kafka/zookeeper #创建zookeeper目录

mkdir /usr/local/kafka/log/zookeeper #创建zookeeper日志目录

cd /usr/local/kafka/config #进入配置目录

vi zookeeper.properties #编辑修改相应的参数

dataDir=/usr/local/kafka/zookeeper #zookeeper数据目录

dataLogDir=/usr/local/kafka/log/zookeeper #zookeeper日志目录

clientPort=2181

maxClientCnxns=100

tickTime=2000

initLimit=10

步骤4:启动zookeeper和kafka(可以在命令的结尾加个&符号,这样就可以启动后离开控制台)

> bin/zookeeper-server-start.sh config/zookeeper.properties &

>bin/kafka-server-start.sh config/server.properties &

4、测试kafka

步骤1:启动zookeeper

>bin/zookeeper-server-start.sh config/zookeeper.properties &

步骤2:启动kafka

>bin/kafka-server-start.sh config/server.properties &

步骤3:测试

创建kafka topic

bin/kafka-topics.sh --zookeeper node01:2181 --create --topic t_cdr --partitions 30 --replication-factor 2

注: partitions指定topic分区数,replication-factor指定topic每个分区的副本数

- partitions分区数:

虽然增加分区数可以提供kafka集群的吞吐量、但是过多的分区数或者或是单台服务器上的分区数过多,会增加不可用及延迟的风险。因为多的分区数,意味着需要打开更多的文件句柄、增加点到点的延时、增加客户端的内存消耗。

分区数也限制了consumer的并行度,即限制了并行consumer消息的线程数不能大于分区数

分区数也限制了producer发送消息是指定的分区。如创建topic时分区设置为1,producer发送消息时通过自定义的分区方法指定分区为2或以上的数都会出错的;这种情况可以通过alter –partitions 来增加分区数。

- replication-factor副本

如果没有在创建时显示指定或通过API向一个不存在的topic生产消息时会使用broker(server.properties)中的default.replication.factor配置的数量

查看所有topic列表

bin/kafka-topics.sh --zookeeper node01:2181 --list

查看指定topic信息

bin/kafka-topics.sh --zookeeper node01:2181 --describe --topic t_cdr

控制台向topic生产数据

bin/kafka-console-producer.sh --broker-list node86:9092 --topic t_cdr

控制台消费topic的数据

bin/kafka-console-consumer.sh --zookeeper node01:2181 --topic t_cdr --from-beginning

查看topic某分区偏移量最大(小)值

bin/kafka-run-class.sh kafka.tools.GetOffsetShell --topic hive-mdatabase-hostsltable --time -1 --broker-list node86:9092 --partitions 0

注: time为-1时表示最大值,time为-2时表示最小值

增加topic分区数, 为topic t_cdr 增加10个分区

bin/kafka-topics.sh --zookeeper node01:2181 --alter --topic t_cdr --partitions 10

删除topic,慎用,只会删除zookeeper中的元数据,消息文件须手动删除

bin/kafka-run-class.sh kafka.admin.DeleteTopicCommand --zookeeper node01:2181 --topic t_cdr

查看topic消费进度

这个会显示出consumer group的offset情况, 必须参数为--group, 不指定--topic,默认为所有topic

bin/kafka-run-class.sh kafka.tools.ConsumerOffsetChecker

5、停止kafka

步骤1:停止Kafka

>bin/kafka-server-stop.sh config/server.properties

步骤2:停止Zookeeper server

>bin/zookeeper-server-stop.sh config/zookeeper.properties

至此,启动,测试,停止全过程ok。

1147

1147

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?