深度学习的风暴刮了又刮,终于挂到了我这个学渣这里。

始于辛顿,乐存等大牛,几年前余凯,老师木,梁斌等都在研究这个,直到现在,我才得以在这上面有所领悟。

今天介绍的这篇文章《CNN Features off-the-shelf: an Astounding Baseline for Recognition》是微博上赵乐平usc推荐的,看完后非常震撼。

文章的主旨一句话就概括清楚了:深度学习结合卷积神经网络应该作为视觉识别任务的首选方案。

具体原委听我细细道来:

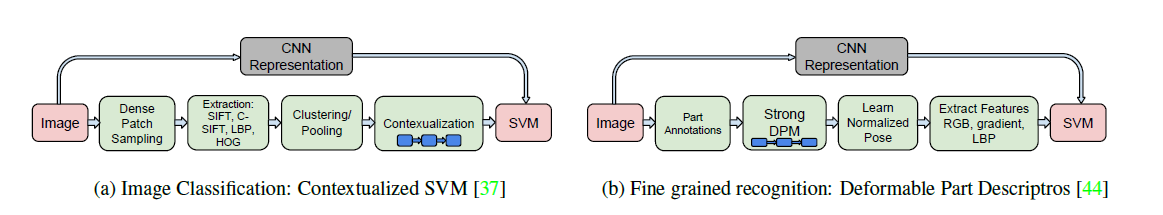

文章中有一幅图,介绍了CNN+线性SVM方法和其他方法的流程对比:

对,这就是简单与复杂的差别,要注意到,这两者的结果都是可以竞争的,很多时候CNN的要更好!

文章介绍,最近深度学习很火啊,但是我没那么多的时间去做训练,没有多少GPU编程知识,好可惜。不过没关系,OverFeat是在ImageNet库上训练好的深度卷积神经网络模型,它已经开源了,我们可以用它来对普通的图片进行特征提取,然后直接进入分类器训练,对比一下和现在的State-of-art方法的识别结果啊!

这句话真正打中了我的心,哦,对啊,SIFT,HOG都是特征提取的方法,CNN也不例外,虽然OverFeat的训练时在特定库上进行的,但是这个库包罗万象,而且CNN提取的特征已经在很多场合中证明是非常强大的,那么把这个特定的CNN网络用于普通的图片的特征提取,也并不是没有道理的事。

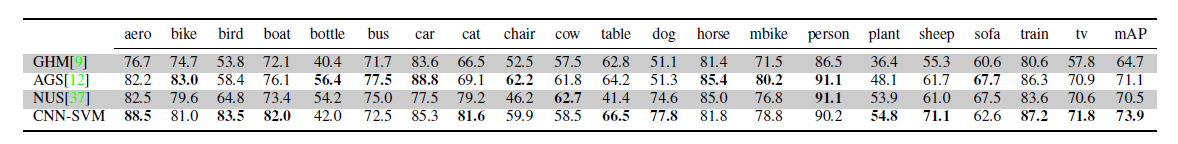

作者在文中对很多不同的视觉任务进行了评比,包括图片分类,场景分类,精细分类(同一大类中各种子类),标签检测(从图片中抽象出来的标签),图像检索等等。这些任务中,简单的CNN特征+线性SVM在结果上至少是可以和State-of-art竞争的,同时在很多任务中是打败了State-of-art的,要知道,State-of-art通常都需要各种复杂的特征提取方式以及非常长的训练时间,现在一切都可以用简单的CNN特征+线性SVM来比拟了。看一个简单的结果:

CNN赢的毫无压力有木有!

我常感觉,计算机视觉的中心任务就是特征的提取,或者说图像的表达方式。深度CNN是一个划时代的技术,它的确应该成为所有计算机视觉任务的基准方法:所有新的算法都要和它比一比...或者在做很多事情的时候,直接拿过来用就行了,这就是标题Off-the-shelf的含义不是吗?

3705

3705

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?