http://www.zhihu.com/question/20447622

最小二乘法可以从Cost/Loss function角度去想,这是

统计(机器)学习

里面一个重要概念,一般建立模型就是让loss function最小,而最小二乘法可以认为是 loss function = (y_hat -y )^2的一个特例,类似的想各位说的还可以用各种距离度量来作为loss function而不仅仅是欧氏距离。所以loss function可以说是一种更一般化的说法。

最大似然估计是从 概率角度 来想这个问题,直观理解,似然函数在给定参数的条件下就是 观测到一组数据realization的概率 (或者概率密度)。最大似然函数的思想就是什么样的参数才能使我们观测到目前这组数据的 概率是最大 的。

类似的从概率角度想的估计量还有 矩估计(moment estimation) 。就是通过一阶矩 二阶矩等列方程,来反解出参数。

各位有人提到了正态分布。最大似然估计和最小二乘法还有一大区别就是,最大似然估计是需要有 分布假设 的,属于参数统计,如果连分布函数都不知道,又怎么能列出似然函数呢? 而最小二乘法则没有这个假设 。 二者的相同之处是都把估计问题变成了最优化问题。但是最小二乘法是一个凸优化问题,最大似然估计不一定是。

最大似然估计是从 概率角度 来想这个问题,直观理解,似然函数在给定参数的条件下就是 观测到一组数据realization的概率 (或者概率密度)。最大似然函数的思想就是什么样的参数才能使我们观测到目前这组数据的 概率是最大 的。

类似的从概率角度想的估计量还有 矩估计(moment estimation) 。就是通过一阶矩 二阶矩等列方程,来反解出参数。

各位有人提到了正态分布。最大似然估计和最小二乘法还有一大区别就是,最大似然估计是需要有 分布假设 的,属于参数统计,如果连分布函数都不知道,又怎么能列出似然函数呢? 而最小二乘法则没有这个假设 。 二者的相同之处是都把估计问题变成了最优化问题。但是最小二乘法是一个凸优化问题,最大似然估计不一定是。

知乎用户

其实我觉着你这个答案站的角度才比较符合这个问题的本质。

补充一点点:从优化的角度上来讲,负的log likelihood 就是求MLE(最大似然估计)要优化的目标函数。

那么为啥MLE需要设置分布这么麻烦,还有这么多应用,因为当likelihood设置正确的时候,这个目标函数给出的解最efficient。

那么为啥有这么多人把MLE和OLSE搞混,因为当likelihood用的是gaussian的时候,由于gaussian kernel里有个类似于Euclidean distance的东西,一求log就变成square loss了,导致解和OLSE是一样的。而碰巧刚接触MLE的时候基本都是gaussian假设,这才导致很多人分不清楚。

补充一点点:从优化的角度上来讲,负的log likelihood 就是求MLE(最大似然估计)要优化的目标函数。

那么为啥MLE需要设置分布这么麻烦,还有这么多应用,因为当likelihood设置正确的时候,这个目标函数给出的解最efficient。

那么为啥有这么多人把MLE和OLSE搞混,因为当likelihood用的是gaussian的时候,由于gaussian kernel里有个类似于Euclidean distance的东西,一求log就变成square loss了,导致解和OLSE是一样的。而碰巧刚接触MLE的时候基本都是gaussian假设,这才导致很多人分不清楚。

从概率论的角度:

-------------------------------------------------------------------

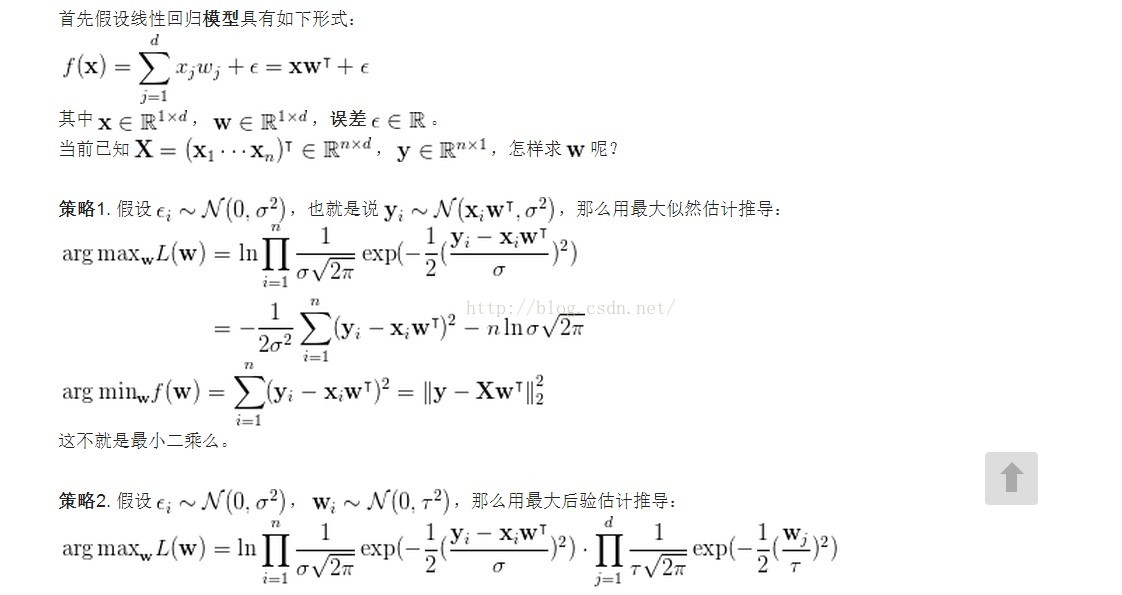

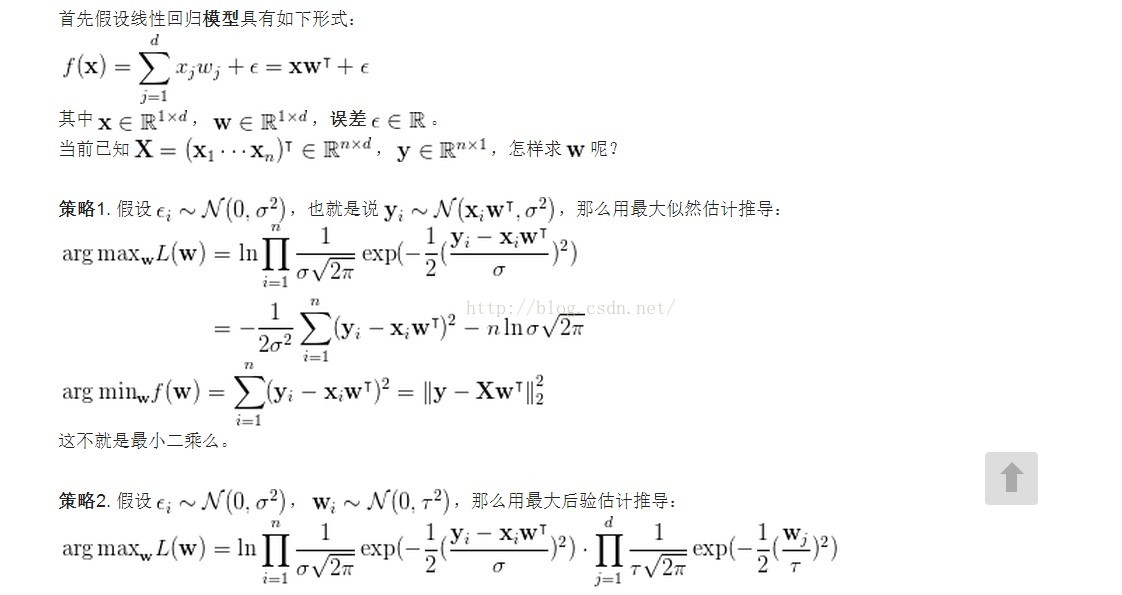

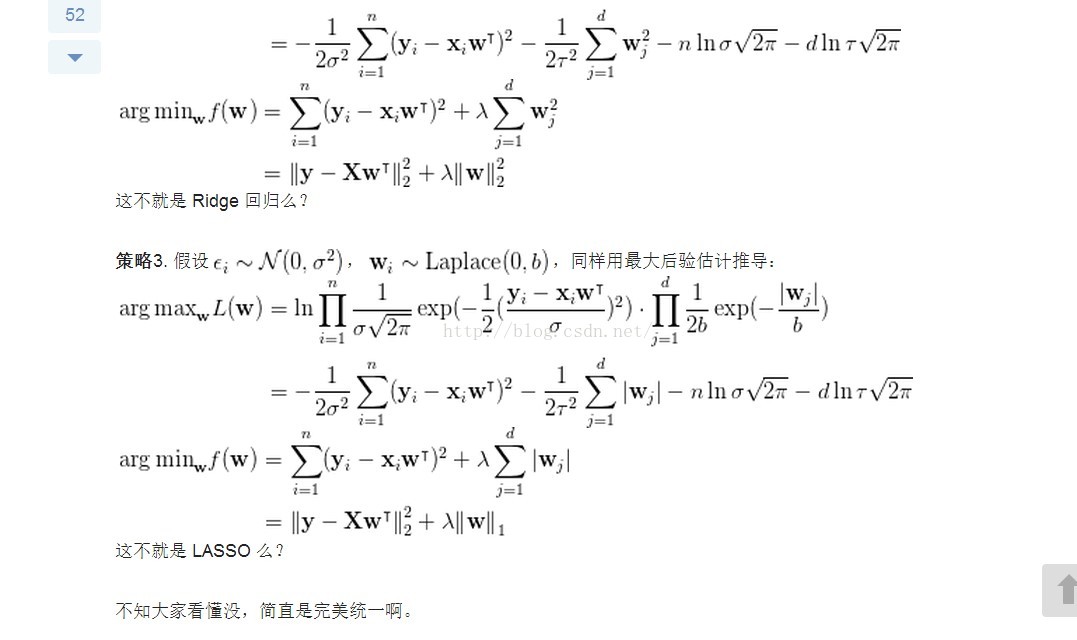

下面贴一下我以前的推导给大家参考,相信会有启发。如有错误还望指正 -_-

注意:

- Least Square 的解析解可以用 Gaussian 分布以及最大似然估计求得

- Ridge 回归可以用 Gaussian 分布和最大后验估计解释

- LASSO 回归可以用 Laplace 分布和最大后验估计解释

-------------------------------------------------------------------

下面贴一下我以前的推导给大家参考,相信会有启发。如有错误还望指正 -_-

注意:

- 假设你已经懂得:高斯分布、拉普拉斯分布、最大似然估计,最大后验估计(MAP)。

- 按照李航博士的观点,机器学习三要素为:模型、策略、算法。一种模型可以有多种求解策略,每一种求解策略可能最终又有多种计算方法。以下只讲模型策略,不讲算法。(具体怎么算,convex or non-convex, 程序怎么写,那是数值分析问题)

1649

1649

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?