RBM(Restricted Boltzmann Machine)是一种基于能量的概率模型,常用于无监督学习任务中。下面给出RBM的公式推导及Matlab代码实现。

一、RBM的公式推导

RBM是一个两层神经网络,包括输入层和隐藏层。假设输入层有m个节点,隐藏层有n个节点。RBM的网络结构如下图所示:

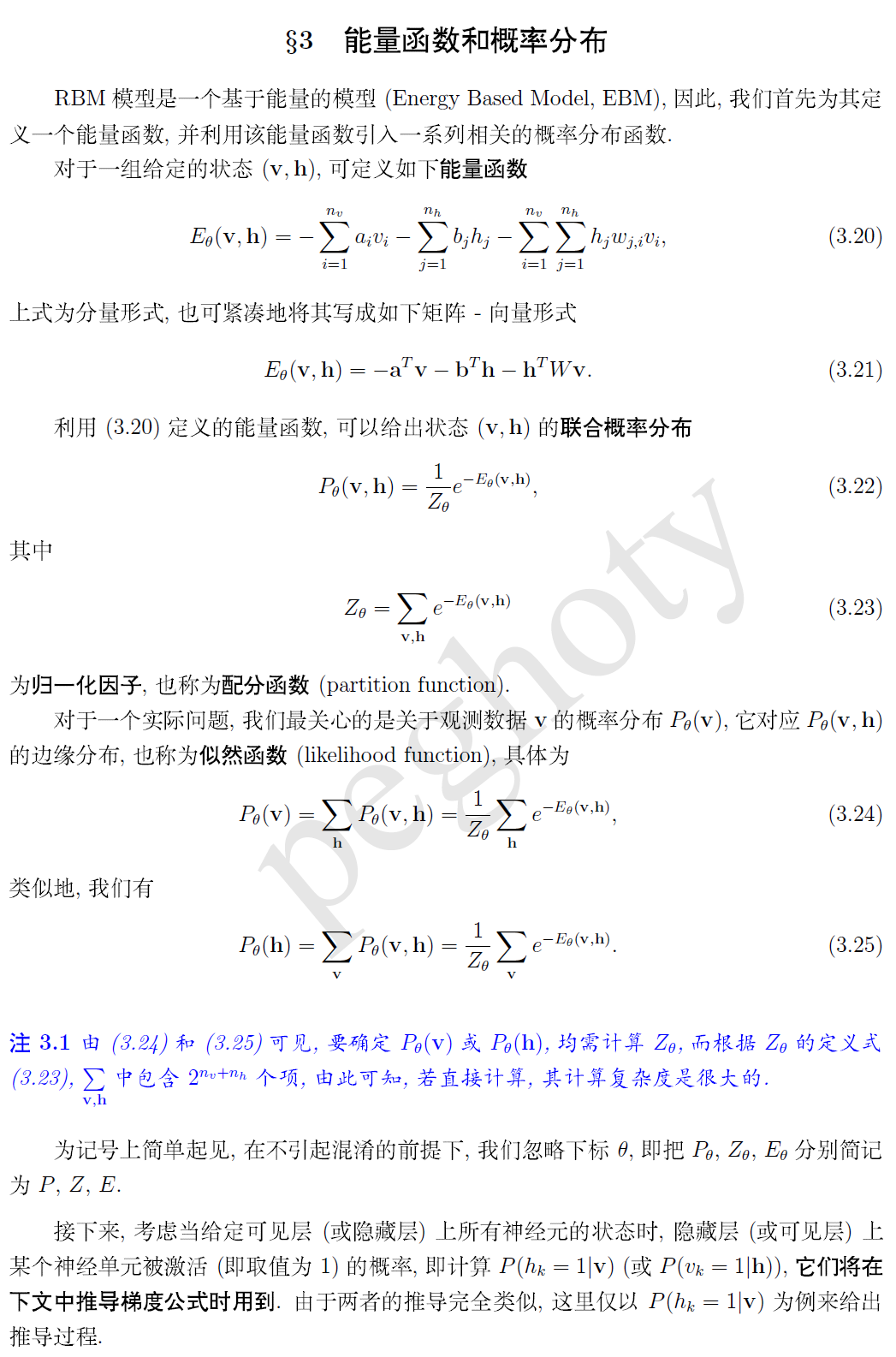

RBM的能量函数为:

$$

E(v,h)=-\sum_{i=1}^{m}\sum_{j=1}^{n}v_iw_{ij}h_j-\sum_{i=1}^{m}v_ib_i-\sum_{j=1}^{n}h_jc_j

$$

其中,$v$表示输入层的节点状态,$h$表示隐藏层的节点状态,$w_{ij}$表示第$i$个输入节点和第$j$个隐藏节点之间的连接权重,$b_i$表示第$i$个输入节点的偏置,$c_j$表示第$j$个隐藏节点的偏置。

RBM的概率分布为:

$$

P(v,h)=\frac{1}{Z}e^{-E(v,h)}

$$

其中,$Z$为归一化因子,可以表示为:

$$

Z=\sum_{v}\sum_{h}e^{-E(v,h)}

$$

RBM的训练目标是最大化样本出现的概率,即最大化对数似然函数。对于一个训练样本$v$,其对应的对数似然函数为:

$$

\log P(v)=\log\sum_{h}e^{-E(v,h)}

$$

使用对比散度(Contrastive Divergence,CD)算法来学习RBM的参数。CD算法的核心思想是通过采样来估计对数似然函数的梯度。具体地,对于一个训练样本$v$,按照以下步骤进行:

1. 将$v$作为输入层的状态,通过前向传播计算出隐藏层的状态$h_0$;

2. 从隐藏层的概率分布中采样出一个样本$h_1$;

3. 将$h_1$作为隐藏层的状态,通过反向传播计算出输入层的状态$v_1$;

4. 从输入层的概率分布中采样出一个样本$v_2$;

5. 将$v_2$作为输入层的状态,通过前向传播计算出隐藏层的状态$h_2$。

最后,更新参数$w_{ij}$、$b_i$和$c_j$,使得对数似然函数的梯度最大化。

具体地,对于一个样本$v$,其对应的参数梯度为:

$$

\frac{\partial\log P(v)}{\partial w_{ij}}=v_ih_{0j}-v_ih_{1j}

$$

$$

\frac{\partial\log P(v)}{\partial b_i}=v_i-v_{2i}

$$

$$

\frac{\partial\log P(v)}{\partial c_j}=h_{0j}-h_{2j}

$$

其中,$h_{0}$、$h_{1}$和$h_{2}$分别表示通过前向传播计算出的隐藏层状态。

二、RBM的Matlab代码实现

以下是使用Matlab实现RBM的代码示例,其中使用了CD算法来训练RBM模型。

```matlab

% RBM的Matlab代码实现

% 数据集:MNIST手写数字数据集,训练集60000个样本,测试集10000个样本

% 神经网络结构:输入层784个节点,隐藏层100个节点

% CD算法的参数:k=1,学习率lr=0.1

% 加载数据集

load mnist_train_data.mat

load mnist_test_data.mat

% 初始化RBM模型参数

input_size = 784; % 输入层节点数

hidden_size = 100; % 隐藏层节点数

w = 0.1 * randn(input_size, hidden_size); % 输入层和隐藏层之间的连接权重

b = zeros(1, input_size); % 输入层的偏置

c = zeros(1, hidden_size); % 隐藏层的偏置

% 训练RBM模型

batch_size = 100; % 每个batch的样本数

num_epochs = 10; % 迭代次数

k = 1; % CD算法的参数

lr = 0.1; % 学习率

% 对训练集进行预处理,将像素值归一化到[0,1]之间

train_data = double(train_data) / 255;

for epoch = 1:num_epochs % 迭代训练

for batch = 1:floor(size(train_data, 1) / batch_size) % 逐个batch训练

% 选取一个batch的样本

batch_data = train_data((batch - 1) * batch_size + 1 : batch * batch_size, :);

% 正向传播

h0_prob = sigmoid(batch_data * w + repmat(c, batch_size, 1)); % 隐藏层的概率分布

h0_sample = double(h0_prob > rand(size(h0_prob))); % 从概率分布中采样出隐藏层的状态

v1_prob = sigmoid(h0_sample * w' + repmat(b, batch_size, 1)); % 重构输入层的概率分布

v1_sample = double(v1_prob > rand(size(v1_prob))); % 从概率分布中采样出重构的输入层状态

% 反向传播

h1_prob = sigmoid(v1_sample * w + repmat(c, batch_size, 1)); % 重构的隐藏层的概率分布

h1_sample = double(h1_prob > rand(size(h1_prob))); % 从概率分布中采样出重构的隐藏层状态

% 计算参数梯度

w_grad = batch_data' * h0_prob - v1_sample' * h1_prob; % 输入层和隐藏层之间的连接权重的梯度

b_grad = sum(batch_data - v1_sample); % 输入层的偏置的梯度

c_grad = sum(h0_prob - h1_prob); % 隐藏层的偏置的梯度

% 更新参数

w = w + lr * w_grad / batch_size;

b = b + lr * b_grad / batch_size;

c = c + lr * c_grad / batch_size;

end

% 每个epoch结束后,计算一次对数似然函数的值

error = zeros(size(train_data, 1), 1);

for i = 1:size(train_data, 1)

v = train_data(i, :);

h_prob = sigmoid(v * w + repmat(c, 1, 1)); % 隐藏层的概率分布

v_recon = sigmoid(h_prob * w' + repmat(b, 1, 1)); % 重构的输入层的概率分布

error(i) = -sum(v .* log(v_recon) + (1 - v) .* log(1 - v_recon));

end

fprintf('Epoch %d, error = %f\n', epoch, mean(error));

end

% 测试RBM模型

test_data = double(test_data) / 255; % 对测试集进行预处理

h_prob = sigmoid(test_data * w + repmat(c, size(test_data, 1), 1)); % 隐藏层的概率分布

v_recon = sigmoid(h_prob * w' + repmat(b, size(test_data, 1), 1)); % 重构的输入层的概率分布

error = -sum(sum(test_data .* log(v_recon) + (1 - test_data) .* log(1 - v_recon), 2)); % 计算对数似然函数的值

fprintf('Test error = %f\n', error);

% 定义sigmoid函数

function y = sigmoid(x)

y = 1 ./ (1 + exp(-x));

end

```

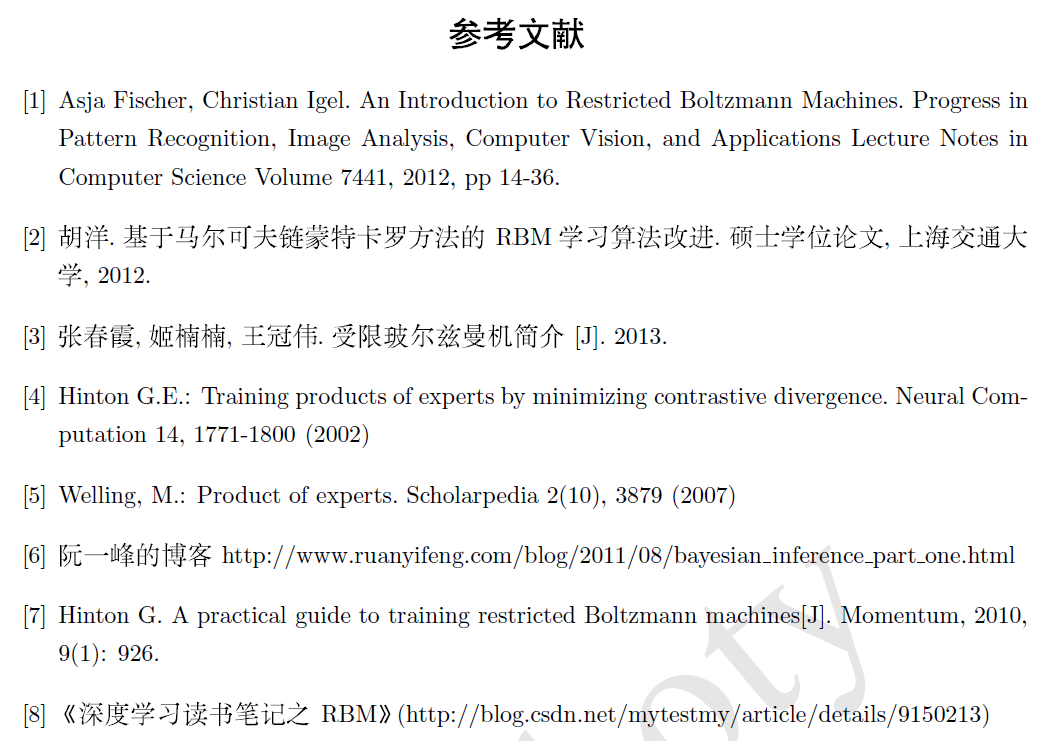

参考文献:

[1] Hinton G E, Salakhutdinov R R. Restricted Boltzmann machines for collaborative filtering[C]//Proceedings of the 25th international conference on Machine learning. ACM, 2008: 448-455.

[2] Fischer A, Igel C. An introduction to restricted Boltzmann machines[J]. Progress in Pattern Recognition, Image Analysis, Computer Vision, and Applications, 2012, 7441: 14-36.

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?