之前一直是在单机写Spark程序,写完拿到服务器上跑,但是本地调试程序很不方便。本文旨在方便开发,在本地搭建简单的环境,可以在本地调试。

前提:本文是在windows环境下,假设你电脑没有安装任何开发环境,如有安装过可自行跳过。

需要:jdk1.8+Python3.5+spark-2.1.0-bin-hadoop2.6+hadoop-common-2.2.0-bin-master+JetBrains PyCharm Community Edition 2017.1.2

第一步:安装jdk1.8

因为Spark的源码是Scala编写的,而Scala语言是基于JVM之上的,所以需要以JAVA为基础,先安装JDK和配置环境变量,具体安装JDK和JRE可以自行搜索,不再赘述。只要在cmd命令行输入“javac”和“java”出现相应的信息,而不提示:“不是内部或者外部命令”就可以了。

第二步:安装Python和py4j模块

总所周知Python有2.x和3.x的版本,笔者安装过2.x和3.x两个版本的都可以根据自己的喜好和使用习惯安装相应的版本,这里安装3.6版本pyspark会有问题,所以建议安装3.x版本的读者安装3.5(写这篇博客的时候Python最新版本是3.6),具体的Python安装细节网上一大片,读者可以自行查阅资料安装。

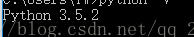

安装完Python后cmd输入“python -V” 如果出现相应的版本;或者cmd直接输入“python”,显示“>>>”,就说明python安装成功。如下图:

Python安装成功后,需要安装py4j的模块,直接cmd输入"pip install py4j",有些读者可能在公司或者其他原因受网络的限制无法安装,可以到Python Windows扩展模块网站直接下载需要的模块,或者去Python安装模块官网 个人都是到前者LFD下载。

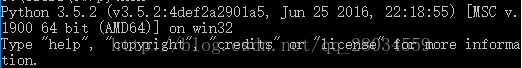

第三步:安装Spark

可以到Spark官网下载相应的Spark版本,我自己选择的是hadoop-2.6.0.tar.gz,点击既可以下载,如下图:

貌似在官网下载特别的慢,这里推荐读者到Apache的镜像去下载,比较快。

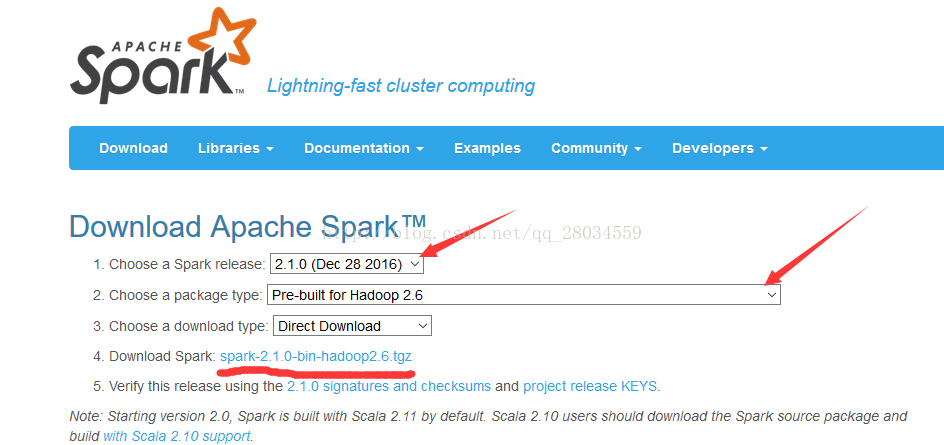

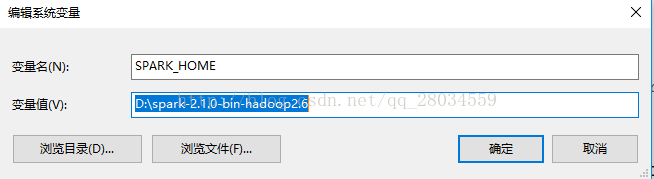

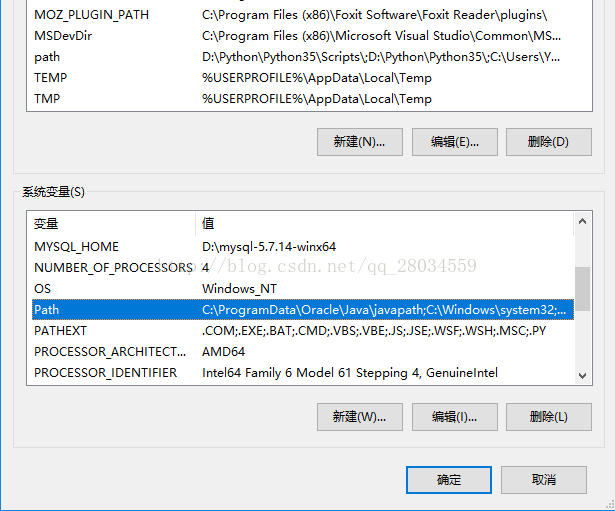

将下载完后的hadoop-2.6.0.tar.gz文件解压到相应的目录(随便选择)假设为D:\spark-2.1.0-bin-hadoop2.6,接下来就需要配置环境变量了:右击“此电脑”-->“属性”-->“高级系统设置”-->“环境变量”-->“新建”,变量名输入:"SPARK_HOME" 变量值输入spark-2.1.0-bin-hadoop2.6所在的路径,这里是:"D:\spark-2.1.0-bin-hadoop2.6",

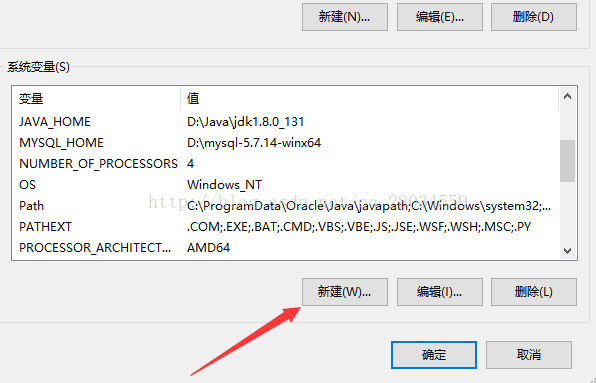

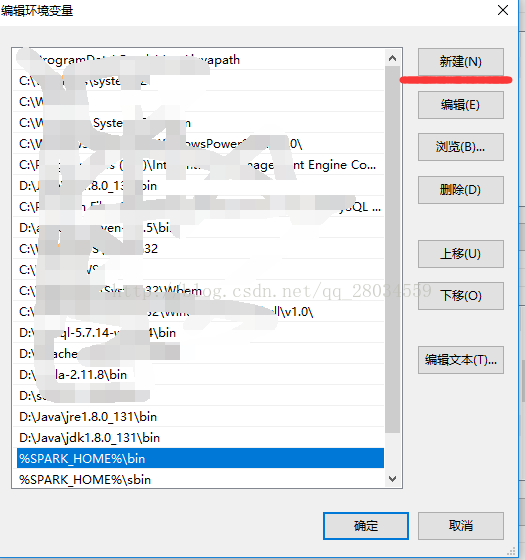

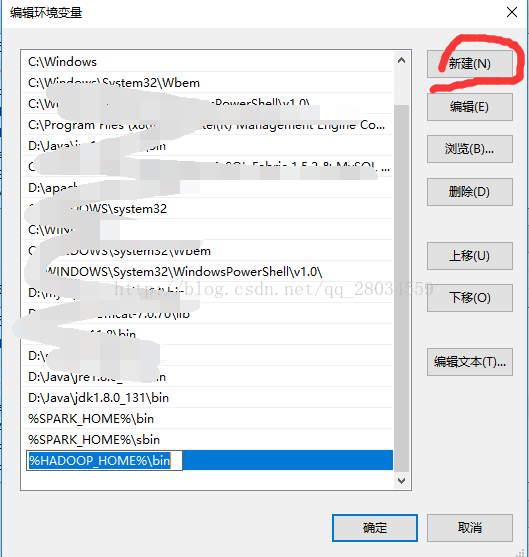

接着在path里边添加"%SPARK_HOME%\bin"和"%SPARK_HOME%\sbin"最后千万别忘了确定。如下图:

1.新建系统变量:

2.添加path:

到此Spark的环境变量就配置好了。接下来就是需要配置Hadoop了。

第四步:安装Hadoop相关依赖

这里不需要完全安装Hadoop所有的东西,当然你也可以去下载整个Hadoop:hadoop-2.6.0.tar.gz。但是要注意跟上一步安装的Spark的版本对应,一般只安装必要的依赖就可以,在Github可以下载,跟第二步差不多,首先解压到D:\hadoop-common-2.2.0-bin-master,然后把bin目录添加到环境变量,步骤一样:

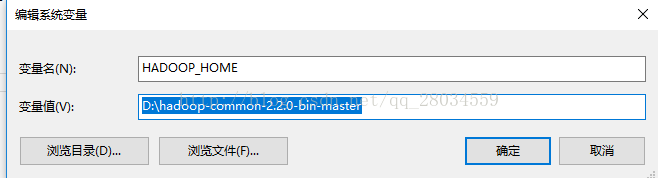

右击“此电脑”-->“属性”-->“高级系统设置”-->“环境变量”-->“新建”,变量名输入:"HADOOP_HOME" 变量值输入hadoop-common-2.2.0-bin-master所在的路径,这里是:"D:\hadoop-common-2.2.0-bin-master",

接着在path里边添加"%HADOOP_HOME%\bin",最后确定。如下图:

新建环境变量:

添加path

还差最后一步:

第五步:

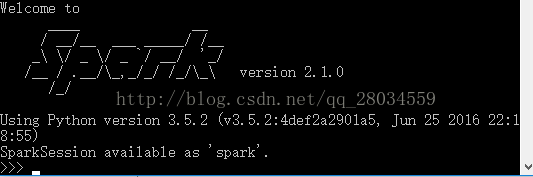

将D:\spark-2.1.0-bin-hadoop2.6\python文件夹下的"pySpark"文件夹,拷贝到自己Python安装目录下的\Lib\site-packages中。

cmd输入pyspark就会出现:

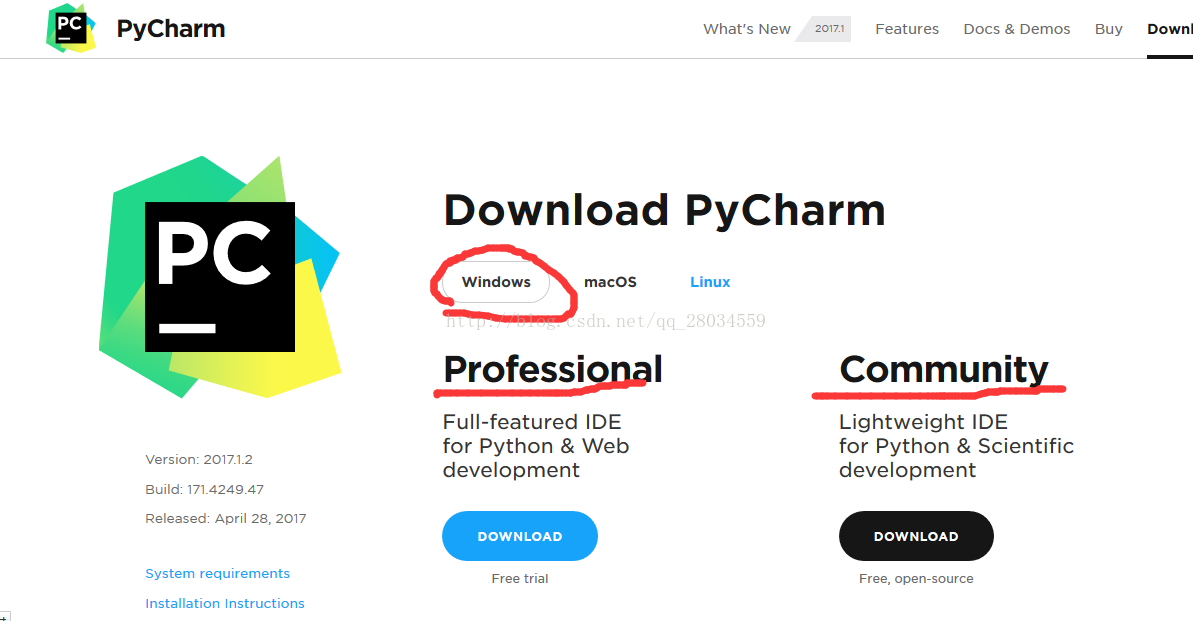

第五步:配置安装pycharm

pycharm下载地址:http://www.jetbrains.com/pycharm/选择Windows两个版本可以安装:

安装社区版本的免费的,专业版本的网上也有激活码,但是容易过期,社区版本的基本就够用了。下载完了自行安装就可以,还有主题背景字体大小读者可以自行搜索修改,具体的有关pycharm使用不在赘述。安装完毕,新建工程应该就可以编写代码运行了:

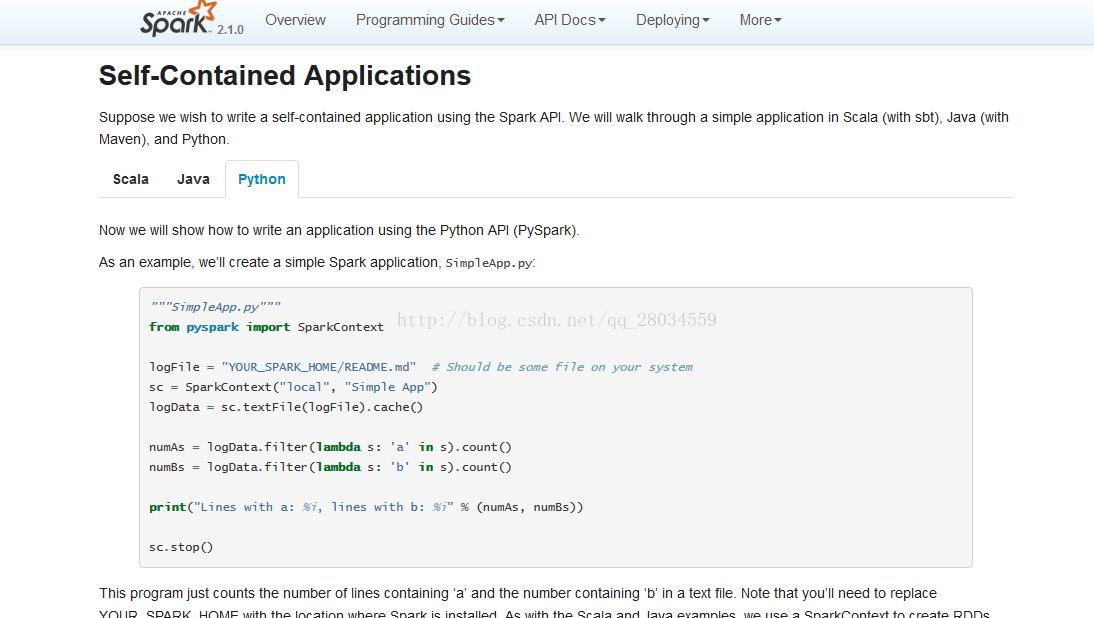

让我们来运行Spark官网的demo:

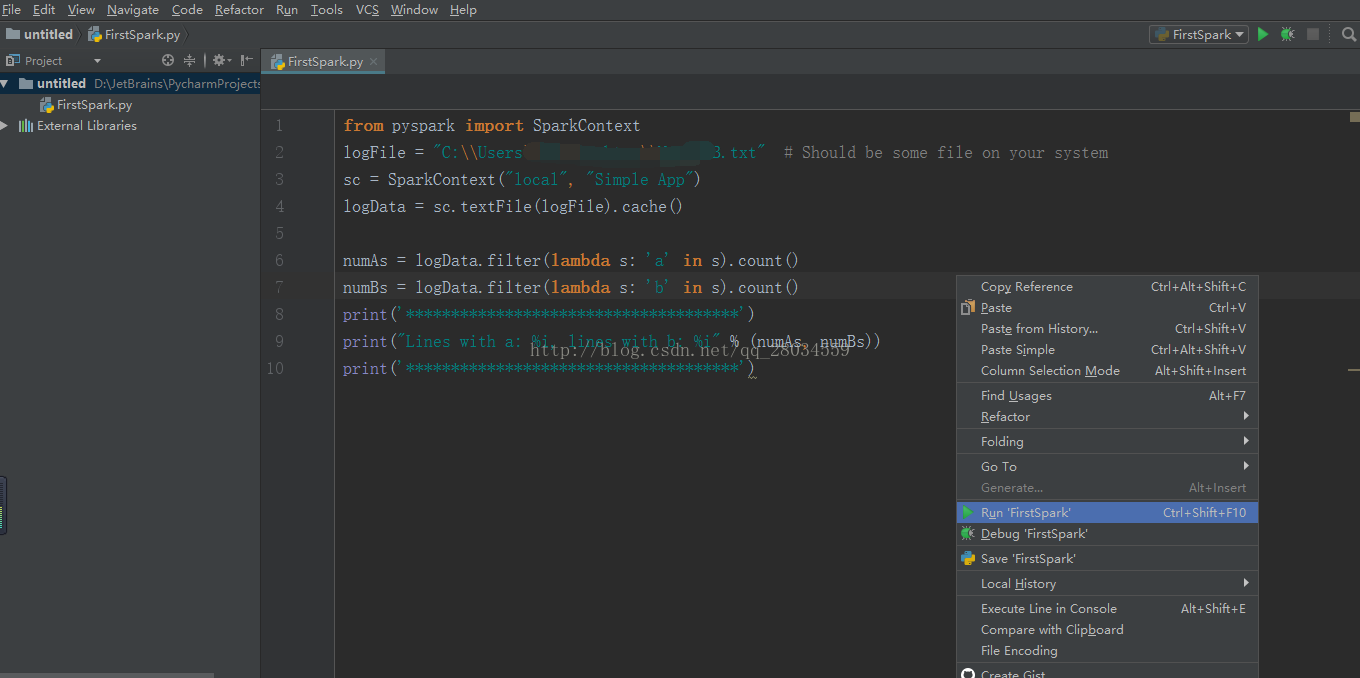

新建Python,然后代码拷贝过来,随便找个文本文件

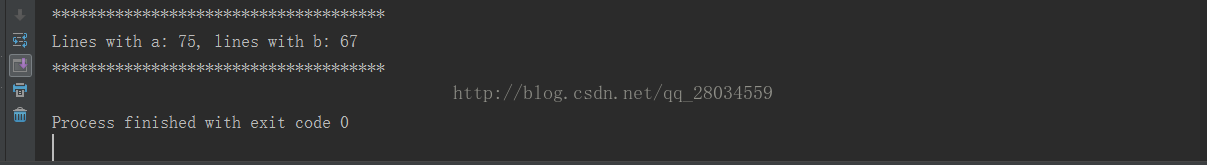

就得到结果:

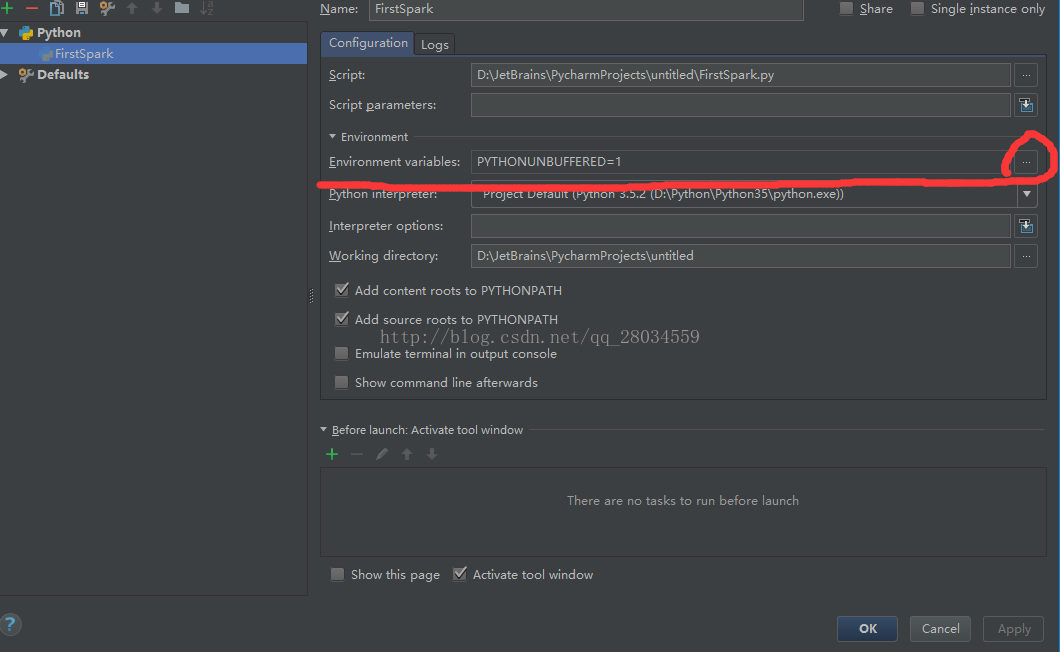

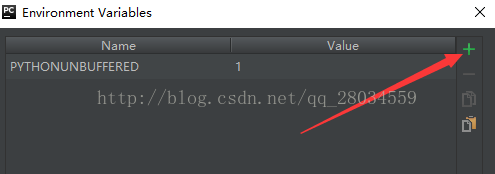

如果运行找不到"SPARK_HOME"可以在pycharm里"Run"-->"Edit Configurations"添加环境变量之前的SPARK_HOME

至此终于把环境搭建好了,你就可以在自己的电脑上开发Spark程序了。

由于本文作者水平有限,有不妥之处恳请指正。

1021

1021

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?