K近邻算法是一种监督学习算法,非常有效并且易于掌握,所以本博主就从该算法开始写起。

下一篇我们重点讲KD树^^

思想:给一个训练数据集和一个新的实例,在训练数据集中找出与这个新实例最近的K个训练实例,然后统计最近的k个训练实例中所属类别计数最多的那个类,就是新实例的类。

三要素:

1.K值的选择:k值越小表明模型越复杂,更容易过拟合;但是k值越大,模型越简单,如果k=N的时候就表明无论什么点都是训练集中类别最多的那个类。

2.距离的度量(常见的距离度量有欧式距离和马氏距离)。

3.分类决策规则(多数表决规则)。

k近邻算法的优缺点:

优点:精度高、对异常值不敏感、无数据输入假定。

缺点:计算复杂度高、空间复杂度高。

适用数据范围:数值型和标称型。

由于各个属性的特征值取值范围不同,导致数字差值最大的属性对计算结果的影响很大,所以我们通常采用的方法就是将数值归一化,如将取值范围处理为0或者-1到1之间。下面的公式可以将任意取值范围的特征值转化为0到1区间内的值:

newvalue=(oldvalue-min)/(max-min)。

代码:

from numpy import *

import operator

from os import listdir

def classify0(inX, dataSet, labels, k): #K近邻算法实现

dataSetSize = dataSet.shape[0]

#距离计算

diffMat = tile(inX, (dataSetSize,1)) - dataSet

sqDiffMat = diffMat**2

sqDistances = sqDiffMat.sum(axis=1)

distances = sqDistances**0.5

sortedDistIndicies = distances.argsort()

classCount={}

for i in range(k):#选择最小的k个点

voteIlabel = labels[sortedDistIndicies[i]]

classCount[voteIlabel] = classCount.get(voteIlabel,0) + 1

sortedClassCount = sorted(classCount.items(), key=operator.itemgetter(1), reverse=True)#排序

return sortedClassCount[0][0]

'''

def createDataSet():

group = array([[1.0,1.1],[1.0,1.0],[0,0],[0,0.1]])

labels = ['A','A','B','B']

return group, labels

'''

def file2matrix(filename):#将文本记录转换为Numpy的解析程序

fr = open(filename)

numberOfLines = len(fr.readlines()) #get the number of lines in the file

returnMat = zeros((numberOfLines,3)) #prepare matrix to return

classLabelVector = [] #prepare labels return

fr = open(filename)

index = 0

for line in fr.readlines():#解析文件到数据列表

line = line.strip()

listFromLine = line.split('\t')

returnMat[index,:] = listFromLine[0:3]

classLabelVector.append(int(listFromLine[-1]))

index += 1

return returnMat,classLabelVector

def autoNorm(dataSet):#归一化特征值

minVals = dataSet.min(0)

maxVals = dataSet.max(0)

ranges = maxVals - minVals

normDataSet = zeros(shape(dataSet))

m = dataSet.shape[0]

normDataSet = dataSet - tile(minVals, (m,1))

normDataSet = normDataSet/tile(ranges, (m,1)) #element wise divide

return normDataSet, ranges, minVals

def datingClassTest():#分类器针对约会网站的测试代码

hoRatio = 0.50 #hold out 10%

datingDataMat,datingLabels = file2matrix('F:\\机器学习\\machinelearninginaction\\Ch02\\datingTestSet2.txt') #load data setfrom file

normMat, ranges, minVals = autoNorm(datingDataMat)

m = normMat.shape[0]

numTestVecs = int(m*hoRatio)

errorCount = 0.0

for i in range(numTestVecs):

classifierResult = classify0(normMat[i,:],normMat[numTestVecs:m,:],datingLabels[numTestVecs:m],3)

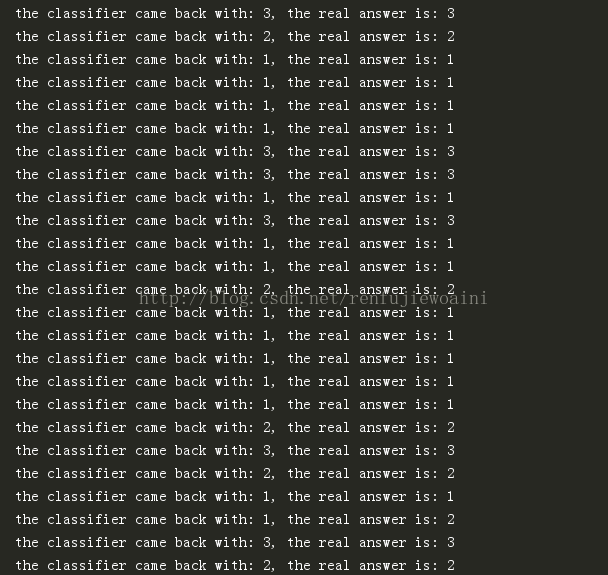

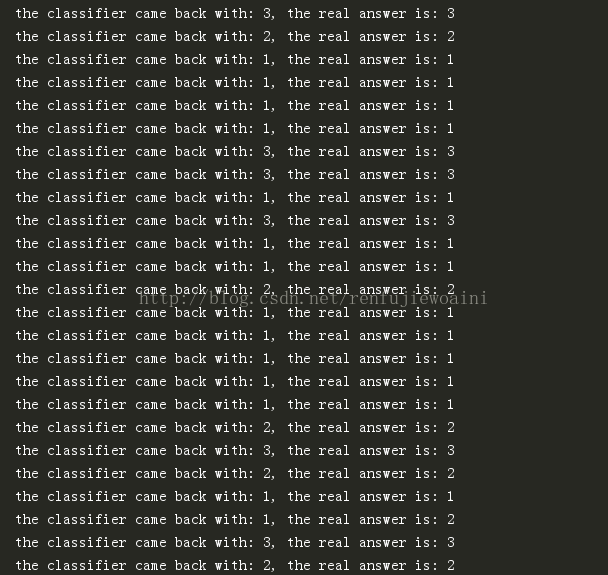

print("the classifier came back with: %d, the real answer is: %d" % (classifierResult, datingLabels[i]))

if (classifierResult != datingLabels[i]): errorCount += 1.0

print("the total error rate is: %f" % (errorCount/float(numTestVecs)))

print(errorCount)

下一篇我们重点讲KD树^^

6万+

6万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?