1.前言

前面介绍的是对于所有训练样本{(xi,yi)}i=1->n同时进行学习的回归、分类算法。一般来说,在训练样本不同时给定的情况下,比起将所有的训练样本集中起来同时进行学习,把训练样本逐个输入到学习算法中,并在新的数据进来的时候马上对现在的学习结果进行更新,这样的逐次学习算法更加有效。本篇博客介绍可以进行逐次学习的在线学习算法,当训练样本总数n非常大的时候,在线学习算法对于有限内存的利用、管理来说非常有效,是大数据时代的一种优秀的机器学习算法。为了便于理解,仅仅讨论简单的关于输入的线性模型:

但是,这里讨论的内容,都可以直接扩展为与参数相关的线性模型:

2.被动攻击学习

2.1 梯度下降量的抑制

回归和分类中对参数的学习都是使与训练样本相关的损失达到最小。在训练样本(x,y)逐个给定的在线学习中,可以使用随机梯度算法进行参数的更新。首先切得与新输入的训练样本(x,y)相关的损失J的梯度▽J。然后朝着梯度下降的方向对参数Θ进行更新。

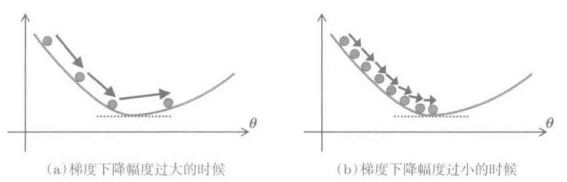

在这里,e为表示梯度下降幅度的正常值。概率梯度下降法中,当梯度下降幅度过大时,学习结果往往会不稳定;而当梯度下降幅度过小时,又会使得收敛速度变慢。 梯度下降法中幅度的设定下降幅度过大,学习结果不稳定;下降幅度过小,收敛速度慢一般来说,如果能合理选择平方损失等损失函数的话,也能一起呵成地使梯度快速下降到谷底(也就是说可以求得下降过程中的最有解析解,即平稳解)。因此,一般会引入一个惩罚系数,即偏离现在的解Θ'的幅度,对梯度下降量进行适当的调整:

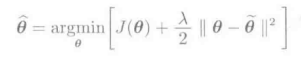

梯度下降法中幅度的设定下降幅度过大,学习结果不稳定;下降幅度过小,收敛速度慢一般来说,如果能合理选择平方损失等损失函数的话,也能一起呵成地使梯度快速下降到谷底(也就是说可以求得下降过程中的最有解析解,即平稳解)。因此,一般会引入一个惩罚系数,即偏离现在的解Θ'的幅度,对梯度下降量进行适当的调整:

其中,λ为正的标量。这样的学习方法对基金的梯度下降可以进行有效地抑制,称为被动攻击学习。2.2 被动攻击分类

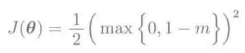

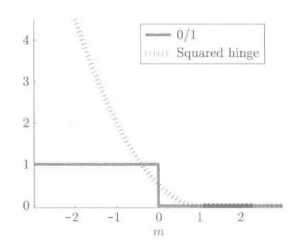

进行分类时的损失函数,一般使用Hinge损失的平方形式,即二乘Hinge损失:

在这里,m=Θ'xy表示的是间隔。二乘Hinge损失,可以用损失右侧等于零是的损失来解释:

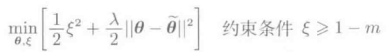

与分类问题相对应的二乘Hinge损失与二乘Hinge损失相对应的被动攻击学习中,可以求得解析解。具体而言,先进行分解,变成一个最优化的问题:

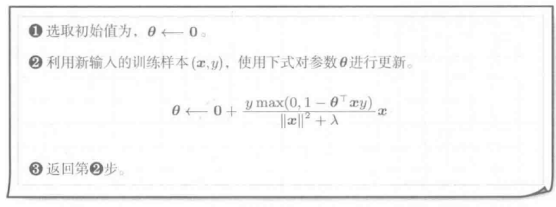

继而利用拉格朗日乘子可以求解。下图给出的是被动攻击分类的具体算法流程:

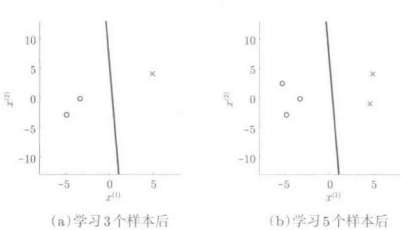

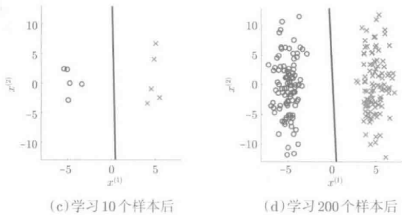

下图给出了被动攻击分类的实例:

被动攻击分类的实例经过三次迭代后,基本上得到了与最终结果类似的分类,正样本和负样本都得到了很好的分离。2.3 被动攻击回归

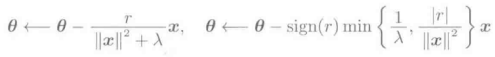

稍微改变一下损失函数的话,被动攻击学习的思想对回归问题也是适用的。在这里,对于残差r=Θ'x-y,使用L2损失或L1损失:

推到过程相同。可以的带如下与L2损失或L1损失相对应的如下参数更新规则。

3.适应正则化学习

被顶攻击学习中使用的是没有上界的损失函数,因此不能很好滴处理异常值。如果采用图基(Tukey)或Ramp损失等有上界的损失函数的话,就可以大幅度提高他对异常值的鲁棒性。然而,具有上界的损失函数是非凸函数,想要进行最优化求解往往很困难。这里重点介绍一种利用在线学习特性的鲁邦学习方法——适应正则化学习。3.1 参数分布的学习

适应正则化学习,并不只是对参数Θ进行学习,而是对参数的概率分布进行学习。具体而言,首先假定参数Θ的概率分布为高斯分布。用下面的概率密度函数决定概率分布:

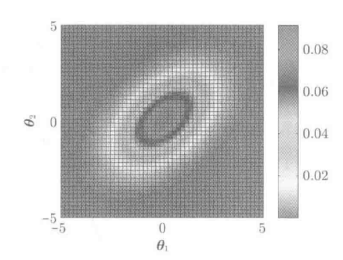

期望为u=(0,0)'/协方差矩阵为(2,1;1,2)的高斯分布适应正则化学习中,对下式的规则为最小时所对应的Θ的期望值u和协方差矩阵∑进行学习:

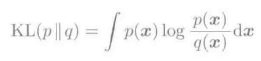

第一项的J(u),表示的是新输入的训练样本(x,y)满足参数Θ=u时的损失。第二项为协方差矩阵对应的正则化项,根据训练输入样本向量x的各种元素大小,对正则化的大小进行调整。第三项的作用于被动攻击学习类似,即调整解的变化量。式中,C>0表示的是正则化参数的倒数,u'和∑'是当前迭代次数下对应的均值与协方差的解。KL(p||q)是概率密度函数p到q的KL距离:

同理,改变参数的更新规则,也可以利用适应正则化进行分类与回归。

901

901

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?