本节来自《pattern recognition and machine learning》第5章。

接(PRML5-神经网络(1))

5.5NN中的正则化

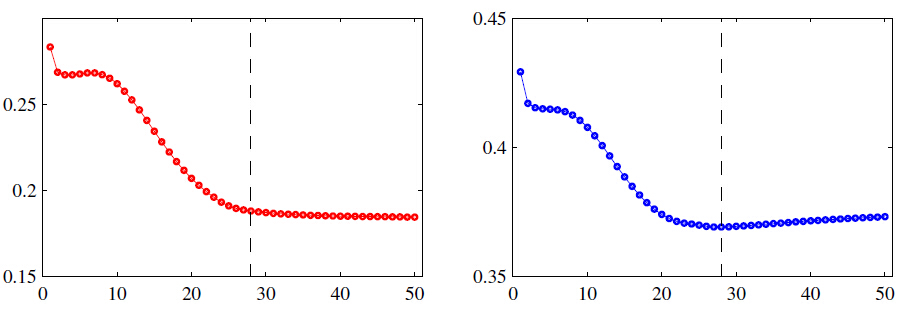

NN的输入层和输出层的单元个数都是按照数据集定义的,只有中间的隐藏层的单元个数

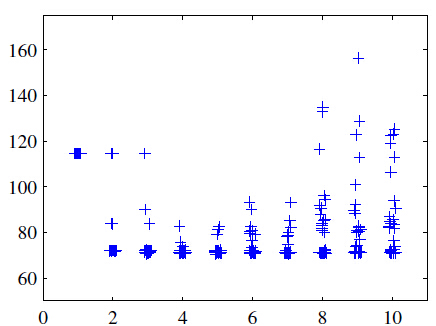

图5.5.1网络中隐藏单元数量不同(x轴)的情况下平方和误差函数在测试集上的误差,在每个网络size上有30个随机初始化。每个初始化权重向量都是通过对一个高斯分布(0均值,10方差)采样得到的。

如上图,通过在选定M的基础上不同的初始化权重导致不同的结果,结果显示M=8的时候验证集上的错误最少(个人:我也看不出来是8的时候最好)。同样的,在实际中,我们也是通过画这种图来选择M的值。而且就拿之前的多项式拟合来说,是先选取一个较大的多项式阶数也就是

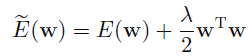

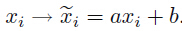

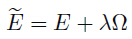

该正则化项叫做权重衰减,这个模型的复杂度可以由前面的系数(超参数)来控制,正如前面介绍的,这一项可以看出是基于权重向量

5.5.1 一致的高斯先验(consistent gaussian priors)

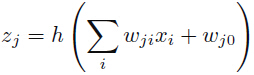

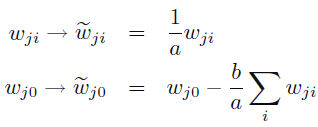

上面这权重衰减的一个局限性在于没法自适应网络映射的缩放属性。假设我们有一个2层权重层和线性输出单元的MLP,第一层隐藏层的激活函数:

输出层单元的激活函数:

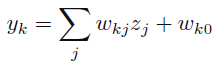

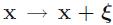

假设我们先对输入数据进行一个线性转换:

我们可以让该网络的映射关系(输入层映射到输出层)不变,只要在输入层到隐藏层的权重和偏置也执行一个对应的线性转换就行(个人:这时候一个处理就相当于将输入的线性转换抵消掉了):

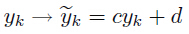

同样的,要想求得该网络的输出对应的如下的一个线性转换关系:

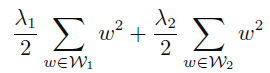

只要接着将第二层的权重和偏置再接着做一个线性转换就行(个人:这个处理是为了让目标变量进行转换,之前输入的转换的影响被第一层权重的改变所抵消掉了):

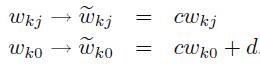

如果我们使用原始的数据训练一个网络和转换后的数据来训练另一个网络,可以发现这原始网络和新网络的对应的权重之间也是有着这么一个转换关系。我们要的也就是正则化器需要在这种情况下保持一致。而正如(5.5.1)式子中的那个权重衰减,明显无法符合这种网络的缩放属性,因为通过这个权重衰减训练的两个网络的权重肯定没有如上面这个转换关系。所以这里需要寻找的正则化方法是能够在如上面的(5.5.1.4)和(5.5.1.6)的线性转换下保持不变性的。也就是需要正则化能够对权重的缩放和偏置的偏移能够保持不变性,如下面这种正则化方法:

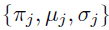

这里

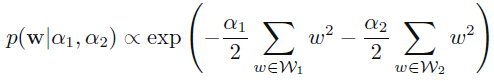

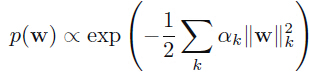

如(5.5.1.7)中的正则化对应的先验形式为:

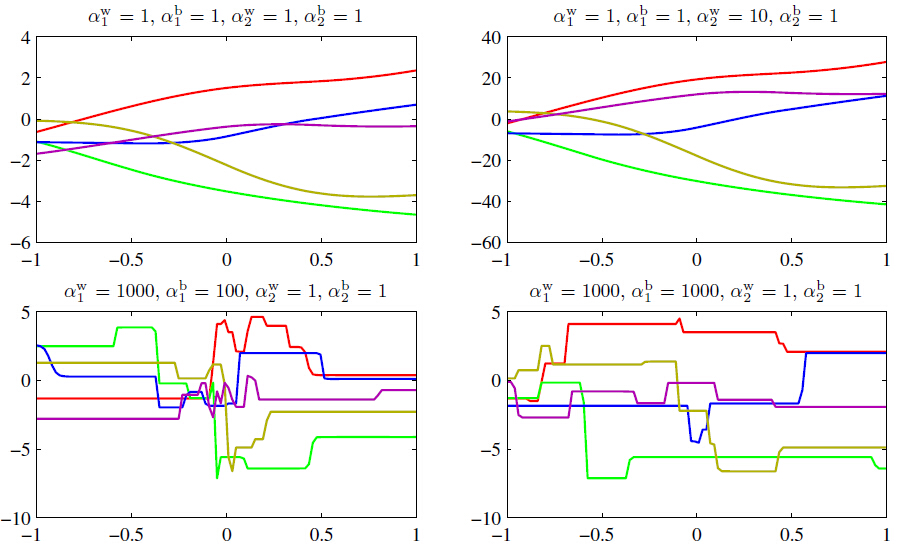

这个形式的先验叫做improper(无法被归一化),因为偏置参数是无约束的。使用improper先验会导致对正则化参数(超参数)的选择和与贝叶斯框架的模型对比变得困难,因为对应的evidence是0(个人:暂时不知道evidence代表什么含义)。所以通常对于偏置来说是选取独立的先验(这会打破平移不变性)并使用自己的超参数。我们可以通过从这些先验中采样然后将对应的网络函数结果画出来,从而观察这四个超参数的影响,如下图:

(上图中的数据1,10,100,1000都是错的,应该都是有着-2的幂,比如

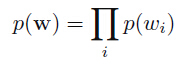

不过,更通用的做法是将先验中的权重分成

这里:

这就是先验的一个特殊情况,如果我们选择的是与一个输入单元相关连的权重集合的分组,然后优化关于对应参数

5.5.2早期停止

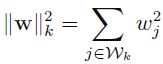

所谓的早期停止,也是另一种正则化方法,就是在训练集和验证集上,一次迭代之后计算它们上面的错误率,当在验证集上错误率最小,而没开始增大的时候就停止,因为再接着训练的话,训练集上误差应该是接着下降的,而验证集上的误差就会上升了,这时候就是要过拟合了,所以及时的停止,从而得到泛化最好的模型。如下图:

图5.5.2.1 训练集和验证集随着训练次数的增加所表现的误差结果:左边训练集,右边验证集

这种行为的解释:对于模型中有效的自由度的数量(这里应该指的是能作为决策的参数,打个比方开始所有的权重都没法决策,随着训练,能决策的参数越来越多,形象的比喻)来说,随着训练的过程是先很小然后不断的增长的,也对应着模型有效复杂度的稳定性增长,在训练误差最小值前停止也就意味着对模型有效复杂度的一个限制。

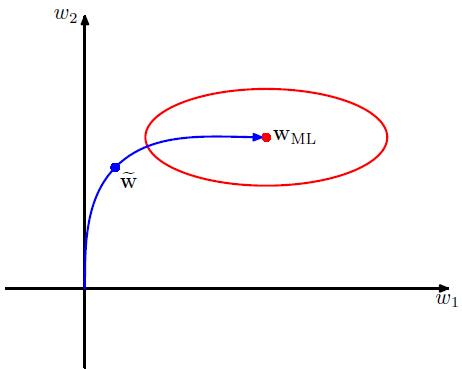

就拿二次误差函数来说,我们可以验证这个观点,而且早期停止其实很像使用最简单的权重衰减项的正则化的行为。如下图:

图5.5.2.2:在点

在上图中权重空间中的轴已经旋转到与hessian矩阵中特征向量平行了。如果没有权重衰减项,权重向量就会先从原点开始,然后随着训练朝着局部负梯度向量的方向前进(sgd方法),也就是最开始会朝着与轴

5.5.3不变性

在模式识别中,当输入变量有着一个或者多个的变换,而输出的预测不变,那么这叫做不变性。比如手写数字识别中,每张图片内数字的位置的改变(平移不变性)和数字的大小不同(缩放不变性)都需要对应到正确的分类结果。或者说在语音识别中,在时间轴(保留了时间顺序)上很小的非线性扭曲(即波形的小程度扭曲),不应该让信号的解释发生改变。

如果有足够多的训练样本,那么就可以训练一个自适应网络例如NN来学习不变性,至少能够逼近。这涉及到训练集必须有足够多不同变换影响的样本。所以,对于图像的平移不变性来说,需要对象在不同位置上足够多的图片用作训练集。然而当训练样本不够多或者只有几种不变性的时候,该方法的实用性不高(因为不同的变换的组合得到的数量也就是你需要的训练集是基于这些变换的种类呈指数型增长的)。所以我们需要找其他方法来让自适应模型自己呈现所需的不变性。这大致可以分为四个方面:

1、训练集可以使用训练样本的副本形式来增强(augmented),并在里面加上合适的不变性的转换。例如在我们的数字识别例子中,可以对每个样本进行多个复制,在每个复制中让数字出现在图像的不同地方;

2、在误差函数上增加一个正则化项来惩罚当输入有不同变换的时候输出的变化情况,这在5.5.4中有种技术叫做切线传播,后续介绍。

3、通过特征提取来预处理,从而在这个阶段建立不变性(比如sift),任何后续的回归或者分类系统使用这样的输入都是体现了不变性的。

4、最后的选择就是将不变性属性放入NN的结构中(或者通过技术,比如定义核函数的方法,如相关向量机)。一种实现的方法就是使用局部感受野和权重共享,正如在5.5.6介绍的CNN。

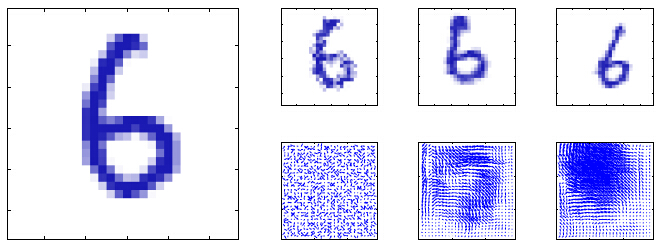

方法1通常来说是相对简单实现的,可以用来构建复杂的不变性,如下图所示:

图5.5.3.1 手写数字的合成扭曲。左边的是原始图片,后面上面的三个是扭曲的数字图片,下面的三个是对应的位移场(displacement fields)。这些位移场都是通过在每个像素上随机位移

对于连续训练算法来说,这可以通过在放入模型之前先对输入样本进行转换(如果样本会被循环用作训练的话)那么每次就增加一个不同的转换形式(从一个合适的分布中提取)。对于批量方法来说,相似的方法就是先多次复制样本,然后每个复制样本上使用不同的转换。这些增强数据(augmented data)的使用可以明显提高泛化能力(simard et al 2003

),虽然会更耗时。

方法2是保持数据集不变,而通过增加额外的正则化来修改误差函数。在5.5.5中,会介绍与该方面相关的方法

方法3的一个优点就是它可以正确的推断远远超出训练集上变换范围之外的变换。然而,同时也很难在不丢弃信息的情况下找到有助于判别的那些手动设计的不变性特征(个人:因为这是更通用的适用不变性,相对来说手动设计的特征是专为判别而设定的,所以靠模型自己来的话,势必会需要更多的信息,因为模型可分不清哪些是易于被鉴别的特征,哪些不是)

5.5.4 tangent传播(切线传播)

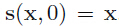

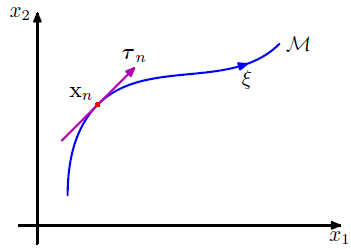

我们可以使用正则化来让模型对转换的输入数据具有不变性,该技术叫做切线传播(simard et al 1992)。这里主要举例在一个具体的输入向量

图5.5.4.1 在一个2维的输入控件中在一个具体的输入向量

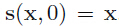

图中是简化的将D=2时候的例子。假设转换由一个参数

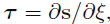

在对输入向量进行转换之后,网络的输出向量通常来说也会变的。输出单元 k 关于

这里

这里

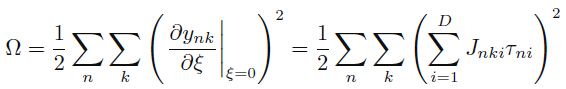

该正则化函数当网络映射函数在对每个输入向量转换后还能保持不变的情况下结果为0,参数

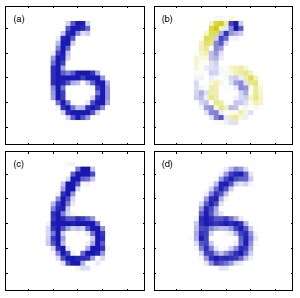

图5.5.4.2 (a)元素图片;(b)一个对应的无穷小顺时针旋转对应的切线向量

该正则化函数是依赖于jacobian矩阵上的网络权重的。可以通过5.3部分介绍的使用BP方法来计算正则化项关于网络权重的导数。如果转换是受到

一个相关的技术,叫做切线距离(tangent distance)可以用来将不变性特性放入基于距离的方法中,例如最近邻分类器(simard et al 1993)。

5.5.5使用转换后的数据训练

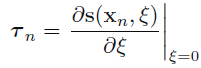

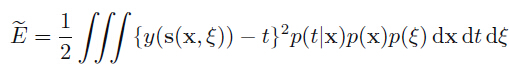

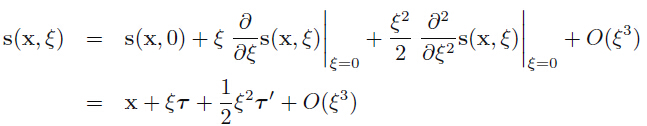

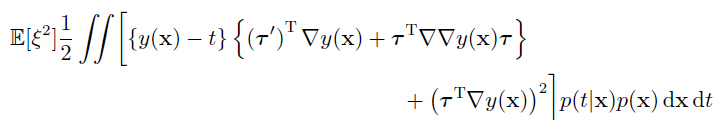

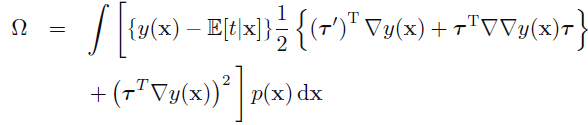

通过使用变换的数据来训练的方法与切线传播这种技术密切相关(bishop1995b;leen 1995)。正如5.5.4介绍的,假设变换是通过一个参数

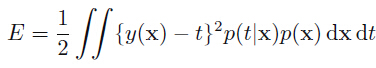

正如1.5.5介绍的那样。并且为了介绍方便,这里使用的输出为单一神经元。如果我们对每个样本都进行无限次的复制,每个复制上使用从分布

现在,假设分布

这里

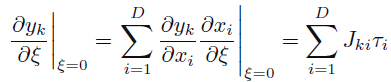

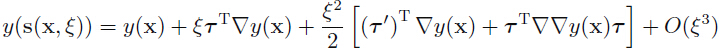

将上面式子带入到(5.5.5.2),然后展开:

(作者:上面的式子第三项改成

因为变换的分布式为0均值,所以

这里

(作者:上面改成

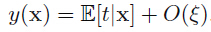

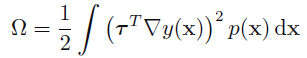

这是基于

为了 阶数

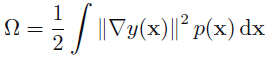

这等效于切线传播正则化(5.5.4.4)。如果我们考虑这么一个特殊情况,输入的变换简单的只加上随机噪音,即

这被称之为Tikhonov 正则化(tikhonov and arsenin 1977;bishop 1995b)。该正则化关于网络权重的导数可以通过使用扩展的BP算法求出(bishop 1993)。对于很小的噪音振幅,Tikhonov正则化是对输入加上随机噪音,这被证明是有助于在合适的环境下改善泛化性能(sietsma and dow 1991)。

5.5.6卷积网络

(该小节长话短说,估计现在这么火,没几个不知道的)另一个让模型具有不变性的方法就是直接将对输入变换的不变性构建到网络中,这也是CNN的基础。对于2维的图片来说,其不变性主要还是平移不变性、缩放不变性、和很小的旋转不变性。更多的,网络还需要有更多微妙的不变性,例如弹性形变(elastic deformations),如图5.5.3.1所示。一个方法就是建立一个完整的全连接MLP,不过这可需要足够大的训练数据集,这样得到的最好结果才能好。不过这种简单粗糙的方法却忽略了一个问题,图像的像素值是与周围的像素点的值密切相关的。所以现有的计算机视觉模型都是通过提取局部特征,依赖于图像的子区域提取的特征。然后将局部提取的特征融合到后期的处理中来检测更高阶的特征,最后产生的特征来表示整张图片。而且在图像一个区域上提取的特征对于其他区域来说也是很有用的,比如图像平移之后。

CNN当然就是三大特性:局部感受野、权值共享、子采样了。对于卷积层每个特征图来说,所需要学习的参数就是一个卷积核外带一个偏置,如果将卷积层每个特征图中的卷积核当做是一个特征提取器,那么一个特征图就相当于对整张图提取相同的特征,即在图片的不同位置提取相同的特,这样如果输入图片平移了,那么特征图上的的激活值也会对应的平移,不过却不会变。这就是网络输出针对输入图片的平移和扭曲不变性的基础(一定程度,所以文中用的是逼近)。对于子采样(不是池化),是将现在流行的池化比如meanpool上计算局部区域的平均值,然后乘以一个权重再加上一个偏置,然后送入sigmoidal激活函数(这里不重叠),所以子采样层中单元的响应对于图像的微小平移具有相对的不敏感特性。在实际中,是多层卷积层和子采样层对的,随着层数的增加,对于输入的变换有着更高程度的不变性。而且空间分辨率的逐渐减少可以通过增加的特征数量来补偿。最终层通常还会与一个全连接层相连,之后再加上一个softmax层用来多分类。

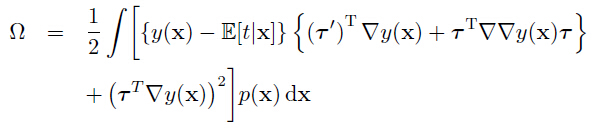

5.5.7软权重共享(soft weight sharing)

上面是通过将某些权重分成不同的组,组内的权重值都相等。然而这只适用于特定的问题上,也就是约束形式已经提前固定了。这里介绍一种软权重共享的方式(nowlan and hinton 1992),将以往的等值权重的硬约束替换成一个正则化的形式,其中不同组的权重倾向于有着相似的值。也就是先将权重划分成不同的组,每组的平均权重值和值的组内扩散都是通过学习过程决定的。

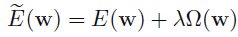

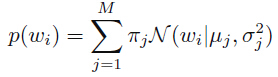

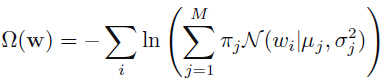

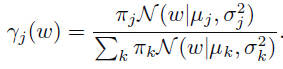

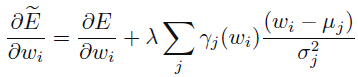

回顾之前那个简单的权重衰减正则项(就是

这里:

其中

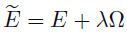

总的误差函数为:

这里

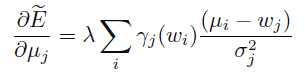

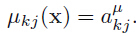

为了最小化总的误差函数,需要计算关于各个不同的参数的导数。为了方便,我们可以将

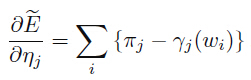

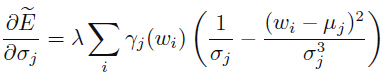

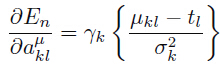

总的误差函数关于权重的导数为:

正则化项的影响就是将每个权重拉向第 j 个高斯的中心,与在给定权重上高速的后验概率成一定比例。这就是我们想要找的那种effect。误差函数关于高斯中心的导数为:

一个简单的直观解释就是,它是将

这会驱使

最小值是在关于

对于关于混合系数

这是基于

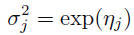

正则化后的误差函数关于

我们可以看到

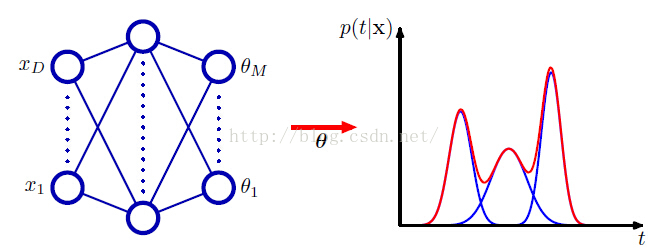

5.6混合密度网络

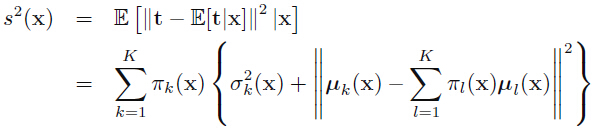

有监督学习的目标是对条件分布

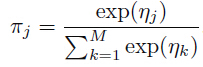

图5.6.1 左边的那个是一个2连机器人手臂,其中手臂末端的笛卡尔坐标

上面机器人手臂任务中的前向问题涉及到需要在给定联合角度基础上找到手臂末端的位置并得到唯一解。然而,在实际中,我们还是希望将手臂末端移动到其他的位置,而这就需要有合适的联合角度,所以我们需要解决后面的逆问题。前向问题在物理学中通常是有因果关系的,所以通常会有个唯一解。例如人生病时相同的症状可能包含着多种病因。而在模式识别中通常需要去解决一个逆问题,在这种多对一映射的前向问题上,那么逆问题就会有多个不同的解。

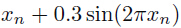

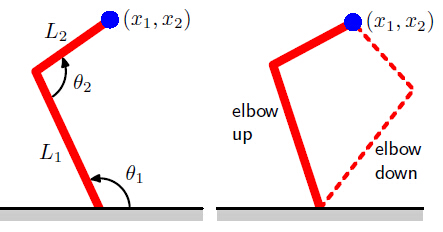

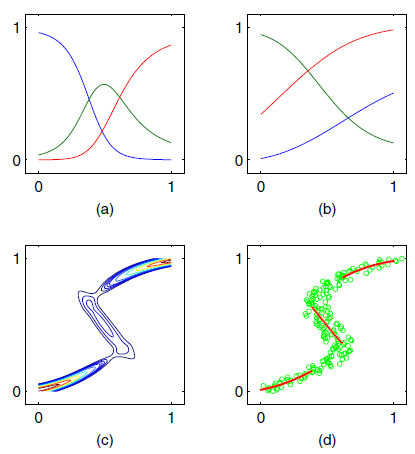

在上面的机器人手臂中,运动学是基于集合等式定义的,很明显会有多个模态存在。然而在ML问题中,多模态的存在特别是涉及到高维空间的问题上,却不那么被容易观察到。所以通常是先考虑一个能够容易可视化多模态的简单问题,然后在逐步深入。假设某个任务的数据变量

图5.6.2 左边的是一个简单的“前向问题”的数据集,其中红曲线表示用一个2层NN通过最小化平方和函数得到的拟合结果;右边是对应的逆问题,是通过交换x 和 t 的角色,然后使用相同的网络结构,在最小化平方和误差函数后得到的对数据的拟合,因为数据集中多模态的存在,所以拟合效果很差。

上图就是针对前向问题和逆问题的数据集,结果是通过一个6个隐藏单元和一个线性输出单元的网络,通过最小化平方误差和函数来进行拟合的结果。最小平方对应着假设是高斯分布下的最大似然函数。我们可以发现对于高度非高斯逆问题来说,得到的结果非常差。

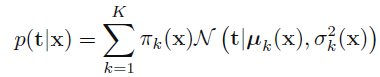

所以需要一个更通用的框架来对条件概率分布进行建模。这可以通过对条件分布

这里先显式的提出关于高斯成分的模型(假设混合模型中都是高斯成分):

这是一个叫做异方差(heteroscedastic)模型的例子,因为数据上的噪音方差是关于输入向量

现在来介绍如何计算混合模型的各个参数:混合系数

图5.6.3 混合密度网络可以表示成同样的条件概率密度

混合密度网络和后面14.5.3部分介绍的专家混合系统关联密切,不过其中主要的不同在于混合密度网络是使用相同的函数去预测所有成分密度的参数和混合系数,而且非线性隐藏单元在输入依赖函数之间是共享的。

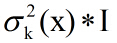

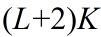

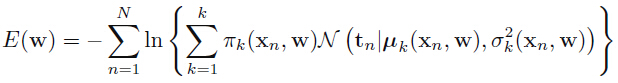

上图5.6.3中是一个2层网络,其中的隐藏单元是sigmoid(tanh)函数,如果在式子(5.6.1)这种混合模型中有

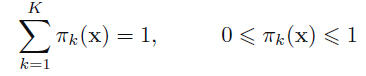

混合系数必须满足下面的条件:

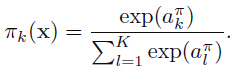

这可以通过softmax输出计算得到:

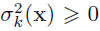

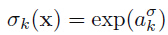

同样的,方差必须满足

最后,因为均值

其中该网络的权重和偏置构成的向量

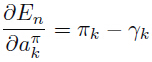

为了最小化误差函数,需要计算

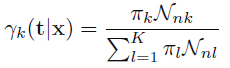

这里

同样的,关于网络输出的导数还决定着成分的均值:

最后,关于网络输出激活值的导数还决定着成分的方差:

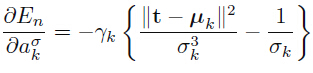

接下来通过介绍一个toy的逆问题的例子来说明混合密度网络的用法,如下图:

图5.6.4 :(a)在图5.6.2呈现的数据上训练一个混合密度网络(其中有三个核函数),混合系数为关于 x 的函数

上图呈现了混合系数

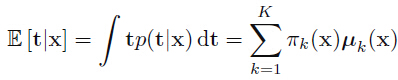

一旦混合密度网络训练好了,它就能够预测在给定输入向量的情况下目标变量的条件密度函数。该条件密度是对目标变量生成的完整描述。从这个密度函数中,我们可以计算不同应用中不同的感兴趣数值,最简单的就是对应着目标变量条件平均的均值(期望):

这里用到了式子(5.6.1)。因为通过最小平方训练的标准NN可以逼近条件均值,所以可以发现混合密度网络可以将传统的最小平方当成其一个特殊情况。当然,正如前面说的,对于一个多模态分布来说,条件均值的值也是有限制的。

关于条件平均的密度函数的方差:

这里用到了式子(5.6.1)和上面那个式子。这比对应的最小平方更通用是因为其方差是关于X的函数。

总结:对于多模态分布,条件均值对数据的表示是很差的。例如在简单机器人手臂控制中,需要挑两个可能的联合角度中的一个来得到合适的手臂末端位置,然而这两个解的平均并不是一个解(个人:即这里不满足闭包)。在这种情况下,条件模型可能有更多的值,因为混合密度网络的条件模型没有个单一的解析解,所以需要数值迭代。一个简单的方法就是采用那个最可能成分的均值(即混合系数最大的那个成分)。如图5.6.4的(d)。

5.7 贝叶斯NN

到目前为止关于NN的讨论都是通过最大似然来决定网络的参数(权重和偏置)。正则化的最大似然可以看成是一个MAP(最大后验),其中正则化可以被认为是先验参数分布的log函数。不过在贝叶斯解决方法中,还需要基于这些参数分布进行边缘化才能进行预测。在3.3节中,针对简单的线性回归模型(假设是高斯噪音),提出了一个贝叶斯解决方法,其中可以看到后验分布(高斯)可以准确的被计算,而且可以在封闭形式(closed form)中找到可预测的分布。而在多层网络中,网络参数的的高度非线性依赖意味着不能找到准确的贝叶斯解决方法了,因为后验分布的log函数已经是非凸函数了,也就是在误差函数中会有多个极小值存在。

在第十章介绍的可变推论可以用在贝叶斯NN上,通过对后验分布使用一个因子化的高斯逼近和一个全方差(fullcovariance)高斯。接下来将会用一个高斯来逼近后验分布,以真正的后验作为模型的中心。然后假设高斯的方差很小以至于网络函数对于参数空间上的参数来说逼近于线性,并且后验概率显然是非零的。有了这两个逼近方法,可以将之前介绍的线性回归和分类结果用到这里。并使用点估计来获得超参数,并比较几种可替代的模型。

5.7.1 后验参数分布

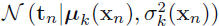

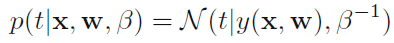

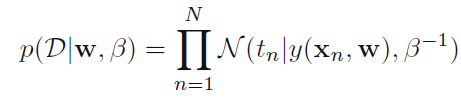

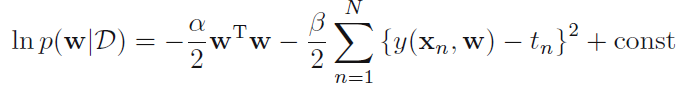

假设我们需要预测一个单一连续目标变量t ,输入为向量 x 。我们这里先假设条件分布

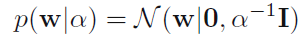

同样的,选择基于权重W 的先验分布为高斯:

假设数据是i.i.d的,样本为

得到的后验分布为:

作为在W 上的非线性依赖函数

这对应着一个正则化后的平方误差和函数。假设此时

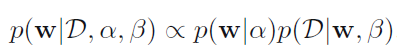

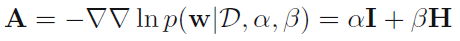

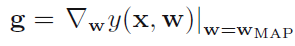

假设已经找到了模型的

这里H 是hessian矩阵,平方和函数关于W的二阶导数矩阵。对应的后验高斯逼近可以从(4.134)中得到:

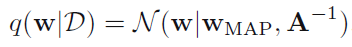

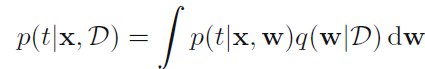

通过对后验分布进行边缘操作得到预测变量的分布:

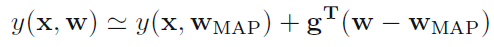

然而,就算是对后验进行高斯逼近,该积分还是难于分析的,因为网络函数

这里假定:

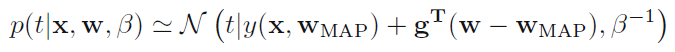

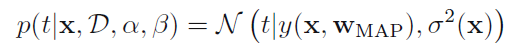

这样就得到了一个

然后通过使用(2.115)的通用结果的边缘分布

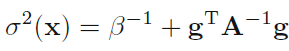

其中依赖输入的方差为:

从上面的式子可以看出预测分布

5.7.2 超参数优化

5.7.3 用于分类的贝叶斯NN

2015/07/27,第0次修改!

1868

1868

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?