Celery

Celery (芹菜)是基于Python开发的分布式任务队列。它支持使用任务队列的方式在分布的机器/进程/线程上执行任务调度。

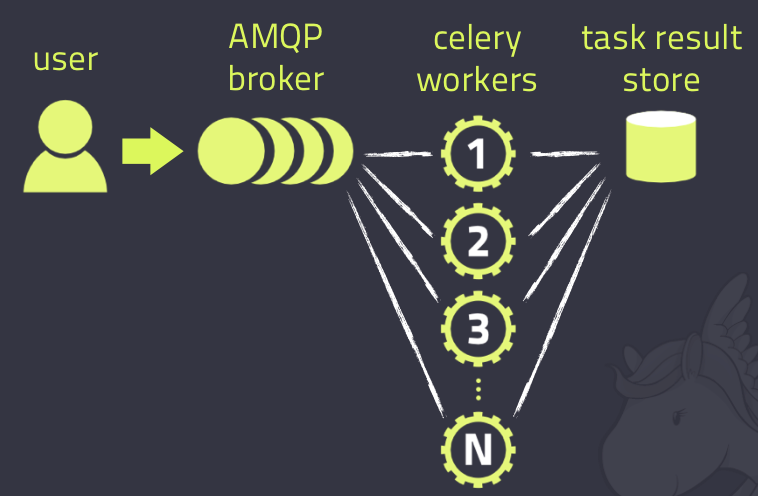

Celery架构

Celery的架构由三部分组成,消息中间件(message broker),任务执行单元(worker)和任务执行结果存储(task result store)组成。

消息中间件

Celery本身不提供消息服务,但是可以方便的和第三方提供的消息中间件集成。包括,RabbitMQ, Redis, MongoDB (experimental), Amazon SQS (experimental),CouchDB (experimental), SQLAlchemy (experimental),Django ORM (experimental), IronMQ

任务执行单元

Worker是Celery提供的任务执行的单元,worker并发的运行在分布式的系统节点中。

任务结果存储

Task result store用来存储Worker执行的任务的结果,Celery支持以不同方式存储任务的结果,包括AMQP, Redis,memcached, MongoDB,SQLAlchemy, Django ORM,Apache Cassandra, IronCache

另外, Celery还支持不同的并发和序列化的手段。

并发

Prefork, Eventlet, gevent, threads/single threaded

序列化

pickle, json, yaml, msgpack. zlib, bzip2 compression, Cryptographic message signing 等等

python安装celery

使用的是django-celery包:

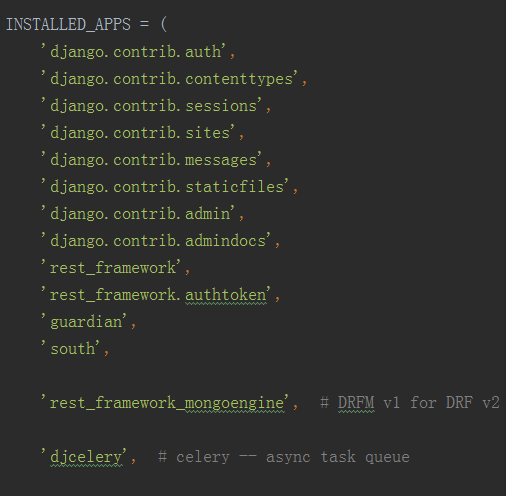

pip install django-djcelery配置djcelery

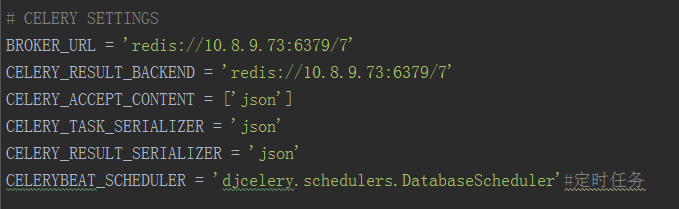

下面是djcelery的有关配置,定义在Django项目的settings模块内。

首先INSTALLED_APPS之中需要写入djcelery。

之后配置celery

说明:直接使用django做broker生产环境不建议,建议使用redis或者rabbitMQ

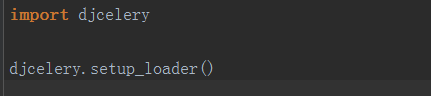

需要在settings.py之中载入celery的配置。

配置好了celery之后需要创建Celery所需要的数据表(django1.7)

python manage.py migrateCelery使用

创建一个task

一个task就是一个Pyhton function。 但Celery需要知道这一function是task, 因此我们可以使用celery自带的装饰器decorator: @task. 在django app目录中创建taske.py:

from celery import task

@task()

def add(x, y):

return x + y当settings.py中的djcelery.setup_loader()运行时, Celery便会查看所有INSTALLED_APPS中app目录中的tasks.py文件, 找到标记为task的function, 并将它们注册为celery task.

将function标注为task并不会妨碍他们的正常执行. 你还是可以像平时那样调用它:

z = add(1, 2).执行task

celery之中你可以用 delay() 方法来调用任务。

让我们以一个简单的例子作为开始. 例如我们希望在用户发出request后异步执行该task, 马上返回response, 从而不阻塞该request, 使用户有一个流畅的访问过程. 那么, 我们可以使用.delay, 例如在在views.py的一个view中:

from myapp.tasks import add

...

add.delay(2, 2)

...Celery会将task加入到queue中, 并马上返回. 而在一旁待命的worker看到该task后, 便会按照设定执行它, 并将他从queue中移除. 而worker则会执行以下代码:

import myapp.tasks.add

myapp.tasks.add(2, 2)启动worker

正如之前说到的, 我们需要worker来执行task. 以下是在开发环境中的如何启动worker:

首先启动terminal, 如同开发django项目一样, 激活virtualenv, 切换到django项目目录. 然后启动django自带web服务器: python manage.py runserver.

然后启动worker:

python manage.py celery worker –loglevel=info

此时, worker将会在该terminal中运行, 并显示输出结果.

启动task

打开新的terminal, 激活virtualenv, 并切换到django项目目录:

$ python manage.py shell >>> from myapp.tasks import add >>> add.delay(2, 2)

此时, 你可以在worker窗口中看到worker执行该task:

[2014-10-07 08:47:08,076: INFO/MainProcess] Got task from broker: myapp.tasks.add[e080e047-b2a2-43a7-af74-d7d9d98b02fc]

[2014-10-07 08:47:08,299: INFO/MainProcess] Task myapp.tasks.add[e080e047-b2a2-43a7-af74-d7d9d98b02fc] succeeded in 0.183349132538s: 4

403

403

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?