本文是kuaihua zhang研究团队发表在2016TIP上的一篇文章,提出了一种不需要pre-training的卷积神经网络模型跟踪框架(CNT),与传统的基于深度学习的方法相比,本算法不需要大量的数据预训练模型,其次是该神经网络只有两层卷积,结构较为简单,效率高达到5fps(vs DLT 1.5s/f)。通过两层的神经网络在线学习目标鲁棒表达。

框架流程如下:

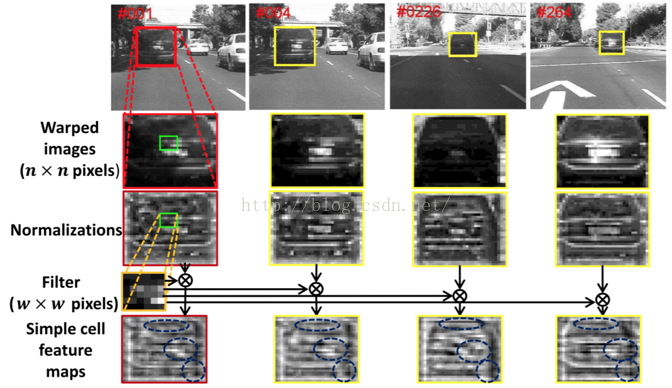

step1:第一帧图像标定groundtruth,目标warp到经典的32*32,经过预处理(去均值,L2规则化)以去除局部亮度差异和对比度的影响。

step2:在第一帧的目标上用sliding window的方法采样patch(6*6),然后通过k-means的方法聚类生成d(100)个patch(作为filter提取patch的特征)。然后在目标的周围采样m个样本,每个样本聚类生成d个filters。用这些filters提取high-level feature maps((32-6+1)*(32-6+1)*100)。然后通过稀疏编码的方式稀疏化该特征,

step3:通过前一阵的目标template加其稀疏表达更新模板

一,目标特征表达

其流程如下

1,目标特征卷积核

a,对groundtruth做滑动窗口采样,然后用k-means聚类的方法从L =(32-6+1)*(32-6+1)个patch中聚类出d = 100个filters作为卷积核

b,对目标周围的区域随机采样出m个样本,对每一个样本用滑动窗的方法采样L个patchs,其filters的生成方式不同于a,如下:

采用了均值池化得方式。

2,生成目标特征

a, 简单包特征

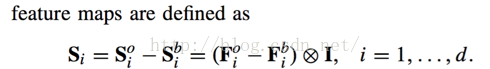

该特征是(目标卷积核-背景卷积核)卷积图像I得到,作为见到包特征。

b,复杂胞特征

把a中生成的特征构造为一个3D张量 C =(32-6+1)*(32-6+1)*100,即为特征图的组合。这种特种具有平移敏感的特征,另外文中把region warp为32*32,使得特征对目标的尺度具有鲁棒性。

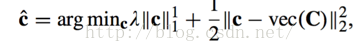

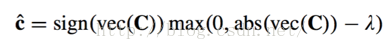

文中为了增加对目标表观特征的鲁棒性采用了稀疏表达的方式表示特征C,通过求解

得到对特征张量的C的稀疏表达c^,该优化是凸优化,采用了soft-shrinking解得唯一解

至此目标的特征表达完成

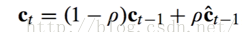

二,模板更新

更新策略如下,是一种低通滤波的形式,其中c(t-1)是上一帧学习到的特征,c^(t-1)是c(t-1)的稀疏表达。

为了提高算法的执行效率用FFT的方式计算,而且使用了并行。

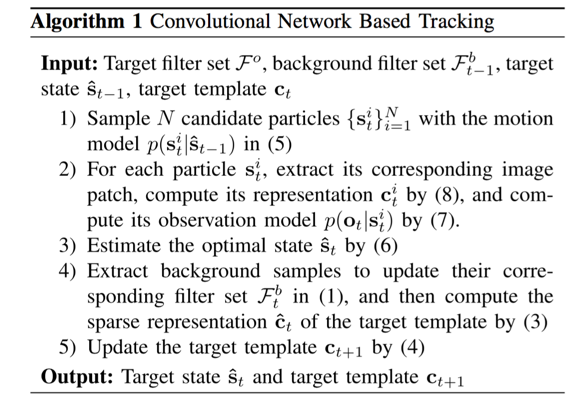

三,跟踪算法

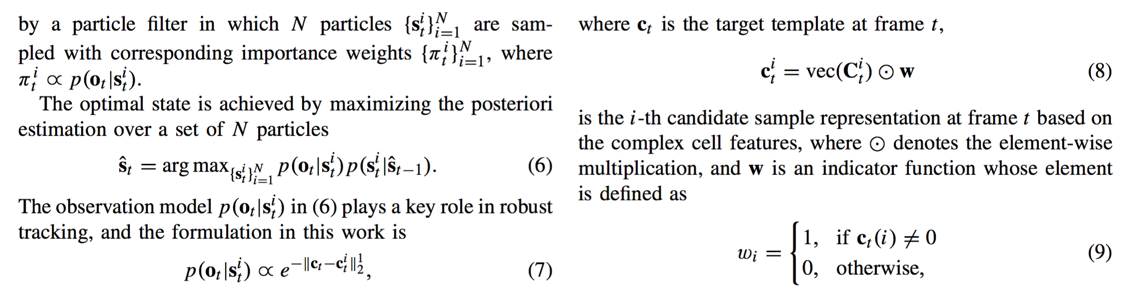

是在粒子滤波的框架下

流程图:

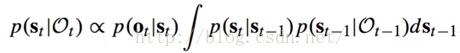

前t帧得到观察集Ot = {o1, o2,......ot},据此计算目标状态(位置和尺度)的后验概率P(st|ot),如下:

通过在目标周围撒离子,然后计算粒子的权重,根据此权重*状态转移矩阵的最大值选定粒子即目标位置。原文表示如下

小结:

文中采用的卷积核是通过聚类产生,不知是否有点鲁莽。但是从跟踪效果上看,算法确实简单有效,再此仰慕一下大神。

7372

7372

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?