做完前面的线性回归练习后,这里继续练习逻辑斯谛回归模型http://openclassroom.stanford.edu/MainFolder/DocumentPage.php?course=MachineLearning&doc=exercises/ex4/ex4.html。

给出的数据是40个被大学接收的学生和40个被拒绝的学生的数据,输入是一个二维向量,表示2门科目成绩,输出是一个分类结果(接收、拒绝),用0和1表示。

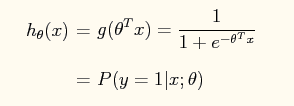

首先,我们要知道logistic regression的假设函数为:

这个假设函数是估计在参数为theta下,输入x被预测为1的概率。这个函数是sigmoid函数,是神经网络中的常用的一种激活函数。

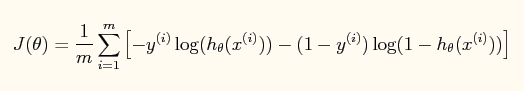

模型的损失函数是:

这

本文介绍了逻辑斯谛回归模型在学生录取问题上的应用,探讨了sigmoid函数作为假设函数的原因,并详细阐述了损失函数及其与最大似然估计的关系。文章还对比了梯度下降法与牛顿法在求解模型参数上的差异,指出牛顿法虽然计算成本高但收敛速度快。最后,展示了牛顿法的更新规则并讨论了其优缺点。

本文介绍了逻辑斯谛回归模型在学生录取问题上的应用,探讨了sigmoid函数作为假设函数的原因,并详细阐述了损失函数及其与最大似然估计的关系。文章还对比了梯度下降法与牛顿法在求解模型参数上的差异,指出牛顿法虽然计算成本高但收敛速度快。最后,展示了牛顿法的更新规则并讨论了其优缺点。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?