一、PCA

PCA即主成分分析(Principle Components Analysis),是统计机器学习、数据挖掘中对数据进行预处理的常用的一种方法。PCA的作用有2个,一个是数据降维,一个是数据的可视化。在实际应用数据中,样本的维数可能很大,远远大于样本数目,这样模型的复杂度会很大,学习到的模型会过拟合,而且训练速度也会比较慢,内存消耗比较大,但实际数据可能有些维度是线性相关的,可能也含有噪声,这样降维处理就很有必要了,不过PCA对防止过拟合的效果也不明显,一般是根据正则化来防止过拟合。PCA是一种线性降维方法,它通过找出样本空间变化较大的一些正交的坐标方向,可认为就是样本的主成分,然后将样本投影到这些坐标从而降维到一个线性子空间。PCA找出了数据的主成分,丢掉了数据次要的成分,这些次要的成分可能是冗余或者噪声信息。PCA是一种特征选择的方法,假设数据维度为n,我们可以选取前k个方差最大的投影方向,然后把这些数据投影到这个子空间得到k维的数据,得到原数据的“压缩”表示,如果还是全部n个投影方向,我们实际只是选择了与原数据空间坐标轴方向不同的另一组坐标轴方向来表示数据而已。

PCA的两种解释分别是最大方差和最小平方误差。最大方差就是找出数据方差最大的方向,最小平方误差就是找出投影方向,使得数据投影后还是尽量地逼近原数据,跟线性回归有点类似,但实质是不一样的,线性回归是有监督的,用x值来预测y值,目的是投影后与y值误差最小,误差是样本点到直线的坐标轴距离,而PCA是无监督的,目的是要使样本与降维后的样本误差最小,误差是样本点与降维后样本点的直线距离。

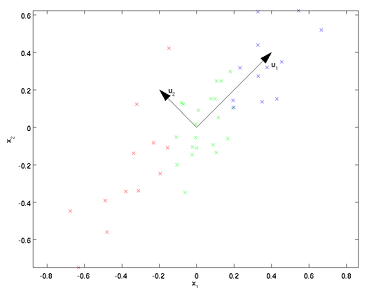

例如上图所示,u1为数据中方差最大的方向,u2为次大的方向。哪该如何找出这些投影方向呢?

首先要对数据进行零均值处理,然后求出协方差矩阵及其特征向量,特征向量就是这些投影方向。零均值处理即消减归一化、移除直流分量,要求出样本的均值,然后对每个样本点减去均值,这样,样本的每个维度的均值都为零了。协方差矩阵是一个正方矩阵,(i,j)元素表示维度i与维度j的协方差。我们的目的是要使协方差矩阵非对角上元素值为0,这样任两个不同的维度就没有相关关系了,但通过计算出来的协方差矩阵不是这样的,所以我们要找出投影方向,原数据投影后再计算的协方差矩阵的非对角元素值都为0。

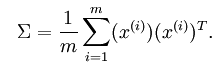

协方差矩阵的计算公式为:

对协方差矩阵求特征分解求出特征向量也可以用奇异值分解(SVD)来求解,SVD求解出的U即为协方差矩阵的特征向量。U是变换矩阵或投影矩阵,即为上面说的坐标方向,U的每一列就是一个投影方向,则U'x即为x在U下的投影,如果U'取前k行(k<n),x就压缩到k维了。

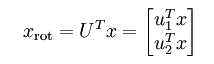

特别地,对于2维空间,投影后的坐标计算如下:

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

743

743

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?