转自:http://www.aichengxu.com/view/2464035

本节代码地址

https://github.com/vic-w/torch-practice/tree/master/rnn-timer

现在终于到了激动人心的时刻了。我最初选用Torch的目的就是为了学习RNN。RNN全称Recurrent Neural Network(卷积神经网络),是通过在网络中增加回路而使其具有记忆功能。对自然语言处理,图像识别等方面都有深远影响。

这次我们要用RNN实现一个神经网络计时器,给定一个时间长度,它会等待直到时间结束,然后切换自己的状态。

如果用C语言实现一个计时器是一件非常简单的事。我们大概要这样写:

void timer(int delay_time)

{

for(int i=0; i<delay_time; i++)

{

delay(1);

}

return;

}但是用神经网络如何来实现呢?我们可以把RNN网络想想成一个黑盒,它有一个输入信号和一个输出信号。我想让输入和输出符合这样的关系:

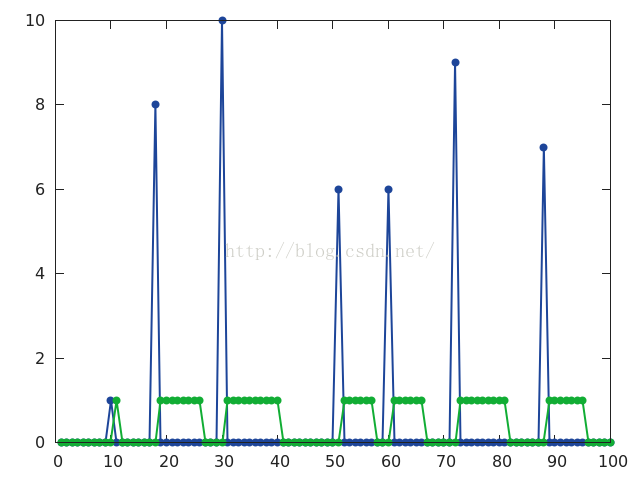

蓝色是输入,绿色是输出。当输入信号产生一个脉冲时,计时器开始工作,计时的长度由脉冲的高度决定。计时器工作时,输出为1,停止工作时,输出为0。

要实现这个功能,模块内部必须有储存单元可以记录自身的状态。最起码需要一个相当于临时变量的机制来记录已经经过的时间长度。这正是RNN需要完成的使命。

我们如果要训练RNN神经网络,首先要有足够多的数据。好在我们的数据是可以无限生成的。我使用 data_gen.lua来生成大量的数据,每段数据的长度为100,储存在同一目录下data.t7文件中。

data_gen.lua需要单独执行

th data_gen.lua有了大量的数据,现在该设计我们的递归神经网络了。

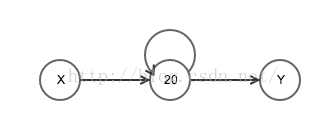

这次的网络也很简单,左边有一个输入节点,中间是拥有20个节点的隐藏层,右边是一个输出节点。和多层感知器不同的是,RNN中间隐藏层里面的20个节点,每个都会连接至本层的所有节点(包括其本身)。所以这些反馈回自身的连接的个数总共有20*20=400条。

为了要在Torch里实现这样一个网络,我们需要用到rnn的库。如果之前没有安装过的话,可以在命令行里输入:

luarocks install rnn在程序中,首先仍然是包含必要的库文件。

require 'rnn'

require 'gnuplot'接下来定义一些常量

batchSize = 8 --mini batch的大小

rho = 100 --rnn在训练时所需考虑的时间最大长度,这也是Back propagation through time所要经历的次数

hiddenSize = 20 --中间隐藏层的节点个数接下来定义隐藏层的结构:

r = nn.Recurrent(

hiddenSize, nn.Linear(1, hiddenSize),

nn.Linear(hiddenSize, hiddenSize), nn.Sigmoid(),

rho

)隐藏层r的类型是nn.Recurrent。后面跟的参数依次分别是:

1. 本层中包含的节点个数,为hiddenSize

2. 前一层(也就是输入层)到本层的连接。这里是一个输入为1,输出为hiddenSize的线性连接。

3. 本层节点到自身的反馈连接。这里是一个输入为hiddenSize,输出也是hiddenSize的线性连接。

4. 本层输入和反馈连接所用的激活函数。这里用的是Sigmoid。

5. Back propagation through time所进行的最大的次数。这里是rho = 100

接下来定义整个网络的结构:

rnn = nn.Sequential()

rnn:add(nn.Sequencer(r))

rnn:add(nn.Sequencer(nn.Linear(hiddenSize, 1)))

rnn:add(nn.Sequencer(nn.Sigmoid()))首先定义一个容器,然后添加刚才定义好的隐藏层r。随后添加隐藏层到输出层的连接,在这里用的是输入为20,输出为1的线性连接。最后接上一层Sigmoid函数。

这里在定义网络的时候,每个具体的模块都是用nn.Sequencer的括号给括起来的。nn.Sequencer是一个修饰模块。所有经过nn.Sequencer包装过的模块都变得可以接受序列的输入。

举个例子来说,假设有一个模块本来能够接受一个2维的Tensor作为输入,并输出另一个2维的Tensor。如果我们想把一系列的2维Tensor依次输入给这个模块,需要写一个for循环来实现。有了nn.Sequencer的修饰就不用这么麻烦了。只需要把这一系列的2维Tensor统一放到一个大的table里,然后一次性的丢给nn.Sequencer就行了。nn.Sequencer会把table中的Tensor依次放入网络,并将网络输出的Tensor也依次放入一个大的table中返回给你。

定义好了网络,接下来是定义评判标准:

criterion = nn.SequencerCriterion(nn.MSECriterion())接下来的事情又是例行公事了。向前传播,向后传播,更新参数......

batchLoader = require 'MinibatchLoader'

loader = batchLoader.create(batchSize)

lr = 0.01

i = 1

for n=1,6000 do

-- prepare inputs and targets

local inputs, targets = loader:next_batch()

local outputs = rnn:forward(inputs)

local err = criterion:forward(outputs, targets)

print(i, err/rho)

i = i + 1

local gradOutputs = criterion:backward(outputs, targets)

rnn:backward(inputs, gradOutputs)

rnn:updateParameters(lr)

rnn:zeroGradParameters()

end需要重点说明的是输入和输出数据的格式。我使用了MinibatchLoader(同目录下的MinibatchLoader.lua文件)来从data.t7中读取数据,每次读取8个序列,每个序列的时间长度是100。那么代码中inputs的类型是table,这个table中有100个元素,每个元素是一个2维8列1行的Tensor。在训练的时候,mini batch中8个序列中的每一个的第一个数据一起进入网络,接下来是8个排在第二的数据一起输入,如此迭代。

当训练完成之后,用其中的组输入放进网络观察其输出:

inputs, targets = loader:next_batch()

outputs = rnn:forward(inputs)

x={}

y={}

for i=1,100 do

table.insert(x,inputs[i][{1,1}])

table.insert(y,outputs[i][{1,1}])

end

x = torch.Tensor(x)

y = torch.Tensor(y)

gnuplot.pngfigure('timer.png')

gnuplot.plot({x},{y})

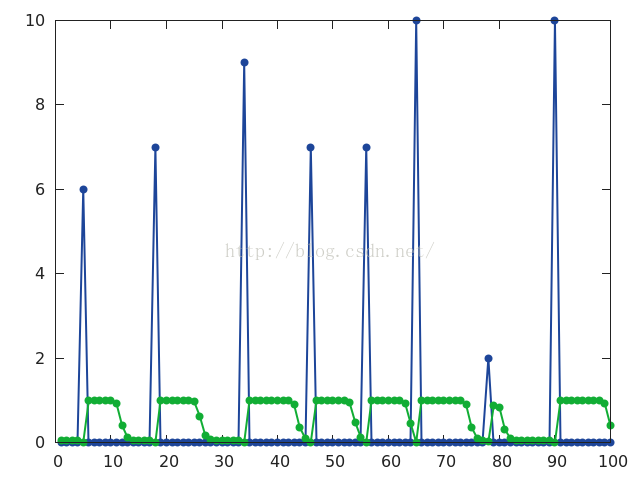

gnuplot.plotflush()结果显示如下:

虽然时间的把握上还有一些偏差,但这个RNN计时器可以算是基本学到了如何计时。

1903

1903

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?