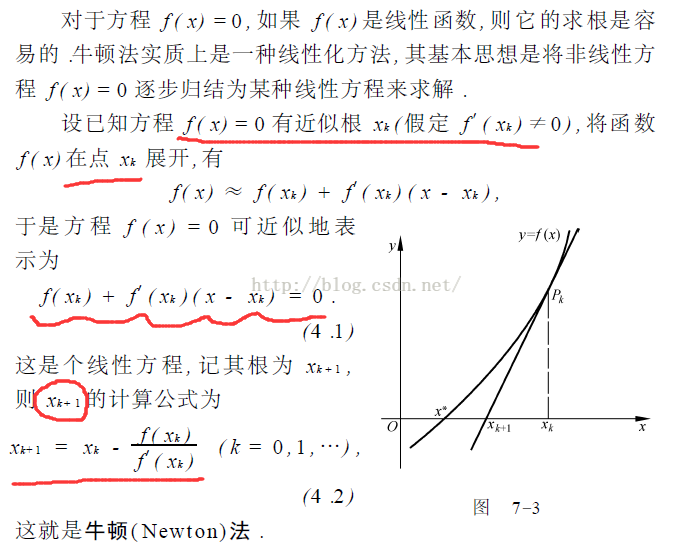

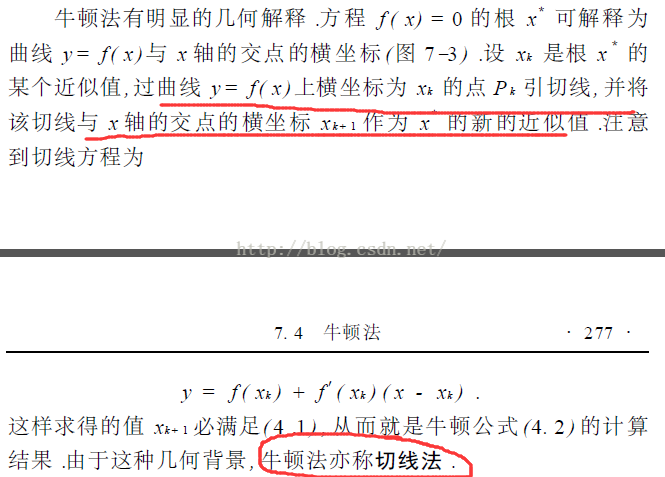

引用数值分析原文的内容,可以很快的编出牛顿法的代码。牛顿法其原理如下:

从上面理论可以看出,牛顿法就是不断寻找新的点 x(k+1)来逼近目标值,其寻找方法是不断对曲线做切线,并计算“前进”距离:f'(x)=tan( f(x(k)) / (x(k) - x(k+1)))。

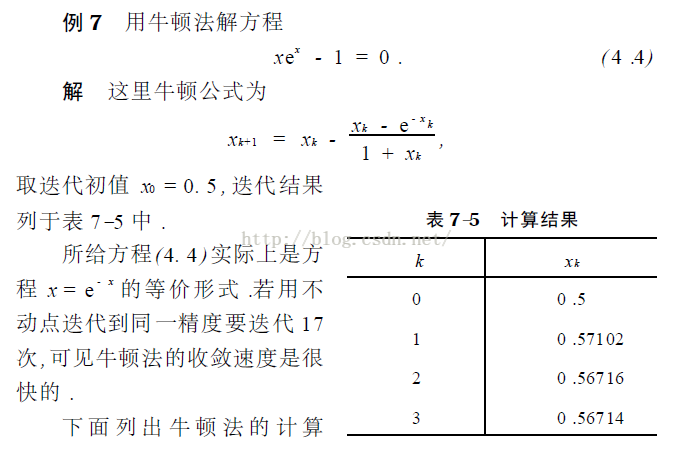

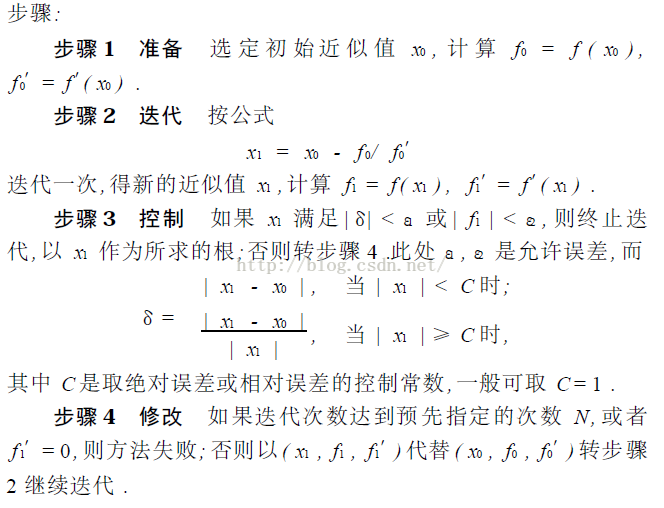

下面以书本的例子,编写相应的代码:

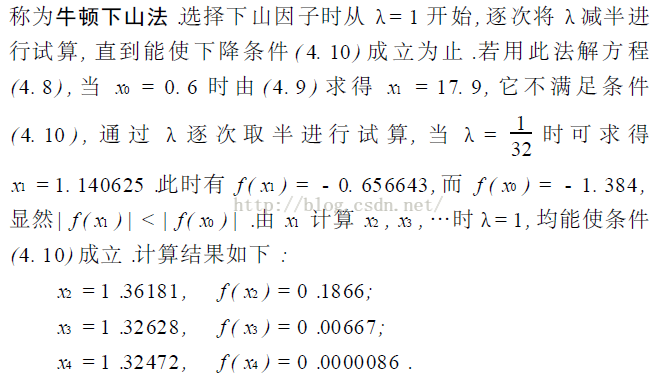

下山法是为防止迭代发散而额外加的条件。

其C语言代码如:

#include <stdio.h>

#include <stdlib.h>

#include <math.h>

#define E 0.000001

float fun(float x, int chs)

{

float y;

if( 0 == chs )//原函数

y = x*x*x -x -1;

if( 1 == chs )//导数

y = 3*x*x -1;

return y;

}

//牛顿下山法

float newton_downhill_method(float (*fun)(float, int), int iter, float x, float C, float E1, float E2)

{

int k;

int i = 1;

float delta;

float x0, x1;

float f0, df0;

float f1, df1;

float landa = 1;

if ( 0 == C )

{

C = 1;

}

x0 = x;

while( i++ < iter )

{

f0 = fun(x0, 0);

df0 = fun(x0, 1);

x1 = x0 - f0/df0;

f1 = fun(x1, 0);

df1 = fun(x1, 1);

//添加下山法

landa = 1;

while(1)

{

if( fabs(f0) > fabs(f1) )

break;

landa = landa/2;

x1 = x0 - landa*f0/df0;

f1 = fun(x1, 0);

}

if( x1 < C )

delta = fabs(x1 -x0);

else

delta = fabs(x1 -x0)/fabs(x1);

x0 = x1;

printf("%f\n", x0);

if( delta<E1 || fabs(f1)<E2)

break;

if( 0 == df1)

{

printf("Error:df1=0,iterative calculation failure.\n");

break;

}

}

if ( i == iter )

{

printf("Error:The iteration upper limit is reached.\n");

return 0;

}

return x1;

}

//牛顿迭代法(切线法)

float newton_method(float (*fun)(float, int), int iter, float x, float C, float E1, float E2)

{

int i = 1;

float delta;

float x0, x1;

float f0, df0;

float f1, df1;

if ( 0 == C )

{

C = 1;

}

x0 = x;

while( i++ < iter )

{

f0 = fun(x0, 0);

df0 = fun(x0, 1);

x1 = x0 - f0/df0;

f1 = fun(x1, 0);

df1 = fun(x1, 1);

if( x1 < C )

delta = fabs(x1 -x0);

else

delta = fabs(x1 -x0)/fabs(x1);

x0 = x1;

printf("%f\n", x0);

if( delta<E1 || fabs(f1)<E2)

break;

if( 0 == df1)

{

printf("Error:df1=0,iterative calculation failure.\n");

break;

}

}

if ( i == iter )

{

printf("Error:The iteration upper limit is reached.\n");

return 0;

}

return x1;

}

void main()

{

int order;

int iter = 1000;

float x0 = 0.6;

float C = 1;

newton_downhill_method(fun, iter, x0, C, E, E);

system("pause");

}

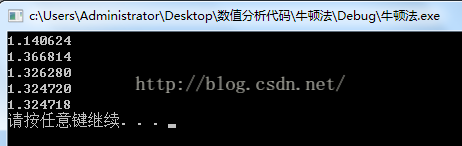

迭代结果:

1973

1973

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?