1.准备Linux环境

1.1设置虚拟机网络

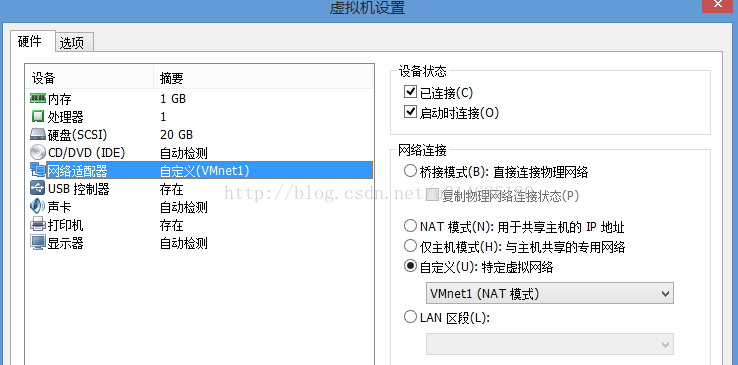

点击VMware菜单上的编辑按钮-->虚拟网络编辑器,把VMnet1设置成NAT模式,如下图所示

子网IP和子网掩码自动填写,点击应用-->确定,点击VMware右下角网络连接(两台电脑图标),出现小菜单后点击设置。

在出现的窗口中把网络连接设置成自定义并选择刚才设置NAT模式的VMnet1,设置后如下图所示。

1.2修改主机名

敲入命令:vim /etc/sysconfig/network,在该文件下设置成:

NETWORKING=yes

HOSTNAME=hadoop01(修改成自己喜欢的主机名)

1.3修改主机名和IP的映射关系

先查看Linux系统的IP地址,命令:ifconfig,再敲入命令:vim /etc/hosts,写上以下格式的内容:192.168.59.128(填写刚才查 到的IP的地址) hadoop01,保存退出。

1.4关闭防火墙

查看防火墙状态,命令:service iptables status;关闭防火墙,命令:service iptables stop;查看防火墙开机启动状态,命令: chkconfig iptables --list;关闭防火墙开机启动,命令:chkconfig iptables off

1.5重启Linux

命令:reboot

2.安装JDK

参考我写的文章:Linux系统下安装JDK7详解以及在centos版本下安装eclipse

3.安装hadoop2.4.1

3.1配置hadoop

伪分布式需要修改5个配置文件(hadoop2.x的配置文件$HADOOP_HOME/etc/hadoop)

第一个:hadoop-env.sh

#第27行

export JAVA_HOME=/usr/java/jdk1.7.0_65(修改为自己JDK的安装路径)

第二个:core-site.xml

<!-- 制定HDFS的老大(NameNode)的地址 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop01:9000</value>

</property>

<!-- 指定hadoop运行时产生文件的存储目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/hadoop/hadoop-2.4.1/tmp</value>

</property>

第三个:hdfs-site.xml

<!-- 指定HDFS副本的数量 -->

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

第四个:mapred-site.xml (命令:mv mapred-site.xml.template mapred-site.xml,修改文件名)

<!-- 指定mr运行在yarn上 -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

第五个:yarn-site.xml

<!-- 指定YARN的老大(ResourceManager)的地址 -->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>hadoop01</value>

</property>

<!-- reducer获取数据的方式 -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

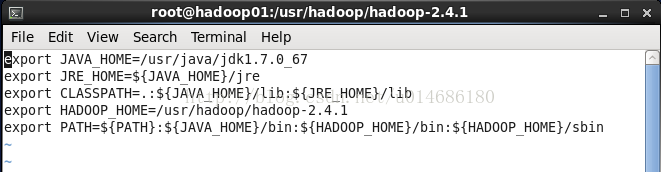

3.2将hadoop添加到环境变量

命令:vim /etc/proflie,添加以下内容:

export JAVA_HOME=/usr/java/jdk1.7.0_67(修改为自己JDK的安装路径)

export JRE_HOME=${JAVA_HOME}/jre

export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib

export HADOOP_HOME=/usr/hadoop/hadoop-2.4.1

export PATH=${PATH}:${JAVA_HOME}/bin:${HADOOP_HOME}/bin:${HADOOP_HOME}/sbin

添加后如以下截图所示:

执行命令:source /etc/profile,刷新设置。

3.3格式化namenode(是对namenode进行初始化)

hdfs namenode -format

3.4启动hadoop(进入hadoop的安装目录)

先启动HDFS

sbin/start-dfs.sh

再启动YARN

sbin/start-yarn.sh

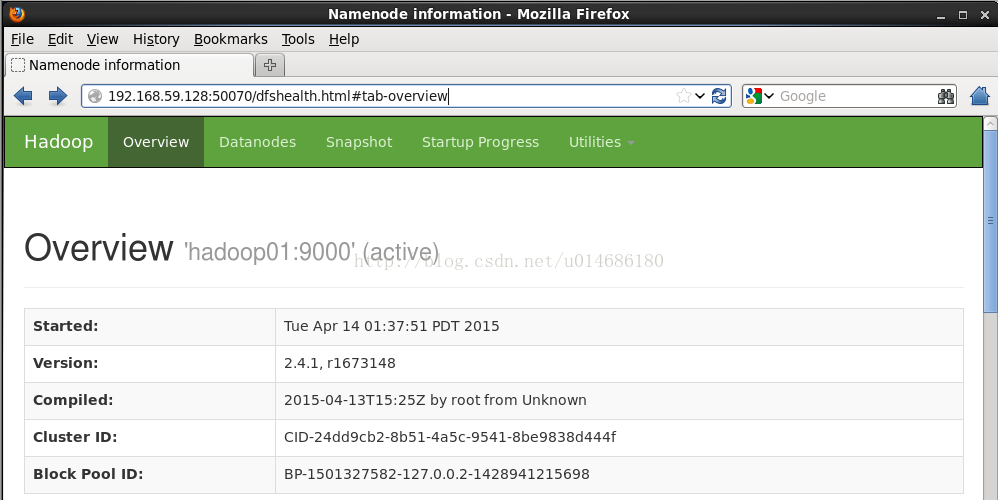

3.5验证是否启动成功

使用jps命令验证,若显示以下截图的信息则表明hadoop已成功启动

http://192.168.59.128:50070 (改成自己Linux系统的 IP地址,该URL能打开HDFS管理界面)

http://192.168.59.128:8088 (MR管理界面)

4.配置ssh免登陆

先生成ssh免登陆密钥,进入到.ssh目录,命令:cd ~/.ssh,再敲入命令:ssh-keygen -t rsa (四个回车),执行完这个命令后, 会生成两个文件 id_rsa(私钥)、id_rsa.pub(公钥),再执行命令: cat id_rsa.pub >> authorized_keys,此时ssh登录时已 无需输入密码,如下图所示

若在执行hdfs dfs 相关命令时会报WARN util.NativeCodeLoader: Unable to load native- hadoop library foryour platform… using builtin-java classes where applicable的错误。请查看我写的文章:WARN util.NativeCodeLoader: Unable to load native-hadoop library for your platform...的解决方案

1933

1933

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?