PRML系列:1.3 Model Selection

模型选择

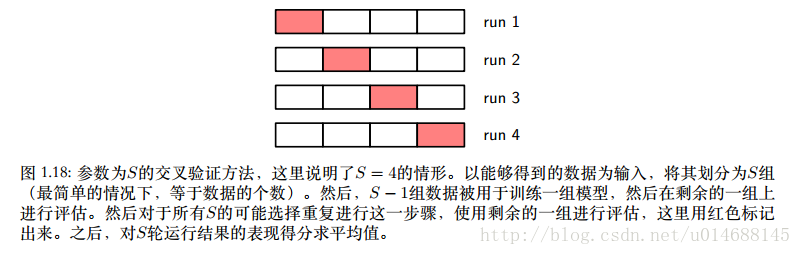

模型选择一般采用交叉验证,本节提到了S-fold cross-validation,原理如下,把数据集D随机划分成S份,其中S-1份用来训练模型,1份用来验证模型的效果。这样,一方面能充分利用所给数据集的几乎全部有用信息,另外一方面,可以有效避免过拟合现象的发生。

当S取数据集个数N时,这种技术叫做留一法,在样本稀缺的情况下尤其有用。

缺点:

- 随着S的增大,模型训练时间也增大,毕竟要训练S次,得到S个模型,在模型本身比较耗时的情况下,时间复杂度相当高。

- 对于单一模型,如果自身需要手动调节多个参数,如若干个正则化参数。在最坏情况下,探索这些参数的组合需要的训练次数可能是参数个数的指数函数。

针对第二个缺点,比如给定多项式拟合函数的阶数M和正则化系数 λ , M可选择9种, λ 可选择5种,那么自然有9 x 5 = 45种选择,随着需要手动调节参数的增多,训练次数也会指数上升。

这些参数的共同特点是,模型不能自动学得,需要手动调节,我们称为超参数。理想情况下,模型选择应该只依赖于训练数据,并且应该允许在一轮训练中对比多个超参数以及模型类型。因此,我们需要找到一种模型表现的度量,它只依赖于训练数据,并且不会由于过拟合产生偏移的问题。

文中提出了针对似然函数的一种”信息准则”,Akaike information criterion, 简称AIC,选择下面使这个量最大的模型:

lnp(D|wML)−M

不过令我好奇的是,是有特定的算法能够通过验证集能够自动选择最优模型么?书中暂未提到。

1691

1691

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?