因为是傻瓜式教程,所以一定会非常详细!一些概念link到了Wiki的相应解释上。

欢迎捉虫~!

二分类和回归的关系

考虑 x⇒y x ⇒ y 表示的二分类或回归问题,其中 x x 是输入, y y 是输出。

1. 在二分类中, y y 的值取0或1,代表被分为正类或负类。在回归中, y y 的取值为连续值。

2. 在线性回归模型中, y=wTx=w⋅x y = w T x = w ⋅ x ,此处 w w 为参数向量, x x 为输入样本向量。

3. 进一步,广义线性回归模型可以写为 g(y)=w⋅x g ( y ) = w ⋅ x 或者 y=g−1(w⋅x) y = g − 1 ( w ⋅ x ) 的形式,其中 g g 为单调可微函数。所以在对数回归中,模型是 ln(y)=w⋅x l n ( y ) = w ⋅ x 。

sigmoid函数与LR的关系

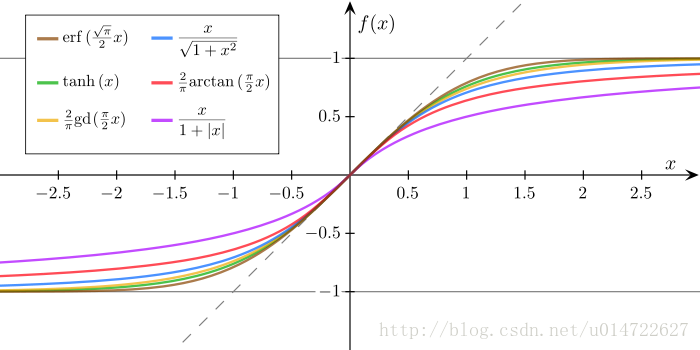

sigmoid函数:在数学上是拥有性感的s形曲线样子的函数:

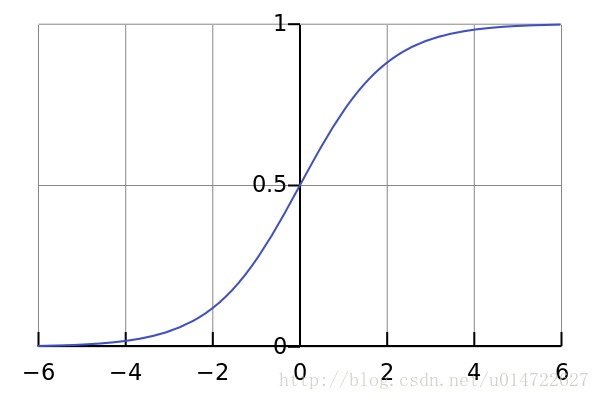

通常说的sigmoid函数指的是这个logistic函数: δ(z)=11+e−z=ez1+ez δ ( z ) = 1 1 + e − z = e z 1 + e z 。本文所指的sigmoid函数就是该logistic函数:

sigmoid函数具有以下特点:

- 值域在(0,1)

- 求导非常容易 δ′(z)=δ(1−δ(z)) δ ′ ( z ) = δ ( 1 − δ ( z ) ) (求导过程见附录,或Wiki)

我们希望在做二分类时,输出 y y 不再是非0即1的取值,而是希望输出一个有概率意义的 (0,1) ( 0 , 1 ) 之间的值,表示的是分为正类的概率(所以 1−y 1 − y 是分为负类的概率),然后再做二分类,所以我们挑选sigmoid函数作为广义线性回归的 g−1 g − 1 ,即

所以,现在 g(y)=ln(y1−y) g ( y ) = l n ( y 1 − y ) 。

前面说到,输出值 y y 代表分到正类的概率, 1−y 1 − y 代表分到负类的概率,那么 y1−y=正类概率负类概率

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

4730

4730

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?