激活函数:

激活函数的特点:

输入:标量,

输出;标量

很多激活函数如果画图,都是S形的,称为Sigmoid函数。

常见的有6种:

1.线性变换Linear:f(x) = Wx,用于输入层。直线。

2.Sigmoid函数:可以减少极端值而不用移除它们。0-1之间的S形渐近线。把x的正负无穷转为y的0-1,大多数都在0或1附近。为每个类输出一个独立概率。

人还是车?用sigmoid函数 ,是人吗?是车吗?

3.Tanh:tanh(x) = sinh(x) / cosh(x). 双曲线三角函数,形状类似Sigoid,但值域在[-1,1],可以处理负值。

4.Hard Tanh:与Tanh类似,x>1,视为1,x<-1视为-1.

5.Softmax:逻辑回归的一般化,可用于连续数据,可处理多决策边界。返回互斥类的概率分布。是大人吗?: 60% 是小孩吗?:40% Pi= Vi/V的总和

总结:sigmoid将一个real value映射到(0,1)的区间(当然也可以是(-1,1)),这样可以用来做二分类。

而softmax把一个k维的real value向量(a1,a2,a3,a4….)映射成一个(b1,b2,b3,b4….)其中bi是一个0-1的常数,然后可以根据bi的大小来进行多分类的任务,如取权重最大的一维。

一种变形为hierarchical softmax,把标签拆为树形分类,在每个节点上用softmax.

6.Rectified Linear (ReLU):f(x) = max(0, x),可处理坡度消失或爆炸的问题,比sigmoid和tanh好使。

7.Leaky ReLU:f(x)=x if x>0 else f(x)=0.01x

8.Softplus:ReLU的光滑版本。f(x) = ln[ 1 + exp(x) ]

小结:

对于输入层激活函数,常见的是线性;其它各层主要看模型任务,如果是0-1分类,首选ReLU或其变体,再考虑S形激活函数,如Sigmoid函数。如果是多分类任务,选择softmax. softmax还适用于连续值预测。

损失函数:

损失函数的值只依赖于权重W和偏好b,也就是网络状态。

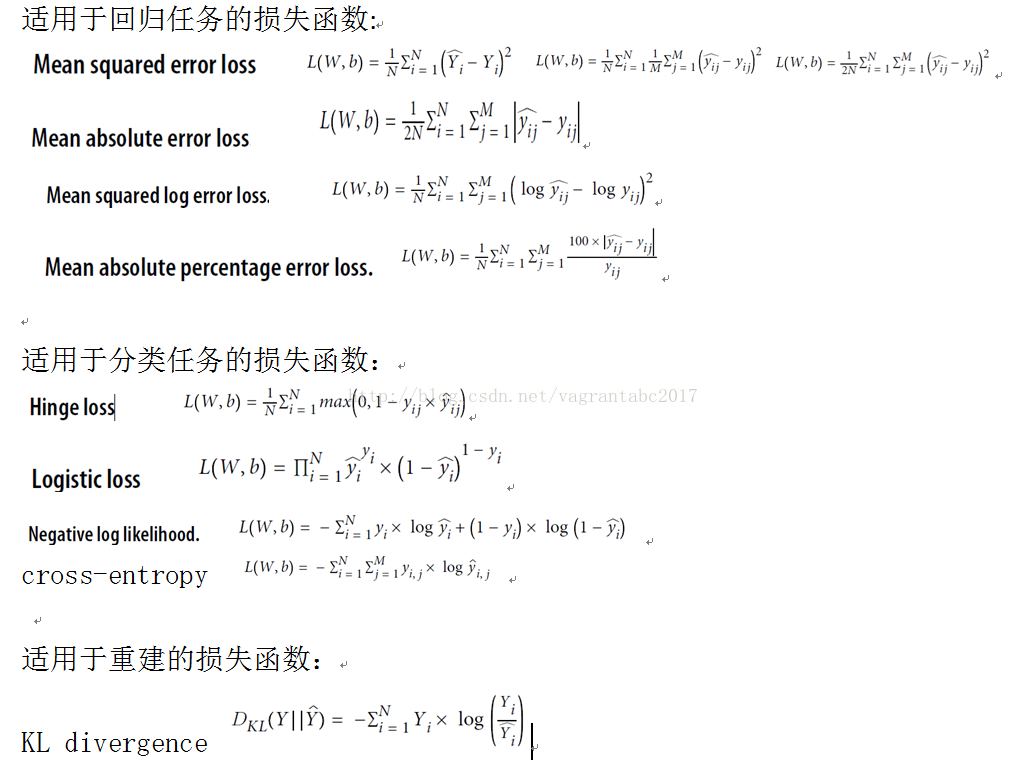

适用于回归任务的损失函数常见四种:

1. 均值平方差MSE。欧几里德距离,是一个意思。是凸形损失函数。但在隐藏层无效,此时对于参数有多个解。使用广泛,但对例外样本敏感。

预测值-实际值, 后面的公式都在这上面做文章。

2. MAE Mean absolute error loss, 不平方了,用绝对值。使用广泛。

3. MSLE Mean squared log error: 先对数一下预测值和实际值,然后和MSE一样(再求差,求平方)

4. MAPE Mean absolute percentage error: 在MAE的基础上,除个实际值,乘100.

当输出范围较大时,考虑第三、四种损失函数。但更多的时候是先标准化输出,再使用第一、二种。

适用于分类任务的损失函数:

1.Hinge loss 0-1分类中常用,是凸形损失函数。

2.Logistic loss

当类别数k = 2 时,softmax 回归退化为 logistic 回归。这表明 softmax 回归是 logistic 回归的一般形式。参见:http://blog.csdn.net/zhangliyao22/article/details/48379291

预测最大的可能性。 二元分类

3.Negative log likelihood 当类别大于2时,就是交叉熵.是效果较好的分类损失函数。

适用于重建的损失函数:限受波尔兹曼机,自动解码器等。

超参数:

与模型参数不同,超参数是为了让模型更好更快,处理模型优化和模型选择,保证模型不欠拟合和过拟合。

1. 学习率: 大的误差,大的坡度,大的学习率会导致大的step. 但大的学习率会导致模型在最优点两边来回跳。使用一个适中的静态学习率,然后试两个方向。更好的方法是学习率随时间变化。

2. 正则化Regularization。主要为了控制过拟合。

L1范数是指向量中各个元素绝对值之和,也有个美称叫“稀疏规则算子”(Lasso regularization)。

L2范数: ||W||2。它也不逊于L1范数,它有两个美称,在回归里面,有人把有它的回归叫“岭回归”(Ridge Regression),有人也叫它“权值衰减weight decay”。

3.动量Momentum:有助全局优化。

4.稀疏参数Sparsity:对于某些输入,只有某些特征相关。阻止网络学习,与bias在这一点上相反。

激活函数的特点:

输入:标量,

输出;标量

很多激活函数如果画图,都是S形的,称为Sigmoid函数。

常见的有6种:

1.线性变换Linear:f(x) = Wx,用于输入层。直线。

2.Sigmoid函数:可以减少极端值而不用移除它们。0-1之间的S形渐近线。把x的正负无穷转为y的0-1,大多数都在0或1附近。为每个类输出一个独立概率。

人还是车?用sigmoid函数 ,是人吗?是车吗?

3.Tanh:tanh(x) = sinh(x) / cosh(x). 双曲线三角函数,形状类似Sigoid,但值域在[-1,1],可以处理负值。

4.Hard Tanh:与Tanh类似,x>1,视为1,x<-1视为-1.

5.Softmax:逻辑回归的一般化,可用于连续数据,可处理多决策边界。返回互斥类的概率分布。是大人吗?: 60% 是小孩吗?:40% Pi= Vi/V的总和

总结:sigmoid将一个real value映射到(0,1)的区间(当然也可以是(-1,1)),这样可以用来做二分类。

而softmax把一个k维的real value向量(a1,a2,a3,a4….)映射成一个(b1,b2,b3,b4….)其中bi是一个0-1的常数,然后可以根据bi的大小来进行多分类的任务,如取权重最大的一维。

一种变形为hierarchical softmax,把标签拆为树形分类,在每个节点上用softmax.

6.Rectified Linear (ReLU):f(x) = max(0, x),可处理坡度消失或爆炸的问题,比sigmoid和tanh好使。

7.Leaky ReLU:f(x)=x if x>0 else f(x)=0.01x

8.Softplus:ReLU的光滑版本。f(x) = ln[ 1 + exp(x) ]

小结:

对于输入层激活函数,常见的是线性;其它各层主要看模型任务,如果是0-1分类,首选ReLU或其变体,再考虑S形激活函数,如Sigmoid函数。如果是多分类任务,选择softmax. softmax还适用于连续值预测。

损失函数:

损失函数的值只依赖于权重W和偏好b,也就是网络状态。

适用于回归任务的损失函数常见四种:

1. 均值平方差MSE。欧几里德距离,是一个意思。是凸形损失函数。但在隐藏层无效,此时对于参数有多个解。使用广泛,但对例外样本敏感。

预测值-实际值, 后面的公式都在这上面做文章。

2. MAE Mean absolute error loss, 不平方了,用绝对值。使用广泛。

3. MSLE Mean squared log error: 先对数一下预测值和实际值,然后和MSE一样(再求差,求平方)

4. MAPE Mean absolute percentage error: 在MAE的基础上,除个实际值,乘100.

当输出范围较大时,考虑第三、四种损失函数。但更多的时候是先标准化输出,再使用第一、二种。

适用于分类任务的损失函数:

1.Hinge loss 0-1分类中常用,是凸形损失函数。

2.Logistic loss

当类别数k = 2 时,softmax 回归退化为 logistic 回归。这表明 softmax 回归是 logistic 回归的一般形式。参见:http://blog.csdn.net/zhangliyao22/article/details/48379291

预测最大的可能性。 二元分类

3.Negative log likelihood 当类别大于2时,就是交叉熵.是效果较好的分类损失函数。

适用于重建的损失函数:限受波尔兹曼机,自动解码器等。

1. KL散度( Kullback–Leibler divergence),又称相对熵(relative entropy)

超参数:

与模型参数不同,超参数是为了让模型更好更快,处理模型优化和模型选择,保证模型不欠拟合和过拟合。

1. 学习率: 大的误差,大的坡度,大的学习率会导致大的step. 但大的学习率会导致模型在最优点两边来回跳。使用一个适中的静态学习率,然后试两个方向。更好的方法是学习率随时间变化。

2. 正则化Regularization。主要为了控制过拟合。

L1范数是指向量中各个元素绝对值之和,也有个美称叫“稀疏规则算子”(Lasso regularization)。

L2范数: ||W||2。它也不逊于L1范数,它有两个美称,在回归里面,有人把有它的回归叫“岭回归”(Ridge Regression),有人也叫它“权值衰减weight decay”。

3.动量Momentum:有助全局优化。

4.稀疏参数Sparsity:对于某些输入,只有某些特征相关。阻止网络学习,与bias在这一点上相反。

814

814

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?