参考地址:http://blog.csdn.net/jediael_lu/article/details/45310321

根据本机环境和安装时遇到的问题,本文进行了补充和修改。

以下介绍安装spark单机环境的方法,可用于测试及开发。主要分成以下5部分:

(1)环境准备

(2)安装scala

(3)安装spark

(4)验证安装情况

(5)可能遇到的问题

1、环境准备

(1)配套软件版本要求:Spark runs on Java 6+ and Python 2.6+. For the Scala API, Spark 1.3.1 uses Scala 2.10. You will need to use a compatible Scala version (2.10.x).

(2)安装好linux、jdk、python, 一般linux均会自带安装好jdk与python,但注意jdk默认为openjdk,建议重新安装oracle jdk。

(3)IP:192.168.198.130 hostname:corp

2、安装scala

(1)下载scala

wget http://downloads.typesafe.com/scala/2.10.5/scala-2.10.5.tgz

(2)解压文件

tar -zxvf scala-2.10.5.tgz(3)配置环境变量

$vi /etc/profile

#SCALA VARIABLES START

export SCALA_HOME=/home/corey/setup/scala-2.10.5

export PATH=$PATH:$SCALA_HOME/bin

#SCALA VARIABLES END$ source /etc/profile

$ scala -version

Scala code runner version 2.10.5 -- Copyright 2002-2013, LAMP/EPFL(4)验证scala

$ scala

Welcome to Scala version 2.10.5 (Java HotSpot(TM) 64-Bit Server VM, Java 1.7.0_51).

Type in expressions to have them evaluated.

Type :help for more information.

scala> 9*9

res0: Int = 813、安装spark

(1)下载spark

wget http://mirror.bit.edu.cn/apache/spark/spark-1.3.1/spark-1.3.1-bin-hadoop2.6.tgz(2)解压spark

tar -zxvf http://mirror.bit.edu.cn/apache/spark/spark-1.3.1/spark-1.3.1-bin-hadoop2.6.tgz(3)配置环境变量

$ vim /etc/profile

#SPARK VARIABLES START

export SPARK_HOME=/home/corey/setup/spark-1.3.1-bin-hadoop2.6

export PATH=$PATH:$SPARK_HOME/bin

#SPARK VARIABLES END$ source /etc/profile(4)配置spark

$ pwd

/home/corey/setup/spark-1.3.1-bin-hadoop2.6/conf$ mv spark-env.sh.template spark-env.sh

$ vim spark-env.sh

export SCALA_HOME=/home/corey/setup/scala-2.10.5

export JAVA_HOME=/usr/bin/jvm/jdk1.7.0_79

export SPARK_MASTER_IP=192.168.198.130

export SPARK_WORKER_MEMORY=512m

export master=spark://192.168.198.130:7070$vi slaves

master(5)启动spark

$ pwd

/home/corey/setup/spark-1.3.1-bin-hadoop2.6/sbin$ ./start-all.sh 注意,hadoop也有start-all.sh脚本,因此必须进入具体目录执行脚本

$ jps

30302 Worker

30859 Jps

30172 Master4、验证安装情况

(1)运行自带示例

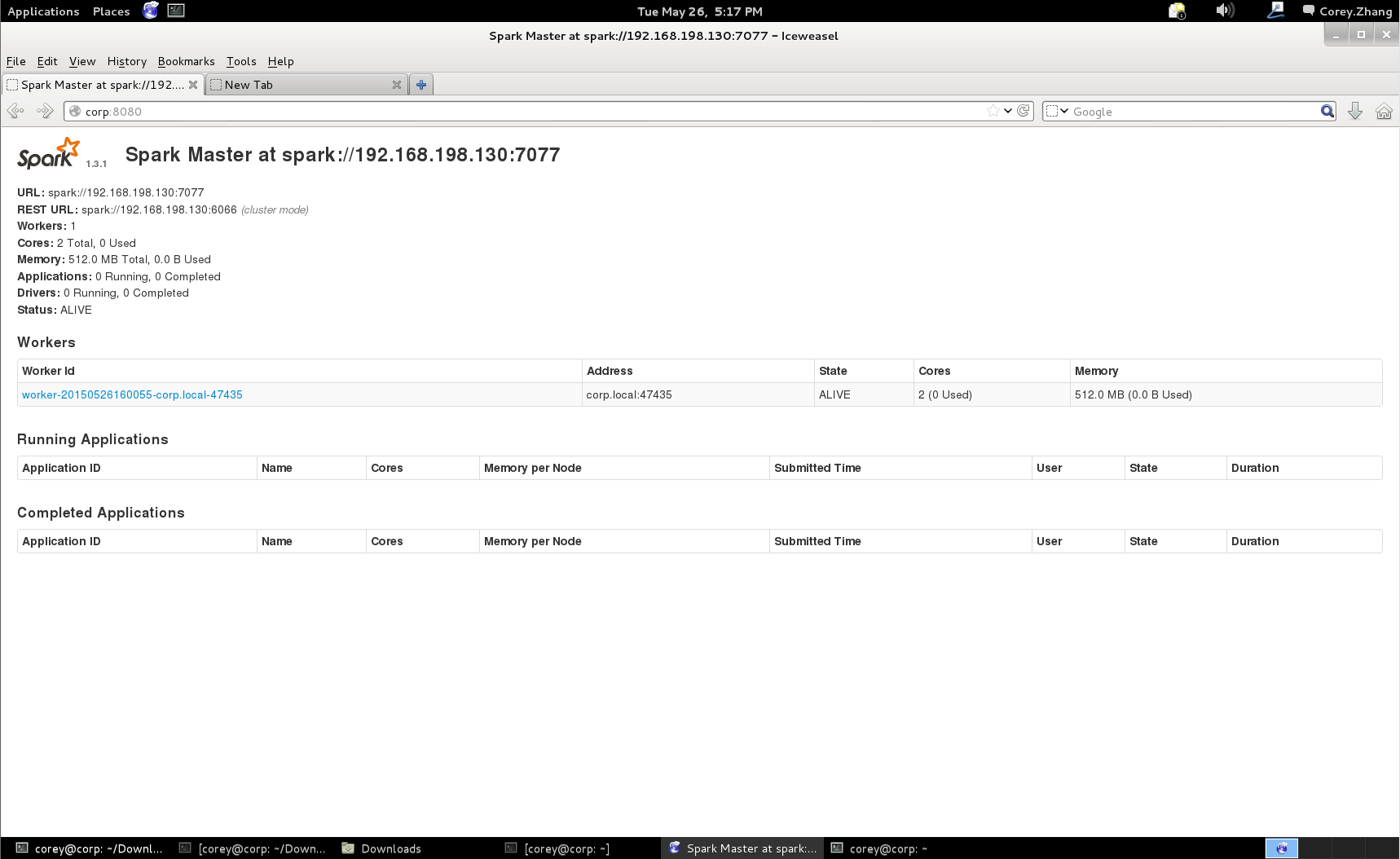

$ bin/run-example org.apache.spark.examples.SparkPi(2)查看集群环境

http://master:8080/

(3)进入spark-shell

$spark-shell(4)查看jobs等信息

http://master:4040/jobs/5、可能遇到的问题

(1)无法启动spark

$ vim spark-env.sh

export master=spark://192.168.198.130:7070将这里的corp修改为你的hostname

corey@corp:~$ hostname

corp或者在hosts中添加master的IP映射

corey@corp:~$ sudo vim /etc/hosts

192.168.198.130 master(2)无法找到jps

jps存在于$JAVA_HOME/bin目录下,将其加入PATH

$ vim /etc/profile

export PATH=$PATH:=/usr/bin/jvm/jdk1.7.0_79/binsource /etc/profile(3)在IDEA中Run遇到ClassNotFoundException。例如

15/05/30 19:00:25 WARN TaskSetManager: Lost task 1.0 in stage 0.0 (TID 1, 192.168.163.128): java.lang.ClassNotFoundException: com.spark.demo.SparkPi$$anonfun$1通过setJars将Jar添加入SparkConf

768

768

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?