1.编译

首先说明,这里所用的hadoop版本为1.0.0。

hadoop的eclipse插件通过编译/src/contrib/eclipse-plugin目录下的代码得到,但是直接编译得到的jar包因为缺少一些依赖库而不能直接使用,因此首先要进行一些修改然后再编译。

首先修改build.xml,

<fileset dir="${hadoop.root}" includes="*.jar"/>在末尾的target标签中加入以下内容

<copy file="${hadoop.root}/lib/commons-configuration-1.6.jar" todir="${build.dir}/lib" verbose="true" />

<copy file="${hadoop.root}/lib/commons-lang-2.4.jar" todir="${build.dir}/lib" verbose="true" />

<copy file="${hadoop.root}/lib/jackson-core-asl-1.0.1.jar" todir="${build.dir}/lib" verbose="true" />

<copy file="${hadoop.root}/lib/jackson-mapper-asl-1.0.1.jar" todir="${build.dir}/lib" verbose="true" />

<copy file="${hadoop.root}/lib/commons-httpclient-3.0.1.jar" todir="${build.dir}/lib" verbose="true" />

我还发现原本就存在的两个copy也有问题:

<copy file="${hadoop.root}/build/hadoop-core-${version}.jar" tofile="${build.dir}/lib/hadoop-core.jar" verbose="true"/>

<copy file="${hadoop.root}/build/ivy/lib/Hadoop/common/commons-cli-${commons-cli.version}.jar" todir="${build.dir}/lib" verbose="true"/>

因为我发现它们所指定的两个jar文件目录都不对,因此修改他们,让他们指向正确的目录:

<copy file="${hadoop.root}/hadoop-core-${version}.jar" tofile="${build.dir}/lib/hadoop-core.jar" verbose="true"/>

<copy file="${hadoop.root}/lib/commons-cli-${commons-cli.version}.jar" todir="${build.dir}/lib" verbose="true"/>这个版本的hadoop使用了过期的API,可以在build.xml中的javac标签中加入下面两行来在编译过程中显示关于未检查转换和过期API的警告详情,也可以不加,编译器依然会简单的警告。

<compilerarg value="-Xlint:unchecked"/>

<compilerarg value="-Xlint:deprecation"/>然后修改META-INF/MANIFEST.MF文件,将Bundle-ClassPath属性修改为:

Bundle-ClassPath: classes/,

lib/hadoop-core.jar,lib/commons-configuration-1.6.jar,lib/commons-lang-2.4.jar,lib/jackson-core-asl-1.0.2.jar,lib/jackson-mapper-asl-1.0.2.jar,lib/commons-httpclient-3.0.1.jar

然后执行ant -Declipse.home=/usr/lib/eclipse -Dversion=1.0.0来进行编译,其中Declipse.home指定eclipse的安装目录,Dversion指定hadoop的版本。

如果在输出中看到BUILD SUCCESSFUL说明编译成功。如果编译过程中遇到错误,可以参考解决错误。

2.配置

生成的jar文件在hadoop-1.0.0/build/contrib/eclipse-plugin目录下,将该jar包拷贝到eclipse的plugins目录下,重启eclipse。

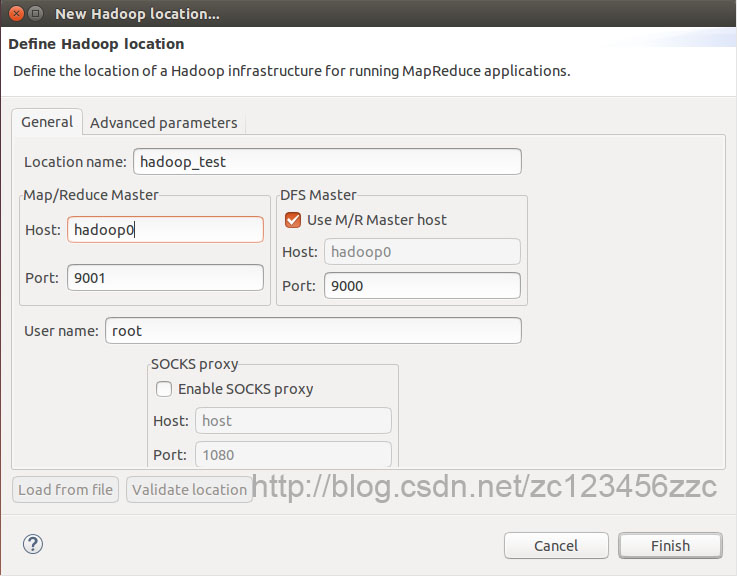

然后Windows-》Show View-》Other-》MapReduce Tools-》Map/Reduce Locations-》New Hadoop Location,然后填写如下内容。

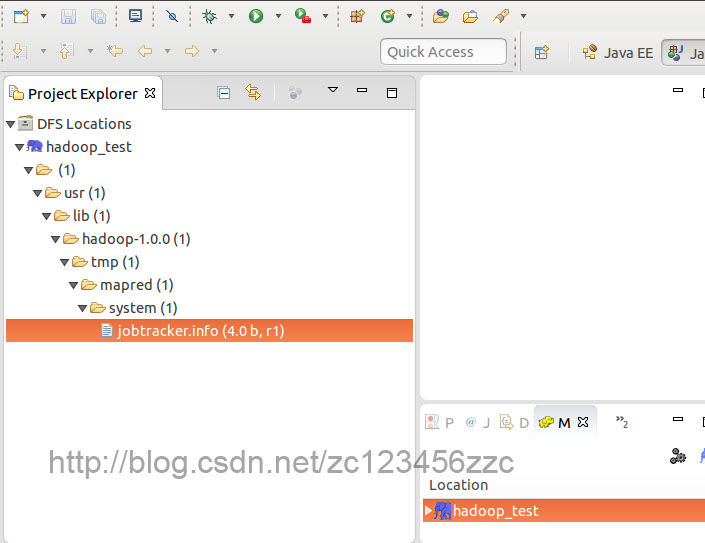

如果能通过Project Explorer看到HDFS上的文件,说明插件配置成功。

3.解决错误

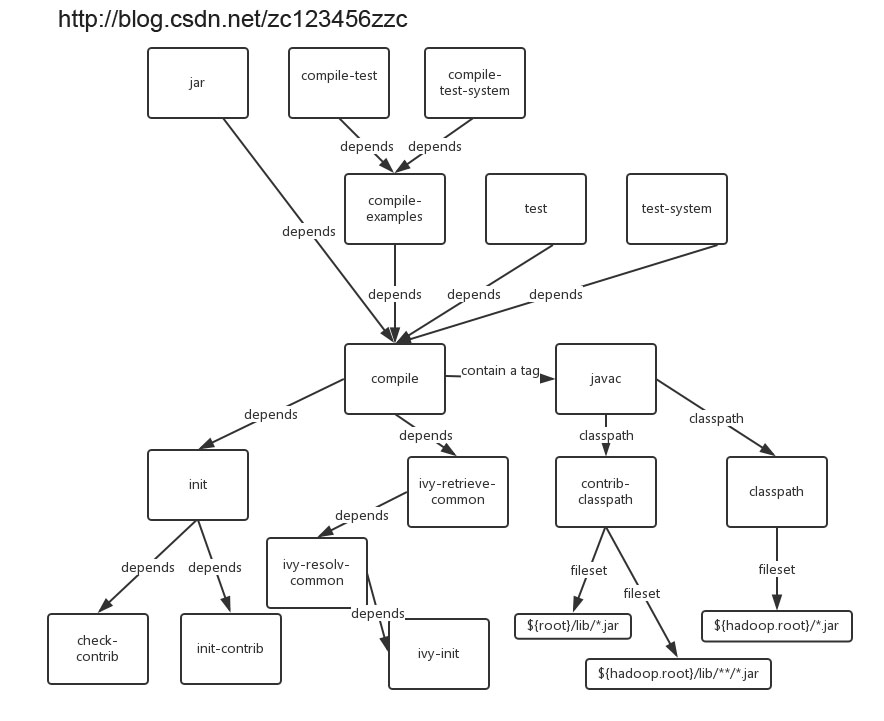

我在编译的过程中出现错误说找不到package org.apache.hadoop.fs,这显然是由于没有正确的引用hadoop-core-1.0.0.jar造成的,因此在上面将hadoop安装目录下的jar包全部加入classpath解决了这个问题(看这里)。当然也可能遇到其他的问题,为了方便排查错误,附一张主要的依赖关系图和一些变量的值。

${hadoop.root}=/usr/lib/hadoop-1.0.0

${root}=${basedir}=${hadoop.root}/src/contrib/eclipse-plugin

${build.dir}=${hadoop.root}/build/contrib/eclipse-plugin

${build.classes}=${build.dir}/classes

${src.dir}=${root}/src/java

65

65

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?