深感当今AI绘画的飞速进展或许已远超所有人的预期. 而这里的前因后果, 包括AI绘画的历史, 以及最近的突破性进展, 值得好好和大伙儿梳理和分享一下. 因此有了本文.

本文分为如下几小节:

1 2022, 进击的AI绘画

2 AI绘画的历史

3 AI绘画何以突飞猛进

4 顶级AI绘画模型的PK

5 AI绘画的突破对人类意味着什么

01

2022, 进击的AI绘画

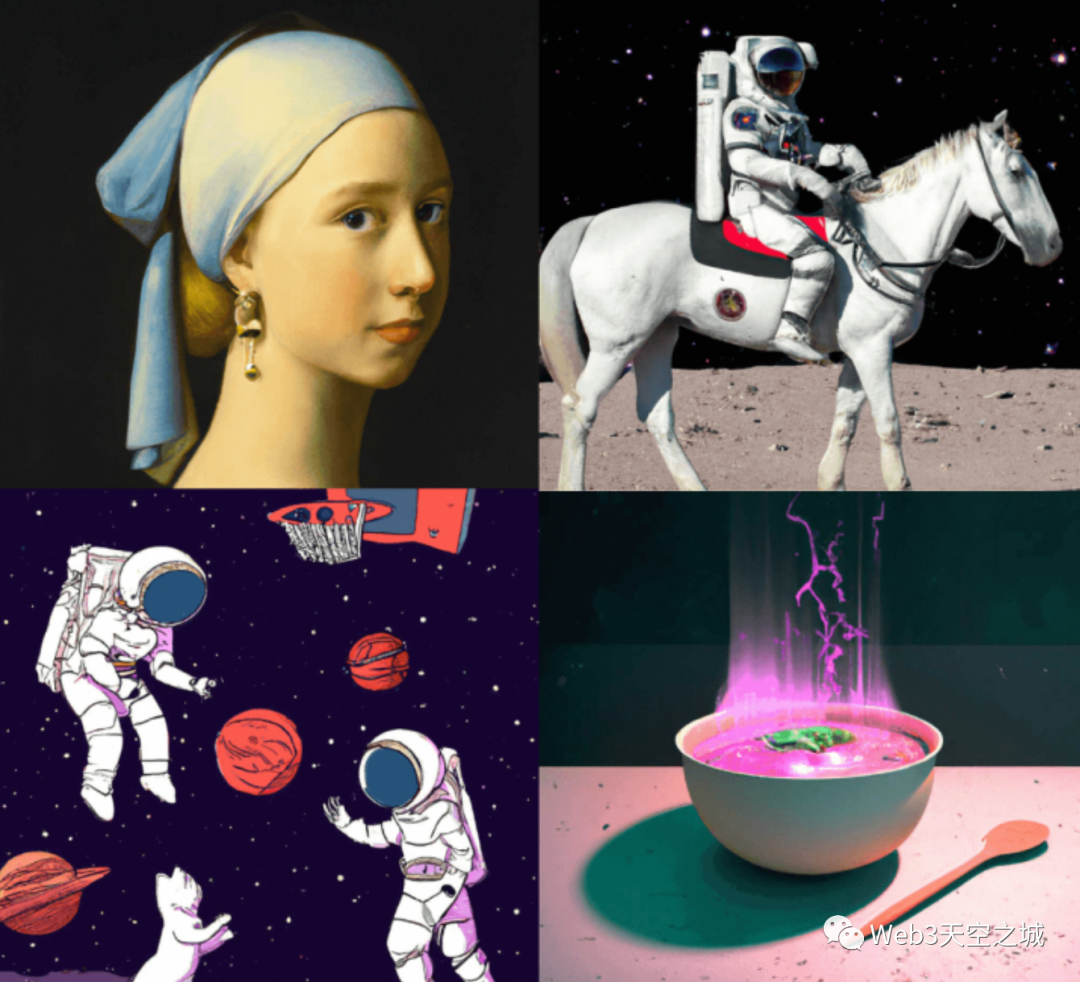

今年以来, 输入文本描述自动生成图片的AI绘画神器突然雨后春笋的冒了出来.

首先是Disco Diffusion.

Disco Diffusion 是在今年 2 月初开始爆红的一个 AI 图像生成程序,它可以根据描述场景的关键词渲染出对应的图像:

到了今年4月, 著名人工智能团队OpenAI 也发布了新模型 DALL·E 2代,该名称来源于著名画家达利(Dalí)和机器人总动员(Wall-E), 同样支持从文本描述生成效果良好的图像.

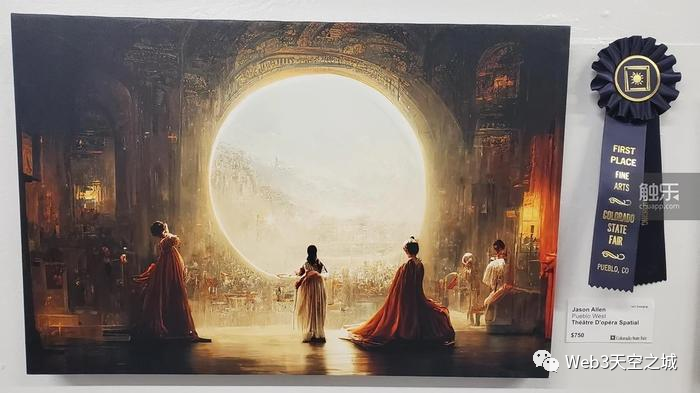

而很多读者对AI绘画开始产生特别的关注, 或许是从以下这幅AI作品闹出的新闻开始的:

这是一幅使用AI绘画服务 MidJourney 生成的数字油画, 生成它的用户以这幅画参加美国科罗拉多州博览会的艺术比赛, 夺得了第一名. 这件事被曝光之后引发了网络上巨大的争论至今.

目前 AI绘画的技术仍在不断变化发展中, 其迭代之快, 完全可以用"日新月异"来形容. 即使把今年年初的AI绘画和现在相比, 效果也有天壤之别.

在年初的时候, 用Disco Diffusion可以生成一些很有氛围感的草图, 但基本还无法生成人脸; 仅仅2个月后, DALL-E 2已经可以生成准确的五官; 现在, 最强大的Stable Diffusion在画作的精致程度和作画速度上更是有了一个量级的变化.

AI绘画这项技术并不是近年才有的, 但是今年以来, AI产出作品的质量以肉眼可见的速度日益提升, 而效率也从年初的一个小时缩短到现在的十几秒.

在这个变化后面, 究竟发生了什么事情? 就让我们先全面回顾一下AI绘画的历史, 再来理解一下, 这一年多来, AI绘画技术足以载入史册的突破发展.

02

AI绘画的出现时间可能比很多人想象的要早

计算机是上世纪60年代出现的, 而就在70年代, 一位艺术家,哈罗德·科恩Harold Cohen(画家,加利福尼亚大学圣地亚哥分校的教授) 就开始打造电脑程序"AARON"进行绘画创作. 只是和当下AI绘画输出数字作品有所不同, AARON是真的去控制一个机械臂来作画的.

Harold 对 AARON的改进一直持续了几十年, 直到他离世. 在80年代的时候, ARRON"掌握"了三维物体的绘制; 90年代时, AARON能够使用多种颜色进行绘画, 据称直到今天, ARRON仍然在创作.

不过, AARON的代码没有开源, 所以其作画的细节无从知晓, 但可以猜测, ARRON只是以一种复杂的编程方式描述了作者Harold本人对绘画的理解 – 这也是为什么ARRON经过几十年的学习迭代,最后仍然只能产生色彩艳丽的抽象派风格画作,这正是 Harold Cohen 本人的抽象色彩绘画风格. Harold用了几十年时间, 把自己对艺术的理解和表现方式通过程序指导机械臂呈现在了画布上.

(左:ARRON和哈罗德.科恩 右: ARRON 在 1992 年的创作作品)

尽管难说AARON如何智能, 但作为第一个自动作画且真的在画布上作画的程序, 给予它一个AI作画鼻祖的称号, 倒也符合其身份.

2006年, 出现了一个类似ARRON的电脑绘画产品 The Painting Fool. 它可以观察照片, 提取照片里的块颜色信息, 使用现实中的绘画材料如油漆, 粉彩或者和铅笔等进行创作.

以上这两个例子算是比较"古典"方式的电脑自动绘画, 有点像一个学步的婴儿, 有一点样子, 但从智能化的角度来看是相当初级的.

而现在, 我们所说的"AI绘画"概念, 更多指的是基于深度学习模型来进行自动作图的计算机程序. 这个绘画方式的发展其实是比较晚的.

在2012年 Google两位大名鼎鼎的AI大神, 吴恩达和Jef Dean进行了一场空前的试验, 联手使用1.6万个CPU训练了一个当时世界上最大的深度学习网络, 用来指导计算机画出猫脸图片. 当时他们使用了来自youtube的1000万个猫脸图片, 1.6万个CPU整整训练了3天, 最终得到的模型, 令人振奋的可以生成一个非常模糊的猫脸.

在今天看起来, 这个模型的训练效率和输出结果都不值一提. 但对于当时的AI研究领域, 这是一次具有突破意义的尝试, 正式开启了深度学习模型支持的AI绘画这个"全新"研究方向.

在这里我们稍微讲一点技术细节: 基于深度学习模型的AI绘画究竟有多麻烦呢, 为什么2012年已经很现代水平的大规模计算机集群耗时多天的训练只能得出一点可怜的结果?

读者们或许有个基本概念, 深度学习模型的训练简单说来就是利用外部大量标注好的训练数据输入, 根据输入和所对应的预期输出, 反复调整模型内部参数加以匹配的过程.

那么让AI学会绘画的过程, 就是构建已有画作的训练数据, 输入AI模型进行参数迭代调整的过程.

一幅画带有多少信息呢? 首先就是长x宽个RGB像素点. 让计算机学绘画, 最简单的出发点是得到一个输出有规律像素组合的AI模型.

但RGB像素组合一起的并非都是画作, 也可能只是噪点. 一副纹理丰富, 笔触自然的画作有很多笔画完成, 涉及绘画中每一笔的位置, 形状, 颜色等多个方面的参数, 这里涉及到的参数组合是非常庞大的. 而深度模型训练的计算复杂度随着参数输入组合的增长而急剧增长… 大家可以理解这个事情为啥不简单了.

在吴恩达和Jeff Dean开创性的猫脸生成模型之后, AI科学家们开始前赴后继投入到这个新的挑战性领域里. 在2014年, AI学术界提出了一个非常重要的深度学习模型, 这就是大名鼎鼎的对抗生成网络GAN (Generative Adverserial Network, GAN).

正如同其名字"对抗生成", 这个深度学习模型的核心理念是让两个内部程序 “生成器(generator)” 和"判别器(discriminator)" 互相PK平衡之后得到结果.

GAN模型一问世就风靡AI学术界, 在多个领域得到了广泛的应用. 它也随即成为了很多AI绘画模型的基础框架, 其中生成器用来生成图片, 而判别器用来判断图片质量. GAN的出现大大推动了AI绘画的发展.

但是, 用基础的GAN模型进行AI绘画也有比较明显的缺陷, 一方面是对输出结果的控制力很弱, 容易产生随机图像, 而AI艺术家的输出应该是稳定的. 另外一个问题是生成图像的分辨率比较低.

分辨率的问题还好说, GAN在"创作"这个点上还存在一个死结, 这个结恰恰是其自身的核心特点: 根据GAN基本架构,判别器要判断产生的图像是否和已经提供给判别器的其他图像是同一个类别的, 这就决定了在最好的情况下, 输出的图像也就是对现有作品的模仿, 而不是创新…

在对抗生成网络G

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?