DB-GPT-Hub学习资料汇总

DB-GPT-Hub是一个基于大语言模型的开放文本到SQL基准平台,旨在通过微调大语言模型来提升文本到SQL的转换能力。本文汇总了DB-GPT-Hub项目的相关学习资料,帮助开发者快速了解和使用该项目。

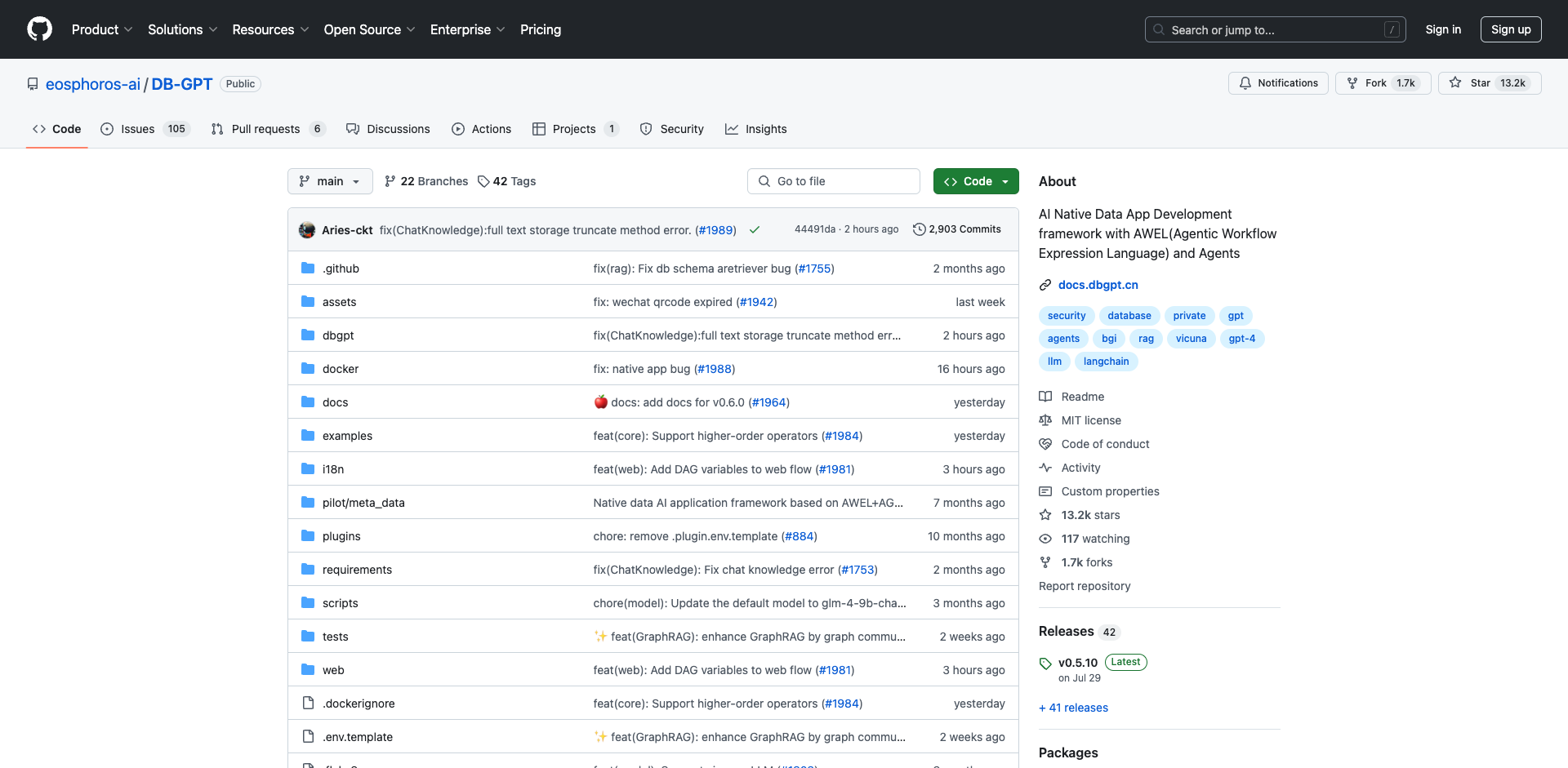

1. 项目介绍

DB-GPT-Hub是一个实验性项目,利用大语言模型(LLMs)实现文本到SQL的解析。该项目包括数据收集、数据预处理、模型选择与构建、模型权重微调等多个阶段,目标是提高文本到SQL的转换能力,同时降低模型训练成本,使更多开发者能参与到提升文本到SQL准确性的工作中来。

项目GitHub仓库:https://github.com/eosphoros-ai/DB-GPT-Hub

2. 主要特性

- 多模型管理(SMMF):简化AI模型的集成和管理

- Text2SQL优化:提高自然语言查询转SQL的效率和准确性

- RAG框架:通过检索增强生成技术提升响应质量

- 多智能体协作:支持多个智能体协同完成复杂任务

- AWEL(智能工作流表达语言):用于编排智能体工作流

3. 数据集

DB-GPT-Hub主要使用以下数据集:

- Spider:跨领域的复杂文本到SQL数据集

- WikiSQL:大规模语义解析数据集

- CHASE:中文跨领域多轮交互文本到SQL数据集

- BIRD-SQL:专注于大规模数据库内容的英文文本到SQL基准

4. 支持的模型

目前支持的基础模型包括:

- CodeLlama

- Baichuan2

- LLaMa/LLaMa2

- Falcon

- Qwen

- XVERSE

- ChatGLM2/3

- internlm

- sqlcoder系列

5. 使用教程

5.1 环境准备

git clone https://github.com/eosphoros-ai/DB-GPT-Hub.git

cd DB-GPT-Hub

conda create -n dbgpt_hub python=3.10

conda activate dbgpt_hub

cd src/dbgpt_hub_sql

pip install -e .

5.2 快速开始

安装dbgpt-hub:

pip install dbgpt-hub

使用Python代码运行完整流程:

from dbgpt_hub_sql.data_process import preprocess_sft_data

from dbgpt_hub_sql.train import start_sft

from dbgpt_hub_sql.predict import start_predict

from dbgpt_hub_sql.eval import start_evaluate

# 配置数据集

data_folder = "dbgpt_hub_sql/data"

data_info = [

{

"data_source": "spider",

"train_file": ["train_spider.json", "train_others.json"],

"dev_file": ["dev.json"],

"tables_file": "tables.json",

"db_id_name": "db_id",

"is_multiple_turn": False,

"train_output": "spider_train.json",

"dev_output": "spider_dev.json",

}

]

# 配置训练参数

train_args = {

"model_name_or_path": "codellama/CodeLlama-13b-Instruct-hf",

"do_train": True,

"dataset": "example_text2sql_train",

"max_source_length": 2048,

"max_target_length": 512,

"finetuning_type": "lora",

"lora_target": "q_proj,v_proj",

"template": "llama2",

"lora_rank": 64,

"lora_alpha": 32,

"output_dir": "dbgpt_hub_sql/output/adapter/CodeLlama-13b-sql-lora",

"overwrite_cache": True,

"overwrite_output_dir": True,

"per_device_train_batch_size": 1,

"gradient_accumulation_steps": 16,

"lr_scheduler_type": "cosine_with_restarts",

"logging_steps": 50,

"save_steps": 2000,

"learning_rate": 2e-4,

"num_train_epochs": 8,

"plot_loss": True,

"bf16": True,

}

# 配置预测参数

predict_args = {

"model_name_or_path": "codellama/CodeLlama-13b-Instruct-hf",

"template": "llama2",

"finetuning_type": "lora",

"checkpoint_dir": "dbgpt_hub_sql/output/adapter/CodeLlama-13b-sql-lora",

"predict_file_path": "dbgpt_hub_sql/data/eval_data/dev_sql.json",

"predict_out_dir": "dbgpt_hub_sql/output/",

"predicted_out_filename": "pred_sql.sql",

}

# 配置评估参数

evaluate_args = {

"input": "./dbgpt_hub_sql/output/pred/pred_sql_dev_skeleton.sql",

"gold": "./dbgpt_hub_sql/data/eval_data/gold.txt",

"gold_natsql": "./dbgpt_hub_sql/data/eval_data/gold_natsql2sql.txt",

"db": "./dbgpt_hub_sql/data/spider/database",

"table": "./dbgpt_hub_sql/data/eval_data/tables.json",

"table_natsql": "./dbgpt_hub_sql/data/eval_data/tables_for_natsql2sql.json",

"etype": "exec",

"plug_value": True,

"keep_distict": False,

"progress_bar_for_each_datapoint": False,

"natsql": False,

}

# 运行完整流程

preprocess_sft_data(

data_folder = data_folder,

data_info = data_info

)

start_sft(train_args)

start_predict(predict_args)

start_evaluate(evaluate_args)

5.3 数据准备

下载Spider数据集并放置在dbgpt_hub_sql/data/spider目录下,然后运行:

sh dbgpt_hub_sql/scripts/gen_train_eval_data.sh

5.4 模型微调

运行以下命令进行模型微调:

sh dbgpt_hub_sql/scripts/train_sft.sh

5.5 模型预测

运行以下命令进行模型预测:

sh ./dbgpt_hub_sql/scripts/predict_sft.sh

5.6 模型评估

运行以下命令评估模型性能:

python dbgpt_hub_sql/eval/evaluation.py --plug_value --input Your_model_pred_file

6. 模型权重

您可以在Hugging Face上找到预训练的模型权重。

7. 贡献指南

我们欢迎更多人参与到项目中来,包括数据集、模型微调、性能评估、论文推荐和代码复现等方面。请随时提出issues或pull requests。

8. 相关资源

DB-GPT-Hub为开发者提供了一个强大的文本到SQL基准平台。通过本文的学习资料汇总,希望能帮助更多人了解和使用这个项目,共同推动自然语言处理和数据库查询技术的发展。

文章链接:www.dongaigc.com/a/db-gpt-hub-learning-resources

https://www.dongaigc.com/a/db-gpt-hub-learning-resources

www.dongaigc.com/p/eosphoros-ai/DB-GPT-Hub

https://www.dongaigc.com/p/eosphoros-ai/DB-GPT-Hub

3227

3227

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?