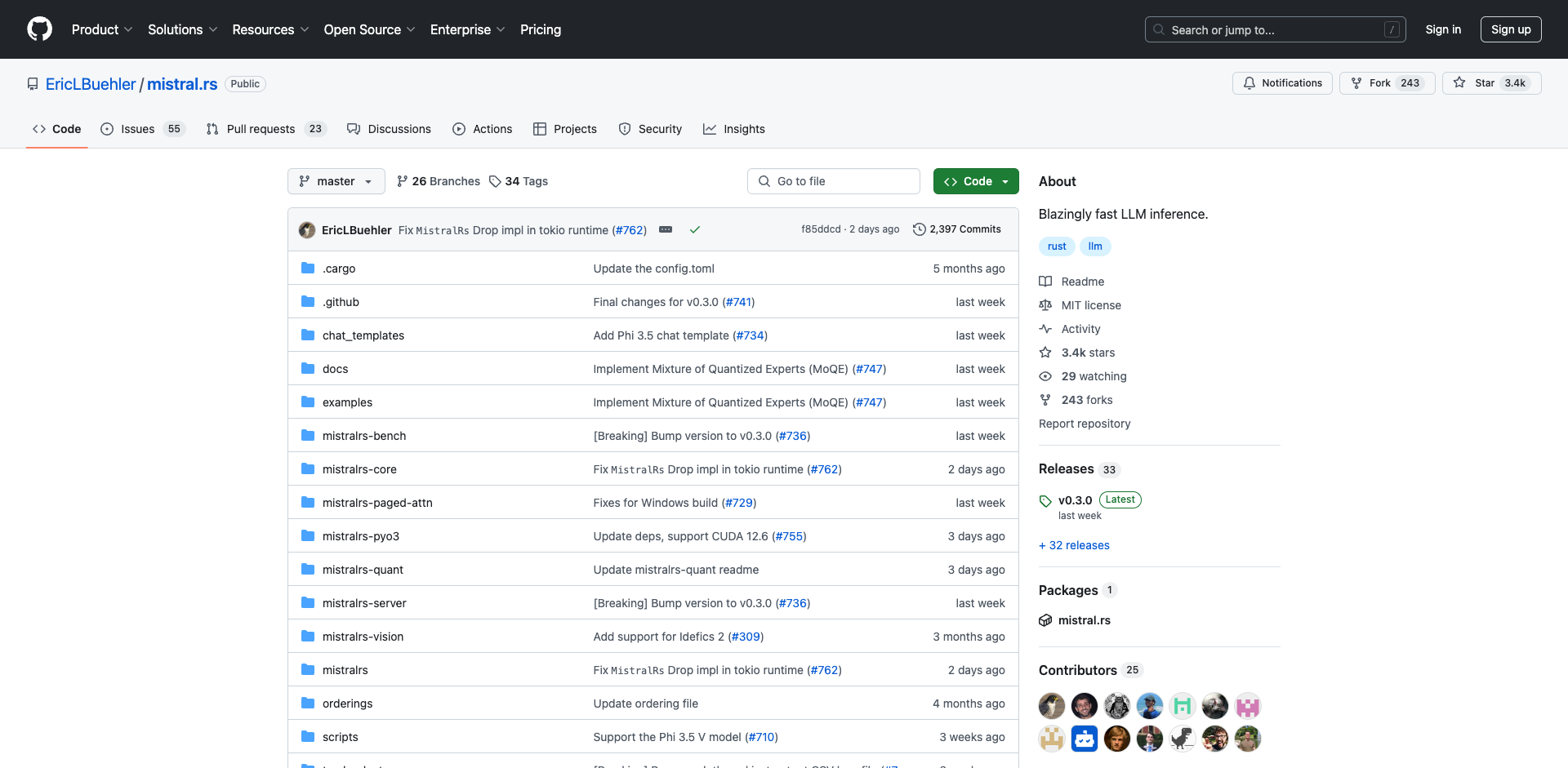

mistral.rs简介

mistral.rs是一个快速、高效的大型语言模型(LLM)推理平台,具有以下主要特点:

- 支持在多种设备上进行推理,包括CPU、GPU和Apple Silicon

- 提供量化功能,支持2-bit到8-bit的量化

- 兼容OpenAI API的HTTP服务器

- 提供Python绑定,易于集成

主要功能

高性能推理

- 支持Apple Silicon的Metal框架

- CPU推理支持MKL和Accelerate优化

- CUDA支持,包括Flash Attention和cuDNN

- 连续批处理和PagedAttention支持

- 前缀缓存

- 设备映射:在设备和CPU上分层加载和运行

量化支持

- GGML:2-bit到8-bit量化,支持ISQ

- GPTQ:2-bit、3-bit、4-bit和8-bit量化

- HQQ:4-bit和8-bit量化,支持ISQ

- ISQ(原位量化):直接从Hugging Face Hub运行.safetensors模型

易用性

- 轻量级兼容OpenAI API的HTTP服务器

- Python API

- 支持正则表达式和Yacc的语法

- 使用YAML文件配置ISQ和设备映射

强大功能

- 快速LoRA支持

- X-LoRA推理支持

- 投机解码

- 动态LoRA适配器切换

- AnyMoE:快速构建内存高效的MoE模型

- PagedAttention

- 多种采样和惩罚技术

- 工具调用

- 提示分块

- 自定义logits处理器API

快速开始

- 安装:

pip install mistralrs

-

下载模型:

- 从Hugging Face Hub自动下载

- 或使用本地GGUF模型文件

-

使用Python API:

from mistralrs import MistralRS

llm = MistralRS(model="mistralai/Mistral-7B-v0.1")

response = llm.generate("Hello, how are you?")

print(response)

- 或使用HTTP服务器:

mistralrs_server --port 8000 plain -m mistralai/Mistral-7B-v0.1

然后可以通过HTTP请求使用模型。

支持的模型和加速器

mistral.rs支持多种流行的LLM模型,如Mistral、LLama、Phi等。支持的加速器包括:

- CUDA(支持Flash Attention)

- Metal

- CPU(支持MKL和Accelerate)

结语

mistral.rs为LLM推理提供了一个高性能、易用的平台。无论您是想在本地运行模型,还是构建AI应用,mistral.rs都是一个值得尝试的强大工具。欢迎访问GitHub仓库了解更多信息并参与贡献。

文章链接:www.dongaigc.com/p/EricLBuehler/mistral.rs

https://www.dongaigc.com/p/EricLBuehler/mistral.rs

www.dongaigc.com/a/mistral-rs-beginners-guide-efficient-llm

https://www.dongaigc.com/a/mistral-rs-beginners-guide-efficient-llm

1427

1427

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?