DN-DETR:引入查询去噪加速DETR训练

DN-DETR(Denoising DETR)是由来自香港科技大学(广州)和微软亚洲研究院的研究人员提出的一种新型目标检测模型。该模型在DETR(DEtection TRansformer)的基础上引入了查询去噪(Query DeNoising)训练方法,显著提高了训练速度和检测性能。本文将详细介绍DN-DETR的核心思想、主要创新点以及在目标检测领域的重要意义。

背景介绍

近年来,基于Transformer的目标检测模型DETR因其端到端的设计和简洁的pipeline而备受关注。然而,DETR也存在训练收敛速度慢的问题,这严重限制了其在实际应用中的推广。DN-DETR正是为解决这一问题而提出的。

DN-DETR的核心思想

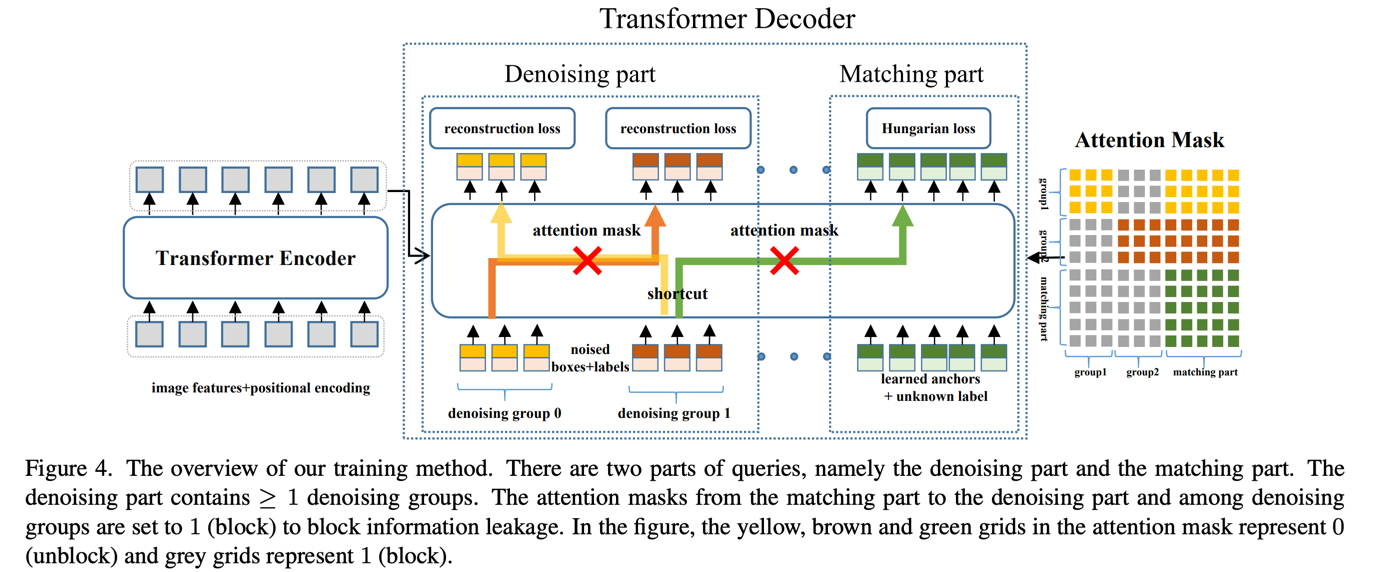

DN-DETR的核心创新在于引入了查询去噪训练方法。具体来说,该方法在训练过程中除了使用匈牙利损失外,还向Transformer解码器输入带有噪声的真实边界框,并训练模型重构原始边界框。这一设计有效降低了二分图匹配的难度,从而加快了模型的收敛速度。

如上图所示,DN-DETR在DAB-DETR的基础上增加了去噪部分,只需添加少量计算即可显著提升训练效果。值得注意的是,这些额外的计算只在训练阶段使用,不会影响推理速度。

DN-DETR的主要优势

-

训练速度显著提升:与基线模型相比,DN-DETR在相同设置下可以用50%的训练轮数达到相当的性能。

-

检测精度大幅提高:使用ResNet-50主干网络,DN-DETR在12轮和50轮训练后分别达到了43.4 AP和48.6 AP,相比基线模型提升了1.9 AP。

-

通用性强:DN-DETR的去噪训练方法可以轻松应用于其他DETR类模型,甚至传统的检测模型中,只需添加几十行代码即可实现显著的性能提升。

-

深入理解DETR收敛问题:DN-DETR的研究为理解DETR类方法收敛缓慢的原因提供了新的视角,指出这一问题源于早期训练阶段二分图匹配的不稳定性导致的优化目标不一致。

实验结果与分析

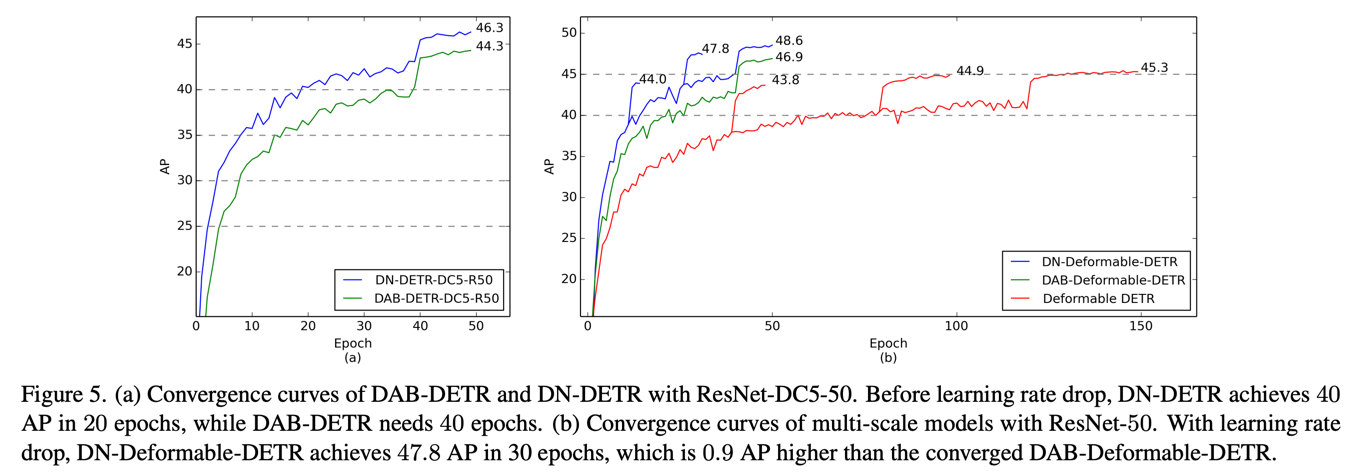

研究者进行了广泛的实验来验证DN-DETR的有效性。下图展示了DN-DETR与其他模型在收敛速度上的对比:

从图中可以清楚地看到,DN-DETR的收敛速度远快于其他模型,并且最终达到了更高的精度。

此外,研究者还在多个数据集和不同主干网络上进行了实验,结果consistently证明了DN-DETR的优越性。例如,使用ResNet-50主干网络,DN-Deformable-DETR在COCO数据集上达到了49.5 AP的优秀性能。

DN-DETR的广泛应用

DN-DETR不仅仅是一个独立的模型,更是一种可以广泛应用的训练方法。研究者将这一方法应用到了多个领域:

- CNN-based模型:如Faster R-CNN

- 分割模型:如Mask2Former

- 其他DETR类模型:如Anchor DETR和原始DETR

在所有这些模型中,引入查询去噪训练都带来了显著的性能提升,证明了该方法的普适性和有效性。

DN-DETR的实现与使用

DN-DETR的代码已在GitHub上开源(https://github.com/IDEA-Research/DN-DETR)。研究者提供了详细的安装指南和使用说明,使得其他研究者和开发者能够轻松地复现结果和应用这一方法。

主要的去噪训练组件被封装在dn_components.py文件中,包含三个核心函数:

prepare_for_dn: 准备去噪输入dn_post_process: 处理去噪输出compute_dn_loss: 计算去噪损失

通过导入这些函数并将它们添加到现有的检测模型中,研究者可以轻松地实现去噪训练。

DN-DETR的影响与展望

DN-DETR的提出不仅解决了DETR训练速度慢的问题,还为目标检测领域带来了新的研究方向。它的成功启发了后续一系列工作,如DINO(DETR with Improved DeNoising Anchor Boxes),进一步推动了基于Transformer的目标检测技术的发展。

未来,DN-DETR的思想有望被应用到更多的计算机视觉任务中,如实例分割、语义分割等。同时,研究者也在探索如何进一步优化去噪训练方法,以适应不同的场景和需求。

结论

DN-DETR通过巧妙的查询去噪训练方法,成功解决了DETR收敛缓慢的问题,显著提升了训练效率和检测性能。这一工作不仅推动了目标检测技术的进步,也为深度学习模型训练提供了新的思路。随着进一步的研究和应用,DN-DETR及其衍生方法有望在计算机视觉领域发挥更大的作用,为人工智能的发展做出重要贡献。

引用

如果您的研究工作中使用了DN-DETR,请考虑引用以下论文:

@inproceedings{li2022dn,

title={Dn-detr: Accelerate detr training by introducing query denoising},

author={Li, Feng and Zhang, Hao and Liu, Shilong and Guo, Jian and Ni, Lionel M and Zhang, Lei},

booktitle={Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition},

pages={13619--13627},

year={2022}

}

通过持续的创新和优化,DN-DETR为基于Transformer的目标检测开辟了新的可能性,相信在未来会有更多令人兴奋的进展出现在这个领域。让我们共同期待DN-DETR及其衍生技术在实际应用中发挥更大的价值,推动人工智能技术的进步与发展。

文章链接:www.dongaigc.com/a/dn-detr-query-denoising-accelerate-training

https://www.dongaigc.com/a/dn-detr-query-denoising-accelerate-training

5005

5005

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?