YOLO系列

YOLO-V1是经典的one-stage目标检测方法 ,名字“You Only Look Once”表明其检测方式是一次就能完成目标检测。它将目标检测问题转化为回归问题,利用一个卷积神经网络(CNN)就能实现。该算法可以对视频进行实时检测,应用范围广泛,如安防监控、自动驾驶等

图片中有一个图表,对比了不同目标检测算法在不同时间的平均精度均值(mAP)和每秒帧数(FPS)。YOLO-V1在2015年推出,其FPS为45,mAP为63.4,与其他算法如R-CNN、Fast R-CNN、Faster R-CNN、SSD等进行了性能对比。

核心思想

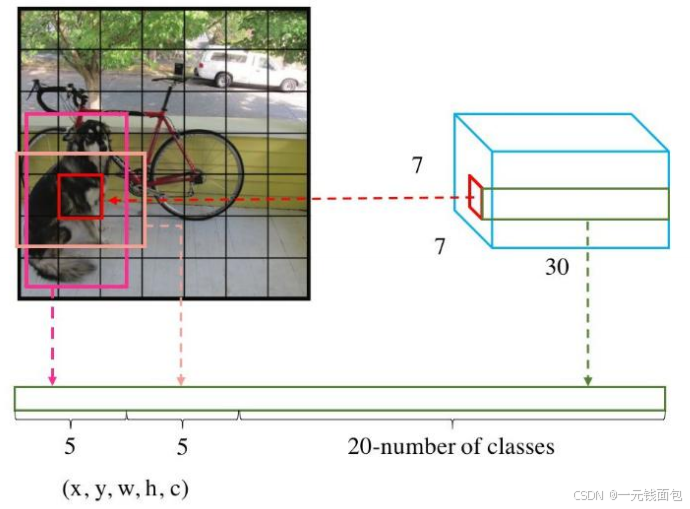

采用将输入图像划分为5×5的网格(5×5 grid on input),每个网格负责预测目标的边界框(Bounding boxes)及其置信度(confidence),最后通过类别概率图(Class probability map)得出最终的检测结果(Final detections) ,确定图像中的目标位置和类别。

网络架构

输入图像经一系列卷积层(Convolutional)和全连接层(Fully Connected)处理,输出张量(Tensor)。每个网格单元(grid cell)会预测两个边界框(two boxes for each grid cell),通过对张量值解读来确定目标位置和类别。

数字含义

“10 =(X,Y,H,W,C)*B (2个)”:每个边界框有5个参数(中心坐标X、Y,宽高H、W,置信度C),B为每个网格预测框数量,这里是2,所以每个网格对应10个参数。

“当前数据集中有20个类别 ”:算法可检测20种不同目标类别。

“7*7表示最终网格的大小 ”:图像被划分为7×7的网格,每个网格负责预测目标。

“(SS) * (B5+C)” :是输出张量维度计算公式,S为网格边长,B是每个网格预测框数,C是类别数 。

损失函数

用于衡量预测值与真实值差距。包含位置误差(预测框位置与真实框位置差距)、置信度误差(分为含目标和不含目标的置信度误差,衡量预测框含目标的置信度准确性)、分类误差(预测类别与真实类别的误差) ,通过不同权重(λ)调整各项误差对总损失影响。

NMS(非极大值抑制)

图片展示了一幅有人脸检测框的示例图,每个检测框旁有置信度数值。NMS是一种后处理技术,在目标检测中,针对同一目标可能出现多个重叠检测框的情况,通过比较置信度,保留置信度最高的框,抑制其他重叠框,从而得到更准确、不重复的目标检测结果。

YOLO-V1

优点:算法运行快速,结构简单,易于理解和实现。

问题:其一,每个网格单元(Cell)只能预测一个类别,当多个不同类别目标在同一网格重叠时,无法准确处理;其二,对小物体的检测效果欠佳,且预测框的长宽比虽然可选,但相对单一,灵活性不足。

YOLO-V2:更快!更强!

性能对比:通过表格对比了YOLO和YOLO-V2在多项技术特性上的应用情况,如批量归一化(batch norm)、高分辨率分类器(hi-res classifier)等,并展示了在VOC2007数据集上的mAP指标,YOLO-V2的mAP显著高于YOLO,体现其性能优势。

批量归一化(Batch Normalization):YOLO-V2版本舍弃了Dropout,在所有卷积层后都加入了Batch Normalization。该操作对网络每一层的输入进行归一化,使网络更容易收敛,并且能提升约2%的mAP,如今Batch Normalization已成为网络的必备处理步骤。

更大的分辨率:YOLO-V1训练时使用224×224的图像,测试时用448×448,这种差异可能导致模型表现不佳。YOLO-V2在训练时额外对448×448分辨率进行了10次微调,使用高分辨率分类器后,mAP提升了约4% 。

网络结构:YOLO-V2采用DarkNet网络结构,实际输入图像尺寸为416×416。还列出了网络中各层的类型(卷积层Convolutional、最大池化层Maxpool)、滤波器数量(Filters)、尺寸/步长(Size/Stride)以及输出尺寸(Output)等信息 。

聚类提取先验框

问题:Faster-RCNN系列选择的先验框比例常规,不一定完全适合数据集。

方法:YOLO-V2采用K-means聚类算法生成先验框,其距离度量公式为d(box,centroids)=1 - IOU(box, centroids) ,即使用1减去预测框与聚类中心的交并比(IOU)来衡量距离。

Anchor Box

引入效果:通过引入Anchor Boxes,增加了预测框的数量(13*13*n),能够更灵活地检测不同大小和位置的目标。

与Faster-RCNN区别:不同于Faster-RCNN系列直接按固定长宽比给定先验框,YOLO-V2的先验框生成方式更具适应性,从数据对比来看,引入Anchor后召回率从81%提升到88%,虽然mAP从69.5略微降至69.2 。

Directed Location Prediction(直接位置预测)

原有问题:在早期的边界框(bbox)位置预测中,根据公式x = x_p + w_p * t_x,y = y_p + h_p * t_y (其中(x_p,y_p)为先验框中心,(w_p,h_p)为其宽高),如果t_x或t_y取值较大,会导致边界框大幅移动,在训练初期可能引发收敛问题,使模型不稳定。

V2改进:YOLO-V2不直接使用偏移量,而是选择相对网格单元(grid cell)的偏移量进行位置预测,计算公式为b_x = \sigma(t_x) + c_x ,通过这种方式使模型训练时的位置预测更加稳定。

感受野概念

感受野是指特征图上的点能看到原始图像的多大区域。简单来说,就是卷积神经网络中某一层输出的特征图上的一个点,对应原始输入图像中的区域大小。

通过示意图展示了输入图像经过两次卷积操作后感受野的变化。堆叠3个3×3的卷积层(滑动窗口步长为1),其感受野与一个7×7卷积核的结果相同。

YOLO-V2的细粒度特征(Fine-Grained Features)

在YOLO-V2中,由于网络最后一层的感受野过大,小目标的信息可能在特征提取过程中丢失。为解决这个问题,需要融合之前层的特征。通过示意图可以看到,先对特征进行池化和卷积操作,然后将特征拆分,再经过passthrough层进行叠加,最终输出融合后的特征,以此来保留小目标的细节信息,提升对小目标的检测能力。

多尺度训练(Multi-Scale)

YOLO-V2利用卷积操作对输入图像尺寸不敏感的特性,在一定训练迭代次数(iterations)后改变输入图片的大小。最小图像尺寸为320×320,最大为608×608 。通过这种多尺度训练的方式,模型能够适应不同大小的目标,增强模型的泛化能力,使其在各种分辨率的图像上都能有较好的检测效果

825

825

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?