1、入门

为了方便管理我们一般统一软件的安装目录,这里选择安装的目录是 ->

/usr/local/soft

我们通过wget命令从redis官网下载压缩包 -> Redis

当前最新版本下载地址 -> https://download.redis.io/releases/redis-6.2.4.tar.gz

- cd /usr/local/soft

- wget https://download.redis.io/releases/

tar -zxvf redis-6.2.4.tar.gz

Redis是C语言编写,编译需要GCC

Redis6.x.x版本支持了多线程,需要gcc的版本大于4.9,我们需要查看默认GCC版本,如果版本过低则需要升级

gcc -v

我的新安装的虚拟机CentOS显示 ->

证明我的没有安装gcc,安装gcc ->

yum install gcc

再次查看安装后的版本,发现是4.8.5,这个是CentOS默认的版本,我们需要对gcc进行升级 ->

- yum -y install centos-release-scl

- yum -y install devtoolset-9-gcc devtoolset-9-gcc-c++ devtoolset-9-binutils

- scl enable devtoolset-9 bash

- echo "source /opt/rh/devtoolset-9/enable" >>/etc/profile

查看升级后的版本 ->

- cd redis-6.2.4/src

- make install

编译过程如下 ->

看到如下结果输出则编译成功 ->

或者在src目录下出现服务端和客户端的脚本 ->

- redis-sentinel

- redis-server

- redis-cli

Redis的配置文件在解压目录下的 redis.conf

1.1.6.1 首先设置后台启动,防止窗口一关闭服务就挂掉

默认后台启动参数为 no->

- # By default Redis does not run as a daemon. Use 'yes' if you need it.

- # Note that Redis will write a pid file in /var/run/redis.pid when daemonized.

- # When Redis is supervised by upstart or systemd, this parameter has no impact.

- daemonize no

修改成 yes->

- # By default Redis does not run as a daemon. Use 'yes' if you need it.

- # Note that Redis will write a pid file in /var/run/redis.pid when daemonized.

- # When Redis is supervised by upstart or systemd, this parameter has no impact.

- daemonize yes

1.1.6.2 允许其他主机访问

根据Redis的文档配置注释,我们要运行其他主机访问有多种方式 ->

- 可以选择配置访问主机的IP address

- bind * -::* 相当于允许所有其它主机访问

- bind 0.0.0.0 相当于允许所有其它主机访问

- 直接注释 相当于允许所有其它主机访问

- # bind 192.168.1.100 10.0.0.1 # listens on two specific IPv4 addresses

- # bind 127.0.0.1 ::1 # listens on loopback IPv4 and IPv6

- # bind * -::* # like the default, all available interfaces

我的处理方式,安装文档的注释来配置

1.1.6.3 配置访问密码

如果是要考虑安全性,一定要配置密码,找到requirepass配置处,新增如下配置(阿里云等云服务其外网访问一定要配置,作者被黑过,整台服务器重启都无法重启,损失惨重,但是穷,官方处理需要Money,建议这里一定要谨慎)

requirepass yourpassword

使用redis-server 来启动,启动的方式如下->

/usr/local/soft/redis-6.2.4/src/redis-server /usr/local/soft/redis-6.2.4/redis.conf

或者这个也一样 ->

- cd /src

- redis-server ../redis.conf

查看端口是否启动成功 ->

netstat -an|grep 6379

进入客户端的方式如下 ->

/usr/local/soft/redis-6.2.4/src/redis-cli

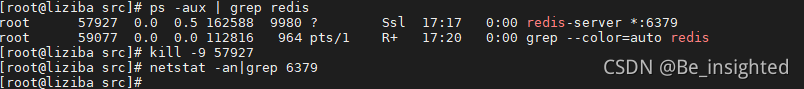

停止Redis有两种方式 :

方式一,在客户端中执行SHUTDOWN

SHUTDOWN

![]()

方式二,暴力kill -9

- ps -aux | grep redis

- kill -9 57927

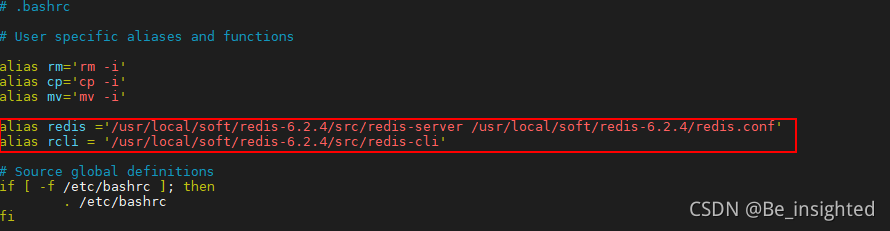

为了方便启动Redis和进入客户端,我们可以通过配置别名来实现

vim ~/.bashrc

添加如下配置,

- 注意''很重要

- redis与rcli后面的=两边不能有空格

- alias redis='/usr/local/soft/redis-6.2.4/src/redis-server /usr/local/soft/redis-6.2.4/redis.conf'

- alias rcli='/usr/local/soft/redis-6.2.4/src/redis-cli'

使配置生效

source ~/.bashrc

现在我们可以通过redis启动Redis服务,使用rcli进入Redis客户端

Redis中所有的的数据结构都是通过一个唯一的字符串key来获取相应的value数据。

Redis有5种基础数据结构,分别是:

- string(字符串)

- list(列表)

- hash(字典)

- set(集合)

- zset(有序集合)

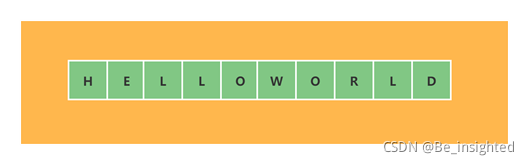

本小结讲述的是Redis的5种基础数据结构中的string(字符串)

2.1.2.1 string(字符串)的内部结构

string(字符串)是Redis最简单也是使用最广泛的数据结构,它的内部是一个字符数组。如图所示:

Redis中string(字符串)是动态字符串,允许修改;它在结构上的实现类似于Java中的ArrayList(默认构造一个大小为10的初始数组),这是冗余分配内存的思想,也称为预分配;这种思想可以减少扩容带来的性能消耗。

2.1.2.2 string(字符串)的扩容

当string(字符串)的大小达到扩容阈值时,将会对string(字符串)进行扩容,string(字符串)的扩容主要有以下几个点:

- 长度小于1MB,扩容后为原先的两倍; length = length * 2

- 长度大于1MB,扩容后增加1MB; length = length + 1MB

- 字符串的长度最大值为 512MB

2.1.3.1 单个键值对增删改查操作

set -> key 不存在则新增,存在则修改

set key value

get -> 查询,返回对应key的value,不存在返回(nil)

get key

del -> 删除指定的key(key可以是多个)

del key [key …]

示例:

- 127.0.0.1:6379> set name liziba

- OK

- 127.0.0.1:6379> get name

- "liziba"

- 127.0.0.1:6379> set name liziba001

- OK

- 127.0.0.1:6379> get name

- "liziba001"

- 127.0.0.1:6379> del name

- (integer) 1

- 127.0.0.1:6379> get name

- (nil)

2.1.3.2 批量键值对

批量键值读取和写入最大的优势在于节省网络传输开销

mset -> 批量插入

mset key value [key value …]

mget -> 批量获取

mget key [key …]

示例:

- 127.0.0.1:6379> mset name1 liziba1 name2 liziba2 name3 liziba3

- OK

- 127.0.0.1:6379> mget name1 name2 name3

- 1) "liziba1"

- 2) "liziba2"

- 3) "liziba3"

2.1.3.3 过期set命令

过期set是通过设置一个缓存key的过期时间,使得缓存到期后自动删除从而失效的机制。

方式一:

expire key seconds

示例:

- 127.0.0.1:6379> set name liziba

- OK

- 127.0.0.1:6379> get name

- "liziba"

- 127.0.0.1:6379> expire name 10 # 10s 后get name 返回 nil

- (integer) 1

- 127.0.0.1:6379> get name

- (nil)

方式二:

setex key seconds value

示例:

- 127.0.0.1:6379> setex name 10 liziba # 10s 后get name 返回 nil

- OK

- 127.0.0.1:6379> get name

- (nil)

2.1.3.4 不存在创建存在不更新

上面的set操作不存在创建,存在则更新;此时如果需要存在不更新的场景,那么可以使用如下这个指令

setnx -> 不存在创建存在不更新

setnx key value

示例:

- 127.0.0.1:6379> get name

- (nil)

- 127.0.0.1:6379> setnx name liziba

- (integer) 1

- 127.0.0.1:6379> get name

- "liziba"

- 127.0.0.1:6379> setnx name liziba_98 # 已经存在再次设值,失败

- (integer) 0

- 127.0.0.1:6379> get name

- "liziba"

2.1.3.5计数

string(字符串)也可以用来计数,前提是value是一个整数,那么可以对它进行自增的操作。自增的范围必须在signed long的区间访问内,[-9223372036854775808,9223372036854775808]

2.1.3.5.1 incr -> 自增1

incr key

示例:

- 127.0.0.1:6379> set fans 1000

- OK

- 127.0.0.1:6379> incr fans # 自增1

- (integer) 1001

2.1.3.5.2 incrby -> 自定义累加值

incrby key increment

- 127.0.0.1:6379> set fans 1000

- OK

- 127.0.0.1:6379> incr fans

- (integer) 1001

- 127.0.0.1:6379> incrby fans 999

- (integer) 2000

2.1.3.5.3 测试value为整数的自增区间

最大值:

- 127.0.0.1:6379> set fans 9223372036854775808

- OK

- 127.0.0.1:6379> incr fans

- (error) ERR value is not an integer or out of range

最小值:

- 127.0.0.1:6379> set money -9223372036854775808

- OK

- 127.0.0.1:6379> incrby money -1

- (error) ERR increment or decrement would overflow

Redis中所有的的数据结构都是通过一个唯一的字符串key来获取相应的value数据。

Redis有5种基础数据结构,分别是:

- string(字符串)

- list(列表)

- hash(字典)

- set(集合)

- zset(有序集合)

其中list、set、hash、zset这四种数据结构是容器型数据结构,它们共享下面两条通用规则:

- create if not exists:容器不存在则创建

- drop if no elements:如果容器中没有元素,则立即删除容器,释放内存

本小结讲述的是Redis的5种基础数据结构中的list(列表)

2.2.2.1 list(列表)的内部结构

Redis的列表相当于Java语言中的LinkedList,它是一个双向链表数据结构(但是这个结构设计比较巧妙,后面会介绍),支持前后顺序遍历。链表结构插入和删除操作快,时间复杂度O(1),查询慢,时间复杂度O(n)。

2.2.2.2 list(列表)的使用场景

根据Redis双向列表的特性,因此其也被用于异步队列的使用。实际开发中将需要延后处理的任务结构体序列化成字符串,放入Redis的队列中,另一个线程从这个列表中获取数据进行后续处理。其流程类似如下的图:

2.2.3.1 右进左出—队列

队列在结构上是先进先出(FIFO)的数据结构(比如排队购票的顺序),常用于消息队列类似的功能,例如消息排队、异步处理等场景。通过它可以确保元素的访问顺序。

lpush -> 从左边边添加元素

lpush key value [value …]

rpush -> 从右边添加元素

rpush key value [value …]

llen -> 获取列表的长度

llen key

lpop -> 从左边弹出元素

lpop key

- 127.0.0.1:6379> rpush code java c python # 向列表中添加元素

- (integer) 3

- 127.0.0.1:6379> llen code # 获取列表长度

- (integer) 3

- 127.0.0.1:6379> lpop code # 弹出最先添加的元素

- "java"

- 127.0.0.1:6379> lpop code

- "c"

- 127.0.0.1:6379> lpop code

- "python"

- 127.0.0.1:6379> llen code

- (integer) 0

- 127.0.0.1:6379> lpop code

- (nil)

2.2.3.2 右进右出——栈

栈在结构上是先进后出(FILO)的数据结构(比如弹夹压入子弹,子弹被射击出去的顺序就是栈),这种数据结构一般用来逆序输出。

lpush -> 从左边边添加元素

lpush key value [value …]

rpush -> 从右边添加元素

rpush key value [value …]

rpop -> 从右边弹出元素

rpop code

- 127.0.0.1:6379> rpush code java c python

- (integer) 3

- 127.0.0.1:6379> rpop code # 弹出最后添加的元素

- "python"

- 127.0.0.1:6379> rpop code

- "c"

- 127.0.0.1:6379> rpop code

- "java"

- 127.0.0.1:6379> rpop code

- (nil)

2.2.3.3 慢操作

列表(list)是个链表数据结构,它的遍历是慢操作,所以涉及到遍历的性能将会遍历区间range的增大而增大。注意list的索引运行为负数,-1代表倒数第一个,-2代表倒数第二个,其它同理。

lindex -> 遍历获取列表指定索引处的值

lindex key ind

lrange -> 获取从索引start到stop处的全部值

lrange key start stop

ltrim -> 截取索引start到stop处的全部值,其它将会被删除

ltrim key start stop

- 127.0.0.1:6379> rpush code java c python

- (integer) 3

- 127.0.0.1:6379> lindex code 0 # 获取索引为0的数据

- "java"

- 127.0.0.1:6379> lindex code 1 # 获取索引为1的数据

- "c"

- 127.0.0.1:6379> lindex code 2 # 获取索引为2的数据

- "python"

- 127.0.0.1:6379> lrange code 0 -1 # 获取全部 0 到倒数第一个数据 == 获取全部数据

- 1) "java"

- 2) "c"

- 3) "python"

- 127.0.0.1:6379> ltrim code 0 -1 # 截取并保理 0 到 -1 的数据 == 保理全部

- OK

- 127.0.0.1:6379> lrange code 0 -1

- 1) "java"

- 2) "c"

- 3) "python"

- 127.0.0.1:6379> ltrim code 1 -1 # 截取并保理 1 到 -1 的数据 == 移除了索引为0的数据 java

- OK

- 127.0.0.1:6379> lrange code 0 -1

- 1) "c"

- 2) "python"

Redis底层存储list(列表)不是一个简单的LinkedList,而是quicklist ——“快速列表”。关于quicklist是什么,下面会简单介绍,具体源码我也还在学习中,后面大家一起探讨。

quicklist是多个ziplist(压缩列表)组成的双向列表;而这个ziplist(压缩列表)又是什么呢?ziplist指的是一块连续的内存存储空间,Redis底层对于list(列表)的存储,当元素个数少的时候,它会使用一块连续的内存空间来存储,这样可以减少每个元素增加prev和next指针带来的内存消耗,最重要的是可以减少内存碎片化问题。

2.2.4.1 常见的链表结构示意图

每个node节点元素,都会持有一个prev->执行前一个node节点和next->指向后一个node节点的指针(引用),这种结构虽然支持前后顺序遍历,但是也带来了不小的内存开销,如果node节点仅仅是一个int类型的值,那么可想而知,引用的内存比例将会更大。

2.2.4.2 ziplist示意图

ziplist是一块连续的内存地址,他们之间无需持有prev和next指针,能通过地址顺序寻址访问。

2.2.4.3 quicklist示意图

quicklist是由多个ziplist组成的双向链表。

Redis中所有的的数据结构都是通过一个唯一的字符串key来获取相应的value数据。

Redis有5种基础数据结构,分别是:

- string(字符串)

- list(列表)

- hash(字典)

- set(集合)

- zset(有序集合)

其中list、set、hash、zset这四种数据结构是容器型数据结构,它们共享下面两条通用规则:

- create if not exists:容器不存在则创建

- drop if no elements:如果容器中没有元素,则立即删除容器,释放内存

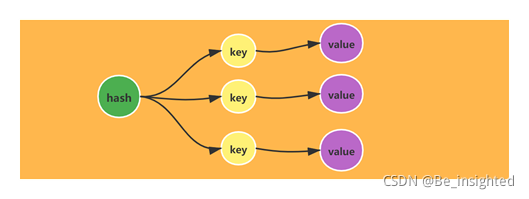

本小节讲述的是Redis的5种基础数据结构中的hash(字典)

2.3.2.1 hash(字典)的内部结构

Redis的hash(字典)相当于Java语言中的HashMap,它是根据散列值分布的无序字典,内部的元素是通过键值对的方式存储。

hash(字典)的实现与Java中的HashMap(JDK1.7)的结构也是一致的,它的数据结构也是数组+链表组成的二维结构,节点元素散列在数组上,如果发生hash碰撞则使用链表串联在数组节点上。

2.3.2.2 hash(字典)扩容

Redis中的hash(字典)存储的value只能是字符串值,此外扩容与Java中的HashMap也不同。Java中的HashMap在扩容的时候是一次性完成的,而Redis考虑到其核心存取是单线程的性能问题,为了追求高性能,因而采取了渐进式rehash策略。

渐进式rehash指的是并非一次性完成,它是多次完成的,因此需要保理旧的hash结构,所以Redis中的hash(字典)会存在新旧两个hash结构,在rehash结束后也就是旧hash的值全部搬迁到新hash之后,新的hash在功能上才会完全替代以前的hash。

2.3.2.3 hash(字典)的相关使用场景

hash(字典)可以用来存储对象的相关信息,一个hash(字典)代表一个对象,hash的一个key代表对象的一个属性,key的值代表属性的值。hash(字典)结构相比字符串来说,它无需将整个对象进行序列化后进行存储。这样在获取的时候可以进行部分获取。所以相比之下hash(字典)具有如下的优缺点:

- 读取可以部分读取,节省网络流量

- 存储消耗的高于单个字符串的存储

2.3.3.1 hash(字典)常用指令

hset -> hash(字典)插入值,字典不存在则创建 key代表字典名称,field 相当于 key,value是key的值

hset key field value

hmset -> 批量设值

hmset key field value [field value …]

示例:

- 7.0.0.1:6379> hset book java "Thinking in Java" # 字符串包含空格需要""包裹

- (integer) 1

- 127.0.0.1:6379> hset book python "Python code"

- (integer) 1

- 127.0.0.1:6379> hset book c "The best of c"

- (integer) 1

- 127.0.0.1:6379> hmset book go "concurrency in go" mysql "high-performance MySQL" # 批量设值

- OK

hget -> 获取字典中的指定key的value

hget key field

hgetall -> 获取字典中所有的key和value,换行输出

hgetall key

示例:

- 127.0.0.1:6379> hget book java

- "Thinking in Java"

- 127.0.0.1:6379> hgetall book

- 1) "java"

- 2) "Thinking in Java"

- 3) "python"

- 4) "Python code"

- 5) "c"

- 6) "The best of c"

hlen -> 获取指定字典的key的个数

hlen key

举例:

- 127.0.0.1:6379> hlen book

- (integer) 5

2.3.3.2 hash(字典)使用小技巧

在string(字符串)中可以使用incr和incrby对value是整数的字符串进行自加操作,在hash(字典)结构中如果单个子key是整数也可以进行自加操作。

hincrby -> 增对hash(字典)中的某个key的整数value进行自加操作

hincrby key field increment

- 127.0.0.1:6379> hset liziba money 10

- (integer) 1

- 127.0.0.1:6379> hincrby liziba money -1

- (integer) 9

- 127.0.0.1:6379> hget liziba money

- "9"

注意如果不是整数会报错。

- 127.0.0.1:6379> hset liziba money 10.1

- (integer) 1

- 127.0.0.1:6379> hincrby liziba money 1

- (error) ERR hash value is not an integer

Redis中所有的的数据结构都是通过一个唯一的字符串key来获取相应的value数据。

Redis有5种基础数据结构,分别是:

- string(字符串)

- list(列表)

- hash(字典)

- set(集合)

- zset(有序集合)

其中list、set、hash、zset这四种数据结构是容器型数据结构,它们共享下面两条通用规则:

- create if not exists:容器不存在则创建

- drop if no elements:如果容器中没有元素,则立即删除容器,释放内存

本文讲述的是Redis的5种基础数据结构中的set(集合)

2.4.2.1 set(集合)的内部结构

Redis的set(集合)相当于Java语言里的HashSet,它内部的键值对是无序的、唯一的。它的内部实现了一个所有value为null的特殊字典。

集合中的最后一个元素被移除之后,数据结构被自动删除,内存被回收。

2.4.2.2 set(集合)的使用场景

set(集合)由于其特殊去重复的功能,我们可以用来存储活动中中奖的用户的ID,这样可以保证一个用户不会中奖两次。

sadd -> 添加集合成员,key值集合名称,member值集合元素,元素不能重复

sadd key member [member …]

- 127.0.0.1:6379> sadd name zhangsan

- (integer) 1

- 127.0.0.1:6379> sadd name zhangsan # 不能重复,重复返回0

- (integer) 0

- 127.0.0.1:6379> sadd name lisi wangwu liumazi # 支持一次添加多个元素

- (integer) 3

smembers -> 查看集合中所有的元素,注意是无序的

smembers key

- 127.0.0.1:6379> smembers name # 无序输出集合中所有的元素

- 1) "lisi"

- 2) "wangwu"

- 3) "liumazi"

- 4) "zhangsan"

sismember -> 查询集合中是否包含某个元素

sismember key member

- 127.0.0.1:6379> sismember name lisi # 包含返回1

- (integer) 1

- 127.0.0.1:6379> sismember name tianqi # 不包含返回0

- (integer) 0

scard -> 获取集合的长度

scard key

- 127.0.0.1:6379> scard name

- (integer) 4

spop -> 弹出元素,count指弹出元素的个数

spop key [count]

- 127.0.0.1:6379> spop name # 默认弹出一个

- "wangwu"

- 127.0.0.1:6379> spop name 3

- 1) "lisi"

- 2) "zhangsan"

- 3) "liumazi"

Redis中所有的的数据结构都是通过一个唯一的字符串key来获取相应的value数据。

Redis有5种基础数据结构,分别是:

- string(字符串)

- list(列表)

- hash(字典)

- set(集合)

- zset(有序集合)

其中list、set、hash、zset这四种数据结构是容器型数据结构,它们共享下面两条通用规则:

- create if not exists:容器不存在则创建

- drop if no elements:如果容器中没有元素,则立即删除容器,释放内存

本文讲述的是Redis的5种基础数据结构中的zset(有序列表)

2.5.2.1 zset(有序集合)的内部结构

zset(有序集合)是Redis中最常问的数据结构。它类似于Java语言中的SortedSet和HashMap的结合体,它一方面通过set来保证内部value值的唯一性,另一方面通过value的score(权重)来进行排序。这个排序的功能是通过Skip List(跳跃列表)来实现的。

zset(有序集合)的最后一个元素value被移除后,数据结构被自动删除,内存被回收。

2.5.2.2 zset(有序集合)的相关使用场景

利用zset的去重和有序的效果可以由很多使用场景,举两个例子:

- 存储粉丝列表,value是粉丝的ID,score是关注时间戳,这样可以对粉丝关注进行排序

- 存储学生成绩,value使学生的ID,score是学生的成绩,这样可以对学生的成绩排名

1、zadd -> 向集合中添加元素,集合不存在则新建,key代表zset集合名称,score代表元素的权重,member代表元素

zadd key [NX|XX] [CH] [INCR] score member [score member …]

- 127.0.0.1:6379> zadd name 10 zhangsan

- (integer) 1

- 127.0.0.1:6379> zadd name 10.1 lisi

- (integer) 1

- 127.0.0.1:6379> zadd name 9.9 wangwu

- (integer) 1

2、zrange -> 按照score权重从小到大排序输出集合中的元素,权重相同则按照value的字典顺序排序(lexicographical order )

超出范围的下标并不会引起错误。 比如说,当 start 的值比有序集的最大下标还要大,或是 start > stop 时, zrange 命令只是简单地返回一个空列表。 另一方面,假如 stop 参数的值比有序集的最大下标还要大,那么 Redis 将 stop 当作最大下标来处理。

可以通过使用 WITHSCORES 选项,来让成员和它的 score 值一并返回,返回列表以 value1,score1, …, valueN,scoreN 的格式表示。 客户端库可能会返回一些更复杂的数据类型,比如数组、元组等。

zrange key start stop [WITHSCORES]

- 127.0.0.1:6379> zrange name 0 -1 # 获取所有元素,按照score的升序输出

- 1) "wangwu"

- 2) "zhangsan"

- 3) "lisi"

- 127.0.0.1:6379> zrange name 0 1 # 获取第一个和第二个slot的元素

- 1) "wangwu"

- 2) "zhangsan"

- 127.0.0.1:6379> zadd name 10 tianqi # 在上面的基础上添加score为10的元素

- (integer) 1

- 127.0.0.1:6379> zrange name 0 2 # key相等则按照value字典排序输出

- 1) "wangwu"

- 2) "tianqi"

- 3) "zhangsan"

- 127.0.0.1:6379> zrange name 0 -1 WITHSCORES # WITHSCORES 输出权重

- 1) "wangwu"

- 2) "9.9000000000000004"

- 3) "tianqi"

- 4) "10"

- 5) "zhangsan"

- 6) "10"

- 7) "lisi"

- 8) "10.1"

3、zrevrange -> 按照score权重从大到小输出集合中的元素,权重相同则按照value的字典逆序排序

其中成员的位置按 score 值递减(从大到小)来排列。 具有相同 score 值的成员按字典序的逆序(reverse lexicographical order)排列。除了成员按 score 值递减的次序排列这一点外, ZREVRANGE 命令的其他方面和 ZRANGE key start stop [WITHSCORES] 命令一样。

zrevrange key start stop [WITHSCORES]

- 127.0.0.1:6379> zrevrange name 0 -1 WITHSCORES

- 1) "lisi"

- 2) "10.1"

- 3) "zhangsan"

- 4) "10"

- 5) "tianqi"

- 6) "10"

- 7) "wangwu"

- 8) "9.9000000000000004"

4、zcard -> 当 key 存在且是有序集类型时,返回有序集的基数。 当 key 不存在时,返回 0

zcard key

- 127.0.0.1:6379> zcard name

- (integer) 4

5、zscore -> 返回有序集 key 中,成员 member 的 score 值,如果 member 元素不是有序集 key 的成员,或 key 不存在,返回 nil

zscore key member z

- 127.0.0.1:6379> zscore name zhangsan

- "10"

- 127.0.0.1:6379> zscore name liziba

- (nil)

6、zrank -> 返回有序集 key 中成员 member 的排名。其中有序集成员按 score 值递增(从小到大)顺序排列。

排名以 0 为底,也就是说, score 值最小的成员排名为 0

zrank key member

- 127.0.0.1:6379> zrange name 0 -1

- 1) "wangwu"

- 2) "tianqi"

- 3) "zhangsan"

- 4) "lisi"

- 127.0.0.1:6379> zrank name wangwu

- (integer) 0

7、zrangebyscore -> 返回有序集 key 中,所有 score 值介于 min 和 max 之间(包括等于 min 或 max )的成员。有序集成员按 score 值递增(从小到大)次序排列。

min 和 max 可以是 -inf 和 +inf ,这样一来,你就可以在不知道有序集的最低和最高 score 值的情况下,使用 *ZRANGEBYSCORE这类命令。

默认情况下,区间的取值使用闭区间 (小于等于或大于等于),你也可以通过给参数前增加 ( 符号来使用可选的开区间 (小于或大于)

zrangebyscore key min max [WITHSCORES] [LIMIT offset count]

- 127.0.0.1:6379> zrange name 0 -1 WITHSCORES # 输出全部元素

- 1) "wangwu"

- 2) "9.9000000000000004"

- 3) "tianqi"

- 4) "10"

- 5) "zhangsan"

- 6) "10"

- 7) "lisi"

- 8) "10.1"

- 127.0.0.1:6379> zrangebyscore name 9 10

- 1) "wangwu"

- 2) "tianqi"

- 3) "zhangsan"

- 127.0.0.1:6379> zrangebyscore name 9 10 WITHSCORES # 输出分数

- 1) "wangwu"

- 2) "9.9000000000000004"

- 3) "tianqi"

- 4) "10"

- 5) "zhangsan"

- 6) "10"

- 127.0.0.1:6379> zrangebyscore name -inf 10 # -inf 从负无穷开始

- 1) "wangwu"

- 2) "tianqi"

- 3) "zhangsan"

- 127.0.0.1:6379> zrangebyscore name -inf +inf # +inf 直到正无穷

- 1) "wangwu"

- 2) "tianqi"

- 3) "zhangsan"

- 4) "lisi"

- 127.0.0.1:6379> zrangebyscore name (10 11 # 10 < score <=11

- 1) "lisi"

- 127.0.0.1:6379> zrangebyscore name (10 (10.1 # 10 < socre < -11

- (empty list or set)

- 127.0.0.1:6379> zrangebyscore name (10 (11

- 1) "lisi"

8、zrem -> 移除有序集 key 中的一个或多个成员,不存在的成员将被忽略

zrem key member [member …]

- 127.0.0.1:6379> zrange name 0 -1

- 1) "wangwu"

- 2) "tianqi"

- 3) "zhangsan"

- 4) "lisi"

- 127.0.0.1:6379> zrem name zhangsan # 移除元素

- (integer) 1

- 127.0.0.1:6379> zrange name 0 -1

- 1) "wangwu"

- 2) "tianqi"

- 3) "lisi"

跳表全称叫做跳跃表,简称跳表。跳表是一个随机化的数据结构,实质就是一种可以进行二分查找的有序链表。跳表在原有的有序链表上面增加了多级索引,通过索引来实现快速查找。跳表不仅能提高搜索性能,同时也可以提高插入和删除操作的性能。

Skip List(跳跃列表)这种随机的数据结构,可以看做是一个二叉树的变种,它在性能上与红黑树、AVL树很相近;但是Skip List(跳跃列表)的实现相比前两者要简单很多,目前Redis的zset实现采用了Skip List(跳跃列表)(其它还有LevelDB等也使用了跳跃列表)。

RBT红黑树与Skip List(跳跃列表)简单对比:

RBT红黑树

- 插入、查询时间复杂度O(logn)

- 数据天然有序

- 实现复杂,设计变色、左旋右旋平衡等操作

- 需要加锁

Skip List跳跃列表

- 插入、查询时间复杂度O(logn)

- 数据天然有序

- 实现简单,链表结构

- 无需加锁

2.6.2.1 Skip List论文

这里贴出Skip List的论文,需要详细研究的请看论文,下文部分公式、代码、图片出自该论文。

Skip Lists: A Probabilistic Alternative to Balanced Trees

https://www.cl.cam.ac.uk/teaching/2005/Algorithms/skiplists.pdf

2.6.2.2 Skip List动态图

先通过一张动图来了解Skip List的插入节点元素的流程,此图来自维基百科。

2.6.2.3 Skip List算法性能分析

2.6.2.3.1 计算随机层数算法

首先分析的是执行插入操作时计算随机数的过程,这个过程会涉及层数的计算,所以十分重要。对于节点他有如下特性:

- 节点都有第一层的指针

- 节点有第i层指针,那么第i+1层出现的概率为p

- 节点有最大层数限制,MaxLevel

计算随机层数的伪代码:

论文中的示例

Java版本

- public int randomLevel(){

- int level = 1;

- // random()返回一个[0...1)的随机数

- while (random() < p && level < MaxLevel){

- level += 1;

- }

- return level;

- }

代码中包含两个变量P和MaxLevel,在Redis中这两个参数的值分别是:

- p = 1/4

- MaxLevel = 64

2.3.2 节点包含的平均指针数目

Skip List属于空间换时间的数据结构,这里的空间指的就是每个节点包含的指针数目,这一部分是额外的内内存开销,可以用来度量空间复杂度。random()是个随机数,因此产生越高的节点层数,概率越低(Redis标准源码中的晋升率数据1/4,相对来说Skip List的结构是比较扁平的,层高相对较低)。其定量分析如下:

- level = 1 概率为1-p

- level >=2 概率为p

- level = 2 概率为p(1-p)

- level >= 3 概率为p^2

- level = 3 概率为p^2(1-p)

- level >=4 概率为p^3

- level = 4 概率为p^3(1-p)

- ……

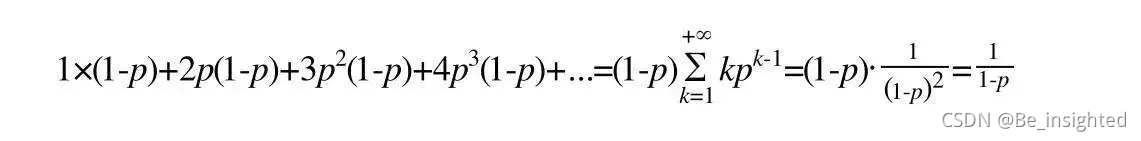

得出节点的平均层数(节点包含的平均指针数目):

所以Redis中p=1/4计算的平均指针数目为1.33

2.3.3 时间复杂度计算

以下推算来自论文内容

假设p=1/2,在以p=1/2生成的16个元素的跳过列表中,我们可能碰巧具有9个元素,1级3个元素,3个元素3级元素和1个元素14级(这不太可能,但可能会发生)。我们该怎么处理这种情况?如果我们使用标准算法并在第14级开始我们的搜索,我们将会做很多无用的工作。那么我们应该从哪里开始搜索?此时我们假设SkipList中有n个元素,第L层级元素个数的期望是1/p个;每个元素出现在L层的概率是p^(L-1), 那么第L层级元素个数的期望是 n * (p^L-1);得到1 / p =n * (p^L-1)

- 1 / p = n * (p^L-1)

- n = (1/p)^L

- L = log(1/p)^n

所以我们应该选择MaxLevel = log(1/p)^n

定义:MaxLevel = L(n) = log(1/p)^n

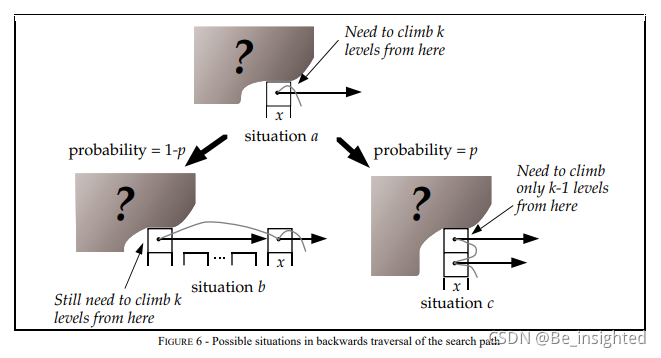

推算Skip List的时间复杂度,可以用逆向思维,从层数为i的节点x出发,返回起点的方式来回溯时间复杂度,节点x点存在两种情况:

- 节点x存在(i+1)层指针,那么向上爬一级,概率为p,对应下图situation c.

- 节点x不存在(i+1)层指针,那么向左爬一级,概率为1-p,对应下图situation b.

设C(k) = 在无限列表中向上攀升k个level的搜索路径的预期成本(即长度)那么推演如下:

- C(0)=0

- C(k)=(1-p)×(情况b的查找长度) + p×(情况c的查找长度)

- C(k)=(1-p)(C(k)+1) + p(C(k-1)+1)

- C(k)=1/p+C(k-1)

- C(k)=k/p

上面推演的结果可知,爬升k个level的预期长度为k/p,爬升一个level的长度为1/p。

由于MaxLevel = L(n), C(k) = k / p,因此期望值为:(L(n) – 1) / p;将L(n) = log(1/p)^n 代入可得:(log(1/p)^n - 1) / p;将p = 1 / 2 代入可得:2 * log2^n - 2,即O(logn)的时间复杂度。

2.6.3.1 Skip List特性

Skip List跳跃列表通常具有如下这些特性

- Skip List包含多个层,每层称为一个level,level从0开始递增

- Skip List 0层,也就是最底层,应该包含所有的元素

- 每一个level/层都是一个有序的列表

- level小的层包含level大的层的元素,也就是说元素A在X层出现,那么 想X>Z>=0的level/层都应该包含元素A

- 每个节点元素由节点key、节点value和指向当前节点所在level的指针数组组成

2.6.3.2 Skip List查询

假设初始Skip List跳跃列表中已经存在这些元素,他们分布的结构如下所示:

此时查询节点88,它的查询路线如下所示:

- 从Skip List跳跃列表最顶层level3开始,往后查询到10 < 88 && 后续节点值为null && 存在下层level2

- level2 10往后遍历,27 < 88 && 后续节点值为null && 存在下层level1

- level1 27往后遍历,88 = 88,查询命中

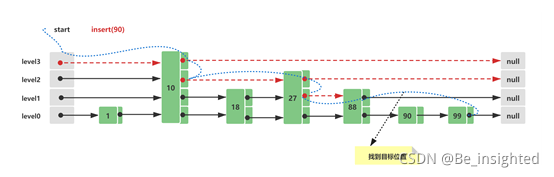

2.6.3.3 Skip List插入

Skip List的初始结构与2.3中的初始结构一致,此时假设插入的新节点元素值为90,插入路线如下所示:

- 查询插入位置,与Skip List查询方式一致,这里需要查询的是第一个比90大的节点位置,插入在这个节点的前面, 88 < 90 < 100

- 构造一个新的节点Node(90),为插入的节点Node(90)计算一个随机level,这里假设计算的是1,这个level时随机计算的,可能时1、2、3、4…均有可能,level越大的可能越小,主要看随机因子x ,层数的概率大致计算为 (1/x)^level ,如果level大于当前的最大level3,需要新增head和tail节点

- 节点构造完毕后,需要将其插入列表中,插入十分简单步骤 -> Node(88).next = Node(90); Node(90).prev = Node(80); Node(90).next = Node(100); Node(100).prev = Node(90);

2.6.3.4 Skip List删除

删除的流程就是查询到节点,然后删除,重新将删除节点左右两边的节点以链表的形式组合起来即可,这里不再画图

实现一个Skip List比较简单,主要分为两个步骤:

- 定义Skip List的节点Node,节点之间以链表的形式存储,因此节点持有相邻节点的指针,其中prev与next是同一level的前后节点的指针,down与up是同一节点的多个level的上下节点的指针

- 定义Skip List的实现类,包含节点的插入、删除、查询,其中查询操作分为升序查询和降序查询(往后和往前查询),这里实现的Skip List默认节点之间的元素是升序链表

2.6.4.1 定义Node节点

Node节点类主要包括如下重要属性:

- score -> 节点的权重,这个与Redis中的score相同,用来节点元素的排序作用

- value -> 节点存储的真实数据,只能存储String类型的数据

- prev -> 当前节点的前驱节点,同一level

- next -> 当前节点的后继节点,同一level

- down -> 当前节点的下层节点,同一节点的不同level

- up -> 当前节点的上层节点,同一节点的不同level

- package com.liziba.skiplist;

- /**

- * <p>

- * 跳表节点元素

- * </p>

- *

- * @Author: Liziba

- * @Date: 2021/7/5 21:01

- */

- public class Node {

- /** 节点的分数值,根据分数值来排序 */

- public Double score;

- /** 节点存储的真实数据 */

- public String value;

- /** 当前节点的 前、后、下、上节点的引用 */

- public Node prev, next, down, up;

- public Node(Double score) {

- this.score = score;

- prev = next = down = up = null;

- }

- public Node(Double score, String value) {

- this.score = score;

- this.value = value;

- }

- }

2.6.4.2 SkipList节点元素的操作类

SkipList主要包括如下重要属性:

- head -> SkipList中的头节点的最上层头节点(level最大的层的头节点),这个节点不存储元素,是为了构建列表和查询时做查询起始位置的,具体的结构请看2.3中的结构

- tail -> SkipList中的尾节点的最上层尾节点(level最大的层的尾节点),这个节点也不存储元素,是查询某一个level的终止标志

- level -> 总层数

- size -> Skip List中节点元素的个数

- random -> 用于随机计算节点level,如果 random.nextDouble() < 1/2则需要增加当前节点的level,如果当前节点增加的level超过了总的level则需要增加head和tail(总level)

- package com.liziba.skiplist;

- import java.util.Random;

- /**

- * <p>

- * 跳表实现

- * </p>

- *

- * @Author: Liziba

- */

- public class SkipList {

- /** 最上层头节点 */

- public Node head;

- /** 最上层尾节点 */

- public Node tail;

- /** 总层数 */

- public int level;

- /** 元素个数 */

- public int size;

- public Random random;

- public SkipList() {

- level = size = 0;

- head = new Node(null);

- tail = new Node(null);

- head.next = tail;

- tail.prev = head;

- }

- /**

- * 查询插入节点的前驱节点位置

- *

- * @param score

- * @return

- */

- public Node fidePervNode(Double score) {

- Node p = head;

- for(;;) {

- // 当前层(level)往后遍历,比较score,如果小于当前值,则往后遍历

- while (p.next.value == null && p.prev.score <= score)

- p = p.next;

- // 遍历最右节点的下一层(level)

- if (p.down != null)

- p = p.down;

- else

- break;

- }

- return p;

- }

- /**

- * 插入节点,插入位置为fidePervNode(Double score)前面

- *

- * @param score

- * @param value

- */

- public void insert(Double score, String value) {

- // 当前节点的前置节点

- Node preNode = fidePervNode(score);

- // 当前新插入的节点

- Node curNode = new Node(score, value);

- // 分数和值均相等则直接返回

- if (curNode.value != null && preNode.value != null && preNode.value.equals(curNode.value)

- && curNode.score.equals(preNode.score)) {

- return;

- }

- preNode.next = curNode;

- preNode.next.prev = curNode;

- curNode.next = preNode.next;

- curNode.prev = preNode;

- int curLevel = 0;

- while (random.nextDouble() < 1/2) {

- // 插入节点层数(level)大于等于层数(level),则新增一层(level)

- if (curLevel >= level) {

- Node newHead = new Node(null);

- Node newTail = new Node(null);

- newHead.next = newTail;

- newHead.down = head;

- newTail.prev = newHead;

- newTail.down = tail;

- head.up = newHead;

- tail.up = newTail;

- // 头尾节点指针修改为新的,确保head、tail指针一直是最上层的头尾节点

- head = newHead;

- tail = newTail;

- ++level;

- }

- while (preNode.up == null)

- preNode = preNode.prev;

- preNode = preNode.up;

- Node copy = new Node(null);

- copy.prev = preNode;

- copy.next = preNode.next;

- preNode.next.prev = copy;

- preNode.next = copy;

- copy.down = curNode;

- curNode.up = copy;

- curNode = copy;

- ++curLevel;

- }

- ++size;

- }

- /**

- * 查询指定score的节点元素

- * @param score

- * @return

- */

- public Node search(double score) {

- Node p = head;

- for (;;) {

- while (p.next.score != null && p.next.score <= score)

- p = p.next;

- if (p.down != null)

- p = p.down;

- else // 遍历到最底层

- if (p.score.equals(score))

- return p;

- return null;

- }

- }

- /**

- * 升序输出Skip List中的元素 (默认升序存储,因此从列表head往tail遍历)

- */

- public void dumpAllAsc() {

- Node p = head;

- while (p.down != null) {

- p = p.down;

- }

- while (p.next.score != null) {

- System.out.println(p.next.score + "-->" + p.next.value);

- p = p.next;

- }

- }

- /**

- * 降序输出Skip List中的元素

- */

- public void dumpAllDesc() {

- Node p = tail;

- while (p.down != null) {

- p = p.down;

- }

- while (p.prev.score != null) {

- System.out.println(p.prev.score + "-->" + p.prev.value);

- p = p.prev;

- }

- }

- /**

- * 删除Skip List中的节点元素

- * @param score

- */

- public void delete(Double score) {

- Node p = search(score);

- while (p != null) {

- p.prev.next = p.next;

- p.next.prev = p.prev;

- p = p.up;

- }

- }

- }

Bitmaps、HyperLogLog、Geospatial是Redis的三大特殊数据类型,其中Bitmaps严格来说不能算一种数据类型。Bitmaps、HyperLogLog、Geospatial能轻松的解决很多问题,也是大厂面试中经常会考究的知识点。下文详细的讲述了Bitmaps、HyperLogLog、Geospatial的原理、使用等等。有需要的可以一键三连,如果有什么问题欢迎留言交流,看到一定及时回复。

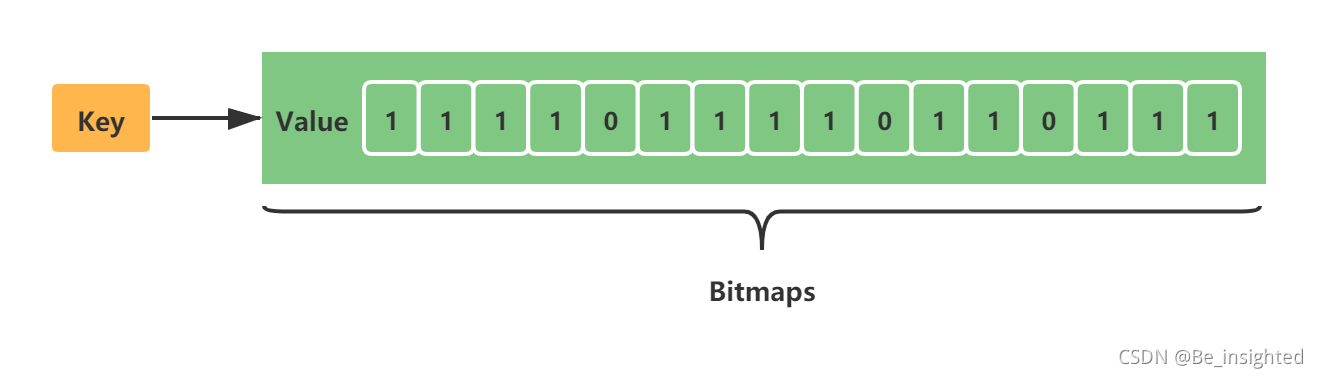

Bitmaps 称为位图,它不是一种数据类型。网上很多视频教程把Bitmaps称为数据类型,应该是不正确的。Bitmaps 是Redis提供给使用者用于操作位的“数据类型”。它主要有如下的基本特性:

- Bitmaps 不是数据类型,底层就是字符串(key-value),byte数组。我们可以使用普通的get/set直接获取和设值位图的内容,也可以通过Redis提供的位图操作getbit/setbit等将byte数组看成“位数组”来处理

- Bitmaps 的“位数组”每个单元格只能存储0和1,数组的下标在Bitmaps中称为偏移量

- Bitmaps设置时key不存在会自动生成一个新的字符串,如果设置的偏移量超出了现有内容的范围,就会自动将位数组进行零扩充。

3.1.2.1 SETBIT key offset value

对key存储的字符串,设置或者清除指定偏移量上的位(bit),位的设置或者清除取决于value参数,0/1;当key不存在时,自动生成一个新的字符串。字符串会进行伸展确保value保存在指定的偏移量上。字符串进行伸展时,空白位置以0填充。

时间复杂度 :

O(1)

offset 范围:

0~2^32

返回值:

指定偏移量原来存储的位

案例:

使用Bitmaps来存储用户是否打卡,打卡记做1,未打卡为0,用户的id作为偏移量

假设存在10个用户,此时用户1、3、5、9、10打了卡,其他人未打卡,Bitmaps的初始化结果如下所示:

clock:20210806代表2021/08/06的打卡记录

注意事项:

正式系统中,id肯定不会是0、1、2这种,而是以某一个数组开头,比如1000000000000001、1000000000000002这个时候非常容易导致偏移量的浪费,因此我们可以考虑通过计算减去一个合适的值后再设置偏移量,如果设置的Bitmaps偏移量过大,容易造成分配内存时间过长,Redis服务器被阻塞。

3.1.2.2 GETBIT key offset

获取指定偏移量上的位(bit),当offset比字符串长度大,或者key不存在,返回0;

时间复杂度:

O(1)

返回值:

字符串值指定偏移量上的位(bit)

案例:

clock:20210806代表2021/08/06的打卡记录

3.1.2.3 BITCOUNT key [start] [end]

计算给定字符串中,被设置为1的bit位的数量。start和end参数可以指定查询的范围,可以使用负数值。-1代表最后一个字节,-2代表倒是第二个字节。

注意:start和end是字节索引,因此每增加1 代表的是增加一个字符,也就是8位,所以位的查询范围必须是8的倍数。

时间复杂度:

O(N)

返回值:

被设置为1的位的数量

案例:

clock:20210806代表2021/08/06的打卡记录,此时一共11位,前8位置3个1,后3位中2个1

bitcount clock:20210806 0 0 表示第1个字符中1的个数

bitcount clock:20210806 1 1 表示第2个字符中1的个数

bitcount clock:20210806 0 1 表示第1和第2个字符中1的个数

3.1.2.4 BITPOS key bit [start] [end]

返回第一个置为bit的二进制位的位置,默认检测整个Bitmaps,也可以通过start和end参数指定查询范围

注意:start和end是字节索引,因此每增加1 代表的是增加一个字符,也就是8位,所以位的查询范围必须是8的倍数。

时间复杂度:

O(N)

返回值:

整数回复

案例:

bitpos clock:20210806 0 表示第一个0的位置

bitpos clock:20210806 1 表示第一个1的位置

bitpos clock:20210806 1 0 0 表示第一个字符中,第一个1的位置

bitpos clock:20210806 1 1 1 表示第二个字符中,第一个1的位置

bitpos clock:20210806 1 0 1 表示第一个和第二个字符中,第一个1的位置

3.1.2.5 BITOP operation destkey key [key …]

Redis的Bitmaps提供BITOP指令来对一个或多个(除了NOT操作)二进制位的字符串key进行位元操作,操作的结果保存到destkey上,operation是操作类型,有四种分别是:AND、OR、NOT、XOR

- BITOP AND destkey key [key …] ,对一个或多个 key 求逻辑并,并将结果保存到 destkey

- BITOP OR destkey key [key …] ,对一个或多个 key 求逻辑或,并将结果保存到 destkey

- BITOP XOR destkey key [key …] ,对一个或多个 key 求逻辑异或,并将结果保存到 destkey

- BITOP NOT destkey key ,对给定 key 求逻辑非,并将结果保存到 destkey

当字符串长度不一致是,较短的那个字符串所缺失的部分会被看作0,空的key也会被看作是包含0的字符串序列

时间复杂度:

O(N)

返回值:

位运算的结果(保存到destkey的字符串的长度和输入key中的最长的字符串的长度相等)

案例:

这里使用key1 1001和key2 1011进行上述四种操作

BITOP AND destkey key [key …]

运算规则:0&0=0; 0&1=0; 1&0=0; 1&1=1;

即:两位同时为“1”,结果才为“1”,否则为0

BITOP OR destkey key [key …]

运算规则:0|0=0; 0|1=1; 1|0=1; 1|1=1;

即 :参加运算的两个对象只要有一个为1,其值为1

BITOP XOR destkey key [key …]

运算规则:0^0=0; 0^1=1; 1^0=1; 1^1=0;

即:参加运算的两个对象,如果两个相应位为“异”(值不同),则该位结果为1,否则为0

BITOP NOT destkey key

运算规则:取反

3.1.2.6 BITFIELD key [GET type offset] [SET type offset value] [INCRBY type offset increment] [OVERFLOW WRAP|SAT|FAIL]

2.1和2.2中的setbit和getbit都是对指定key的单个位的操作,如果需要对多个位同时操作,那么可以使用bitfield指令,bitfield有三个子指令,分别是get、set、incrby,它们可以对指定的片段进行读写,但是最多处理64个连续的位,超过64个连续的位,需要使用多个子指令,bitfield可以同时执行多个子指令(无符号整数只能返回63位)。

注意:

- 使用 GET 子命令对超出字符串当前范围的二进制位进行访问(包括键不存在的情况), 超出部分的二进制位的值将被当做是 0 。

- 使用 SET 子命令或者 INCRBY 子命令对超出字符串当前范围的二进制位进行访问将导致字符串被扩大, 被扩大的部分会使用值为 0 的二进制位进行填充。 在对字符串进行扩展时, 命令会根据字符串目前已有的最远端二进制位, 计算出执行操作所需的最小长度。

值操作子指令:

- GET —— 返回指定的二进制位范围

- SET —— 对指定的二进制位范围进行设置,并返回它的旧值

- INCRBY —— 对指定的二进制位范围执行加法操作,并返回它的旧值。用户可以通过向 increment 参数传入负值来实现相应的减法操作

溢出策略子指令:

- WRAP:回绕/折返(wrap around)-默认溢出策略,对于无符号整数来说, 回绕就像使用数值本身与能够被储存的最大无符号整数执行取模计算, 这也是 C 语言的标准行为。 对于有符号整数来说, 上溢将导致数字重新从最小的负数开始计算, 而下溢将导致数字重新从最大的正数开始计算。

- SAT:饱和计算(saturation arithmetic),也可以理解为饱和截断,这种模式下下溢计算的结果为最小的整数值, 而上溢计算的结果为最大的整数值

- FAIL:失败不执行,这种模式会拒绝执行那些导致上溢或者下溢的计算情况,返回nil表示计算未被执行。

需要注意的是, OVERFLOW 子命令只会对紧随着它之后被执行的 INCRBY 命令产生效果, 这一效果将一直持续到与它一同被执行的下一个 OVERFLOW 命令为止。 在默认情况下, INCRBY 命令使用 WRAP 方式来处理溢出计算。

i与u:

i表示有符号整数,u表示无符号整数。u4代表4位长的无符号整数,i8代表8位长的有符号整数。

案例:

测试数字为10100111

bitfield key get u4 0 从第一个位开始取4个位,得到无符号数1010=10

![]()

bitfield key set u8 0 128 从第0个开始,将接下来的8位用无符号整数128替换,也就是10000000

bitfield key incrby u4 2 1 从第2位开始对接下来的4位无符号数+1

bitfield key set u8 0 128 get u4 0 incrby u4 2 1 复合指令,是上面三者的组成,返回值是每个操作的子集,相当于管道操作

首先抛出一个业务问题:

假设产品经理让你设计一个模块,来统计PV(Page View页面的访问量),那么你会怎么做?

我想很多人对于PV(Page View页面的访问量)的统计会很快的想到使用Redis的incr、incrby指令,给每个网页配置一个独立Redis计数器就可以了,把这个技术区的key后缀加上当它的日期,这样一个请求过来,就可以通过执行incr、incrby指令统计所有PV。

此时当你完成这个需求后,产品经理又让你设计一个模块,统计UV(Unique Visitor,独立访客),那么你又会怎么做呢?

UV与PV不一样,UV需要根据用户ID去重,如果用户没有ID我们可能需要考虑使用用户访问的IP或者其他前端穿过了的唯一标志来区分,此时你可能会想到使用如下的方案来统计UV。

- 存储在MySQL数据库表中,使用distinct count计算不重复的个数

- 使用Redis的set、hash、bitmaps等数据结构来存储,比如使用set,我们可以使用用户ID,通过sadd加入set集合即可

但是上面的两张方案都存在两个比较大的问题:

- 随着数据量的增加,存储数据的空间占用越来越大,对于非常大的页面的UV统计,基本不合实际

- 统计的性能比较慢,虽然可以通过异步方式统计,但是性能并不理想

因此针对UV的统计,我们将会考虑使用Redis的新数据类型HyperLogLog.

HyperLogLog是用来做基数统计的算法,它提供不精确的去重计数方案(这个不精确并不是非常不精确),标准误差是0.81%,对于UV这种统计来说这样的误差范围是被允许的。HyperLogLog的优点在于,输入元素的数量或者体积非常大时,基数计算的存储空间是固定的。在Redis中,每个HyperLogLog键只需要花费12KB内存,就可以计算接近2^64个不同的基数。

但是:HyperLogLog只能统计基数的大小(也就是数据集的大小,集合的个数),他不能存储元素的本身,不能向set集合那样存储元素本身,也就是说无法返回元素。

HyperLogLog指令都是pf(PF)开头,这是因为HyperLogLog的发明人是Philippe Flajolet,pf是他的名字的首字母缩写。

3.3.2.1 PFADD key element [element …]

将任意数量的元素添加到指定的 HyperLogLog 里面,当PFADD key element [element …]指令执行时,如果HyperLogLog的估计近似基数在命令执行之后出现了变化,那么命令返回1,否则返回0,如果HyperLogLog命令执行时给定的键不存在,那么程序将先创建一个空的HyperLogLog结构,再执行命令。

该命令可以只给定key不给element,这种以方式被调用时:

- 如果给定的键存在且已经是一个HyperLogLog,那么这种调用不会产生任何效果

- 如果给定的键不存在,那么命令会闯进一个空的HyperLogLog,并且给客户端返回1

返回值:

如果HyperLogLog数据结构内部存储的数据被修改了,那么返回1,否则返回0

时间复杂度:

O(1)

使用示例:

3.3.2.2 PFCOUNT key [key …]

PFCOUNT 指令后面可以跟多个key,当PFCOUNT key [key …]命令作用于单个键时,返回存储在给定键的HyperLogLog的近似基数,如果键不存在,则返回0;当PFCOUNT key [key …]命令作用于多个键时,返回所给定HyperLogLog的并集的近似基数,这个近似基数是通过将索引给定HyperLogLog合并至一个临时HyperLogLog来计算得出的。

返回值:

返回给定HyperLogLog包含的唯一元素的近似数量的整数值

时间复杂度:

当命令作用于单个HyperLogLog时,时间复杂度为O(1),并且具有非常低的平均常数时间。当命令作用于N个HyperLogLog时,时间复杂度为O(N),常数时间会比单个HyperLogLog要大的多。

使用示例:

3.3.2.3 PFMERGE destkey sourcekey [sourcekey …]

将多个HyperLogLog合并到一个HyperLogLog中,合并后HyperLogLog的基数接近于所有输入HyperLogLog的可见集合的并集,合并后得到的HyperLogLog会被存储在destkey键里面,如果该键不存在,那么命令在执行之前,会先为该键创建一个空的HyperLogLog。

返回值:

字符串回复,返回OK

时间复杂度:

O(N),其中N为被合并的HyperLogLog的数量,不过这个命令的常数复杂度比较高

使用示例:

3.3.3.1 伯努利试验

HyperLogLog的算法设计能使用12k的内存来近似的统计2^64个数据,这个和伯努利试验有很大的关系,因此在探究HyperLogLog原理之前,需要先了解一下伯努利试验。

以下是百度百科关于伯努利试验的介绍:

伯努利试验(Bernoulli experiment)是在同样的条件下重复地、相互独立地进行的一种随机试验,其特点是该随机试验只有两种可能结果:发生或者不发生。我们假设该项试验独立重复地进行了n次,那么就称这一系列重复独立的随机试验为n重伯努利试验,或称为伯努利概型。单个伯努利试验是没有多大意义的,然而,当我们反复进行伯努利试验,去观察这些试验有多少是成功的,多少是失败的,事情就变得有意义了,这些累计记录包含了很多潜在的非常有用的信息。

伯努利试验是数据概率论中的一部分,它的典故源于“抛硬币”。

一个硬币只有正面和反面,每次抛硬币出现正反面的概率都是50%,我们一直抛硬币直到出现第一次正面为止,记录抛硬币的次数,这个就被称为一次伯努利试验。伯努利试验需要做非常多的次数,数据才会变得有意义。

对于n次伯努利试验,出现正面的次数为n,假设每次伯努利试验抛掷的次数为k(也就是每次出现正面抛掷的次数),第一次伯努利试验抛掷次数为k1,第n次伯努利试验抛掷次数为kn,在这n次伯努利试验中,抛掷次数最大值为kmax。

上述的伯努利试验,结合极大似然估算方法(极大似然估计),得出n和kmax之间的估算关系:n=2^kmax。很显然这个估算关系是不准确的,例如如下案例:

第一次试验:抛掷1次出现正面,此时k=1,n=1;

第二次实验:抛掷3次出现正面,此时k=3,n=2;

第三次实验:抛掷6次出现正面,此时k=6,n=3;

第n次试验:抛掷10次出现正面,此时k=10,n=n,通过估算关系计算,n=2^10

上述案例可以看出,假设n=3,此时通过估算关系n=2^kmax,2^6 ≠3,而且偏差很大。因此得出结论,这种估算方法误差很大。

3.3.3.2 估值优化

关于上述估值偏差较大的问题,可以采用如下方式结合来缩小误差:

- 增加测试的轮数,取平均值。假设三次伯努利试验为1轮测试,我们取出这一轮试验中最大的的kmax作为本轮测试的数据,同时我们将测试的轮数定位100轮,这样我们在100轮实验中,将会得到100个kmax,此时平均数就是(k_max_1 + … + k_max_m)/m,这里m为试验的轮数,此处为100.

- 增加修正因子,修正因子是一个不固定的值,会根据实际情况来进行值的调整。

上述这种增加试验轮数,去kmax的平均值的方法,是LogLog算法的实现。因此LogLog它的估算公式如下:

HyperLogLog与LogLog的区别在于HyperLogLog使用的是调和平均数,并非平均数。调和平均数指的是倒数的平均数(调和平均数)。调和平均数相比平均数能降低最大值对平均值的影响,这个就好比我和马爸爸两个人一起算平均工资,如果用平均值这么一下来我也是年薪数十亿,这样肯定是不合理的。

使用平均数和调和平均数计算方式如下:

假设我的工资20000,马云1000000000

使用平均数的计算方式:(20000 + 1000000000) / 2 = 500010000

调和平均数的计算方式:2/(1/20000 + 1/1000000000) ≈ 40000

很明显,平均工资月薪40000更加符合实际平均值,5个亿不现实。

调和平均数的基本计算公式如下:

3.3.3.3 HyperLogLog的实现

根据3.1和3.2大致可以知道HyperLogLog的实现原理了,它的主要精髓在于通过记录下低位连续零位的最大长度K(也就是上面我们说的kmax),来估算随机数的数量n。

任何值在计算机中我们都可以将其转换为比特串,也就是0和1组成的bit数组,我们从这个bit串的低位开始计算,直到出现第一个1为止,这就好比上面的伯努利试验抛硬币,一直抛硬币直到出现第一个正面为止(只是这里是数字0和1,伯努利试验中使用的硬币的正与反,并没有区别)。而HyperLogLog估算的随机数的数量,比如我们统计的UV,就好比伯努利试验中试验的次数。

综上所述,HyperLogLog的实现主要分为三步:

第一步:转为比特串

通过hash函数,将输入的数据装换为比特串,比特串中的0和1可以类比为硬币的正与反,这是实现估值统计的第一步

第二步:分桶

分桶就是上面3.2估值优化中的分多轮,这样做的的好处可以使估值更加准确。在计算机中,分桶通过一个单位是bit,长度为L的大数组S,将数组S平均分为m组,m的值就是多少轮,每组所占有的比特个数是相同的,设为 P。得出如下关系:

- L = S.length

- L = m * p

- 数组S的内存 = L / 8 / 1024 (KB)

在HyperLogLog中,我们都知道它需要12KB的内存来做基数统计,原因就是HyperLogLog中m=16834,p=6,L=16834 * 6,因此内存为=16834 * 6 / 8 / 1024 = 12 (KB),这里为何是6位来存储kmax,因为6位可以存储的最大值为64,现在计算机都是64位或32位操作系统,因此6位最节省内存,又能满足需求。

第三步:桶分配

最后就是不同的数据该如何分配桶,我们通过计算hash的方式得到比特串,只要hash函数足够好,就很难产生hash碰撞,我们假设不同的数值计算得到不同的hash值,相同的数值得到相同的hash值(这也是HyperLogLog能用来统计UV的一个关键点),此时我们需要计算值应该放到那个桶中,可以计算的方式很多,比如取值的低16位作为桶索引值,或者采用值取模的方式等等。

3.3.3.4 代码实现-BernoulliExperiment(伯努利试验)

首先来写一个3.1中伯努利试验n=2^kmax的估算值验证,这个估算值相对偏差会比较大,在试验轮次增加时估算值的偏差会有一定幅度的减小,其代码示例如下:

- package com.lizba.pf;

- import java.util.concurrent.ThreadLocalRandom;

- /**

- * <p>

- * 伯努利试验 中基数n与kmax之间的关系 n = 2^kmax

- * </p>

- *

- * @Author: Liziba

- * @Date: 2021/8/17 23:16

- */

- public class BernoulliExperimentTest {

- static class BitKeeper {

- /** 记录最大的低位0的长度 */

- private int kmax;

- public void random() {

- // 生成随机数

- long value = ThreadLocalRandom.current().nextLong(2L << 32);

- int len = this.lowZerosMaxLength(value);

- if (len > kmax) {

- kmax = len;

- }

- }

- /**

- * 计算低位0的长度

- * 这里如果不理解看下我的注释

- * value >> i 表示将value右移i, 1<= i <32 , 低位会被移出

- * value << i 表示将value左移i, 1<= i <32 , 低位补0

- * 看似一左一右相互抵消,但是如果value低位是0右移被移出后,左移又补回来,这样是不会变的,但是如果移除的是1,补回的是0,那么value的值就会发生改变

- * 综合上面的方法,就能比较巧妙的计算低位0的最大长度

- *

- * @param value

- * @return

- */

- private int lowZerosMaxLength(long value) {

- int i = 1;

- for (; i < 32; i++) {

- if (value >> i << i != value) {

- break;

- }

- }

- return i - 1;

- }

- }

- static class Experiment {

- /** 测试次数n */

- private int n;

- private BitKeeper bitKeeper;

- public Experiment(int n) {

- this.n = n;

- this.bitKeeper = new BitKeeper();

- }

- public void work() {

- for(int i = 0; i < n; i++) {

- this.bitKeeper.random();

- }

- }

- /**

- * 输出每一轮测试次数n

- * 输出 logn / log2 = k 得 2^k = n,这里的k即我们估计的kmax

- * 输出 kmax,低位最大0位长度值

- */

- public void debug() {

- System.out.printf("%d %.2f %d\n", this.n, Math.log(this.n) / Math.log(2), this.bitKeeper.kmax);

- }

- }

- public static void main(String[] args) {

- for (int i = 0; i < 100000; i++) {

- Experiment experiment = new Experiment(i);

- experiment.work();

- experiment.debug();

- }

- }

- }

我们可以通过修改main函数中,测试的轮次,再根据输出的结果来观察,n=2^kmax这样的结果还是比较吻合的。

3.3.3.5 代码实现-HyperLogLog

接下来根据HyperLogLog中采用调和平均数+分桶的方式来做代码优化,模拟简单版本的HyperLogLog算法的实现,其代码如下:

- package com.lizba.pf;

- import java.util.concurrent.ThreadLocalRandom;

- /**

- * <p>

- * HyperLogLog 简单实现

- * </p>

- *

- * @Author: Liziba

- * @Date: 2021/8/18 10:40

- */

- public class HyperLogLogTest {

- static class BitKeeper {

- /** 记录最大的低位0的长度 */

- private int kmax;

- /**

- * 计算低位0的长度,并且保存最大值kmax

- *

- * @param value

- */

- public void random(long value) {

- int len = this.lowZerosMaxLength(value);

- if (len > kmax) {

- kmax = len;

- }

- }

- /**

- * 计算低位0的长度

- * 这里如果不理解看下我的注释

- * value >> i 表示将value右移i, 1<= i <32 , 低位会被移出

- * value << i 表示将value左移i, 1<= i <32 , 低位补0

- * 看似一左一右相互抵消,但是如果value低位是0右移被移出后,左移又补回来,这样是不会变的,但是如果移除的是1,补回的是0,那么value的值就会发生改变

- * 综合上面的方法,就能比较巧妙的计算低位0的最大长度

- *

- * @param value

- * @return

- */

- private int lowZerosMaxLength(long value) {

- int i = 1;

- for (; i < 32; i++) {

- if (value >> i << i != value) {

- break;

- }

- }

- return i - 1;

- }

- }

- static class Experiment {

- private int n;

- private int k;

- /** 分桶,默认1024,HyperLogLog中是16384个桶,并不适合我这里粗糙的算法 */

- private BitKeeper[] keepers;

- public Experiment(int n) {

- this(n, 1024);

- }

- public Experiment(int n, int k) {

- this.n = n;

- this.k = k;

- this.keepers = new BitKeeper[k];

- for (int i = 0; i < k; i++) {

- this.keepers[i] = new BitKeeper();

- }

- }

- /**

- * (int) (((m & 0xfff0000) >> 16) % keepers.length) -> 计算当前m在keepers数组中的索引下标

- * 0xfff0000 是一个二进制低16位全为0的16进制数,它的二进制数为 -> 1111111111110000000000000000

- * m & 0xfff0000 可以保理m高16位, (m & 0xfff0000) >> 16 然后右移16位,这样可以去除低16位,使用高16位代替高16位

- * ((m & 0xfff0000) >> 16) % keepers.length 最后取模keepers.length,就可以得到m在keepers数组中的索引

- */

- public void work() {

- for (int i = 0; i < this.n; i++) {

- long m = ThreadLocalRandom.current().nextLong(1L << 32);

- BitKeeper keeper = keepers[(int) (((m & 0xfff0000) >> 16) % keepers.length)];

- keeper.random(m);

- }

- }

- /**

- * 估算 ,求倒数的平均数,调和平均数

- *

- * @return

- */

- public double estimate() {

- double sumBitsInverse = 0.0;

- // 求调和平均数

- for (BitKeeper keeper : keepers) {

- sumBitsInverse += 1.0 / (float) keeper.kmax;

- }

- double avgBits = (float) keepers.length / sumBitsInverse;

- return Math.pow(2, avgBits) * this.k;

- }

- }

- /**

- * 测试

- *

- * @param args

- */

- public static void main(String[] args) {

- for (int i = 100000; i < 1000000; i+=100000) {

- Experiment experiment = new Experiment(i);

- experiment.work();

- double estimate = experiment.estimate();

- // i 测试数据

- // estimate 估算数据

- // Math.abs(estimate - i) / i 偏差百分比

- System.out.printf("%d %.2f %.2f\n", i, estimate, Math.abs(estimate - i) / i);

- }

- }

- }

测试结果如下,误差基本控制在0.08以下,还是很高的误差,所以说算法很粗糙

Geospatial是Redis在3.2版本以后增加的地理位置GEO模块,这个模块可以用来实现微信附近的人,在线点餐“附近的餐馆”等位置功能。

3.4.2.1 GEOADD

命令简介:

GEOADD key longitude latitude member [longitude latitude member …]

![]()

将给定的空间元素(维度、经度、名字)添加到指定的键里面,数据以有序集合的形式被存放在键中。GEOADD接收的参数必须先输入经度,然后输入维度。

GEOADD经纬度的输入范围如下(对两极不支持):

- 有效经度介于-180°~180°之间

- 有效维度介于-85.05112878°至85.05112878°之间

当用户尝试输入一个超出范围的经度或者纬度时, GEOADD 命令将返回一个错误。

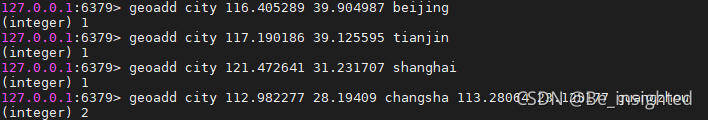

代码示例:

可以依次添加单个,也可以同时添加多个地理位置的元素。

- 127.0.0.1:6379> geoadd city 116.405289 39.904987 beijing

- (integer) 1

- 127.0.0.1:6379> geoadd city 117.190186 39.125595 tianjin

- (integer) 1

- 127.0.0.1:6379> geoadd city 121.472641 31.231707 shanghai

- (integer) 1

- 127.0.0.1:6379> geoadd city 112.982277 28.19409 changsha 113.28064 23.125177 guangzhou

- (integer) 2

错误示例:

- 127.0.0.1:6379> geoadd city 190 18 buzhidao

- (error) ERR invalid longitude,latitude pair 190.000000,18.000000

![]()

3.4.2.2 GEOPOS

命令简介:

GEOPOS key member [member …]

根据键(key)获取给定位置元素的位置(经度和纬度),GEOPOS 可以接收一个member,也可以接收多个member,如果member不存在则返回nil

代码示例:

- 127.0.0.1:6379> geopos beijing

- (empty array)

- 127.0.0.1:6379> geopos city beijing

- 1) 1) "116.40528827905654907"

- 2) "39.90498588819134085"

- 127.0.0.1:6379> geopos city tianjin shanghai

- 1) 1) "117.19018846750259399"

- 2) "39.12559461779084558"

- 2) 1) "121.47264093160629272"

- 2) "31.23170744181923197"

- 127.0.0.1:6379> geopos city xiaoriben

- 1) (nil)

3.4.2.3 GEODIST

命令简介:

GEODIST key member1 member2 [unit]

返回两个给定位置之间的距离,以双精度浮点数的形式被返回。如果给定的位置其中一个不存在(两个都不存在也是一样,下面有示例),将会返回空值(nil)。

unit单位描述:

- m -> 米

- km -> 千米

- mi -> 英里

- ft -> 英尺

默认单位:

如果用户未给定指定单位unit,则默认为米(m)

误差范围:

GEODIST 计算的算法会将地球考虑为一个完全球体,在极限情况下,存在最大0.5%的误差

代码示例:

- 127.0.0.1:6379> geodist city beijing shanghai m

- "1067597.0432"

- 127.0.0.1:6379> geodist city beijing shanghai km

- "1067.5970"

- 127.0.0.1:6379> geodist city beijing xiaoriben

- (nil)

- 127.0.0.1:6379> geodist city meiguoguizi xiaoriben

- (nil)

3.4.2.4 GEORADIUS

命令简介:

GEORADIUS key longitude latitude radius m|km|ft|mi [WITHCOORD] [WITHDIST] [WITHHASH] [ASC|DESC] [COUNT count]

以给定的经纬度为中心, 返回键包含的位置元素当中, 与中心的距离不超过给定最大距离的所有位置元素。

m|km|ft|mi选项:

- m -> 米

- km -> 千米

- mi -> 英里

- ft -> 英尺

[WITHCOORD] [WITHDIST] [WITHHASH]选项:

- [WITHCOORD]:将位置元素的经度和纬度也一并返回。

- [WITHDIST] :在返回位置元素的同时, 将位置元素与中心之间的距离也一并返回。 距离的单位和用户给定的范围单位保持一致。

- [WITHHASH]: 以 52 位有符号整数的形式, 返回位置元素经过原始 geohash 编码的有序集合分值。 这个选项主要用于底层应用或者调试, 实际中的作用并不大。

[ASC|DESC] 选项:

- ASC:根据给定的中心位置,从近到远返回位置元素

- DESC:根据给定的中心位置,从远到近返回位置元素

[COUNT count] 参数:

GEORADIUS 默认会返回符合条件的全部位置元素。但是用户可以通过[COUNT count] 参数去指定获取前N个匹配元素。这个参数可以减少需要返回的元素数量,一定程度上可以减少带宽压力。

返回值:

GEORADIUS 的返回值是一个数组,但是数组的内容会根据是否存在上述参数而改变

- 未给定任何WITH参数,则返回普通线性列表

- 给定[WITHCOORD] [WITHDIST] [WITHHASH]等参数后返回一个二层嵌套数组

具体返回值请查看后续示例,建议还是自己多搞几次就清楚了

代码示例:

未给定任何WITH参数

- 127.0.0.1:6379> georadius city 116.405289 39.904987 1000 km

- 1) "tianjin"

- 2) "beijing"

给定[WITHCOORD] [WITHDIST] [WITHHASH]等参数,返回的时二层嵌套数组

- 127.0.0.1:6379> georadius city 116.405289 39.904987 1000 km withcoord

- 1) 1) "tianjin"

- 2) 1) "117.19018846750259399"

- 2) "39.12559461779084558"

- 2) 1) "beijing"

- 2) 1) "116.40528827905654907"

- 2) "39.90498588819134085"

- 127.0.0.1:6379> georadius city 116.405289 39.904987 1000 km withdist

- 1) 1) "tianjin"

- 2) "109.7754"

- 2) 1) "beijing"

- 2) "0.0001"

3.4.2.5 GEORADIUSBYMEMBER

命令简介:

GEORADIUSBYMEMBER key member radius m|km|ft|mi [WITHCOORD] [WITHDIST] [WITHHASH] [ASC|DESC] [COUNT count]

GEORADIUSBYMEMBER与GEORADIUS的区别在于,GEORADIUSBYMEMBER无需给定经纬度,只需要给定成员的key就行,具体使用与GEORADIUS一致

代码示例:

- 127.0.0.1:6379> georadiusbymember city beijing 1000 km

- 1) "tianjin"

- 2) "beijing"

- 127.0.0.1:6379> georadiusbymember city beijing 1000 km withcoord

- 1) 1) "tianjin"

- 2) 1) "117.19018846750259399"

- 2) "39.12559461779084558"

- 2) 1) "beijing"

- 2) 1) "116.40528827905654907"

- 2) "39.90498588819134085"

3.4.2.6 GEOHASH

命令名称:

GEOHASH key member [member …]

返回一个或多个位置元素的GeoHash表示,可以给顶多个key中的member,因此返回的是一个数组。

代码示例:

- 127.0.0.1:6379> geohash city beijing shanghai changsha

- 1) "wx4g0b7xru0"

- 2) "wtw3sjt9vs0"

- 3) "wt026ux4mz0"

为了便于各位大佬们学习Geospatial的学习,我整理了全国省会城市的经纬度在这,有需要的可以自取。

| 名称 | 经度 | 维度 |

| 北京市 | 116.405289 | 39.904987 |

| 天津市 | 117.190186 | 39.125595 |

| 呼和浩特市 | 111.751990 | 40.841490 |

| 银川市 | 106.232480 | 38.486440 |

| 石家庄市 | 114.502464 | 38.045475 |

| 济南市 | 117.000923 | 36.675808 |

| 郑州市 | 113.665413 | 34.757977 |

| 西安市 | 108.948021 | 34.263161 |

| 武汉市 | 114.298569 | 30.584354 |

| 南京市 | 118.76741 | 32.041546 |

| 合肥市 | 117.283043 | 31.861191 |

| 上海市 | 121.472641 | 31.231707 |

| 长沙市 | 112.982277 | 28.19409 |

| 南昌市 | 115.892151 | 28.676493 |

| 杭州市 | 120.15358 | 30.287458 |

| 福州市 | 119.306236 | 26.075302 |

| 广州市 | 113.28064 | 23.125177 |

| 台北市 | 121.5200760 | 25.0307240 |

| 海口市 | 110.199890 | 20.044220 |

| 南宁市 | 108.320007 | 22.82402 |

| 重庆市 | 106.504959 | 29.533155 |

| 昆明市 | 102.71225 | 25.040609 |

| 贵阳市 | 106.713478 | 26.578342 |

| 成都市 | 104.065735 | 30.659462 |

| 兰州市 | 103.834170 | 36.061380 |

| 西宁市 | 101.777820 | 36.617290 |

| 拉萨市 | 91.11450 | 29.644150 |

| 乌鲁木齐市 | 87.616880 | 43.826630 |

| 沈阳市 | 123.429092 | 41.796768 |

| 长春市 | 125.324501 | 43.886841 |

| 哈尔滨市 | 126.642464 | 45.756966 |

| 香港 | 114.165460 | 22.275340 |

| 澳门 | 113.549130 | 22.198750 |

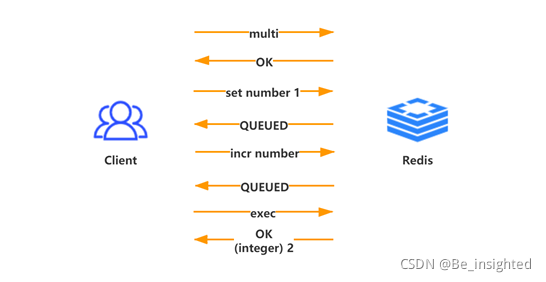

Redis类似大多数成熟的数据库系统一样,提供了事务机制。Redis的事务机制非常简单,它没有严格的事务模型,无法像关系型数据库一样保证操作的原子性。

Redis事务最大的作用是保证多个指令的串行执行,它可以借助于Redis单线程读写的特性,保证Redis事务中的指令不会被事务外的指令打搅,不过要注意它不是原子性的。

完整事务案例:

multi开启一个事务之后,所有指令都不执行,而是缓存到事务队列中,直到服务器接收到exec指令,才开始执行整个事务中的指令。事务全部指令执行完毕后,一次性返回全部的结果。

使用Redis事务,一个最需要注意的问题是,指令多,网络开销高;因此我们一定要结合管道pipeline一起使用,这样可以将多次网络io操作压缩成单次。

4.1.2.1 简介

Redis事务相关的指令有五个,分别是MULTI、EXEC、DISCARD、WATCH、UNWATCH

| 指令 | 指令作用 | 返回值 |

| MULTI | 标记一个事务块的开始 | 总是返回 OK |

| EXEC | 执行所有事务块内的命令 | 事务块内所有命令的返回值,按命令执行的先后顺序排列。当操作被打断时,返回空值 nil |

| DISCARD | 取消事务,放弃执行事务块内的所有命令,如果正在使用 WATCH 命令监视某个(或某些) key,那么取消所有监视,等同于执行命令 UNWATCH | 总是返回 OK |

| WATCH | 监视一个(或多个) key ,如果在事务执行之前这个(或这些) key 被其他命令所改动,那么事务将被打断 | 总是返回 OK |

| UNWATCH | 取消 WATCH 命令对所有 key 的监视。如果在执行WATCH 命令之后, EXEC 命令或 DISCARD 命令先被执行了的话,那么就不需要再执行 UNWATCH 了。因为 EXEC 命令会执行事务,因此 WATCH 命令的效果已经产生了;而 DISCARD 命令在取消事务的同时也会取消所有对 key 的监视,因此这两个命令执行之后,就没有必要执行 UNWATCH 了 | 总是返回 OK |

4.1.2.2 MULTI(开启事务)

MULTI用于标记一个事务的开始,事务块内的多条命令会按照先后顺序被放进一个队列当中,最后由 EXEC 命令原子性(atomic)地执行。MULTI指令总是返回OK。

4.1.2.3 EXEC(执行事务)

EXEC用于执行所有事务块内的命令,假如某个(或某些) key 正处于 WATCH 命令的监视之下,且事务块中有和这个(或这些) key 相关的命令,那么 EXEC 命令只在这个(或这些) key 没有被其他命令所改动的情况下执行并生效,否则该事务被打断(abort)。

4.1.2.4 DISCARD(取消事务)

DISCARD用于取消事务,放弃执行事务块内的所有命令。如果正在使用 WATCH 命令监视某个(或某些) key,那么取消所有监视,等同于执行命令 UNWATCH 。DISCARD指令总是返回OK。

4.1.2.5 WATCH(监视)

WATCH用于监视一个(或多个) key ,如果在事务执行之前这个(或这些) key 被其他命令所改动,那么事务将被打断。这个实现方式也很简单,WATCH是在事务之间发送的指令,Redis服务在接收到指令时,会记录下该key对应的值,当Redis服务接收到EXEC指令,需要执行事务时,Redis服务首先会检查WATCH的key的值,从WATCH之后是否发生改变即可。

注意禁止在MULTI和EXEC之间执行WATCH指令,这会导致Redis服务响应异常

4.1.2.6 UNWATCH

UNWATCH用于取消WATCH命令对所有key的监视。如果在执行 WATCH 命令之后, EXEC 命令或 DISCARD 命令先被执行了的话,那么就不需要再执行 UNWATCH 了。因为 EXEC 命令会执行事务,因此 WATCH 命令的效果已经产生了;而 DISCARD 命令在取消事务的同时也会取消所有对 key 的监视,因此这两个命令执行之后,就没有必要执行 UNWATCH 了。

通过模拟一个简单的余额增加的例子,使用Jedis客户端来使用Redis的事务。

- package com.lizba.redis.tx;

- import redis.clients.jedis.Jedis;

- import redis.clients.jedis.Transaction;

- import java.math.BigDecimal;

- import java.util.List;

- /**

- * <p>

- * Redis事务demo

- * </p>

- *

- * @Author: Liziba

- * @Date: 2021/9/9 23:53

- */

- public class TransactionDemo {

- private Jedis client;

- public TransactionDemo(Jedis client) {

- this.client = client;

- }

- /**

- * 添加余额

- *

- * @param userId 用户id

- * @param amt 添加余额

- * @return

- */

- public BigDecimal addBalance(String userId, BigDecimal amt) {

- String key = this.keyFormat(userId);

- // 初始用户余额为0

- client.setnx(key, "0");

- while (true) {

- client.watch(key);

- BigDecimal balance = new BigDecimal(client.get(key)).setScale(2, BigDecimal.ROUND_HALF_UP);

- BigDecimal amount = balance.add(amt);

- Transaction tx = client.multi();

- tx.set(key, amount.toPlainString());

- List<Object> exec = tx.exec();

- // 返回值不为空则证明Redis事务成功

- if (exec != null) {

- break;

- }

- }

- return new BigDecimal(client.get(key)).setScale(2, BigDecimal.ROUND_HALF_UP);

- }

- /**

- * 获取总金额

- *

- * @param userId 用户id

- * @return

- */

- public BigDecimal getAmount(String userId) {

- String amt = client.get(keyFormat(userId));

- return new BigDecimal(amt);

- }

- /**

- * Redis key

- * @param userId 用户id

- * @return

- */

- private String keyFormat(String userId) {

- return String.format("balance:%s",userId);

- }

- }

测试代码:

- package com.lizba.redis.tx;

- import redis.clients.jedis.Jedis;

- import java.math.BigDecimal;

- import java.util.concurrent.CountDownLatch;

- /**

- * <p>

- * 测试Redis事务

- * </p>

- *

- * @Author: Liziba

- * @Date: 2021/9/10 0:03

- */

- public class TestTransactionDemo {

- private static CountDownLatch count = new CountDownLatch(100);

- public static void main(String[] args) throws InterruptedException {

- for (int i = 0; i < 100; i++) {

- new Thread(() -> {

- Jedis client = new Jedis("192.168.211.109", 6379);

- TransactionDemo demo = new TransactionDemo(client);

- demo.addBalance("liziba", BigDecimal.TEN);

- client.close();

- count.countDown();

- }).start();

- }

- count.await();

- Jedis client = new Jedis("192.168.211.109", 6379);

- BigDecimal amt = new TransactionDemo(client).getAmount("liziba");

- System.out.println(amt.toPlainString());

- }

- }

测试结果:

预期1000,结果1000

李子捌把话说在前头,如果你是面试或者为了了解知识来学习这一知识点,我觉得是有必要的;但是如果你是作为公司的技术负责人或者项目技术选型来使用Redis的Pub/Sub做消息的发布订阅,如果你不是走投无路了,那么你可能值得斟酌一下。Redis的Pub/Sub发布订阅,是Redis一步步完善消息队列功能的一个进步点,虽然现在没人用Pub/Sub做消息队列,但是它的思想和功能也是值得玩一下的,这个就是我写这篇文章的主要原因。同步执行的

Redis 发布订阅 (pub/sub) 是一种消息通信模式:发送者 (pub) 发送消息,订阅者 (sub) 接收消息。

- pub -> publisher

- sub -> subscriber

Redis客户端订阅一个频道非常简单,它可以订阅任意数量的频道。

如下图,Redis客户端订阅(subscriber)频道(channel)

如下图,当消息发送到客户端订阅的频道(channel)时,这个消息就会被订阅的所有未故障的客户端接接收到

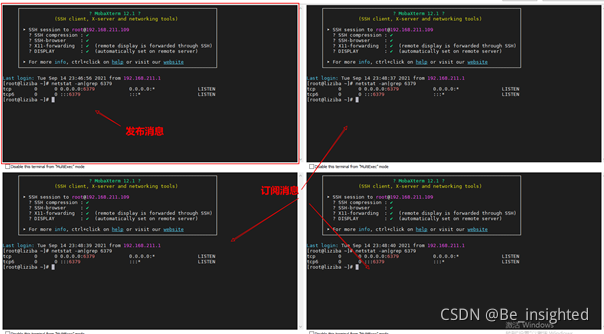

演示Redis的发布订阅,我们需要开启多个客户端,订阅频道(channel)。

4.2.2.1 普通订阅

如下我会启动4个客户端,第一个客户端用来发布消息,其他的用来订阅频道,接收消息。

客户端2、客户端3、客户端4同时订阅news和weather频道(channel)

客户端1向频道news/weather发布消息

此时可以看到三个客户端均接收客户端1向频道news/weather发布的消息

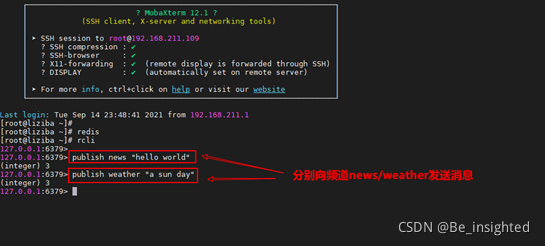

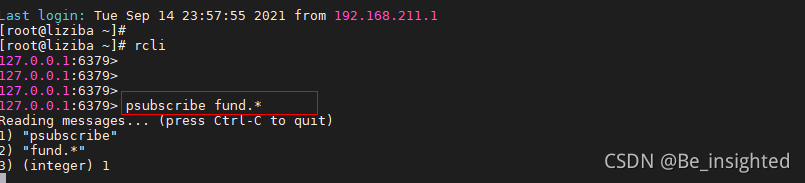

4.2.2.2 模式订阅

Redis为了方便同时订阅多个模式的频道,也有类似市面上常见的MQ中模式订阅功能(如Rabbit MQ中的topic),这个功能可以匹配符的方式进行订阅。

比如我需要订阅以fund.开头,任意字符结尾的频道,就可以使用如下的订阅方式

尝试向fund.nuoan发布消息

![]()

订阅了fund.*的客户端,成功接收到消息

关于Redis的Pub/Sub为什么被抛弃,最主要的原因是它无法持久化,没有实现持久化机制的Pub/Sub,无法做到消息的不丢失,在客户端宕机或者Redis服务宕机的情况下,都会导致消息丢失。

- 客户端宕机,客户端无法接收消息

- Redis服务宕机,没有客户端能连接上,肯定也无法接收到消息

大部分情况下,我们都不会用到Redis去做消息中间件,市面上成熟且好用的消息中间件非常多,如果真的需要使用Redis来做消息中间件,可以考虑Redis 5.0的新数据结构Stream,这个功能在Pub/Sub的基础上,实现了持久化机制,并且大力借鉴了kafka的设计原理,完善了Redis用于实现消息队列的不足之处。

Stream弥补了Redis作为MQ(message queue)技术选型上的不足之处;Redis 5.0发布的Stream相比Pub/Sub模块,Stream支持消息持久化,结合sentinel或cluster使其成为了一个比较可靠的消息队列。尽管我认为它很难成为公司MQ的技术选型产品,但是关于Stream的使用和特性(消费组),仍值得一探究竟。

Stream对标消息队列,因此几乎具备了MQ所有的特性,以下列出Stream所具有的部分特性:

- 消息顺序存储

- 消息ID序列化规则生成

- 消息的遍历

- 消息阻塞/非阻塞式获取

- 客户端分组消费消息

- 消息确认机制

- 消息异常机制

- 消息队列监控

在文中也会说到Stream的这些特性。

4.3.2.1 Stream 结构

在探索Stream的内部结构之前,先看一张清晰的Stream结构图:

如下是关于上图的名词解析:

- Message Content:消息内容

- Consumer group:消费组,通过XGROUP CREATE 命令创建,一个消费组可以有多个消费者

- Last_delivered_id:游标,每个消费组有一个游标,任意消费者读取消息后,游标都会向前移动

- Consumer:消费者,消费组中的消费者

- Pending_ids:状态变量,每个消费者会有一个状态变量,用于记录被当前消费者读取,但是并未ack的消息id

4.3.2.2 四个唯一

Stream内部维护了一个消息链表,以此使得消息能够具有队列的特性。在Stream中有四个唯一需要了解:

- 每个Stream都具有唯一的名称

- 每个消息(Message)都具有一个由系统分配或者客户端指定唯一ID

- 每个Stream中的消费组(Consumer_Group)具有唯一名称

- 每个消费组(Consumer_Group)中的消费者(Consumer)具有唯一名称

4.3.2.3 消息ID

Stream的消息ID可以由服务端自动生成,也可以由客户端传入,如下图是自动生成的结构:

![]()

系统自动生成的规则

<millisecondsTime>-<sequenceNumber

millisecondsTime指的是Redis节点服务器的本地时间,如果存在当前的毫秒时间戳比以前已经存在的数据的时间戳小的话(本地时间钟后跳),那么系统将会采用以前相同的毫秒创建新的ID。

sequenceNumber指的是序列号,在相同的millisecondsTime毫秒下,序列号从0开始递增,序列号是64位长度,理论上在统一毫秒内生成的数据量无法到达这个级别,因此不用担心sequenceNumber会不够用。

客户端显示传入规则

Redis对于ID有强制要求,格式必须是-,最小ID为0-1,并且后续ID不能小于前一个ID

4.3.2.4 消息内容

Stream的消息内容,也就是图中的Message Content它的结构类似Hash结构,以key-value的形式存在。

4.3.3.1 指令汇总

Stream的指令根据可以分为两类,分别是消息队列相关指令,消费组相关指令。

消息队列相关指令:

| 指令名称 | 指令作用 |

| XADD | 添加消息到队列末尾 |

| XTRIM | 限制Stream的长度,如果已经超长会进行截取 |

| XDEL | 删除消息 |

| XLEN | 获取Stream中的消息长度 |

| XRANGE | 获取消息列表(可以指定范围),忽略删除的消息 |

| XREVRANGE | 和XRANGE相比区别在于反向获取,ID从大到小 |

| XREAD | 获取消息(阻塞/非阻塞),返回大于指定ID的消息 |

消费组相关指令:

| 指令名称 | 指令作用 |

| XGROUP CREATE | 创建消费者组 |

| XREADGROUP GROUP | 读取消费者组中的消息 |

| XACK | ack消息,消息被标记为“已处理” |

| XGROUP SETID | 设置消费者组最后递送消息的ID |

| XGROUP DELCONSUMER | 删除消费者组 |

| XPENDING | 打印待处理消息的详细信息 |

| XCLAIM | 转移消息的归属权(长期未被处理/无法处理的消息,转交给其他消费者组进行处理) |

| XINFO | 打印Stream\Consumer\Group的详细信息 |

| XINFO GROUPS | 打印消费者组的详细信息 |

| XINFO STREAM | 打印Stream的详细信息 |

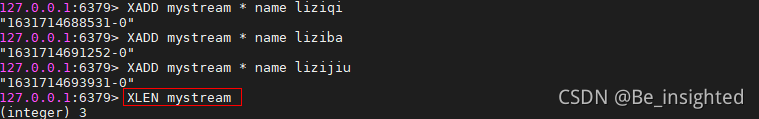

4.3.3.2 XADD

XADD 用于向Stream 队列中添加消息,如果指定的Stream 队列不存在,则该命令执行时会新建一个Stream 队列。

XADD的指令语法:

XADD key [NOMKSTREAM] [MAXLEN|MINID [=|~] threshold [LIMIT count]] *|ID field value [field value …]

如下通过XADD展示了定义ID的两种方式,具体可以看2.3。

4.3.3.3 XTRIM

XTRIM 用于对Stream的长度进行限定。

XTRIM 的指令语法:

XTRIM key MAXLEN|MINID [=|~] threshold [LIMIT count]

- MAXLEN 允许的最大长度,如果长度超出则会抛弃队列前面的消息

- MINID 允许的最小id,从某个id值开始保留,其余的将会被抛弃

4.3.3.4 XDEL

XDEL 用于删除消息。

XDEL 的指令语法:

XDEL key ID [ID …]

4.3.3.5 XLEN

XLEN 用于获取Stream 队列的消息的长度。

XLEN 的指令语法:

XLEN key

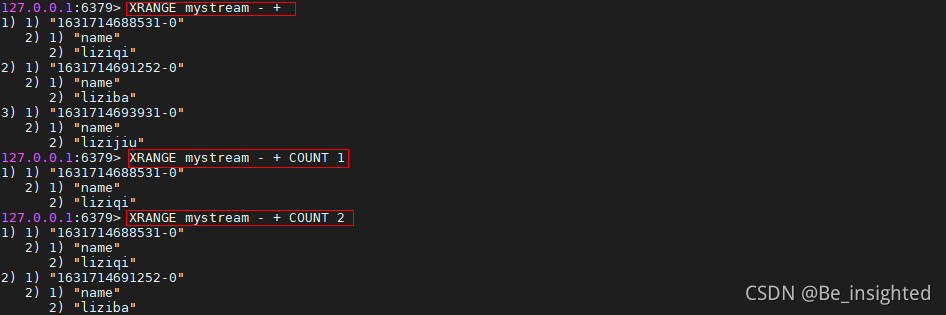

4.3.3.6 XRANGE

XRANGE 用于获取消息列表(可以指定范围),忽略删除的消息。

XRANGE 的指令语法:

XRANGE key start end [COUNT count]

- start 表示开始值,-代表最小值

- end 表示结束值,+代表最大值

- count 表示最多获取多少个值

4.3.3.7 XREVRANGE

XREVRANGE 用于获取消息列表(可以指定范围),忽略删除的消息。与XRANGE 的区别在于,获取消息列表元素的方向是相反的,end在前,start在后。

XREVRANGE 的指令语法:

XREVRANGE key end start [COUNT count]

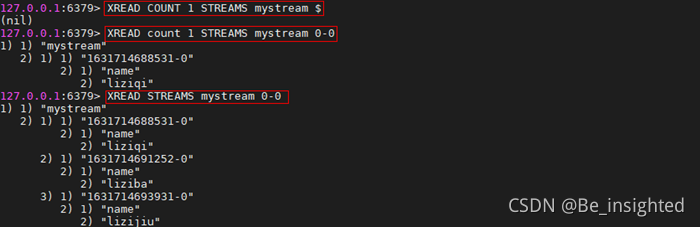

4.3.3.8 XREAD

XREAD 用于获取消息(阻塞/非阻塞),只会返回大于指定ID的消息。

XREAD 的指令语法:

XREAD [COUNT count] [BLOCK milliseconds] STREAMS key [key ...] ID [ID ...]

- COUNT 最多读取多少条消息

- BLOCK 是否已阻塞的方式读取消息,默认不阻塞,如果milliseconds设置为0,表示永远阻塞

$代表特殊ID,表示以当前Stream已经存储的最大的ID作为最后一个ID,当前Stream中不存在大于当前最大ID的消息,因此此时返回nil。

0-0代表从最小的ID开始获取Stream中的消息,当不指定count,将会返回Stream中的所有消息,注意也可以使用0(00/000也都是可以的……)。

阻塞方式获取Stream中的指令,这里演示阻塞获取一条消息

4.3.3.9 XGROUP CREATE

XGROUP CREATE 用于创建消费者组。

XGROUP CREATE 的指令语法:

XGROUP [CREATE key groupname ID|$ [MKSTREAM]] [SETID key groupname ID|$] [DESTROY key groupname] [CREATECONSUMER key groupname consumername] [DELCONSUMER key groupname consumername]

XGROUP CREATE中的指令没什么复杂的,第一个中括号中的几个参数最为重要,如下图两种方式:

- $表示从Stream尾部开始消费,会忽略Stream中目前已有的数据

- 0表示从Stream头部开始消费

如果Stream不存在,XGROUP CREATE 语法将会报错,因此可以得出不允许在不存在的Stream上创建消费者组

4.3.3.10 XREADGROUP GROUP

XREADGROUP GROUP 用于读取消费者组中的消息。

XREADGROUP GROUP 的指令语法:

XREADGROUP GROUP group consumer [COUNT count] [BLOCK milliseconds] [NOACK] STREAMS key [key …] ID [ID …]

注意,这里有一个比较重要的知识点,刚开始的时候可能容易搞错:

>这个特殊符号表示消息到目前为止,从未传递给其他消费者的消息

0表示指定消息ID,因为ID均大于0-0(0代指0-0),因此代表从Stream 的队列头部开始获取消息

在如下截图中,为何第一次 mystream 0 获取消息返回empty,在执行完 mystream > 之后,第二 mystream 0 却成功的获取到了消息,但是很明显mystream中刚添加了两条消息,第一次不应该失败才对呀?

这是因为,当指定ID进行消息获取时,命令将会让我们访问我们的历史待处理消息(曾被获取,但是未ack)。即传递给这个指定消费者(由提供的名称标识)的消息集,并且到目前为止从未使用XACK进行确认。

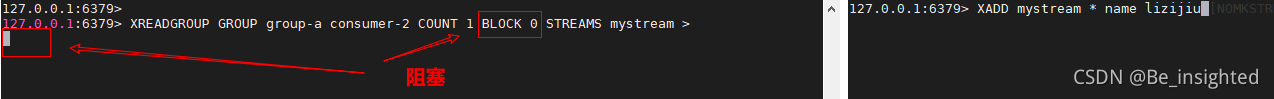

XREADGROUP GROUP 也可以像XREAD 一样使用阻塞的方式获取消息

当向mystream中添加消息后,阻塞读返回

4.3.3.11 XACK

XACK 用于标记为“已处理”。

XACK 的指令语法:

XACK key group ID [ID …]

结合**XREADGROUP GROUP **中指定ID的方式只能获取未ack的未处理消息的特性,测试XACK指令。从如下的测试示例中可以得出两个结论:

- 消息首次ack成功,返回1,ack失败返回0

- 3.9中的结论是正确的

4.3.3.12 XPENDING

XPENDING 用于打印待处理消息的详细信息。

XPENDING 指令是非常有用的,因为它可以打印待处理消息的信息。如果在一个消费者组中存在多个消费者,如果存在部分消费者永久的故障,无法再处理消息了,我们就可以通过XPENDING 指令来查看指定消费者组中的消费者未ack的消息,然后转移给其他消费者进行处理。

XPENDING 的指令语法:

XPENDING key group [[IDLE min-idle-time] start end count [consumer]]

XPENDING 返回值解析:

- 第一个参数表示当前消费者中待处理消息的总数

- 第二个参数表示待处理消息的最小ID

- 第三个参数表示待处理消息的最大ID

- 第四个参数表示消费者列表和未处理的消息数量

4.3.3.13 XCLAIM

XCLAIM 用于转移消息的归属权。

XCLAIM 的指令语法:

XCLAIM key group consumer min-idle-time ID [ID …] [IDLE ms] [TIME ms-unix-time] [RET

指令参数解析:

- key 表示Stream的名称

- group 表示需要转移消息的归属权的消费者组名称

- consumer 表示接收消息的消费者名称

- min-idle-time 表示最小空闲时间,只有后续指定ID的消息空闲时间大于指定的空闲时间,消息归属权转移指令才会生效

- ID [] 需要转移归属权的消息ID,数组,可以是多个

示例中,将consumer-1中ID为1631719560149-0的未处理的消息的归属权转移到consumer-2下:

4.3.3.14 XINFO

XINFO 用于打印Stream\Consumer\Group的详细信息。

XINFO 的指令语法:

XINFO [CONSUMERS key groupname] [GROUPS key] [STREAM key] [HELP]

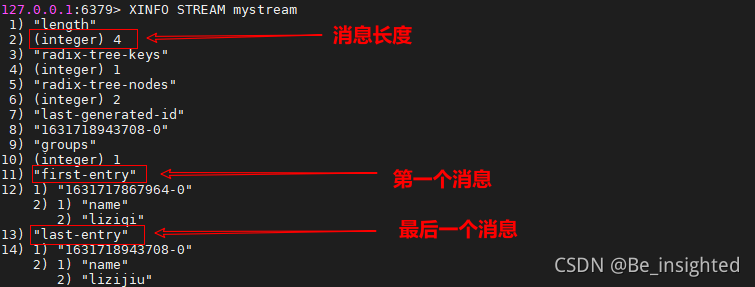

示例打印指定STREAM的详细消息

使用Stream有两个点需要注意,如果使用不当都会导致内存消耗增大。

- 待处理消息过多,消息未及时ack

- Stream消息持续持久化,使用XDEL删除消息

关于第一点,待处理消息过多,消息未及时ack,其导致内存增加的原因是,Stream会为每个消费者维护一个PEL列表,PEL列表用于存储处理完但未及时ack的消息ID。我们在实际使用过程中,处理完的消息一定要及时ack,也有定时检查是否有消费者不可用导致消息堆积的情况。

XPENDING能查询出消费者中待处理的消息,就是因为有PEL的存在。

关于第二点,使用XDEL删除Stream中不在需要的消息,其导致内存增加的原因是,Stream的XDEL删除消息的指令,并不会从内存上删除消息,它只是给消息打上标记位,下次通过XRANGE指令忽略这些消息而已。因此我们可以设置Stream的最大长度,来解决这个问题,在XADD中使用MAXLEN指定Stream队列的长度,当消息超出长度就会将队列头消息清除掉。(不过这种处理方式一定要做到及时处理消息,避免消息的丢失。)

XADD key [NOMKSTREAM] [MAXLEN|MINID [=|~] threshold [LIMIT count]] *|ID field value [field value …]

Redis是一种基于客户端-服务端模型以及请求/响应的TCP服务。一次Redis客户端发起的请求,经过服务端的响应后,大致会经历如下的步骤:

- 客户端发起一个(查询/插入)请求,并监听socket返回,通常情况都是阻塞模式等待Redis服务器的响应

- 服务端处理命令,并且返回处理结果给客户端

- 客户端接收到服务的返回结果,程序从阻塞代码处返回

Redis客户端和服务端之间通过网络连接进行数据传输,这个连接可以很快(loopback接口)或很慢(建立了一个多次跳转的网络连接)。无论网络延如何延时,数据包总是能从客户端到达服务器,并从服务器返回数据回复客户端,这个时间被称之为RTT(Round Trip Time - 往返时间)。我们可以很容易就意识到,Redis在连续请求服务端时,即使Redis每秒能处理100k请求,但也会因为网络传输花费大量时间,导致整体性能的下降。

因此如果遇到大量的批处理,我们可以考虑使用Redis的pipeline(管道)。值得注意的是,管道技术并不是Redis特有的技术,管道技术往往需要客户端-服务器的共同配合,大部分工作任务其实是在客户端完成,很显然Redis支持管道技术,按照官网的意思,Redis的最低版本就考虑了管道技术的支持性设计。

如下图,多个连续的incr指令,使用pipeline(管道)后,多个连续的incr指令只会花费一次网络来回开销,这个开销会随着n数值的增大,大幅减少网络io开销,从而提升整体服务的性能。

在上述简介中,提到了管道技术优化的是网络传输的耗时时间,这里通过Redis客户端-服务端的一次完整的网络请求来回,深入探索pipeline的本质。

- 客户端调用write将数据写入操作系统内核(kernel)为socket连接分配的发送缓冲区(send buffer)

- 客户端操作系统内核将发送缓冲区(send buffer)的数据发送到网卡(NIC)

- 网卡(NIC)将数据通过路由(route)将数据送到Redis服务器机器网卡(NIC)

- 服务器操作系统内核(kernel)将网卡(NIC)接收的数据,写入内核为socket分配的接收缓冲区(recv buffer)

- 服务器进程从接收缓冲区调用read读取数据,并进行数据逻辑处理

- 数据处理完成之后,服务器进程调用write将响应数据写入操作系统内核为socket分配的发送缓冲区

- 操作系统内核将发送缓冲区的数据发送到服务器网卡

- 服务器网卡将响应数据通过路由发送到客户端网卡

- 客户端网卡接收响应数据

- 客户端操作系统内核读取网卡接收到的服务器响应数据,并写入操作系统为socket连接分配的介绍缓冲区

- 客户端进程调用read从接收缓冲区中读取服务器响应数据

- 一次完整网络请求来回过程结束

对于pipeline技术而言,就是将n * 12个步骤,合并成1 * 12,这样服务请求响应的总体时间将会大大的减少。

有个值得注意的点:

在上述网络请求来回中,可能出现我们经常说到的io阻塞:

- 当write操作发生,并且发送缓冲区(send buffer)满时,就会导致write操作阻塞

- 当read操作发生,并且接收缓冲区(recv buffer)满时,就会导致read操作阻塞

上述的这两个阻塞如果出现,将会导致整个请求时间变长,因此我们操作大批量指令的时候,比如10k个指令,我们可以合理的对指令分多次批量发送,这样可以减少出现阻塞的情况,也可以避免服务器响应一个过大的答复包,导致客户端内存负载过重。

使用Redis提供的benchmark对Redis进行性能测试,

如过你是Windows下的Redis,在安装目录下有个redis-benchmark.exe,进入cmd命令模式测试即可。

如果你是在Linux下的redis,在安装目录的src目录下有个redis-benchmark

redis-benchmark的全部指令参数如下所示,我们这里测试pipeline,需要使用-P

| 指令名称 | 描述 | 默认值 |

| -h | 指定Redis服务器hostname | 127.0.0.1 |

| -p | 指定Redis服务器端口 | 6379 |

| -s | 指定Redis服务器Server Socket | |

| -a | 指定Redis服务器密码 | |

| -c | 指定客户端并发数 | 50 |

| -n | 指定总请求数 | 100000 |

| -dbnum | 指定Redis数据库 | 0 |

| -k | 1=keep alive 0=reconnect | 1 |

| -r | 使用随机key,value 对相关指令进行压测 | |

| -P | 使用管道(pipeline) | 1(no pipeline) |

| -q | 强制退出Redis,仅展示query/sec | |

| --csv | 使用CSV格式输出 | |

| -l | 循环运行测试 | |

| -t | 运行逗号分隔的测试列表 | |

| -I | Idle模式,仅打开N个idle连接并等待 |

通过普通方式测试set指令和pipeline方式测试set指令,可以看到Redis服务不同的QPS:

- 普通set方式,Redis QPS 大概在5.3万左右

- 当使用pipeline set时,随着管道内并行请求数量的增加,Redis QPS可以达到100万以上

4.4.4 Jedis使用pipeline

测试代码

- package com.liziba.redis;

- import redis.clients.jedis.Jedis;

- import redis.clients.jedis.Pipeline;

- import java.io.IOException;

- /**

- * <p>

- * 测试pipeline

- * </p>

- *

- * @Author: Liziba

- * @Date: 2021/9/14 22:43

- */

- public class PipelineTest {

- public static void main(String[] args) throws IOException {

- Jedis client = new Jedis("127.0.0.1", 6379);

- long startPipe = System.currentTimeMillis();

- Pipeline pipe = client.pipelined();

- pipe.multi();

- for (int i = 0; i < 100000; i++) {

- pipe.set("pipe" + i, i + "" );

- }

- pipe.exec();

- pipe.close();

- long endPipe = System.currentTimeMillis();

- System.out.println("pipeline set cost time : " + (endPipe - startPipe) + "ms");

- for (int i = 0; i < 100000; i++) {

- client.set("normal" + i, i + "");

- }

- System.out.println("normal set cost time : " + (System.currentTimeMillis() - endPipe)+ "ms");

- }

- }

测试结果

Redis的非常快,很大一部分原因是因为Redis的数据存储在内存中,既然在内存中,那么当服务器宕机或者断电的时候,数据就会全部丢失了,所以Redis提供了两种机制来保证Redis数据不会因为故障而全部丢失,这种机制称为Redis的持久化机制。

Redis的持久化机制有两种:

- RDB(Redis Data Base) 内存快照

- AOF(Append Only File) 增量日志

**RDB(Redis DataBase) **指的是在指定的时间间隔内将内存中的数据集快照写入磁盘,RDB是内存快照(内存数据的二进制序列化形式)的方式持久化,每次都是从Redis中生成一个快照进行数据的全量备份。

优点:

- 存储紧凑,节省内存空间

- 恢复速度非常快

- 适合全量备份、全量复制的场景,经常用于灾难恢复(对数据的完整性和一致性要求相对较低的场合)

缺点:

- 容易丢失数据,容易丢失两次快照之间Redis服务器中变化的数据。

- RDB通过fork子进程对内存快照进行全量备份,是一个重量级操作,频繁执行成本高。

- fork子进程,虽然共享内存,但是如果备份时内存被修改,最大可能膨胀到2倍大小。

AOF(Append Only File)是把所有对内存进行修改的指令(写操作)以独立日志文件的方式进行记录,重启时通过执行AOF文件中的Redis命令来恢复数据。AOF能够解决数据持久化实时性问题,是现在Redis持久化机制中主流的持久化方案(后续会谈到4.0以后的混合持久化)。

优点:

- 数据的备份更加完整,丢失数据的概率更低,适合对数据完整性要求高的场景

- 日志文件可读,AOF可操作性更强,可通过操作日志文件进行修复

缺点:

- AOF日志记录在长期运行中逐渐庞大,恢复起来非常耗时,需要定期对AOF日志进行瘦身处理(后续详述)

- 恢复备份速度比较慢

- 同步写操作频繁会带来性能压力

官网地址

RDB持久化方案进行备份时,Redis会单独fork一个子进程来进行持久化,会将数据写入一个临时文件中,持久化完成后替换旧的RDB文件。在整个持久化过程中,主进程(为客户端提供服务的进程)不参与IO操作,这样能确保Redis服务的高性能,RDB持久化机制适合对数据完整性要求不高但追求高效恢复的使用场景。

下面展示RDB持久化流程:

上面说到了RDB持久化过程中,主进程会fork一个子进程来负责RDB的备份,这里简单介绍一下fork

- Linux操作系统中的程序,fork会产生一个和父进程完全相同的子进程。子进程与父进程所有的数据均一致,但是子进程是一个全新的进程,与原进程是父子进程关系

- 出于效率考虑,Linux操作系统中使用COW(Copy On Write)写时复制机制,fork子进程一般情况下与父进程共同使用一段物理内存,只有在进程空间中的内存发生修改时,内存空间才会复制一份出来。

在Redis中,RDB持久化就是充分的利用了这项技术,Redis在持久化时调用glibc函数fork一个子进程,全权负责持久化工作,这样父进程仍然能继续给客户端提供服务。fork的子进程初始时与父进程(Redis的主进程)共享同一块内存;当持久化过程中,客户端的请求对内存中的数据进行修改,此时就会通过COW机制对数据段页面进行分离,也就是复制一块内存出来给主进程去修改。

RDB触发的规则分为两大类,分别是手动触发和自动触发:

自动触发:

- 配置触发规则

- shutdown触发

- flushall触发

手动触发:

- save

- bgsave

以下介绍Redis的RDB持久化机制中的自动触发机制中的配置触发规则来触发RDB,涉及到RDB规则的配置、文件存储路径配置、文件名配置、文件压缩配置、文件完整性校验配置。

5.2.3.1 配置规则触发

- 在Redis安装目录下的redis.conf配置文件中搜索 /snapshot即可快速定位,配置文件默认注释了下面三行数据,通过配置规则来触发RDB的持久化,需要开启或者根据自己的需求按照规则来配置。

下面对配置规则进行解释,实际使用过程中可以根据需求进行合理的配置

save 3600 1 -> 3600秒内有1个key被修改,触发RDB

save 300 100 -> 300 秒内有100个key被修改,触发RDB

save 60 10000 -> 60 秒内有10000个key被修改,触发RDB

- 配置RDB文件的存储路径

我们可以在Redis的安装目录下看到dump.rdb文件,如果没看到,连接到客户端执行一次shutdown,这个是后面

shutdown自动触发规则,后续会讲述

- 配置RDB文件的名称

- 配置RDB文件压缩

Redis默认会使用LZF算法对Redis的RDB文件进行压缩,这会消耗一定的CPU计算资源,但是会带来空间上的节省

- 配置RDB文件完整性校验

Redis 默认使用CRC64的算法,对RDB文件完整性进行校验,以此来保证RDB文件的完整

5.2.3.2 shutdown触发

shutdown触发Redis的RDB持久化机制非常简单,我们在客户端执行shutdown即可。

5.2.3.3 flushall触发

首先这里一定要特别注意,flushall是删库跑路,它是清空dump.rdb文件,千万千万不要看了博主的文章,跑到公司备份的时候顺手来个flushall,然后到时候来问候我……,这个flushall是为了清空Redis数据的同时清空dump.rdb文件,要不然重启Redis的时候,数据又会恢复到上一次备份的时候的数据,与flushall的执行指令含义就冲突了。

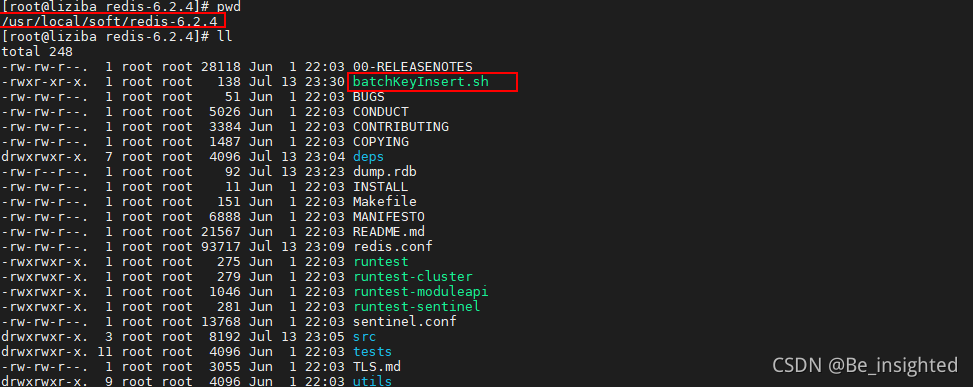

为了证明这个文件不会保留数据,我特地特地的写个脚本测试一下:

编写一个批量插入的脚本文件

vi batchKeyInsert.sh

- #!/bin/bash

- for((i=0;i<100000;i++))

- do

- echo -en "Hello Redis." | redis-cli -h 192.168.211.108 -p 6379 -c -x set name$i >>redis.log

- done

文件赋权

chmod +x batchKeyInsert.sh

./batchKeyInsert.sh

此时查看dump.rdb

执行flushall,后再次查看,rbd文件被清空

手动触发RDB持久化的方式可以使用save命令和bgsave命令,这两个命令的区别如下。

save:执行save指令,阻塞Redis的其他操作,会导致Redis无法响应客户端请求,不建议使用。

bgsave:执行bgsave指令,Redis后台异步进行快照的保存操作,此时Redis仍然能响应客户端的请求。

在实际的生产环境中,我们一般不会使用主节点Master来进行持久化备份,我们会通过在Redis的多个从服务器上进行RDB持久化备份,这样是为了对Redis数据的多次备份,防止出现网络分区或者部分节点宕机甚至是硬件损坏的情况发生。

作为运维或者架构师,李子捌觉得应该要定时定期的通过脚本对Redis持久化文件进行转移备份,这样双重保险,更加可靠,万一遇到突发情况,也是多一手解决方案。

Redis配置文件中开启,AOF持久化方案进行备份时,客户端所有请求的写命令都会被追加到AOF缓冲区中,缓冲区中的数据会根据Redis配置文件中配置的同步策略来同步到磁盘上的AOF文件中,同时当AOF的文件达到重写策略配置的阈值时,Redis会对AOF日志文件进行重写,给AOF日志文件瘦身。Redis服务重启的时候,通过加载AOF日志文件来恢复数据。

5.3.2.1 基本配置

AOF默认不开启,默认为appendonly no,开启则需要修改为appendonly yes

AOF配置文件的名称默认为appendonly.aof

配置文件的地址可以通过在redis客户端执行config get dir获取,其保存路径与RDB一致

5.3.2.2 同步频率配置

AOF日志是以文件的形式存在的,当程序对AOF日志文件进行写操作时,实际上将内容写到了内核为文件描述符分配的一个内存缓冲区中,随后内核会异步的将缓冲区中的数据刷新到磁盘中。如果缓冲区中的数据没来得及刷回磁盘时,服务器宕机了,这些数据就会丢失。

因此Redis通过调用Linux操作系统的glibc提供的fsync(int fid)来将指定文件的内容强制从内核缓冲区刷回磁盘,以此来保证缓冲区中的数据不会丢失。不过这是一个IO操作,相比Redis的性能来说它是非常慢的,所以不能频繁的执行。

Redis配置文件中有三种刷新缓冲区的配置:

appendfsync always

每次Redis写操作,都写入AOF日志,这种配置理论上Linux操作系统扛不住,因为Redis的并发远远超过了Linux操作系统提供的最大刷新频率,就算Redis写操作比较少的情况,这种配置也是非常耗性能的,因为涉及到IO操作,所以这个配置基本上不会用

appendfsync everysec

每秒刷新一次缓冲区中的数据到AOF文件,这个Redis配置文件中默认的策略,兼容了性能和数据完整性的折中方案,这种配置,理论上丢失的数据在一秒钟左右。

appendfsync no

Redis进程不会主动的去刷新缓冲区中的数据到AOF文件中,而是直接交给操作系统去判断,这种操作也是不推荐的,丢失数据的可能性非常大。

注意要刷新缓冲区的数据到磁盘需要将如下配置,配置为no,不是yes

no-appendfsync-on-rewrite no

5.3.2.3 AOF修复功能

AOF持久化机制正常恢复与RDB持久化机制的恢复是一样的,都只需要将备份文件放置到Redis的工作目录下,Redis启动时就会自动的加载。AOF持久化机制提供了AOF文件异常时恢复的功能,这个功能在AOF文件损坏的场景中经常被使用到。

测试,清空Redis服务中的数据

写入数据

AOF日志文件每秒会被刷新一次数据,此时数据已经写入了appendonly.aof文件

打开文件我们可以非常清除的阅读AOF的文件内容,看到Redis的指令序列

此时人为的进行数据破坏

再次启动发现无法启动(我配置的别名启动)

执行redis-check-aof --fix ../appendonly.aof 对AOF日志文件进行修复

修复过程中会有部分数据丢失

连接客户端查看数据

5.3.2.4 AOF重写

前面提到AOF的缺点时,说过AOF属于日志追加的形式来存储Redis的写指令,这会导致大量冗余的指令存储,从而使得AOF日志文件非常庞大,比如同一个key被写了10000次,最后却被删除了,这种情况不仅占内存,也会导致恢复的时候非常缓慢,因此Redis提供重写机制来解决这个问题。Redis的AOF持久化机制执行重写后,保存的只是恢复数据的最小指令集,我们如果想手动触发可以使用如下指令:

bgrewriteaof

Redis4.0后的重写使用的是RDB快照和AOF指令拼接的方式,在AOF文件的头部是RDB快照的二进制形式的数据,尾部是快照产生后发生的写入操作的指令。

由于重写AOF文件时,会对Redis的性能带来一定的影响,因此也不能随便的进行自动重写,Redis提供两个配置用于自动进行AOF重写的指标,只有这两个指标同时满足的时候才会发生重写:

auto-aof-rewrite-percentage 100:指的是当文件的内存达到原先内存的两倍

auto-aof-rewrite-min-size 64mb:指的是文件重写的最小内存大小

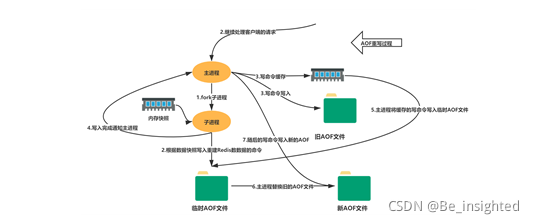

AOF重写流程如下:

- bgrewriteaof触发重写,判断是否存在bgsave或者bgrewriteaof正在执行,存在则等待其执行结束再执行

- 主进程fork子进程,防止主进程阻塞无法提供服务,类似RDB

- 子进程遍历Redis内存快照中数据写入临时AOF文件,同时会将新的写指令写入aof_buf和aof_rewrite_buf两个重写缓冲区,前者是为了写会旧的AOF文件,后者是为了后续刷新到临时AOF文件中,防止快照内存遍历时新的写入操作丢失

- 子进程结束临时AOF文件写入后,通知主进程

- 主进程会将上面3中的aof_rewirte_buf缓冲区中的数据写入到子进程生成的临时AOF文件中

- 主进程使用临时AOF文件替换旧AOF文件,完成整个重写过程

Redis4.0后大部分的使用场景都不会单独使用RDB或者AOF来做持久化机制,而是兼顾二者的优势混合使用。其原因是RDB虽然快,但是会丢失比较多的数据,不能保证数据完整性;AOF虽然能尽可能保证数据完整性,但是性能确实是一个诟病,比如重放恢复数据。

其日志文件结构如下:

混合持久化通过aof-use-rdb-preamble yes开启,Redis 4.0以上版本默认开启

测试,我们先插入一些key,然后执行BGREWRITEAOF触发AOF持久化后,再插入一些key

此时将会看到如下的效果,验证了混合持久化的方式

最后来总结这两者,到底用哪个更好呢?

- 推荐是两者均开启

- 如果对数据不敏感,可以选单独用RDB

- 不建议单独用AOF,因为可能会出现Bug

- 如果只是做纯内存缓存,可以都不用

Redis中文网的介绍:

-

如何选择使用哪种持久化方式?

一般来说, 如果想达到足以媲美 PostgreSQL 的数据安全性, 你应该同时使用两种持久化功能。

如果你非常关心你的数据, 但仍然可以承受数分钟以内的数据丢失, 那么你可以只使用 RDB 持久化。

有很多用户都只使用 AOF 持久化, 但我们并不推荐这种方式: 因为定时生成 RDB 快照(snapshot)非常便于进行数据库备份, 并且 RDB 恢复数据集的速度也Note: 因为以上提到的种种原因, 未来我们可能会将 AOF 和 RDB 整合成单个持久化模型。 (这是一个长期计划。) 接下来的几个小节将介绍 RDB 和 AOF 的更多细节。要比 AOF 恢复的速度要快, 除此之外, 使用 RDB 还可以避免之前提到的 AOF 程序的 bug 。

Redis官网关于持久化的介绍

Redis中文网关于持久化的介绍

REDIS persistence -- Redis中国用户组(CRUG)

6.1 Redis安装布隆(Bloom Filter)过滤器

- 推荐版本6.x,最低4.x版本,可以通过如下命令查看版本:

redis-server -v

![]()

- 插件安装,网上大部分推荐v1.1.1,文章写的时候v2.2.6已经是release版本了,用户自己选择,地址全在下面(2.2.6官网介绍说是1.0版本的维护版本,如果不想使用新的功能,无需升级!)

v1.1.1

https://github.com/RedisLabsModules/rebloom/archive/v1.1.1.tar.gz

v2.2.6

https://github.com/RedisLabsModules/rebloom/archive/v2.2.6.tar.gz

以下安装全部在指定目录下完成,可以选择一个合适的统一目录进行软件安装和管理。

6.1.2.1 下载插件压缩包

wget https://github.com/RedisLabsModules/rebloom/archive/v2.2.6.tar.gz

6.1.2.2 解压

tar -zxvf v2.2.6.tar.gz

6.1.2.3 编译插件

- cd RedisBloom-2.2.6/

- make

编译成功后看到redisbloom.so文件即可

6.1.3.1 Redis配置文件修改

- 在redis.conf配置文件中加入如RedisBloom的redisbloom.so文件的地址

- 如果是集群则每个配置文件中都需要加入redisbloom.so文件的地址

- 添加完成后需要重启redis

loadmodule /usr/local/soft/RedisBloom-2.2.6/redisbloom.so

redis.conf配置文件中预置了loadmodule的配置项,我们可以直接在这里修改,后续修改会更加方便。

保存退出后一定要记得重启Redis!

保存退出后一定要记得重启Redis!

保存退出后一定要记得重启Redis!

6.1.3.2 测试是否成功

Redis集成布隆过滤器的主要指令如下:

- bf.add 添加一个元素

- bf.exists 判断一个元素是否存在

- bf.madd 添加多个元素

- bf.mexists 判断多个元素是否存在

连接客户端进行测试,如果指令有效则证明集成成功

如果出现如下情况(error) ERR unknown command ,可以通过如下方法检查:

- SHUTDOWN Redis实例,再重启实例,再次测试

- 检查配置文件是否配置redisbloom.so文件地址正确

- 检查Redis的版本是否过低

![]()

布隆过滤器(Bloom Filter)是1970年由布隆提出的。它实际上是一个很长的二进制向量和一系列随机映射函数。布隆过滤器可以用于检索一个元素是否在一个集合中。它的优点是空间效率和查询时间都比一般的算法要好的多,缺点是有一定的误识别率和删除困难。

上面这句介绍比较全面的描述了什么是布隆过滤器,如果还是不太好理解的话,就可以把布隆过滤器理解为一个set集合,我们可以通过add往里面添加元素,通过contains来判断是否包含某个元素。由于本文讲述布隆过滤器时会结合Redis来讲解,因此类比为Redis中的Set数据结构会比较好理解,而且Redis中的布隆过滤器使用的指令与Set集合非常类似(后续会讲到)。

学习布隆过滤器之前有必要先聊下它的优缺点,因为好的东西我们才想要嘛!

布隆过滤器的优点:

- 时间复杂度低,增加和查询元素的时间复杂为O(N),(N为哈希函数的个数,通常情况比较小)

- 保密性强,布隆过滤器不存储元素本身

- 存储空间小,如果允许存在一定的误判,布隆过滤器是非常节省空间的(相比其他数据结构如Set集合)

布隆过滤器的缺点:

- 有点一定的误判率,但是可以通过调整参数来降低

- 无法获取元素本身

- 很难删除元素

布隆过滤器可以告诉我们** “某样东西一定不存在或者可能存在”,也就是说布隆过滤器说这个数不存在则一定不存,布隆过滤器说这个数存在可能不存在(误判,后续会讲),**利用这个判断是否存在的特点可以做很多有趣的事情。

- 解决Redis缓存穿透问题(面试重点)

- 邮件过滤,使用布隆过滤器来做邮件黑名单过滤

- 对爬虫网址进行过滤,爬过的不再爬

- 解决新闻推荐过的不再推荐(类似抖音刷过的往下滑动不再刷到)

- HBase\RocksDB\LevelDB等数据库内置布隆过滤器,用于判断数据是否存在,可以减少数据库的IO请求

6.2.3.1 数据结构

布隆过滤器它实际上是一个很长的二进制向量和一系列随机映射函数。以Redis中的布隆过滤器实现为例,Redis中的布隆过滤器底层是一个大型位数组(二进制数组)+多个无偏hash函数。

一个大型位数组(二进制数组):

多个无偏hash函数:

无偏hash函数就是能把元素的hash值计算的比较均匀的hash函数,能使得计算后的元素下标比较均匀的映射到位数组中。

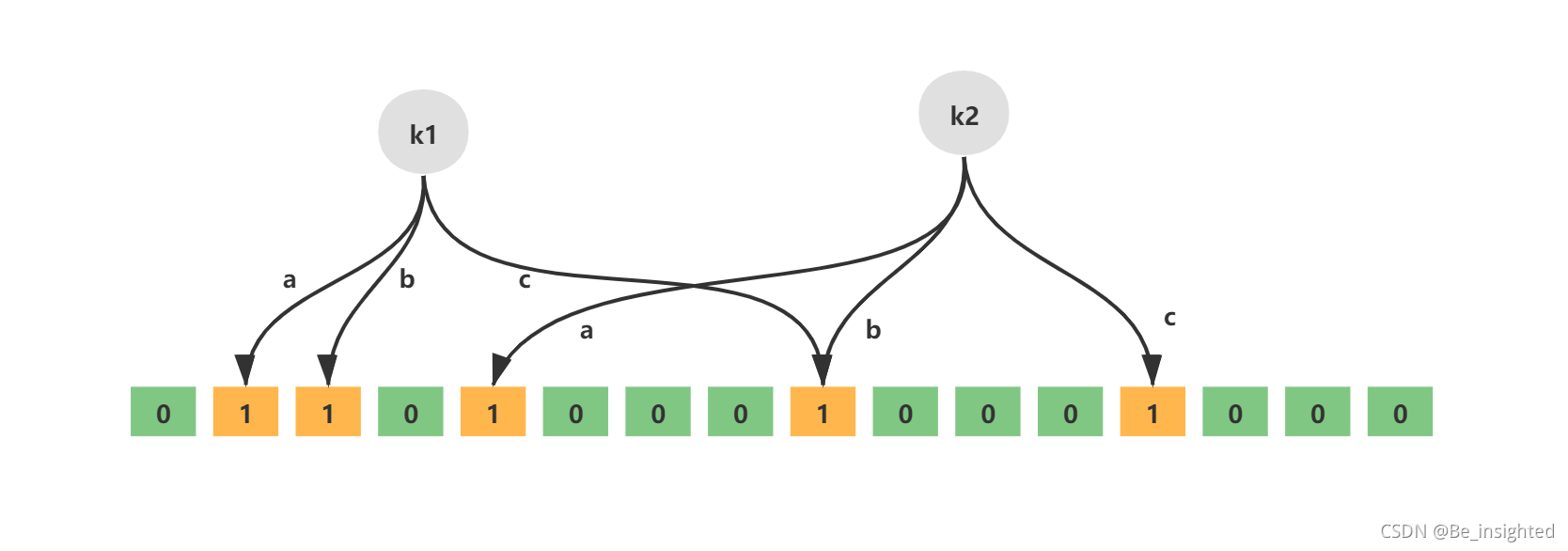

如下就是一个简单的布隆过滤器示意图,其中k1、k2代表增加的元素,a、b、c即为无偏hash函数,最下层则为二进制数组。

6.2.3.2 空间计算

在布隆过滤器增加元素之前,首先需要初始化布隆过滤器的空间,也就是上面说的二进制数组,除此之外还需要计算无偏hash函数的个数。布隆过滤器提供了两个参数,分别是预计加入元素的大小n,运行的错误率f。布隆过滤器中有算法根据这两个参数会计算出二进制数组的大小l,以及无偏hash函数的个数k。

它们之间的关系比较简单:

- 错误率越低,位数组越长,控件占用较大

- 错误率越低,无偏hash函数越多,计算耗时较长

如下地址是一个免费的在线布隆过滤器在线计算的网址:

Bloom Filter Calculator Bloom Filter Calculator

Bloom Filter Calculator

6.2.3.3 增加元素

往布隆过滤器增加元素,添加的key需要根据k个无偏hash函数计算得到多个hash值,然后对数组长度进行取模得到数组下标的位置,然后将对应数组下标的位置的值置为1

- 通过k个无偏hash函数计算得到k个hash值

- 依次取模数组长度,得到数组索引

- 将计算得到的数组索引下标位置数据修改为1

例如,key = Liziba,无偏hash函数的个数k=3,分别为hash1、hash2、hash3。三个hash函数计算后得到三个数组下标值,并将其值修改为1.

如图所示:

6.2.3.4 查询元素

布隆过滤器最大的用处就在于判断某样东西一定不存在或者可能存在,而这个就是查询元素的结果。其查询元素的过程如下:

- 通过k个无偏hash函数计算得到k个hash值

- 依次取模数组长度,得到数组索引

- 判断索引处的值是否全部为1,如果全部为1则存在(这种存在可能是误判),如果存在一个0则必定不存在

关于误判,其实非常好理解,hash函数在怎么好,也无法完全避免hash冲突,也就是说可能会存在多个元素计算的hash值是相同的,那么它们取模数组长度后的到的数组索引也是相同的,这就是误判的原因。例如李子捌和李子柒的hash值取模后得到的数组索引都是1,但其实这里只有李子捌,如果此时判断李子柒在不在这里,误判就出现啦!因此布隆过滤器最大的缺点误判只要知道其判断元素是否存在的原理就很容易明白了!

6.2.3.5 修改元素

无

6.2.3.6 删除元素

布隆过滤器对元素的删除不太支持,目前有一些变形的特定布隆过滤器支持元素的删除!关于为什么对删除不太支持,其实也非常好理解,hash冲突必然存在,删除肯定是很苦难的!

6.2.4.1 版本要求

- 推荐版本6.x,最低4.x版本,可以通过如下命令查看版本:

redis-server -v

![]()

- 插件安装,网上大部分推荐v1.1.1,文章写的时候v2.2.6已经是release版本了,用户自己选择,地址全在下面(2.2.6官网介绍说是1.0版本的维护版本,如果不想使用新的功能,无需升级!)

v1.1.1

https://github.com/RedisLabsModules/rebloom/archive/v1.1.1.tar.gz

v2.2.6

https://github.com/RedisLabsModules/rebloom/archive/v2.2.6.tar.gz

6.2.4.2 安装&编译

以下安装全部在指定目录下完成,可以选择一个合适的统一目录进行软件安装和管理。

6.2.4.2.1 下载插件压缩包

wget https://github.com/RedisLabsModules/rebloom/archive/v2.2.6.tar.gz

6.2.4.2.2 解压

tar -zxvf v2.2.6.tar.gz

6.2.4.2.3 编译插件

- cd RedisBloom-2.2.6/

- make

编译成功后看到redisbloom.so文件即可

6.2.4.3 Redis集成

6.2.4.3.1 Redis配置文件修改

- 在redis.conf配置文件中加入如RedisBloom的redisbloom.so文件的地址

- 如果是集群则每个配置文件中都需要加入redisbloom.so文件的地址

- 添加完成后需要重启redis

loadmodule /usr/local/soft/RedisBloom-2.2.6/redisbloom.so

redis.conf配置文件中预置了loadmodule的配置项,我们可以直接在这里修改,后续修改会更加方便。

保存退出后一定要记得重启Redis!

保存退出后一定要记得重启Redis!

保存退出后一定要记得重启Redis!

6.2.4.3.2 测试是否成功

Redis集成布隆过滤器的主要指令如下:

- bf.add 添加一个元素

- bf.exists 判断一个元素是否存在

- bf.madd 添加多个元素

- bf.mexists 判断多个元素是否存在

连接客户端进行测试,如果指令有效则证明集成成功

如果出现如下情况(error) ERR unknown command ,可以通过如下方法检查:

- SHUTDOWN Redis实例,再重启实例,再次测试

- 检查配置文件是否配置redisbloom.so文件地址正确

- 检查Redis的版本是否过低

6.2.5.1 bf.add

bf.add表示添加单个元素,添加成功返回1

- 127.0.0.1:6379> bf.add name liziba

- (integer) 1

![]()

6.2.5.2 bf.madd

bf.madd表示添加多个元素

- 127.0.0.1:6379> bf.madd name liziqi lizijiu lizishi

- 1) (integer) 1

- 2) (integer) 1

- 3) (integer) 1

6.2.5.3 bf.exists

bf.exists表示判断元素是否存在,存在则返回1,不存在返回0

- 127.0.0.1:6379> bf.mexists name liziba

- 1) (integer) 1

![]()

6.2.5.3 bf.mexists

bf.mexists表示判断多个元素是否存在,存在的返回1,不存在的返回0

- 127.0.0.1:6379> bf.mexists name liziqi lizijiu liziliu

- 1) (integer) 1

- 2) (integer) 1

- 3) (integer) 0

使用布隆过滤器的方式有很多,还有很多大佬自己手写的,我这里使用的是谷歌guava包中实现的布隆过滤器,这种方式的布隆过滤器是在本地内存中实现。

6.2.6.1 引入pom依赖

- <dependency>

- <groupId>com.google.guava</groupId>

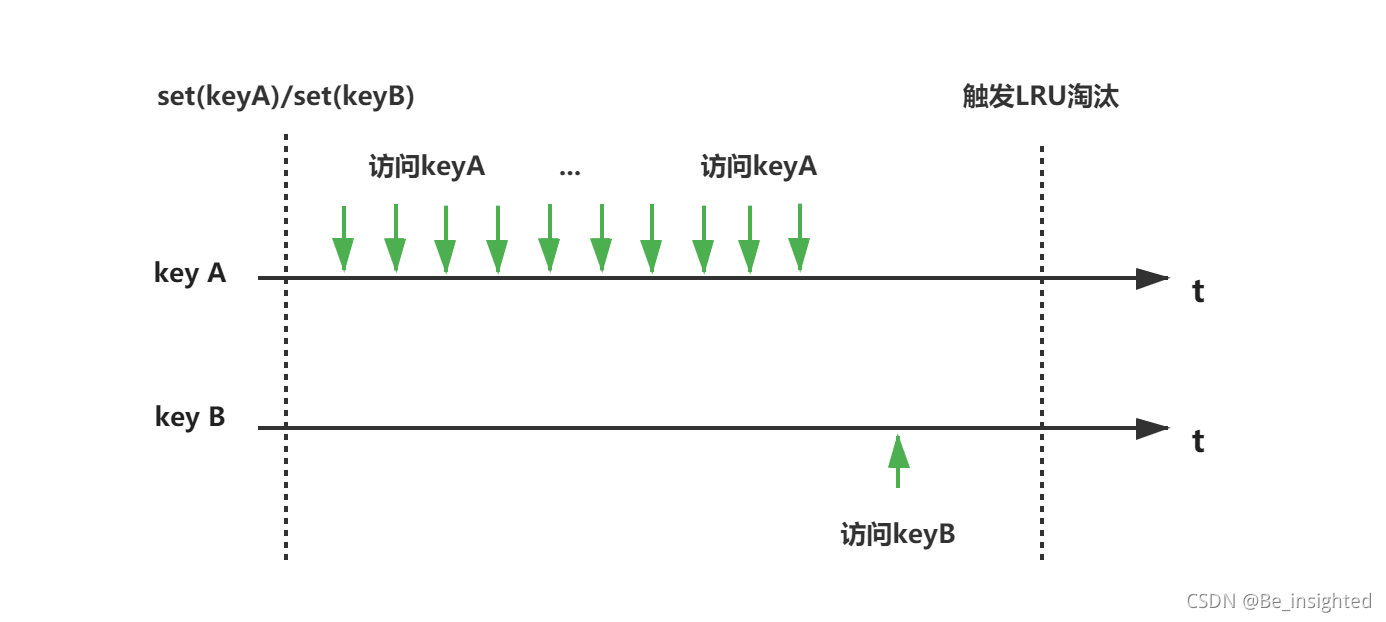

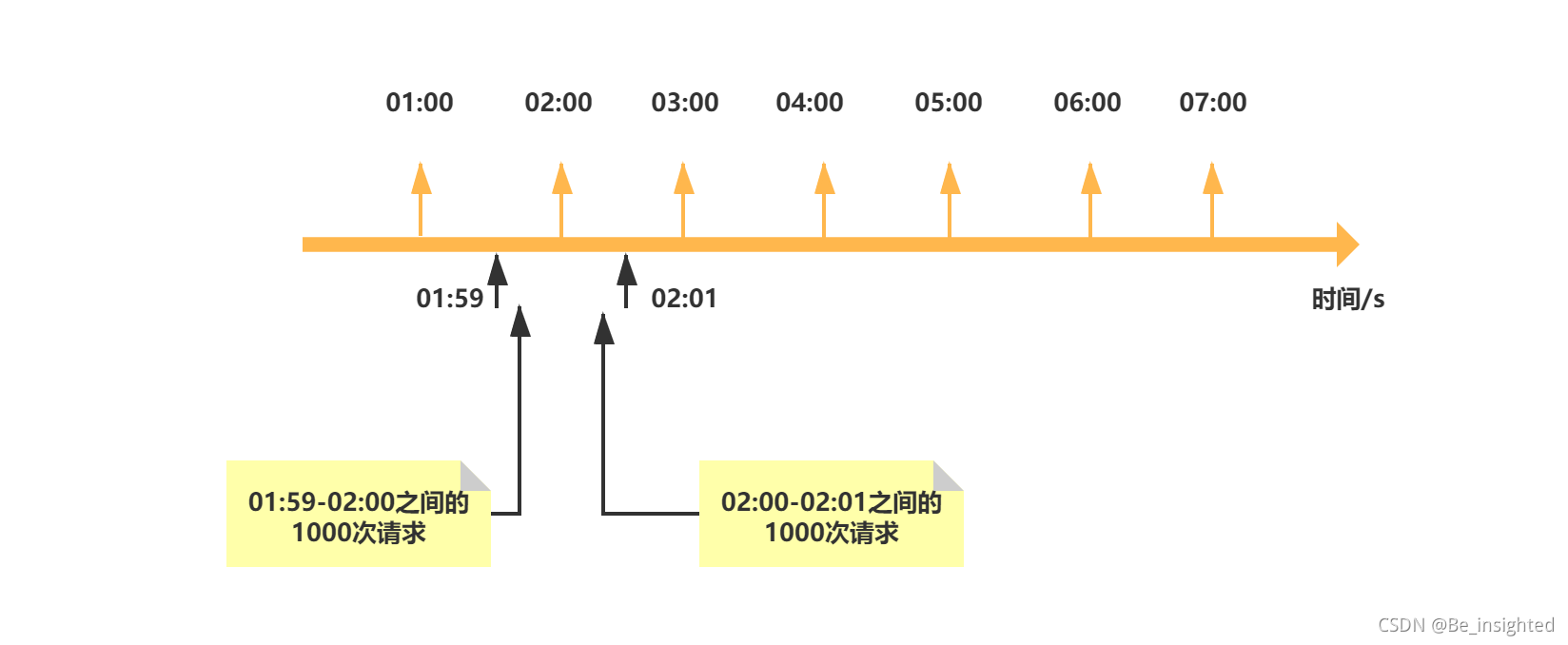

- <artifactId>guava</artifactId>