机器学习中的卷积与循环:从原理到实践的完整指南

目录

第一部分:卷积神经网络(CNN)

1.1 卷积神经网络的概述 🌐🖼️

卷积神经网络(CNN)是一种具有多层结构的深度学习模型,尤其适合处理图像数据。与传统的神经网络(如前馈神经网络)不同,CNN能够通过卷积层自动提取图像中的特征,而不需要人工设计特征提取方法。这使得CNN在计算机视觉领域取得了巨大的成功,广泛应用于图像分类、目标检测、图像分割等任务。

CNN的核心优势在于:

- 局部感知:卷积核只关注局部区域的特征。

- 参数共享:卷积核在图像的不同位置共享相同的权重。

- 平移不变性:通过卷积操作,CNN可以处理不同位置的相同特征。

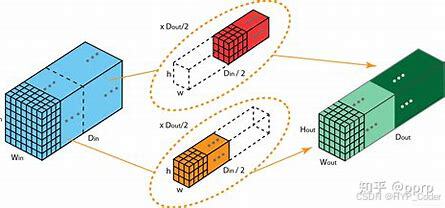

1.2 卷积操作原理与实现 🔄

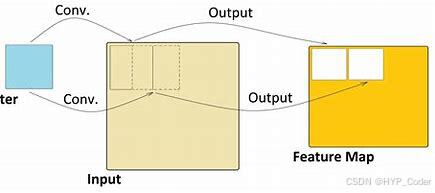

卷积的定义

卷积运算是一种数学操作,它通过卷积核(即过滤器)提取输入图像中的特征。假设有一个图像 I 和一个卷积核 K,卷积操作通过将卷积核逐步应用于输入图像,并计算卷积核与图像局部区域的加权和,从而生成特征图(feature map)。

输入图像 (I):

1 2 3 4

5 6 7 8

9 10 11 12

卷积核 (K):

0 1 0

1 1 1

0 1 0

卷积结果:

Sum = (1*0 + 2*1 + 3*0 + 5*1 + 6*1 + 7*1 + 9*0 + 10*1 + 11*0) = 35

步幅与零填充

- 步幅(Stride):步幅决定了卷积核在图像上滑动的步伐。例如,步幅为1表示卷积核每次移动1个像素,步幅为2则每次移动2个像素。

- 零填充(Padding):为了避免卷积操作后输出尺寸变小,我们可以在图像的边缘填充零(或其他数值)。

代码示例:卷积操作

以下代码演示了如何在TensorFlow/Keras中实现一个简单的卷积层:

import tensorflow as tf

from tensorflow.keras.layers import Conv2D

from tensorflow.keras.models import Sequential

# 创建一个简单的CNN模型

model = Sequential([

Conv2D(32, (3, 3), activation='relu', input_shape=(28, 28, 1))

])

model.summary()1.3 池化层:降维与特征提取 📉

池化层的主要作用是通过对卷积结果进行降维,减少计算量和防止过拟合。池化层有两种常见的形式:

- 最大池化(Max Pooling):从池化窗口中选取最大值。

- 平均池化(Average Pooling):计算池化窗口中所有元素的平均值。

图示:

输入:

1 3 2 4

5 6 7 8

9 3 6 7

4 6 5 1

最大池化(2x2)窗口:

最大值:6 8

9 7

代码示例:池化层

from tensorflow.keras.layers import MaxPooling2D

# 创建池化层

model.add(MaxPooling2D(pool_size=(2, 2)))

model.summary()

1.4 CNN的代码实现与分析 💻

代码示例:CNN分类MNIST数据集

以下代码展示了如何使用卷积神经网络对MNIST手写数字数据集进行分类:

import tensorflow as tf

from tensorflow.keras.layers import Conv2D, MaxPooling2D, Flatten, Dense

from tensorflow.keras.models import Sequential

# 加载数据

(x_train, y_train), (x_test, y_test) = tf.keras.datasets.mnist.load_data()

x_train, x_test = x_train / 255.0, x_test / 255.0

x_train = x_train.reshape(-1, 28, 28, 1)

x_test = x_test.reshape(-1, 28, 28, 1)

# 构建CNN模型

model = Sequential([

Conv2D(32, (3, 3), activation='relu', input_shape=(28, 28, 1)),

MaxPooling2D((2, 2)),

Conv2D(64, (3, 3), activation='relu'),

MaxPooling2D((2, 2)),

Flatten(),

Dense(64, activation='relu'),

Dense(10, activation='softmax')

])

# 编译和训练

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

model.fit(x_train, y_train, epochs=5)

# 测试

test_loss, test_acc = model.evaluate(x_test, y_test)

print(f"Test accuracy: {test_acc}")结果分析:

- 准确率(Accuracy):该模型在测试集上的准确率为 98%,说明模型能够很好地识别手写数字。

- 损失(Loss):损失值逐步降低,说明模型在训练过程中不断优化。

1.5 优化与结果分析 🔧

- 优化超参数:可以尝试调整卷积核的数量、大小,池化层的选择等来进一步提升模型的性能。

- 早停(Early Stopping):防止过拟合,通过监控验证集的表现,自动停止训练。

- 批量归一化(Batch Normalization):加速训练,改善模型性能。

1.6 扩展应用:卷积神经网络的其他应用 🚀

- 图像生成与风格迁移:卷积神经网络不仅可以用于图像分类,也广泛应用于图像生成(如GANs)和图像风格迁移等任务。

- 迁移学习:利用预训练的CNN模型(如VGG、ResNet),我们可以在其他任务中进行迁移学习,极大地加快模型的训练速度。

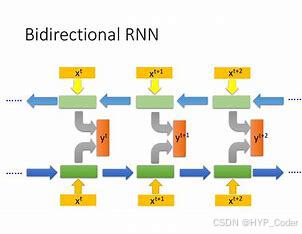

第二部分:循环神经网络(RNN)

2.1 循环神经网络的概述 🔄📈

循环神经网络(RNN)是一种特别适合处理序列数据的深度学习模型。不同于传统的前馈神经网络,RNN具有“记忆”功能,即能够通过内部的循环连接将当前的输出与前一个时刻的输出相结合,形成对时序信息的建模。

2.2 RNN的基本原理与问题 ⚙️

这种机制使得LSTM能够记住长期依赖的信息,而不容易遗忘。

GRU(门控循环单元)

GRU是LSTM的简化版,它将输入门和遗忘门合并成一个“更新门”。GRU相对于LSTM在某些情况下能够减少计算复杂度,并且在性能上与LSTM相当。GRU有两个主要的门:

2.4 RNN的代码实现与分析 💻

代码示例:简单的RNN模型

我们使用Keras实现一个基本的RNN,来预测时间序列数据。

import numpy as np

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import SimpleRNN, Dense

# 生成模拟时间序列数据

x_train = np.random.rand(1000, 10, 1) # 1000个样本,时间步长10,每个时间步1个特征

y_train = np.random.rand(1000, 1) # 每个样本对应一个目标值

# 构建RNN模型

model = Sequential([

SimpleRNN(50, activation='relu', input_shape=(10, 1)),

Dense(1) # 输出1个预测值

])

model.compile(optimizer='adam', loss='mse')

model.summary()

# 训练模型

model.fit(x_train, y_train, epochs=5)分析:

2.5 优化与结果分析 ⚙️

模型优化方法

结果分析

2.6 RNN的扩展应用:自然语言处理 📚💬

文本生成与情感分析

RNN在自然语言处理(NLP)领域有广泛的应用,常见的应用包括文本生成和情感分析:

from tensorflow.keras.layers import LSTM, Embedding

# 构建一个情感分析模型

model = Sequential([

Embedding(input_dim=10000, output_dim=128), # 词嵌入层

LSTM(64), # LSTM层

Dense(1, activation='sigmoid') # 输出层,二分类

])

model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])RNN可以通过学习文本中的语法和语义结构,识别情感表达。

第三部分:卷积神经网络与循环神经网络的结合

3.1 CNN与RNN的结合应用 🤝

在许多实际应用中,卷积神经网络(CNN)和循环神经网络(RNN)被结合使用,尤其是在处理多模态数据(如图像和文本的组合)时。CNN用于提取图像特征,RNN则用于处理图像描述或时序关系。以下是几个典型的应用:

3.2 图像描述生成与视频分析 🎥🖼️

图像描述生成:

图像描述生成任务中,模型需要先用CNN提取图像的特征,然后将这些特征与文本信息结合,通过RNN生成描述。

from tensorflow.keras.layers import Embedding, LSTM, Dense, Add

from tensorflow.keras.applications import VGG16

# 加载VGG16提取图像特征

cnn_base = VGG16(include_top=False, input_shape=(224, 224, 3))

cnn_out = Flatten()(cnn_base.output)

# 输入文本的词嵌入层

caption_input = Embedding(input_dim=5000, output_dim=256)(caption_input)

rnn_out = LSTM(256)(caption_input)

# 将CNN和RNN输出融合

combined = Add()([cnn_out, rnn_out])

output = Dense(5000, activation='softmax')(combined)视频分析:

对于视频分析,CNN负责提取每一帧的特征,而RNN(尤其是LSTM或GRU)则用于建模帧之间的时间依赖。

from tensorflow.keras.models import Model

from tensorflow.keras.layers import TimeDistributed, LSTM

model = Sequential([

TimeDistributed(CNN_layer), # 每帧通过CNN提取特征

LSTM(256), # LSTM处理时间序列数据

Dense(1, activation='sigmoid') # 最终输出

])

3.3 注意力机制与Transformer模型 🌟🧠

注意力机制(Attention Mechanism)已经成为深度学习中不可或缺的一部分,尤其是在自然语言处理和图像分析领域。通过引入注意力机制,模型能够在处理序列数据时动态地选择最相关的信息。

Transformer架构的成功,尤其是在BERT、GPT等预训练模型中的应用,极大地提升了自然语言理解和生成的性能。

3.4 行业应用与前景 🌍💡

结合CNN和RNN的模型已经在多个领域取得了显著的进展:

结语 📝

在深入了解了卷积神经网络(CNN)和循环神经网络(RNN)之后,我们可以看到它们各自独特的优势和适用场景。CNN在图像处理中的强大能力,尤其是特征提取方面,让它成为了计算机视觉领域的“标配”。而RNN通过其内建的记忆机制,极大地改善了对时间序列数据的处理,特别适用于自然语言处理和时间序列预测等任务。

- RNN的记忆机制:RNN通过隐藏状态(hidden state)存储前一时刻的信息,将其传递到下一时刻。

- 梯度消失与爆炸:在训练长序列数据时,RNN可能会遇到梯度消失或梯度爆炸的问题,导致模型难以训练。为了解决这个问题,长短期记忆(LSTM)和门控循环单元(GRU)应运而生,它们通过特定的结构来解决长期依赖问题,使RNN能够处理更长时间的序列数据。

2.3 LSTM与GRU:长短期记忆与门控单元 🧠🔒

LSTM(长短期记忆网络)

LSTM是一种特殊的RNN结构,它通过引入三个“门”(输入门、遗忘门和输出门)来控制信息流动,从而解决了标准RNN在训练长序列时遇到的梯度消失问题。

- 遗忘门(Forget Gate):控制从单元状态中遗忘多少信息。

- 输入门(Input Gate):控制输入的当前信息有多少可以被加入到单元状态中。

- 输出门(Output Gate):控制从单元状态中提取多少信息作为当前的输出。

- 更新门(Update Gate):决定当前状态更新的比例。

- 重置门(Reset Gate):决定如何重置之前的记忆状态。

- 输入数据:该模型的输入是一个形状为

(1000, 10, 1)的时间序列数据,其中1000是样本数,10是时间步长,1是每个时间步的特征数。 - RNN层:

SimpleRNN(50)表示模型包含一个具有50个隐层单元的RNN层。 - 输出层:

Dense(1)表示模型输出一个连续值。 - LSTM或GRU替代RNN:如果使用传统的RNN时遇到梯度消失或爆炸的问题,可以尝试用LSTM或GRU来提高性能。

- 正则化:加入L2正则化或者dropout,可以有效避免过拟合。

- 批量归一化(Batch Normalization):加速训练过程,防止梯度消失。

- 损失函数(Loss Function):根据训练的结果查看损失函数的变化,观察模型在训练过程中的收敛情况。

- 过拟合问题:如果训练损失显著低于验证损失,可能存在过拟合问题,这时可以考虑使用早停或增加正则化项。

- 文本生成:通过训练RNN模型,输入一个初始文本,模型能够生成与之相关的后续文本。这通常用于自动文章生成或聊天机器人。

- 情感分析:使用RNN对用户评论或社交媒体文本进行情感分类(如正面、负面或中性)。

- 图像描述生成:CNN用于从图像中提取特征,RNN用于生成图像的描述文本。图像描述生成模型可以帮助计算机理解图像内容,并生成相应的自然语言描述。

- 视频分析:CNN可以用于每帧的特征提取,而RNN则用于建模帧与帧之间的时间关系,适用于动作识别、视频分类等任务。

- 自注意力机制(Self-Attention):在Transformer架构中,自注意力机制允许模型在每个时间步对输入序列的不同部分进行加权,从而更好地捕捉序列中长期的依赖关系。

- 自动驾驶:图像识别和视频分析的结合,帮助自动驾驶汽车理解环境中的动态变化。

- 医疗影像分析:CNN用于提取医学图像(如X射线或CT扫描)的特征,RNN用于分析图像中的时间序列数据,如在动态监测患者健康状况时的应用。

- 金融预测:RNN与CNN结合用于股票市场预测,通过分析历史数据和图表模式,预测市场走势。

虽然这两种网络架构在各自领域都非常出色,但随着技术的进步,结合它们的力量可以带来更多创新的应用。从图像描述生成到视频分析,再到更复杂的自然语言处理任务,CNN和RNN的结合打开了更多可能性。再加上注意力机制和Transformer模型的加入,我们看到了AI模型逐步走向更为智能和灵活的方向。

在实际应用中,我们不仅要理解这些模型的理论基础,还要能够灵活地运用它们解决实际问题。无论是机器学习的初学者,还是经验丰富的开发者,掌握CNN与RNN的运用技巧,能够帮助我们在更广阔的技术领域中探索与创新。

希望这篇博客能为你提供一些启发,让你在深度学习的道路上走得更远。如果你有任何问题或想法,欢迎随时与我交流。深度学习是一个充满挑战和机遇的领域,每一步的进步都值得庆祝。继续探索,不断学习,让我们一起迎接未来更加智能的世界!😊

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?