前沿科技速递🚀

随着文本大模型的发展,解码器架构已经成为文本处理任务的标准。然而,现有的多模态大模型架构却尚未统一,不同模型在选择 LLM 主干、视觉编码器以及训练数据上存在较大差异,且无法直接进行对比研究。为了解决这些问题,英伟达研究团队推出了 NVLM 1.0,通过创新的模型设计和数据处理方法,极大提升了多模态推理能力和训练效率。

来源:传神社区

01 模型简介

英伟达最近推出了NVLM 1.0,这是一款多模态大型语言模型,在视觉-语言任务上表现出色,能够与最强的闭源模型(如GPT-4o)以及开源模型(如LLaMA 3-V 405B 和 InternVL 2)相媲美。值得关注的是,NVLM 1.0 不仅在多模态任务中表现优异,甚至在纯文本任务上也有所突破。经过多模态训练后,NVLM 1.0 在文本任务中的表现相比其基础语言模型(LLM)主干有明显提升,特别是在数学和代码生成基准测试中,平均准确率提高了 4.3 个百分点。

NVLM 1.0 在处理多模态任务时,能够高效处理包括文本、图像和高分辨率视觉输入等多种形式的数据,大幅提升了 OCR、视觉问答(VQA)、文档理解等复杂任务的性能。同时,研究团队深入比较了纯解码器模型与交叉注意力模型的优缺点,提出了一种全新的架构设计,进一步优化了高分辨率图像处理的效率,确保了模型在纯文本任务中的表现不仅不下降,反而有所提高。

02 核心架构:三大模型设计

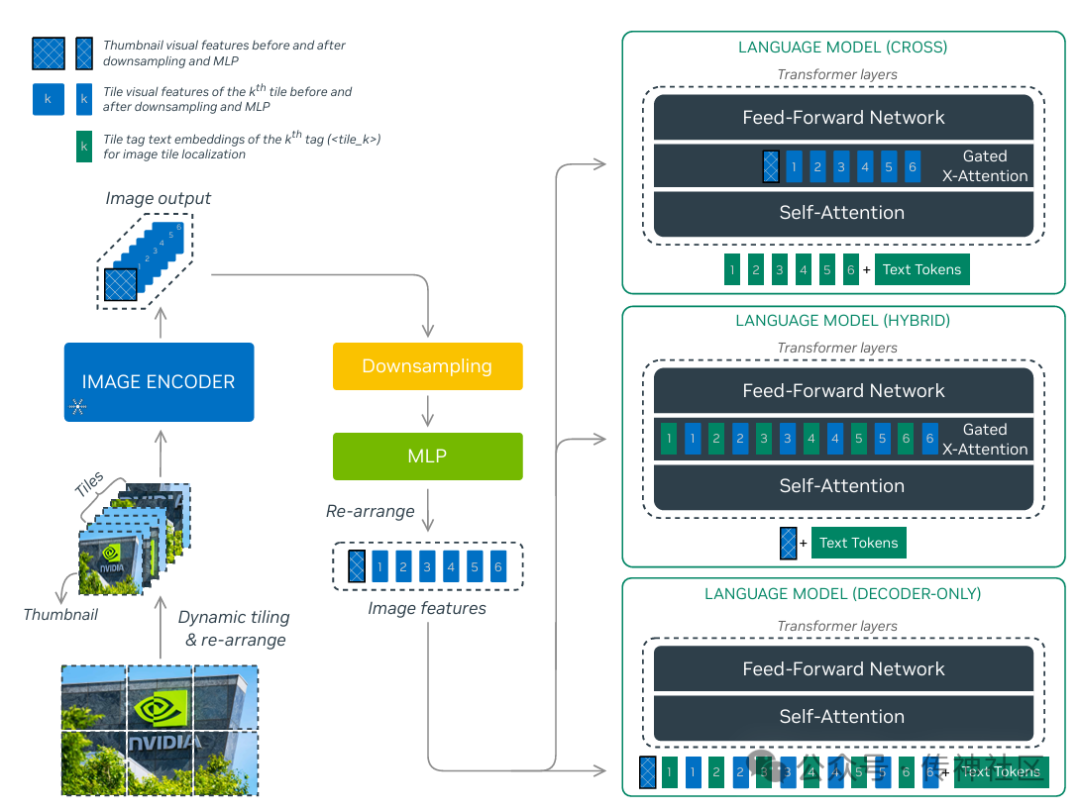

NVLM 1.0 包含三种不同的架构,分别是解码器模型(NVLM-D)、交叉注意力模型(NVLM-X)和混合模型(NVLM-H)。每种架构针对不同的任务需求进行优化:

-

NVLM-D:解码器架构该模型采用解码器架构,视觉信息通过多层感知机(MLP)转换为文本嵌入,并统一输入到LLM(大语言模型)中进行处理。解码器架构的特点是可以将所有输入(无论是图像还是文本)作为统一的token进行处理,因此特别适合OCR任务,能够准确识别图像中的文字信息。

-

NVLM-X:交叉注意力架构NVLM-X采用交叉注意力机制,在处理图像信息时通过专门的注意力层来读取视觉编码器的输出。该架构在处理高分辨率图像和视觉推理任务时效率更高,特别适合处理复杂的视觉问答、图表分析以及文档理解任务。

-

NVLM-H:混合架构NVLM-H结合了解码器和交叉注意力的优势,文本和缩略图通过解码器的自注意力机制处理,而详细的图像信息则通过交叉注意力机制处理。这种设计不仅保持了高效的计算性能,还增强了模型在高分辨率图像任务中的表现,是一个平衡性能和计算效率的最佳方案。

03 评测结果

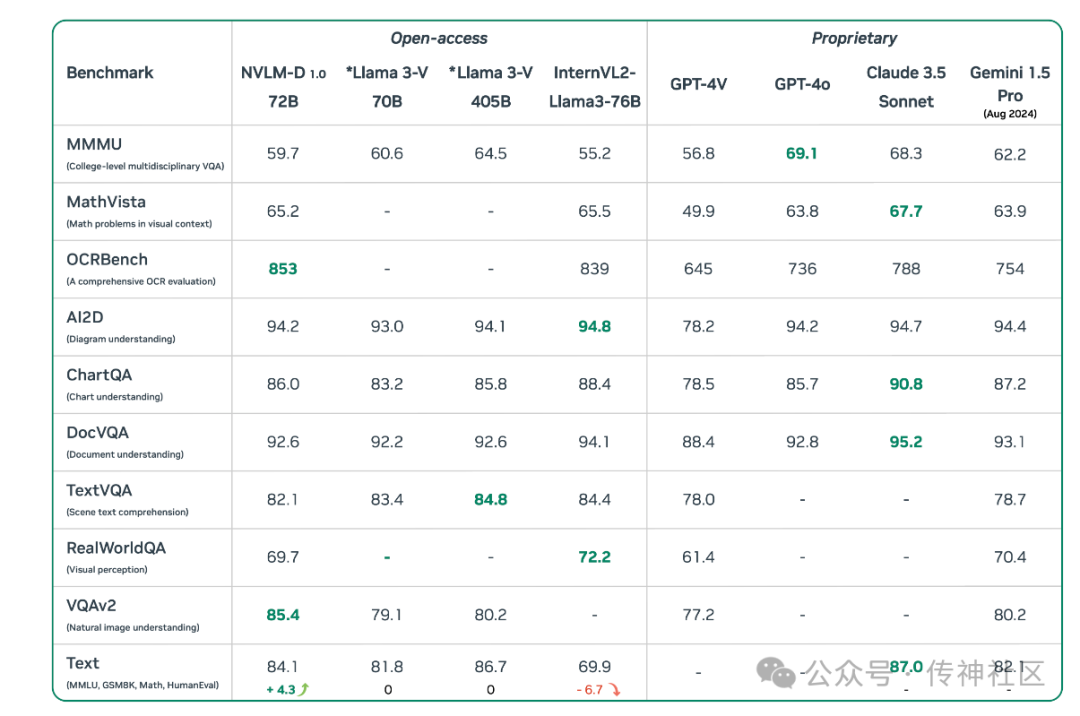

为了评估NVLM 1.0在多模态任务中的表现,NVIDIA团队对模型进行了多项基准测试,涵盖了视觉语言任务和文本任务。以下是NVLM 1.0的主要评测结果:

1. OCR任务

NVLM-D在OCR相关的任务(如OCRBench测试)中表现尤为突出,取得了全场最高得分。无论是文档图像中的文本识别,还是复杂场景中的字符识别,NVLM-D均展现出了强大的准确性和鲁棒性。

2. 多模态推理任务

NVLM-H在多模态推理任务(如MathVista和MMMU测试)中表现优异,特别是在几何图形、函数图和表格等场景下的数学推理任务中取得了领先的成绩。这表明,NVLM 1.0不仅能够处理简单的视觉任务,还具备了处理复杂推理问题的能力。

3. 视觉问答(VQA)

在自然图像理解和视觉问答任务(如VQAv2和TextVQA测试)中,NVLM-X取得了与当前最先进的模型相当的成绩。模型能够精准理解图像中的内容,并根据上下文生成准确的答案,展示了卓越的视觉感知和语言生成能力。

4. 文本任务

值得一提的是,NVLM 1.0在多模态训练过程中,不仅没有牺牲文本生成和推理任务的性能,反而在数学推理和代码生成等任务中展现了比基础语言模型更强的表现。这得益于NVLM 1.0在训练过程中加入了高质量的纯文本数据以及大量的多模态数学推理数据,从而提升了模型的跨模态推理能力。

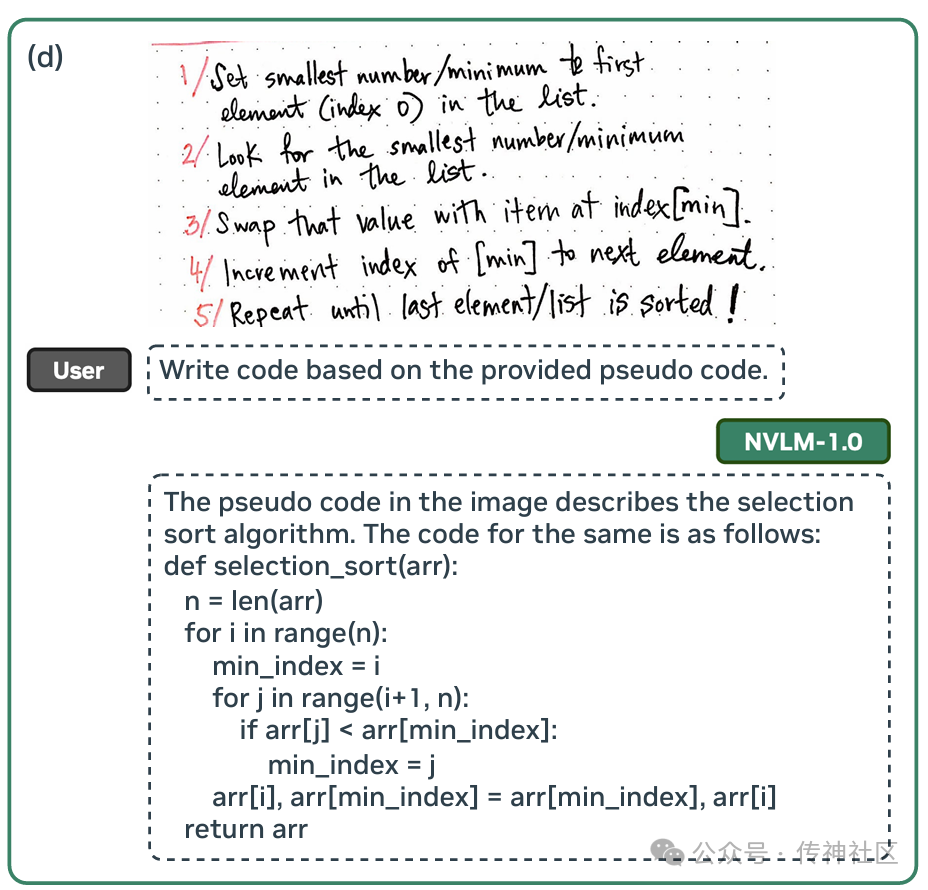

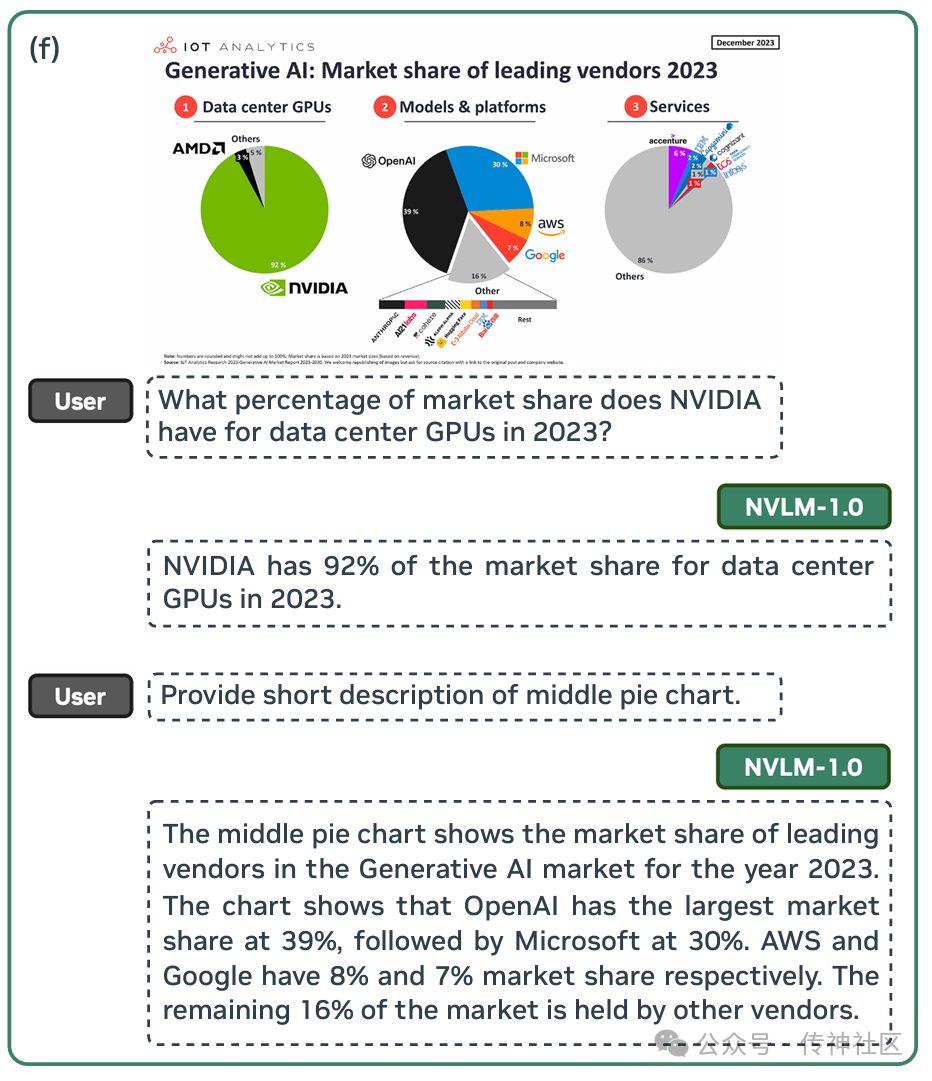

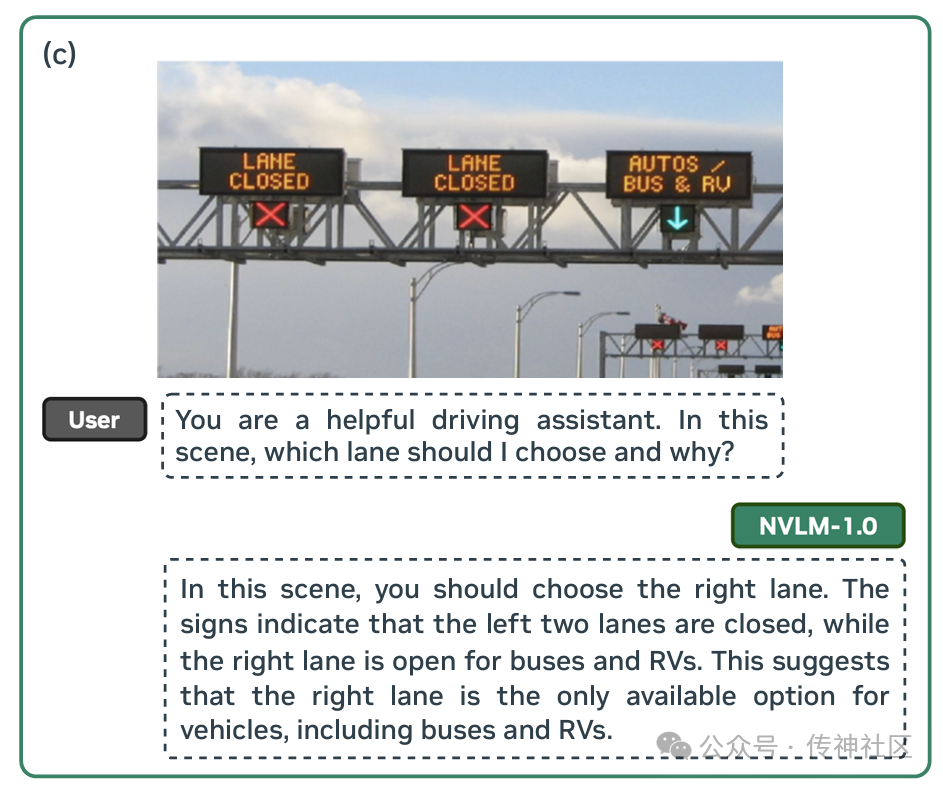

04 实例评测

为了验证NVLM 1.0在多模态任务中的实际表现,对模型的多项任务处理能力进行了测试,涵盖排序算法理解、市场份额分析、驾驶辅助决策等多领域任务。以下为详细的实例评测结果:

05 模型下载

传神社区:

模型权重还未发布,尽请期待~

欢迎加入传神社区

•贡献代码,与我们一同共建更好的OpenCSG

•Github主页

欢迎🌟:https://github.com/OpenCSGs

•Huggingface主页

欢迎下载:https://huggingface.co/opencsg

•加入我们的用户交流群,分享经验

扫描上方二维码添加传神小助手

“ 关于OpenCSG

开放传神(OpenCSG)成立于2023年,是一家致力于大模型生态社区建设,汇集人工智能行业上下游企业链共同为大模型在垂直行业的应用提供解决方案和工具平台的公司。

关注OpenCSG

加入传神社区

6999

6999

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?