点击上方“3D视觉工坊”,选择“星标”

干货第一时间送达

标题:Probabilistic 3D MultiModal,MultiObject Tracking forAutonomous Driving

作者:Hsu-kuang Chiu, Antonio Prioletti, Jie Li, and Jeannette Bohg

来源:ICRA 2021

编译:廖邦彦

审核:lionheart

摘要

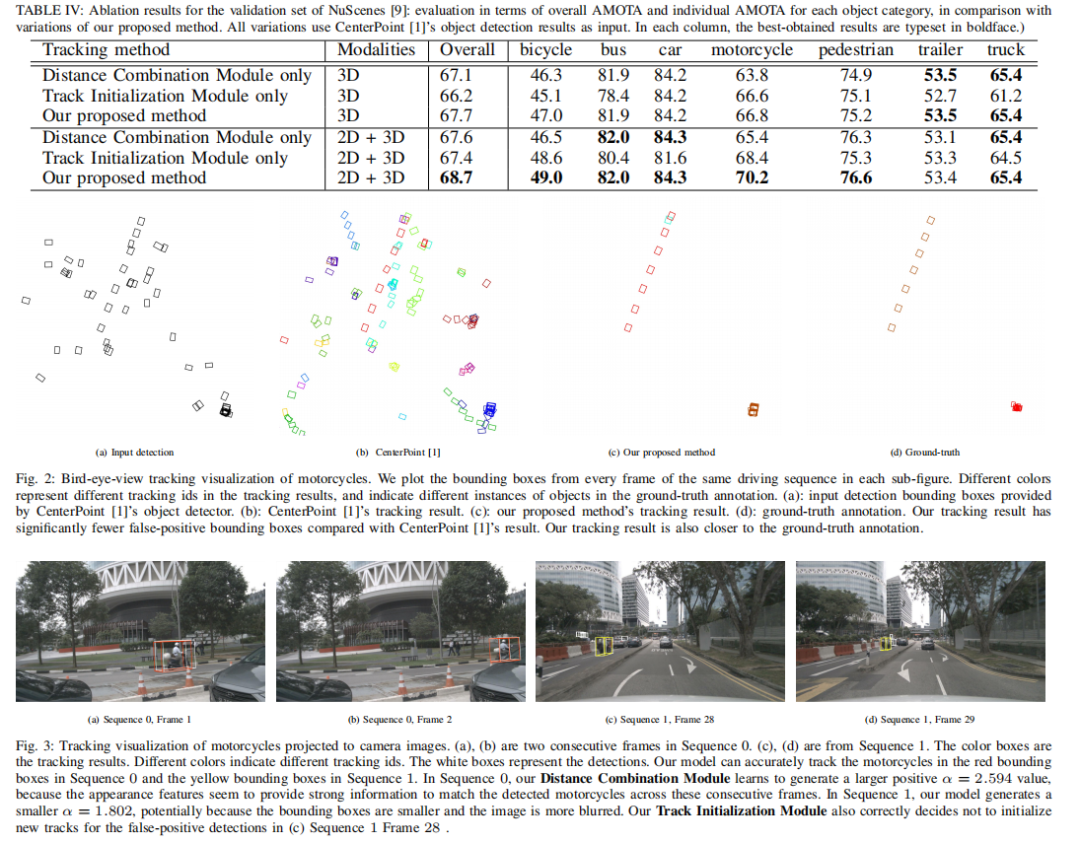

多目标跟踪是确保自动驾驶车辆能够安全在交通场景进行导航的一个重要能力。目前的SOTA算法延续着使用检测来实现跟踪的范式,这种范式通过一些距离度量将当前的跟踪目标与检测到的目标进行数据关联。提高跟踪精度的关键挑战在于数据关联和跟踪目标的生命周期管理。我们提出了一个基于概率的多模态,多目标跟踪系统,包含不同的可训练的模块,能够提供鲁棒且基于数据驱动的跟踪结果。第一,我们通过基于学习的方法融合来自2D图像上的特征和3D雷达点云来获得一个目标的外表以及几何信息。第二,我们提出通过学习一个混合了马氏以及特征距离的度量,当我们比较一个跟踪目标与新检测的目标在数据关联中时。以及第三,我们提出学习在什么时候从未匹配匹配目标中初始化一个跟踪目标。通过大量的定量和定性结果,我们表明,当使用相同的目标检测器时,我们的方法在NuSchenes和KITTI数据集上优于SOTA方法。

主要贡献

我们提出了包含三个可训练模块(距离结合,跟踪初始化,特征融合)的基于概率的多模态,多目标跟踪系统。能够提供鲁棒以及数据驱动的跟踪结果。

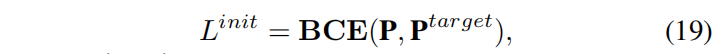

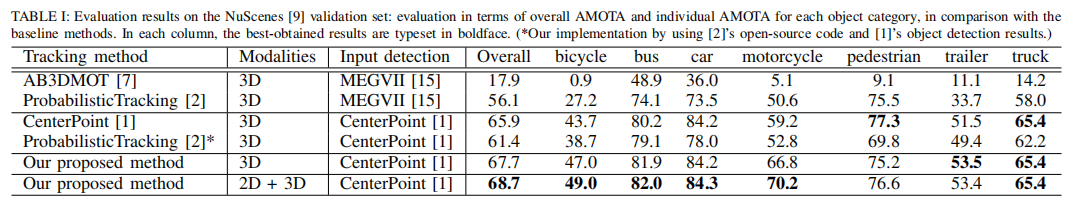

我们在NuScenes和KITTI数据集上做验证,并且使用了领先的目标检测器,检测器以3D雷达点云作为输入。我们的结果表明,我们的性能优于T. Yin2021以及X. Weng2020的方法。

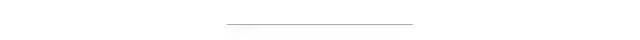

算法流程图

在第t帧时,我们使用3D检测器来提取每个检测目标的雷达点云特征以及图像特征。这些特征会进一步在特征融合模块进行融合。第t帧的融合特征以及第t 1帧的跟踪信息会在距离度量融合模块来学习一个融合了深度特征距离与马氏距离的距离度量。我们使用一个贪婪匹配算法来对融合的距离度量进行数据融合。匹配配对可以进一步使用卡尔曼滤波器来更新原有预测结果,进一步得到最终的状态结果。跟踪初始化模块将决定是否为一个未匹配成果的目标初始化一个新的跟踪线程。

方法概览

Kalman Filters

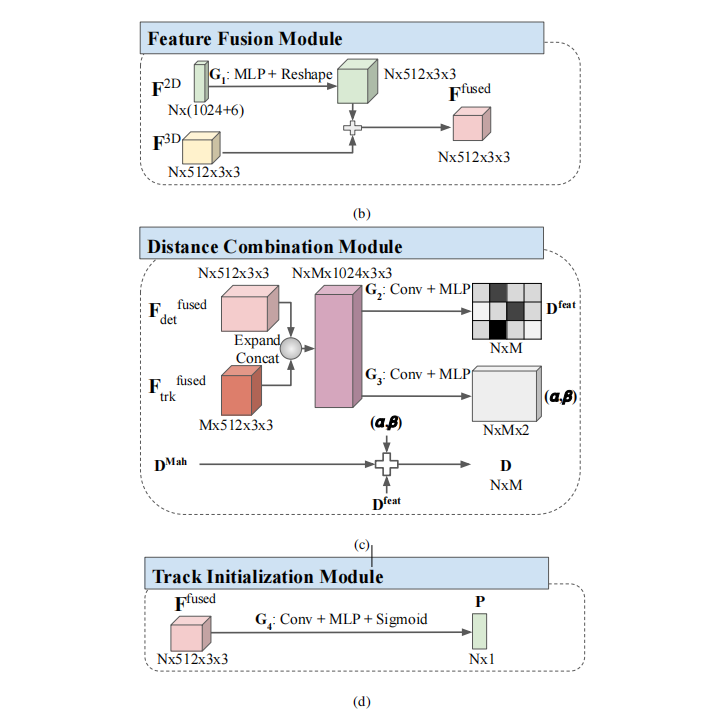

每个状态向量将使用11个变量表示

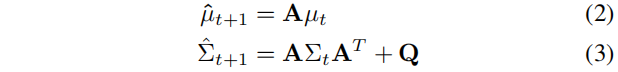

x y z代表着目标3D边界框的中心点,a表示的是目标朝向与x轴之间的夹角,l w h表示的是边界框的长宽高,以及dx dy dz da表示的是当前的x y z a与之前帧的距离误差。我们将移动目标的动力学方程建模成线性运动模型,所以我们建模成匀线速度以及角速度。我们定义预测方程如下。

μ_t定义为第t帧估计得到的真值,μ_t+1定义为第t + 1帧预测状态均值。矩阵A是状态转移矩阵。Σ_t定义为第t帧的状态协方差。矩阵Q定义为状态的噪声协方差矩阵。

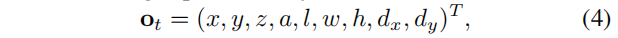

我们使用CenterPoint 3D目标检测器来为卡尔曼滤波提供观测。每帧得到的3D边界框使用9个变量来表示。

其中前7个变量与上文类似,剩下的两个d_x d_y来表示当前帧的x y与之前帧的距离。这两个值通过使用间隔时间乘以估计的速度来得到。我们采用线性的观测模型以及均值为0的高斯噪声来建模观测过程。

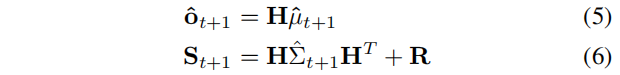

o_t+1定义为观测,矩阵H为观测矩阵,R为观测模型噪声。

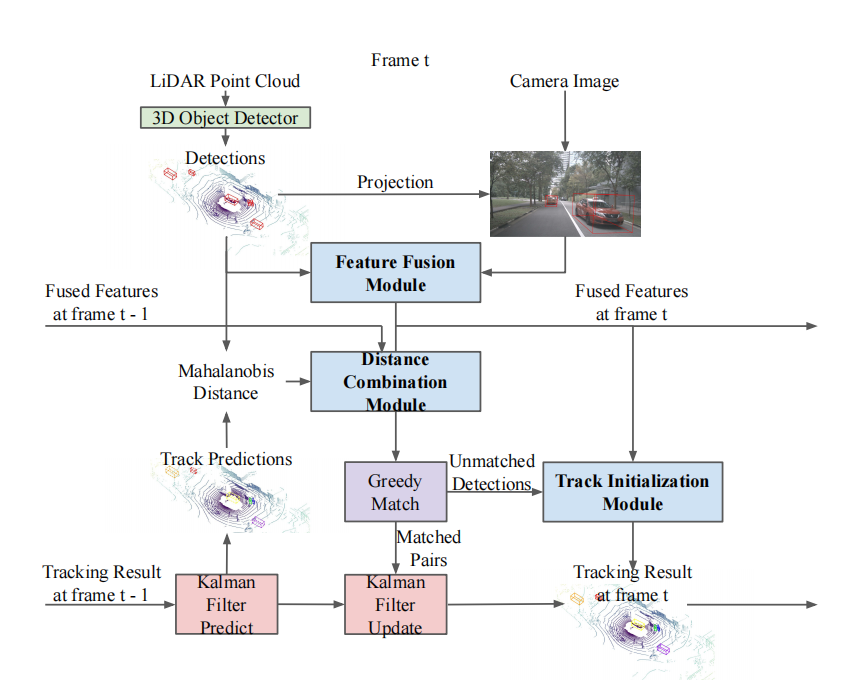

Fusion of 2D and 3D features

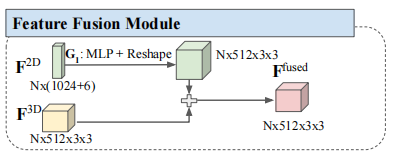

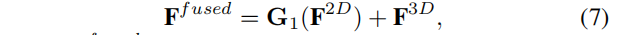

对每个观测目标,我们首先将世界坐标系下的2D的坐标(x,y)转换到到3D目标检测器的中间特征地图坐标系下。在中间特征地图中,我们提取出512*3*3雷达点云特征。与提取单一特征向量相比,我们提取的点云特征拥有更多的语义信息。我们将3D的检测边界框投影到相机平面坐标系,同时使用COCO预训练的Mask RCNN的检测器来提取出对应的2D图像特征。对于每个投影得到的2D边界框,我们提取得到一个2D图像特征,该特征将一个从边界框的ROI Align区域提取的1024维向量与一个6维的Onehot向量连接起来,并且将该向量与投影到的投影平面链接起来。最后,我们通过一个多层感知机(MLP)以及一个尺寸重建来融合两个特征向量。

其中,对应着三种特征

G1表示的是MLP,使用ReLU作为激活函数。MLP拥有一个尺寸大小为1536的隐藏层以及一个尺寸大小为4608的输出层。值得注意的是,我们不会单独训练特征融合模块而是和其它两个模块一起训练。

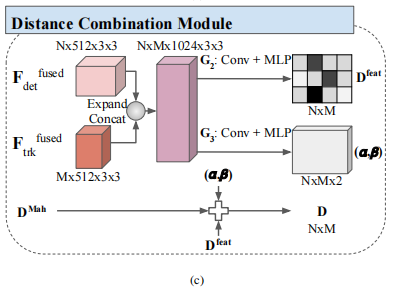

Distance Combination Module

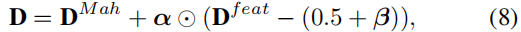

我们定义了一种马氏距离和深度特征距离的线性组合距离。

其中

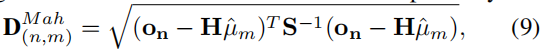

定义为马氏距离矩阵,每个元素保存的是每个检测和每个跟踪的预测状态的距离。

表示的是特征维度的不一致度。

每个都是N*M矩阵,代表着组合系数矩阵。符号

代表着点乘。常数5代表着线性组合的初始化误差,能够加速训练的收敛。D_Math中的每个元素通过如下计算。

其中的主要元素在方程4和6中定义。我们通过一个两阶段的训练方法得到最后的D,我们先训练D_feat然后训练组合系数矩阵。

1)深度特征距离

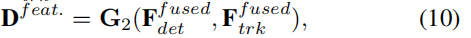

该网络通过融合的特征(N检测以及M跟踪)来学习一个N*M的距离映射。

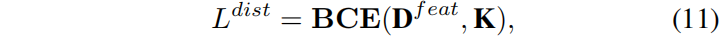

G2代表着一个卷积核为3*3的输出频道尺寸为256的卷积网络,跟随着一个ReLU激活函数和MLP神经层,拥有128的隐藏层。我们使用二元的交叉熵函数作为损失函数训练网络。

其中K是监督的匹配显示矩阵。当它为0时,表示的是一个匹配上的特征对,当它为1时,表示的是一个未匹配的特征对。因为对于每个检测跟踪对,我们没有真值的标注,所以我们将一些情况视作匹配。当前一帧的跟踪边界框最近的真值边界框与当前帧的拥有同样的标识,并且他们的2D中心的欧式距离不足2m。

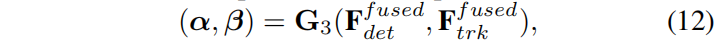

2)组合系数我们将D_feat固定住,然后训练组合系数为了能够根据每个深度特征距离的重要性来调整最后的距离D。

G3和G2的结构相似,处理最后的输出频道尺寸。

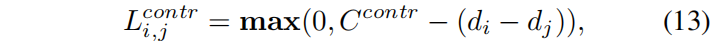

我们使用最大边缘和对比损失作为损失函数训练网络。对于一个正例i以及一个负例j,我们定义最大边缘损失函数如下。

其中,C_contr定义为一个常边缘,di是正例i的融合距离,同理dj。融合距离可以从矩阵D中找到。总的对比误差定义如下。

其中的Pos和Neg分别代表着正的跟踪匹配对和错误的匹配对。网络通过学习组合系数使得正例的距离小于负例。为了同时使用学习的融合距离D来拒绝在推断中匹配失败的外点。我们定义两个其它的最大边缘损失如下。

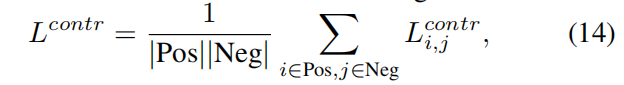

其中,C_pos和C_neg定义为固定边缘,以及T是固定的阈值来拒绝匹配失败的外点。总的损失函数定义如下。

在实际中,我们选择T = 11,C_contr = 6,C_pos = C_neg = 3。在验证中,我们使用贪心算法来进行数据关联。

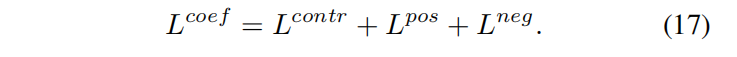

Track Initialization Module

我们将跟踪初始化模块视作一个二分类问题,输入未匹配的检测F_fused作为输入,输出一个信赖度分数P来决定是否需要初始化一个新的跟踪。

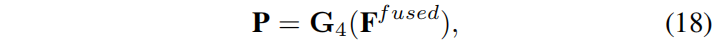

其中G4包含卷积,MLP以及Sigmoid层。我们使用交叉熵损失函数。

= 1当真值目标靠近检测n,否则 = 0。在推断时,当Pn大与0.5时,我们就新建一个跟踪

实验结果

Abstract

Multiobject tracking is an important ability for an autonomous vehicle to safely navigate a trafficscene. Current stateoftheart follows the trackingbydetection paradigm where existing tracksare associated with detected objects through some distance metric. Key challenges to increasetracking accuracy lie in data association and track life cycle management. We propose aprobabilistic, multimodal, multiobject tracking system consisting of different trainable modules toprovide robust and datadriven tracking results. First, we learn how to fuse features from 2Dimages and 3D LiDAR point clouds to capture the appearance and geometric information of anobject. Second, we propose to learn a metric that combines the Mahalanobis and featuredistances when comparing a track and a new detection in data association. And third, we proposeto learn when to initialize a track from an unmatched object detection. Through extensivequantitative and qualitative results, we show that when using the same object detectors our method outperforms stateoftheart approaches on theNuScenes and KITTI datasets.

本文仅做学术分享,如有侵权,请联系删文。

下载1

在「3D视觉工坊」公众号后台回复:3D视觉,即可下载 3D视觉相关资料干货,涉及相机标定、三维重建、立体视觉、SLAM、深度学习、点云后处理、多视图几何等方向。

下载2

在「3D视觉工坊」公众号后台回复:3D视觉github资源汇总,即可下载包括结构光、标定源码、缺陷检测源码、深度估计与深度补全源码、点云处理相关源码、立体匹配源码、单目、双目3D检测、基于点云的3D检测、6D姿态估计源码汇总等。

下载3

在「3D视觉工坊」公众号后台回复:相机标定,即可下载独家相机标定学习课件与视频网址;后台回复:立体匹配,即可下载独家立体匹配学习课件与视频网址。

重磅!3DCVer-学术论文写作投稿 交流群已成立

扫码添加小助手微信,可申请加入3D视觉工坊-学术论文写作与投稿 微信交流群,旨在交流顶会、顶刊、SCI、EI等写作与投稿事宜。

同时也可申请加入我们的细分方向交流群,目前主要有3D视觉、CV&深度学习、SLAM、三维重建、点云后处理、自动驾驶、多传感器融合、CV入门、三维测量、VR/AR、3D人脸识别、医疗影像、缺陷检测、行人重识别、目标跟踪、视觉产品落地、视觉竞赛、车牌识别、硬件选型、学术交流、求职交流、ORB-SLAM系列源码交流、深度估计等微信群。

一定要备注:研究方向+学校/公司+昵称,例如:”3D视觉 + 上海交大 + 静静“。请按照格式备注,可快速被通过且邀请进群。原创投稿也请联系。

▲长按加微信群或投稿

▲长按关注公众号

3D视觉从入门到精通知识星球:针对3D视觉领域的视频课程(三维重建系列、三维点云系列、结构光系列、手眼标定、相机标定、orb-slam3等视频课程)、知识点汇总、入门进阶学习路线、最新paper分享、疑问解答五个方面进行深耕,更有各类大厂的算法工程人员进行技术指导。与此同时,星球将联合知名企业发布3D视觉相关算法开发岗位以及项目对接信息,打造成集技术与就业为一体的铁杆粉丝聚集区,近2000星球成员为创造更好的AI世界共同进步,知识星球入口:

学习3D视觉核心技术,扫描查看介绍,3天内无条件退款

圈里有高质量教程资料、可答疑解惑、助你高效解决问题

觉得有用,麻烦给个赞和在看~

2098

2098

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?