deep image prior (cvpr 2018)

1 结论:因为网络参数具有高噪声阻抗和低信号阻抗性,相当于给网络w加了一个约束。此时信号收敛的更快,而噪声收敛的较慢,使得前期输出的图像主要是信号相关信息。

2 为什么网络参数具有高噪声阻抗和低信号阻抗性?

2.1实践出真理:

论文考虑最基本的重建问题:

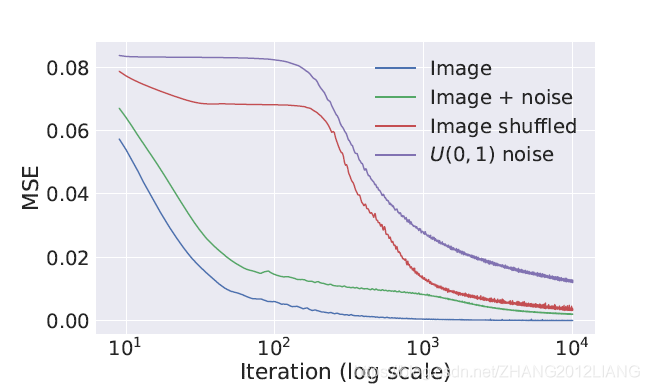

构建网络,输入为固定分布的的随机编码,GT为X,而X为如下四种:

一张自然图像A,自然图像A+噪声,被随机破坏的自然图像A,白噪声

实验发现,当X为自然图像和加了噪声的自然图像时,网络收敛的更快更好。

另外两个也能一定收敛,但是慢,且没有前面两个收敛得好。

作者根据这个实验现象得出了一个结论:网络参数具有高噪声阻抗和低信号阻抗性,即喜欢有规则的信号,不喜欢无规则的噪声。并将其称作一种先验信息。

2.2 理论出真理:

引用:https://www.zhihu.com/question/263404981/answer/269351837

论文主要对去噪,超分,图像修复三个任务进行实验了,因此从任务的角度解释:

去噪:相对于高频的、无序(信息熵高)的噪声,低频、有规则的自然图像是更容易被编码的。通过训练,CNN能很自然地提取出自然图像中普遍的特征,完成生成干净图像的任务。而对于剩余的噪声,则是要依靠网络的死记硬背来完成。

3 具体怎么做:

- 用随机参数初始化深度卷积网络f。

- 令f的输入为服从一定分布的随机编码z。( 在一些实验中,我们发现在每次迭代中随机扰动z可以得到更好的结果。)

- 令f的目标为:输入z,输出x。以此训练f的参数。

- 设计loss。

- 当训练很久之后,f可实现输出一模一样的x。

- 但如果在查看迭代次数较少时的结果,会发现它会输出一幅“修复过的x”。

白话:输入为服从一定分布的随机向量(有扰动),gt是对应的退化图像,希望网络模型输出与GT尽量一致的图像,但是由于网络参数具有高噪声阻抗和低信号阻抗(喜欢信号,不喜欢噪声)的先验信息,使得信号会收敛得更快,而噪声则收敛得慢,导致迭代前期,因为信号提前收敛,而噪声还没有收敛,出现了清晰高质量的图像。如果一值迭代下去,则最终输出则跟GT基本一致。

4 结论:

针对病态问题/不适定问题(多个解问题),往往需要通过正则化也就是先验信息来约束解的空间。例如L1/L2/TV 等各种正则化用于迭代/梯度下降优化。这里作者基于实验观察网络参数具有高噪声阻抗和低信号阻抗性的现象,将其理解为一种先验信息,即网络迭代训练前期可以得到修复过的图像。

Deep Image Prior的重要特点是,网络由始至终,仅使用了输入的被破坏过的图像做为训练。它没有看过任何其它图像,也没有看过正常的图像。但最终效果依然颇为不错。这说明自然图像的局部规律和自相似性确实很强。

这种在观察空间重建的策略在DIP等工作中就已经被应用。它有个前提条件是对应的退化变换 ϕ 已知且可导,好在上色,补全,超分辨率这些任务所对应的退化变换(灰度化,裁剪,降采样)都满足该要求。

1588

1588

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?