1.什么是scrapy?

Scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架。框架的本质就是集成各种功能、具有很强通用性的项目模板。

2.安装

Linux:

pip3 install scrapy Windows:===》见Twisted安装 a. pip3 install wheel b. 下载twisted http://www.lfd.uci.edu/~gohlke/pythonlibs/#twisted c. 进入下载目录,执行 pip3 install Twisted‑17.1.0‑cp35‑cp35m‑win_amd64.whl d. pip3 install pywin32 e. pip3 install scrapy scrapy crawl qiubai -o qiubai.json

scrapy crawl qiubai -o qiubai.xml

scrapy crawl qiubai -o qiubai.csv

1 project_name/ 2 scrapy.cfg: 3 project_name/ 4 __init__.py 5 items.py 6 pipelines.py 7 settings.py 8 spiders/ 9 __init__.py

应用名称.py 10 11 scrapy.cfg 项目的主配置信息。(真正爬虫相关的配置信息在settings.py文件中) 12 items.py 设置数据存储模板,用于结构化数据,如:Django的Model 13 pipelines 数据持久化处理 14 settings.py 配置文件,如:递归的层数、并发数,延迟下载等 15 spiders 爬虫目录,如:创建文件,编写爬虫解析规则

执行完创建应用命令后,打开文件会显示出如下页面

1 # -*- coding: utf-8 -*- 2 import scrapy 3 4 class QiubaiSpider(scrapy.Spider): 5 name = 'qiubai' #应用名称 6 #允许爬取的域名(如果遇到非该域名的url则爬取不到数据) 7 allowed_domains = ['https://www.qiushibaike.com/'] 8 #起始爬取的url 9 start_urls = ['https://www.qiushibaike.com/'] 10 11 #访问起始URL并获取结果后的回调函数,该函数的response参数就是向起始的url发送请求后,获取的响应对象.该函数返回值必须为可迭代对象或者NUll 12 def parse(self, response): 13 print(response.text) #获取字符串类型的响应内容 14 print(response.content)#获取字节类型的相应内容

修改settings相关配置

修改内容及其结果如下: 19行:USER_AGENT = 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_12_0) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/68.0.3440.106 Safari/537.36' #伪装请求载体身份 22行:ROBOTSTXT_OBEY = False #可以忽略或者不遵守robots协议 ==》防君子不防小人协议 需要改为False,不需要遵守协议

scrapy对糗事百科进行爬取

1 # -*- coding: utf-8 -*- 2 import scrapy 3 4 class QiubaiSpider(scrapy.Spider): 5 name = 'qiubai' 6 allowed_domains = ['https://www.qiushibaike.com/'] 7 start_urls = ['https://www.qiushibaike.com/'] 8 9 def parse(self, response): 10 #xpath为response中的方法,可以将xpath表达式直接作用于该函数中 11 odiv = response.xpath('//div[@id="content-left"]/div') 12 content_list = [] #用于存储解析到的数据 13 for div in odiv: 14 #xpath函数返回的为列表,列表中存放的数据为Selector类型的数据。我们解析到的内容被封装在了Selector对象中,需要调用extract()函数将解析的内容从Selecor中取出。 15 author = div.xpath('.//div[@class="author clearfix"]/a/h2/text()')[0].extract() 16 content=div.xpath('.//div[@class="content"]/span/text()')[0].extract() 17 18 #将解析到的内容封装到字典中 19 dic={ 20 '作者':author, 21 '内容':content 22 } 23 #将数据存储到content_list这个列表中 24 content_list.append(dic) 25 26 return content_list

执行爬虫程序并保存文件

执行输出指定格式进行存储:将爬取到的数据写入不同格式的文件中进行存储

scrapy crawl qiubai -o qiubai.json

scrapy crawl qiubai -o qiubai.xml

scrapy crawl qiubai -o qiubai.csv

二.scrapy持久化操作:将爬取到糗百数据存储写入到文本文件中进行存储

1 # -*- coding: utf-8 -*- 2 import scrapy 3 4 5 class QiubaiSpider(scrapy.Spider): 6 name = 'qiubai' 7 allowed_domains = ['https://www.qiushibaike.com/'] 8 start_urls = ['https://www.qiushibaike.com/'] 9 10 def parse(self, response): 11 #xpath为response中的方法,可以将xpath表达式直接作用于该函数中 12 odiv = response.xpath('//div[@id="content-left"]/div') 13 with open('./data.txt', 'w') as fp: 14 for div in odiv: 15 #xpath函数返回的为列表,列表中存放的数据为Selector类型的数据。我们解析到的内容被封装在了Selector对象中,需要调用extract()函数将解析的内容从Selecor中取出。 16 author = div.xpath('.//div[@class="author clearfix"]/a/h2/text()')[0].extract() 17 content=div.xpath('.//div[@class="content"]/span/text()')[0].extract() 18 #持久化存储爬取到的内容 19 fp.write(author + ':' + content + '\n')

注意:上述代码表示的持久化操作是我们自己通过IO操作将数据进行的文件存储。在scrapy框架中已经为我们专门集成好了高效、便捷的持久化操作功能,我们直接使用即可。要想使用scrapy的持久化操作功能,我们首先来认识如下两个文件:

items.py:数据结构模板文件。定义数据属性。

pipelines.py:管道文件。接收数据(items),进行持久化操作。

持久化流程:

1.爬虫文件爬取到数据后,需要将数据封装到items对象中。

2.使用yield关键字将items对象提交给pipelines管道进行持久化操作。

3.settings.py配置文件中开启管道

三.小试牛刀:将糗事百科首页中的段子和作者数据爬取下来,然后进行持久化存储

1 # -*- coding: utf-8 -*- 2 import scrapy 3 from secondblood.items import SecondbloodItem 4 5 class QiubaidemoSpider(scrapy.Spider): 6 name = 'qiubaiDemo' 7 allowed_domains = ['www.qiushibaike.com'] 8 start_urls = ['http://www.qiushibaike.com/'] 9 10 def parse(self, response): 11 odiv = response.xpath('//div[@id="content-left"]/div') 12 for div in odiv: 13 # xpath函数返回的为列表,列表中存放的数据为Selector类型的数据。我们解析到的内容被封装在了Selector对象中,需要调用extract()函数将解析的内容从Selecor中取出。 14 author = div.xpath('.//div[@class="author clearfix"]//h2/text()').extract_first() 15 author = author.strip('\n')#过滤空行 16 content = div.xpath('.//div[@class="content"]/span/text()').extract_first() 17 content = content.strip('\n')#过滤空行 18 19 #将解析到的数据封装至items对象中 20 item = SecondbloodItem() 21 item['author'] = author 22 item['content'] = content 23 24 yield item#提交item到管道文件(pipelines.py)

items.py

1 import scrapy 2 3 4 class SecondbloodItem(scrapy.Item): 5 # define the fields for your item here like: 6 # name = scrapy.Field() 7 author = scrapy.Field() #存储作者 8 content = scrapy.Field() #存储段子内容

管道文件:pipelines.py

1 # -*- coding: utf-8 -*- 2 3 # Define your item pipelines here 4 # 5 # Don't forget to add your pipeline to the ITEM_PIPELINES setting 6 # See: https://doc.scrapy.org/en/latest/topics/item-pipeline.html 7 8 9 class SecondbloodPipeline(object): 10 #构造方法 11 def __init__(self): 12 self.fp = None #定义一个文件描述符属性 13 #下列都是在重写父类的方法: 14 #开始爬虫时,执行一次 15 def open_spider(self,spider): 16 print('爬虫开始') 17 self.fp = open('./data.txt', 'w') 18 19 #因为该方法会被执行调用多次,所以文件的开启和关闭操作写在了另外两个只会各自执行一次的方法中。 20 def process_item(self, item, spider): 21 #将爬虫程序提交的item进行持久化存储 22 self.fp.write(item['author'] + ':' + item['content'] + '\n') 23 return item 24 25 #结束爬虫时,执行一次 26 def close_spider(self,spider): 27 self.fp.close() 28 print('爬虫结束')

配置文件:settings.py

#开启管道 ITEM_PIPELINES = { 'secondblood.pipelines.SecondbloodPipeline': 300, #300表示为优先级,值越小优先级越高 }

Scrapy递归爬取多页数据:

需求:将糗事百科所有页码的作者和段子内容数据进行爬取切持久化存储

1 # -*- coding: utf-8 -*- 2 import scrapy 3 from qiushibaike.items import QiushibaikeItem 4 # scrapy.http import Request 5 class QiushiSpider(scrapy.Spider): 6 name = 'qiushi' 7 allowed_domains = ['www.qiushibaike.com'] 8 start_urls = ['https://www.qiushibaike.com/text/'] 9 10 #爬取多页 11 pageNum = 1 #起始页码 12 url = 'https://www.qiushibaike.com/text/page/%s/' #每页的url 13 14 def parse(self, response): 15 div_list=response.xpath('//*[@id="content-left"]/div') 16 for div in div_list: 17 #//*[@id="qiushi_tag_120996995"]/div[1]/a[2]/h2 18 author=div.xpath('.//div[@class="author clearfix"]//h2/text()').extract_first() 19 author=author.strip('\n') 20 content=div.xpath('.//div[@class="content"]/span/text()').extract_first() 21 content=content.strip('\n') 22 item=QiushibaikeItem() 23 item['author']=author 24 item['content']=content 25 26 yield item #提交item到管道进行持久化 27 28 #爬取所有页码数据 29 if self.pageNum <= 13: #一共爬取13页(共13页) 30 self.pageNum += 1 31 url = format(self.url % self.pageNum) 32 33 #递归爬取数据:callback参数的值为回调函数(将url请求后,得到的相应数据继续进行parse解析),递归调用parse函数 34 yield scrapy.Request(url=url,callback=self.parse)

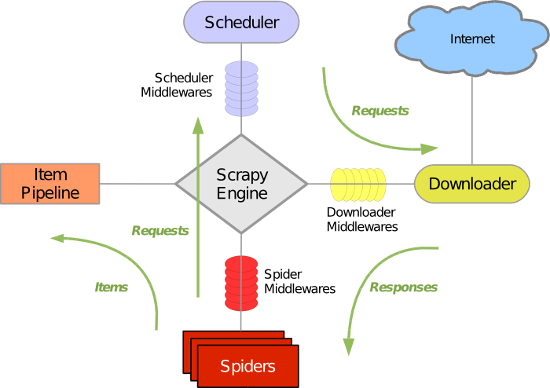

scrapy组件

- 引擎(Scrapy)

用来处理整个系统的数据流处理, 触发事务(框架核心) - 调度器(Scheduler)

用来接受引擎发过来的请求, 压入队列中, 并在引擎再次请求的时候返回. 可以想像成一个URL(抓取网页的网址或者说是链接)的优先队列, 由它来决定下一个要抓取的网址是什么, 同时去除重复的网址 - 下载器(Downloader)

用于下载网页内容, 并将网页内容返回给蜘蛛(Scrapy下载器是建立在twisted这个高效的异步模型上的) - 爬虫(Spiders)

爬虫是主要干活的, 用于从特定的网页中提取自己需要的信息, 即所谓的实体(Item)。用户也可以从中提取出链接,让Scrapy继续抓取下一个页面 - 项目管道(Pipeline)

负责处理爬虫从网页中抽取的实体,主要的功能是持久化实体、验证实体的有效性、清除不需要的信息。当页面被爬虫解析后,将被发送到项目管道,并经过几个特定的次序处理数据。

- 引擎(Scrapy)

* 解释:引擎首先会将爬虫文件中的起始url获取,并且提交到调度器中。如果需要从url中下载数据,则调度器会将url通过引擎提交给下载器,下载器根据url去下载指定内容(响应体)。下载好的数据会通过引擎移交给爬虫文件,爬虫文件可以将下载的数据进行指定格式的解析。如果解析出的数据需要进行持久化存储,则爬虫文件会将解析好的数据通过引擎移交给管道进行持久化存储。

面试题:如果最终需要将爬取到的数据值一份存储到磁盘文件,一份存储到数据库中,则应该如何操作scrapy?

答:管道文件中的代码为:

1 #该类为管道类,该类中的process_item方法是用来实现持久化存储操作的。 2 class DoublekillPipeline(object): 3 4 def process_item(self, item, spider): 5 #持久化操作代码 (方式1:写入磁盘文件) 6 return item 7 8 #如果想实现另一种形式的持久化操作,则可以再定制一个管道类: 9 class DoublekillPipeline_db(object): 10 11 def process_item(self, item, spider): 12 #持久化操作代码 (方式1:写入数据库) 13 return item

在settings.py开启管道操作代码为:

1 #下列结构为字典,字典中的键值表示的是即将被启用执行的管道文件和其执行的优先级。 2 ITEM_PIPELINES = { 3 'doublekill.pipelines.DoublekillPipeline': 300, 4 'doublekill.pipelines.DoublekillPipeline_db': 200, 5 } 6 7 #上述代码中,字典中的两组键值分别表示会执行管道文件中对应的两个管道类中的process_item方法,实现两种不同形式的持久化操作。

五.Scrapy发起post请求:

- 问题:在之前代码中,我们从来没有手动的对start_urls列表中存储的起始url进行过请求的发送,但是起始url的确是进行了请求的发送,那这是如何实现的呢?

- 解答:其实是因为爬虫文件中的爬虫类继承到了Spider父类中的start_requests(self)这个方法,该方法就可以对start_urls列表中的url发起请求:

def start_requests(self):

for u in self.start_urls:

yield scrapy.Request(url=u,callback=self.parse)

【注意】该方法默认的实现,是对起始的url发起get请求,如果想发起post请求,则需要子类重写该方法。

- 重写start_requests方法,让其发起post请求:

def start_requests(self): #请求的url post_url = 'http://fanyi.baidu.com/sug' # 表单数据 formdata = { 'kw': 'wolf', } # 发送post请求 yield scrapy.FormRequest(url=post_url, formdata=formdata, callback=self.parse)

Scrapy是一个Python爬虫框架,用于爬取网站数据。本文介绍了Scrapy的安装、基本组成,包括items.py和pipelines.py,以及如何进行数据持久化操作。还详细讲解了Scrapy的工作流程,如引擎、调度器、下载器、爬虫和管道的角色。最后讨论了如何在Scrapy中发起POST请求,并给出了面试题示例,展示了如何将数据同时存储到磁盘和数据库中。

Scrapy是一个Python爬虫框架,用于爬取网站数据。本文介绍了Scrapy的安装、基本组成,包括items.py和pipelines.py,以及如何进行数据持久化操作。还详细讲解了Scrapy的工作流程,如引擎、调度器、下载器、爬虫和管道的角色。最后讨论了如何在Scrapy中发起POST请求,并给出了面试题示例,展示了如何将数据同时存储到磁盘和数据库中。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?