Netapp数据恢复环境&故障情况:

某公司一台服务器中一共有72块SAS硬盘。

工作人员误操作删除了十几个lun。需要恢复服务器中的数据。

Netapp数据恢复过程:

1、将故障服务器上磁盘编号后取出。由硬件工程师对所有磁盘进行硬件故障检测,未发现有硬盘存在物理坏道和其他硬件故障。将所有硬盘以只读方式做全盘镜像,镜像完成后将磁盘根据编号按照原样还原到原服务器中。后续的数据分析和数据恢复操作都基于镜像文件进行,避免对原始磁盘数据造成二次破坏。

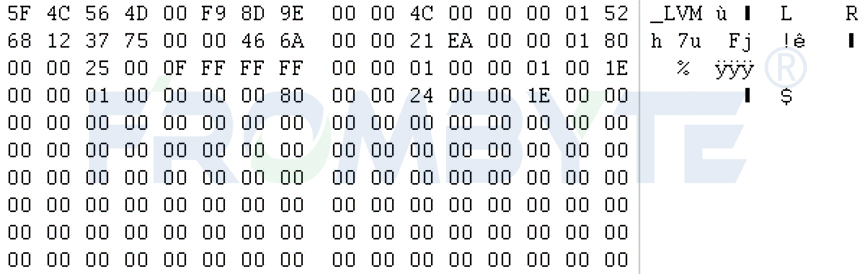

2、服务器数据恢复工程师基于镜像文件分析所有硬盘底层数据,找到盘头位置的超级块,继续分析超级块信息得到磁盘组的起始块信息、磁盘组名称、逻辑组起始块号、raid编号等基本信息。

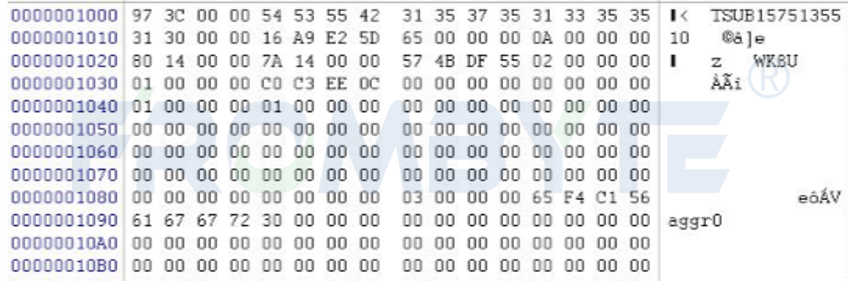

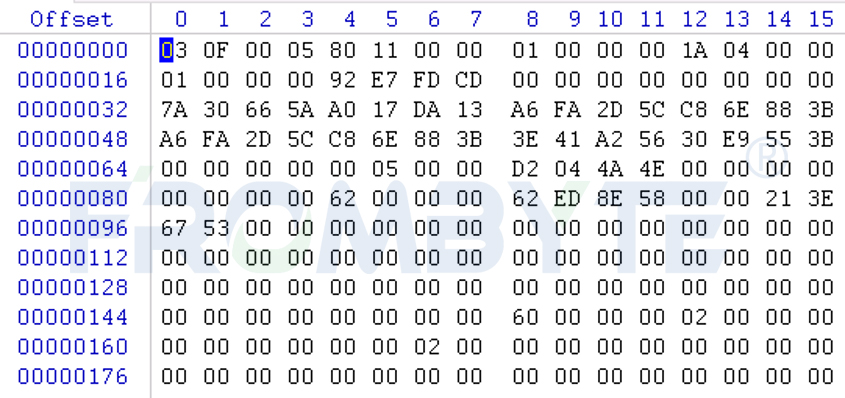

分析超级块:

3、通过分析得知每个数据块占8个扇区,数据块后附加64字节数据块描述信息。北亚企安数据恢复工程师根据这些信息判断出是校验盘的磁盘。恢复数据时需要将校检盘排除在外。

0x10:6字节为aggr_data块号

0x10处为FFFF表示校验块。

校验块描述信息样例:

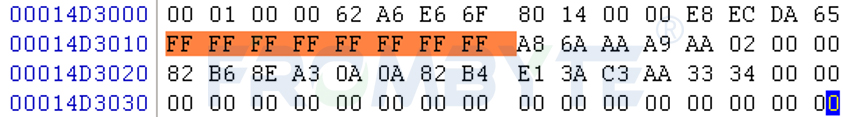

4、根据每块磁盘8号扇区的磁盘信息以及磁盘末尾的RAID盘序表确定盘序。

首先确定各个磁盘所属aggr组,然后再判断组内盘序。数据指针跳转时不考虑校验盘,所以只取得数据盘的盘序即可。

aggr_raid(磁盘靠近尾部) 根据10H处的VCN块号判断磁盘组内各盘的顺序。

分析盘序表:

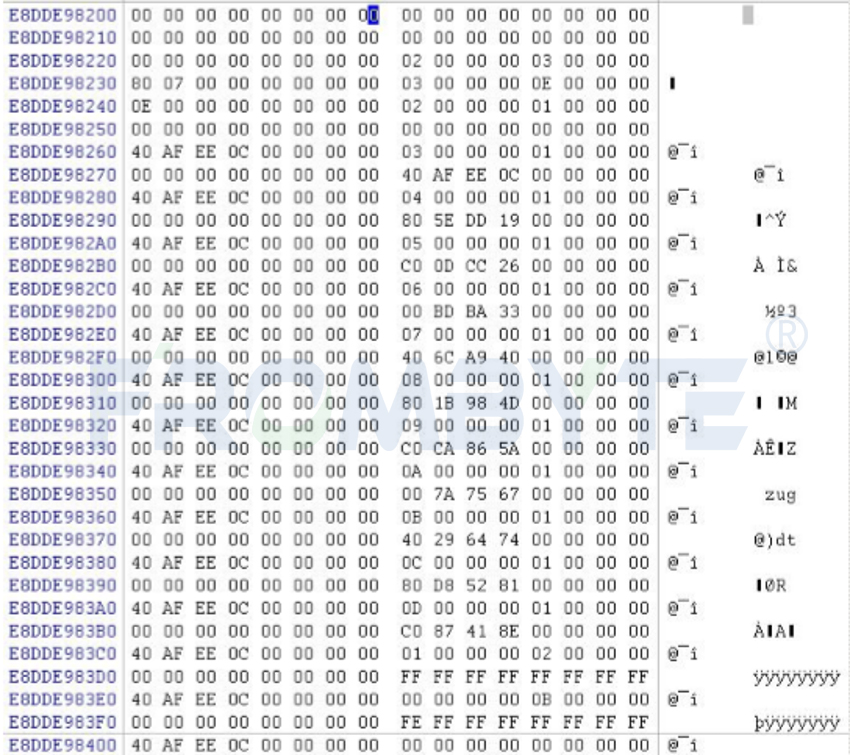

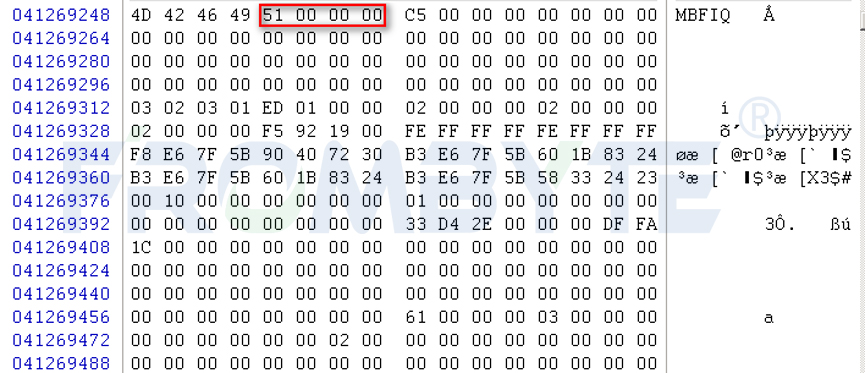

Tips:Netapp的节点分布在数量众多的数据块内,在数据块内又被统一组织为节点组。每个节点组的前64字节记录一些系统数据,然后用192字节为一项来记录各个文件节点。根据用户级别可分为两类:“MBFP”系统文件节点和“MBFI”用户文件节点,在数据恢复时一般只取“MBFI”节点组即可。

服务器节点样例图:

头部信息64字节

解析如下:(此头部为数据文件的节点文件块头部,大小为64字节)

标志,常量(“MBFP”为元文件的节点标志,“MBFI”为用户文件的节点标志)

根据更新序列值获取到最新节点。

5、解析节点中节点类型、逻辑块号、文件数量、文件大小、所占块数量、数据指针。获取节点在节点文件中的逻辑块号,从0开始计数。

6、获取目录项,并根据其节点编号,找到对应节点。

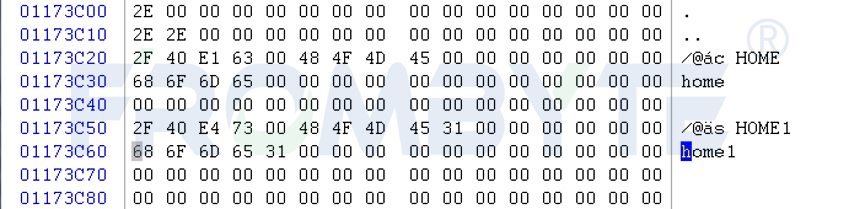

获取服务器内对应节点截图:

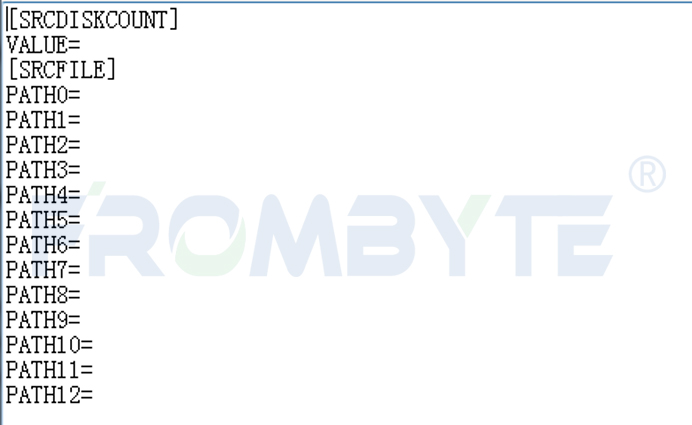

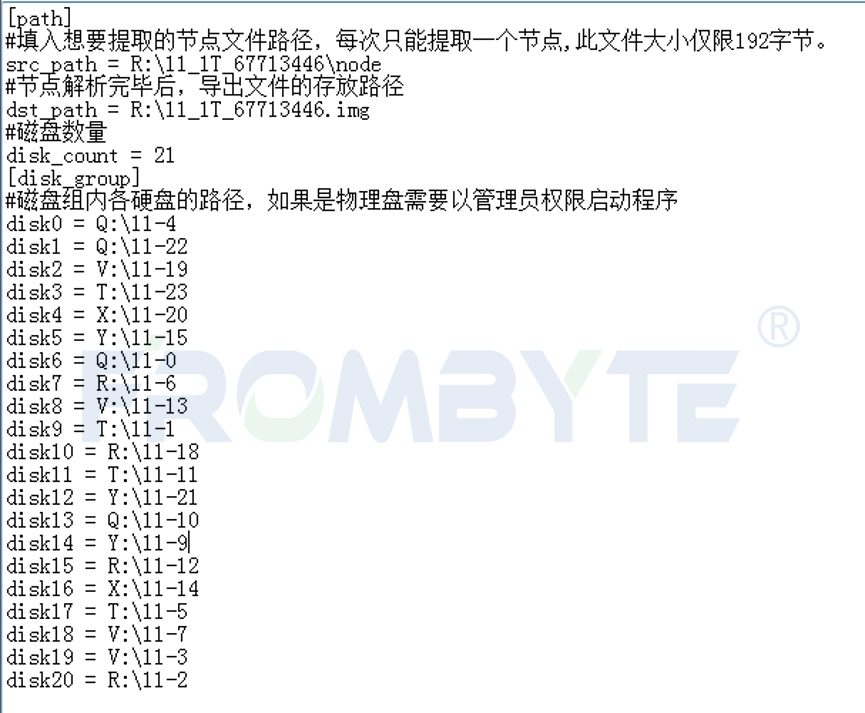

7、使用北亚企安自主开发的程序提取服务器数据。

a、扫描节点信息。

扫描服务器节点信息:

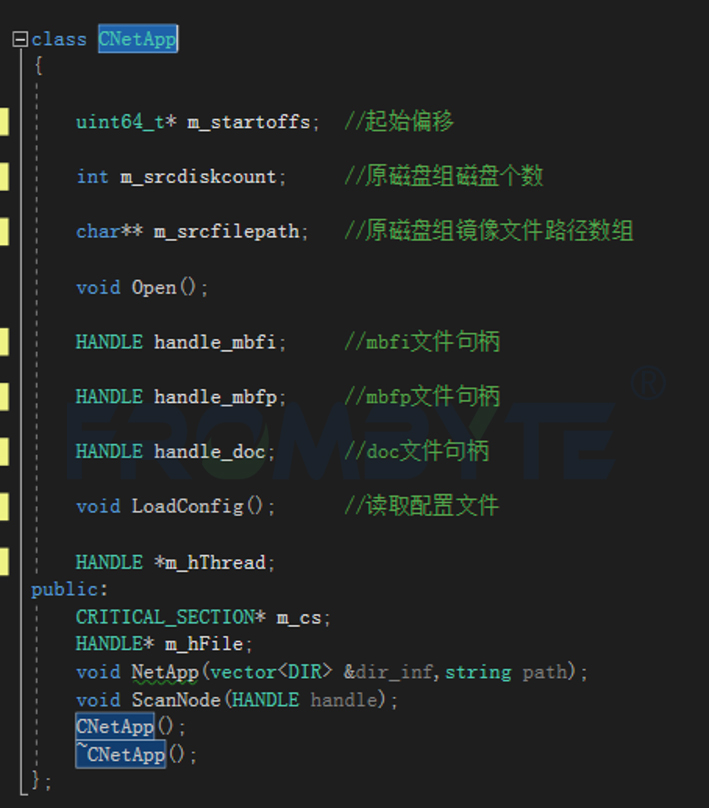

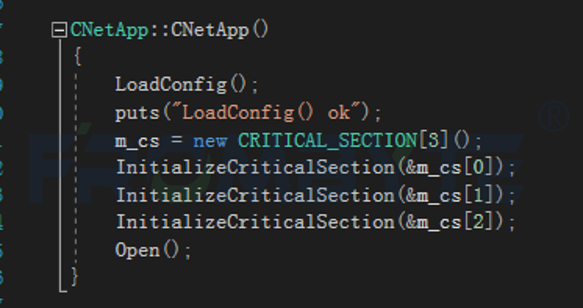

节点扫描类:

节点扫描程序完整流程:

在循环扫描完毕之后会将所有扫描到的MBFP、MBFI和DOC数据块分别写入到三个文件内,用于后续处理。

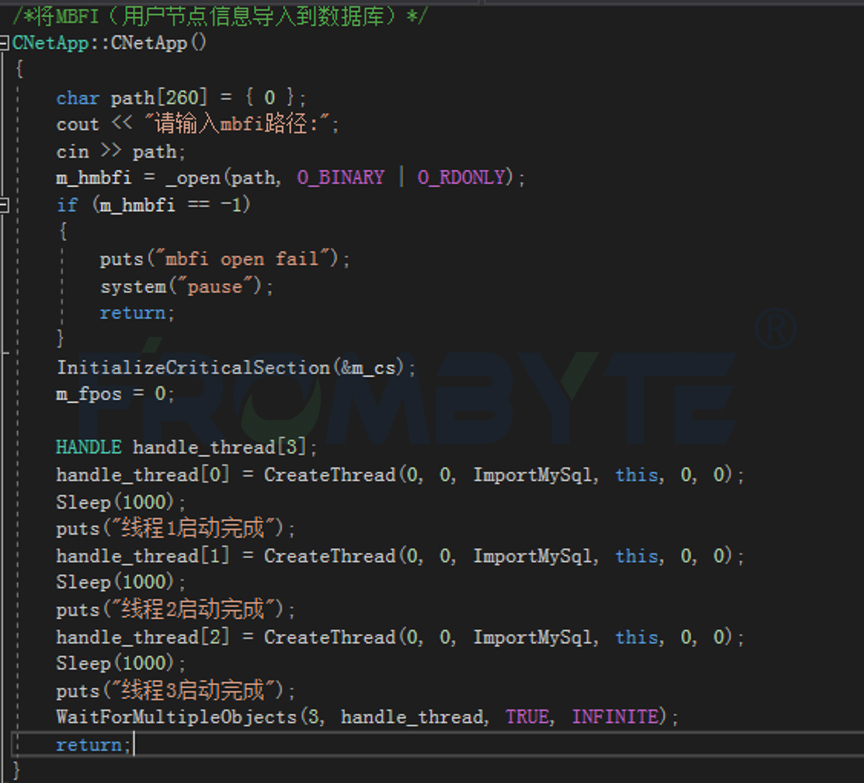

b、将节点信息导入到数据库。

此模块主要负责将ScanNode扫描得到的MBFI和MBFP、Dir存入数据库以备后续使用。

MBFI导入数据库整体流程:

函数执行完毕后可以查看数据库。

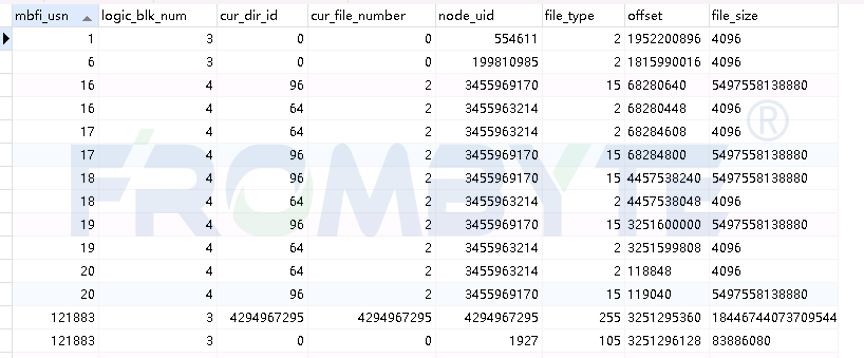

节点导入信息:

Netapp在更改inode节点时不会直接覆盖而是重新分配inode进行写入。单个文件的节点node_uid唯一不变,mbfi_usn会随着节点的变化而增大(正常情况下提取某个文件时使用usn最大的节点)。一般情况下存储划分出的单个节点会作为LUN映射到服务器使用,根据file_size可以确定这个文件的大小,按照文件大小分组后再选取usn最大值的节点,跳转到MBFI文件的offset值偏移位置,取出节点。

节点样例图示:

c、提取文件

在获取到要提取的文件的Node之后,开始提取块设备文件。

提取块设备文件:

初始化完毕后,开始提取文件的各级MAP。本次提取过程中文件大小均大于1T,MAP层级为4,所以需要提取4次。第一级MAP默认只占用1个块,所以在程序内直接提取,后三级MAP在GetAllMap函数内进行提取。通过块号计算数据块位置时,由于NetApp使用JBOD组织LVM,直接用块号除以每块磁盘上的块数就可以得到当前块所在的磁盘序号(计算机整数除法,丢弃小数邠);再使用块号取余块数,得到数据块在此磁盘上的物理块号,物理块号乘以块大小,得到数据块偏移位置。

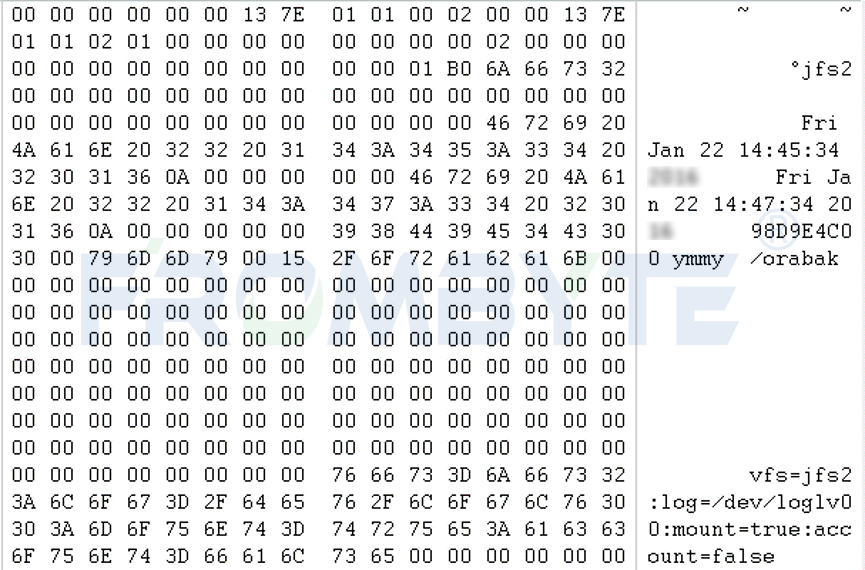

8、块设备文件系统解析

a、本案例中的块设备5T大小的lun使用的是aix小机的jfs2文件系统。因此要解析jfs2文件系统,提取里面的数据库备份文件。解析lvm。

7扇区记录lvm描述信息,获取pv大小和pv序号。

类似找到vg描述区,获取lv数和pv数,找到pv描述区,解析pp序号和pp数。

解析文件系统块信息:

LV类型及LV挂载信息区域:

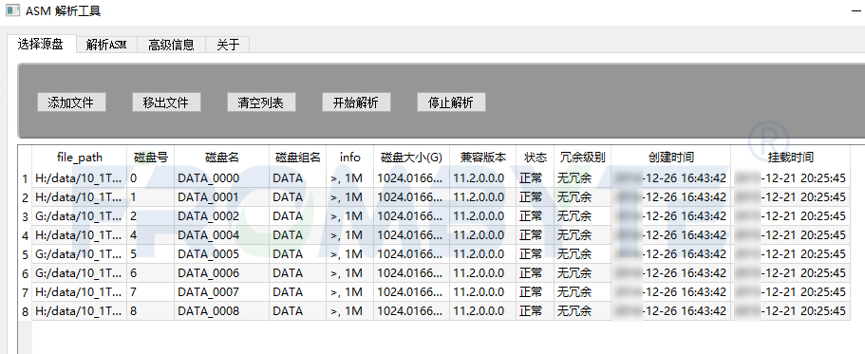

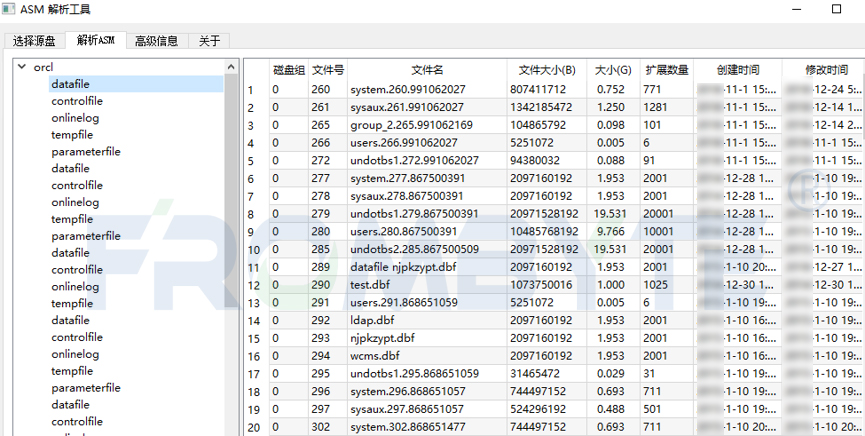

b、解析8个1T大小的lun组成的oralce ASM文件系统,提取其中的数据库文件。

添加8个lT大小的lun。

解析ASM文件系统,提取出数据库文件。

9、数据恢复工程师对恢复出来的数据进行检测后没有发现异常。让用户方工程师进行验证,经过验证确认恢复出来的数据完整有效。本次netapp数据恢复工作完成。

452

452

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?