来源:IEEE电气电子工程师协会

GPT-5本应是那个证明通用人工智能(AGI)触手可及的模型。OpenAI首席执行官Sam Altman在1月份的个人博客帖子中也暗示了这一点(https://blog.samaltman.com/reflections)。Altman写道,他“现在有信心我们知道如何构建我们传统意义上所理解的通用人工智能”,并补充说2025年将是人工智能代理“从根本上改变公司产出”的一年。

但现实并未达到Altman的预期。认知科学家、通用人工智能怀疑论者Gary Marcus在Substack上的一篇帖子中称GPT-5“被过度炒作且令人失望”(https://garymarcus.substack.com/p/gpt-5-overdue-overhyped-and-underwhelming),大量的负面反馈最终促使Altman承认OpenAI“完全搞砸了”这次发布(https://fortune.com/2025/08/18/sam-altman-openai-chatgpt5-launch-data-centers-investments/)。

受到质疑的不仅仅是GPT-5。麻省理工学院最近一份关于商业领域人工智能的报告发现,在商业环境中部署的所有生成式人工智能中,有95%“没有产生任何回报”(https://www.artificialintelligence-news.com/wp-content/uploads/2025/08/ai_report_2025.pdf)。这份报告严重动摇了人们对人工智能的信心,以至于引发了科技股的小幅抛售,不过股价后来趋于稳定。最近Grok和Anthropic发布的产品也反映平平。

人工智能公司Neurologyca的首席执行官Juan Graña表示:“我们正处于一个典型的炒作周期中。人工智能伴随着强烈的喧嚣突然出现在人们的视野中,但现在正滑向高德纳公司所说的‘幻灭低谷’,在那里,期望与现实相遇。”

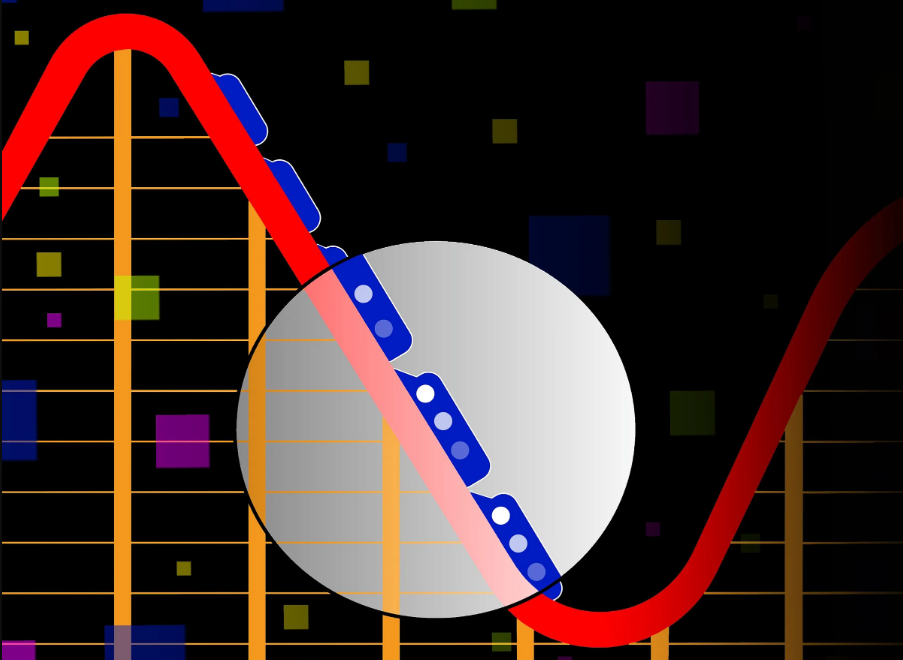

人工智能正走向幻灭低谷吗?

即使你不熟悉“幻灭低谷”这个术语,你也很有可能知道它的意思。

这个短语是1995年由Gartner公司的分析师Jackie Fenn创造的,作为一个图表的一部分,用来解释过高的期望是如何导致一段幻灭期的。它很快就流行起来,并催生了无数对原始图表的(有时很有趣的)变体。

人工智能咨询公司Bowtie的联合管理合伙人Jason Gabbard表示,在GPT-5以及2025年其他人工智能产品发布之前,炒作的热度非常高。Gabbard说:“有太多的权威人士参与讨论,长期以来评论都是一片炒作之声,以至于人们的期望变得很高。”他还补充说,GPT-5未能达到预期,小型组织和个人对此感受最为深切,他们原本希望“OpenAI的下一个产品能够解决他们所有的问题”。

在GPT-5发布后,用户发起的抵制行为也呼应了他的这些评论。

作为新模型发布的一部分,OpenAI从ChatGPT中移除了早期的GPT-4o模型,显然是认为用户会在任何情况下都觉得GPT-5是一个升级版本。然而,许多ChatGPT用户抱怨说,新模型似乎比它的前身更差。这些批评使得OpenAI改变了做法,在移除GPT-4o模型仅24小时后就恢复了用户对它的访问权限。

这对OpenAI来说是一个尴尬的局面。2024年,Altman曾预测,GPT-5会让GPT-4相比之下“略显尴尬”。但事实却相反,用户对GPT-5的反馈非常负面,以至于OpenAI决定恢复之前的模型(https://the-decoder.com/openai-ceo-sam-altman-promises-ai-models-that-far-surpass-gpt-4/)。

2025年人工智能智能体面临的挑战

具有讽刺意味的是,Fenn 1995年的原始图表将智能体置于期望的顶峰 —— 而这正是2025年初人工智能智能体所处的位置。快进到8月,似乎正如芬恩的图表所预测的那样,智能体正引领着一场暴跌,进入幻灭低谷。

GPT-5的智能体模式(以前称为Operator)的推出,和该模型本身一样,受到了褒贬不一的评价。而且对智能体人工智能的质疑已经蔓延到了整个人工智能行业。人工智能编程工具Replit在其智能体删除了一家公司的整个代码库后,于6月份遭到了批评。安全也是一个问题。杀毒软件提供商Malwarebytes最近发出警告,被托付重要凭证的人工智能智能体可能会因陷入旨在欺骗人工智能的骗局而让用户“身无分文”(https://www.malwarebytes.com/blog/news/2025/08/ai-browsers-could-leave-users-penniless-a-prompt-injection-warning)。

这些令人担忧的头条新闻是极端案例,但与此同时,基准测试也显示出智能体的性能表现平平。

其中一个这样的基准测试是TheAgentCompany进行的,它让由亚马逊、Anthropic、谷歌和OpenAI的模型驱动的人工智能智能体承担包括编码、数据科学和人力资源等广泛职业路径的工作。结果发现,即使是测试中表现最好的模型,即谷歌的Gemini 2.5 Pro,也只能完成30.3%的任务。GPT-5的测试结果尚未公布。

TheAgentCompany的基准测试还发现,人工智能智能体的局限性与预期不同。

最近的一项研究发现,人工智能对需要软技能的工作构成了最大威胁(https://arxiv.org/pdf/2507.07935)。这些工作包括客服代表、职员、分析师、公关专家和管理人员。Anthropic公司的首席执行官Dario Amodei表示,人工智能将淘汰多达一半的白领工作。

然而,TheAgentCompany的基准测试发现,当被要求完成这些岗位范围内的任务时,人工智能智能体的表现很差。由于缺乏社交技能和存在自我欺骗的倾向,它们难以完成任务。当被要求处理软件开发和项目管理任务时,智能体的表现最为成功。

TheAgentCompany论文的合著者Frank Xu表示:“编码对人类来说看起来很难,但实际上,对人工智能模型来说,它比看起来更简单的文书工作等任务更容易。”

数据限制影响人工智能性能

造成这种能力差距的一个可能原因是什么?训练数据的缺乏。

Xu表示:“网上有大量的开源代码可供训练,但你不会看到公司将他们的电子表格或人力资源工作流程开源。数据的缺乏是人工智能智能体难以完成人们期望它们取代的工作的一个重要原因。”

IEEE Spectrum采访的所有专家都一致认为,与特定任务相关的数据缺乏似乎是人工智能模型的一个绊脚石。

Neurologyca公司的Graña认为,”人工智能缺乏数据,更重要的是,缺乏以情感智能方式行事所需的背景信息”。帮助对冲基金等金融机构实施人工智能自动化的Bowtie公司的Gabbard表示,通用人工智能智能体难以应对独特的业务流程,需要定制化解决方案才能成功。而有使用人工智能经验的分析师Mark Parfenov发现,智能体“很快就会在复杂任务上失去头绪”,并且在用于市场分析时会忽略重要数据。

这些困难使人们对人工智能行业通过扩大通用大型语言模型来实现通用人工智能(AGI)的希望产生了怀疑。然而,这并不是说人工智能模型缺乏改进的途径。合成数据和改进的数据标注提供了解决缺点的选项,尽管它们也可能使人工智能走出幻灭低谷的过程变得艰难而昂贵。

“我认为,那些容易实现的改进空间已经越来越少了,”Xu表示。他补充说,早期智能体取得的进展源于一些简单的改变,“比如格式错误问题,或者对工具的理解不足…… 我认为,在找到下一个重大突破之前,进展会放缓。”