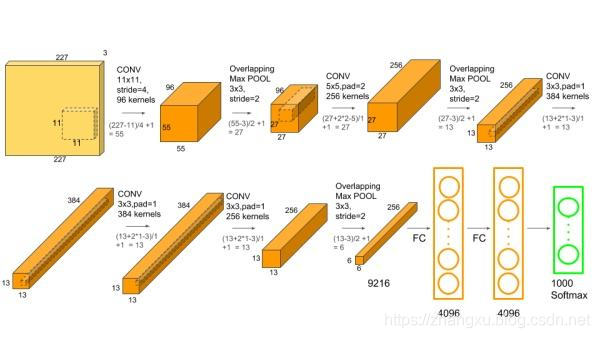

下面以最经典的AlexNet模型为例子,计算感受野,模型计算量和大小(内存)。下面这张图是AlexNet的结构图,看起来比较直观。

感受野

感受野是检测和分割任务中比较重要的指标,它是一个逐层叠加的过程,计算到最后一层的卷积特征图输出上,它的计算公式是:

R

F

i

=

R

F

i

−

1

+

(

k

e

r

n

e

l

s

i

z

e

−

1

)

×

s

t

r

i

d

e

,

R

F

0

=

1

RF_{i}=RF_{i-1}+(kernelsize-1)\times stride,RF_{0}=1

RFi=RFi−1+(kernelsize−1)×stride,RF0=1

其中

R

F

0

RF_{0}

RF0默认是输入层,感受野为1。所以AlexNet的感受野计算为:

- 第一层,卷积: R F 1 = 1 + ( 11 − 1 ) × 4 = 41 RF_{1}=1+(11-1)\times 4=41 RF1=1+(11−1)×4=41

- 第二层,池化: R F 2 = 41 + ( 3 − 1 ) × 2 = 45 RF_{2}=41+(3-1)\times 2=45 RF2=41+(3−1)×2=45

- 第三层,卷积: R F 3 = 45 + ( 5 − 1 ) × 2 = 53 RF_{3}=45+(5-1)\times 2=53 RF3=45+(5−1)×2=53

- 第四层,池化: R F 2 = 53 + ( 3 − 1 ) × 2 = 57 RF_{2}=53+(3-1)\times 2=57 RF2=53+(3−1)×2=57

- 第五层,卷积: R F 2 = 57 + ( 3 − 1 ) × 1 = 59 RF_{2}=57+(3-1)\times 1=59 RF2=57+(3−1)×1=59

- 第六层,卷积: R F 2 = 59 + ( 3 − 1 ) × 1 = 61 RF_{2}=59+(3-1)\times 1=61 RF2=59+(3−1)×1=61

- 第七层,卷积: R F 2 = 61 + ( 3 − 1 ) × 1 = 63 RF_{2}=61+(3-1)\times 1=63 RF2=61+(3−1)×1=63

- 第八层,池化: R F 2 = 63 + ( 3 − 1 ) × 2 = 67 RF_{2}=63+(3-1)\times 2=67 RF2=63+(3−1)×2=67

第八层的输出就是 6 × 6 × 256 6\times6\times256 6×6×256,感受野的计算就结束了。

计算量

计算量是评价一个模型重要的标准之一,其实在模型的计算量统计时有两点简化的地方:

- 模型的不同层中,卷积层和全连接层是占据了绝大多数的计算量,所以下面我们只关注这两个层的计算;

- 卷积层和全连接层都有对应的“+”操作,而这些“+”操作也被忽略掉了(一般情况下,是忽略“+”操作的,但是也会有例外,比如YOLOv3在计算主干网络算力的时候)。

卷积层

对于一个

w

1

×

h

1

×

c

1

w_{1}\times h_{1}\times c_{1}

w1×h1×c1的输入特征图,经过

3

×

3

3\times3

3×3的卷积核,输出

w

2

×

h

2

×

c

2

w_{2}\times h_{2}\times c_{2}

w2×h2×c2的特征图,那么卷积一次将输出一个值,计算量为:

F

o

=

3

×

3

×

c

1

+

1

F_{o}=3\times3\times c_{1}+1

Fo=3×3×c1+1

其中这个1是每个卷积核对应的偏置,它也要做一次乘运算,然后,卷积完一张特征图

w

2

×

h

2

w_{2}\times h_{2}

w2×h2计算量为:

F

c

=

F

o

×

w

2

×

h

2

F_{c}=F_{o}\times w_{2}\times h_{2}

Fc=Fo×w2×h2

最后需要

c

2

c_{2}

c2个卷积核才能完成

w

2

×

h

2

×

c

2

w_{2}\times h_{2}\times c_{2}

w2×h2×c2的输出:

F

a

=

F

c

×

c

2

F_{a}=F_{c}\times c_{2}

Fa=Fc×c2

全连接层

全连接层的计算量分析就更简单了,因为它没有滑动,就只输入相乘相加为一个输出,假设输出维度为

o

1

o_{1}

o1,输出维度为

o

2

o_{2}

o2,那么计算量为:

F

=

(

o

1

+

1

)

×

o

2

F=(o_{1}+1)\times o_{2}

F=(o1+1)×o2

AlexNet逐层计算计算量的话太多了,下面偷个懒,只算下第一层举个例子吧。

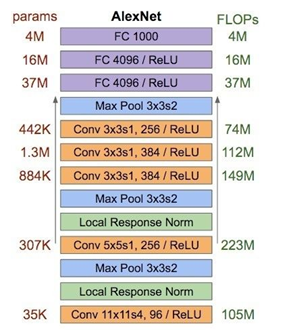

这是AlexNet的的参数数量和计算量分布图,第一层卷积的计算量是105M FLOPs,FLOPs是“每秒浮点运算次数”,在作为计算量是,就是浮点运算次数,那么105MFLOPs就应该是

105

×

1

0

6

105\times10^6

105×106次浮点运算。

套用上面公式就是:

(

11

×

11

×

3

+

1

)

×

55

×

55

×

96

=

105705600

=

105

M

(11\times11\times3+1)\times55\times55\times96= 105705600=105M

(11×11×3+1)×55×55×96=105705600=105M

模型大小

模型的大小完全由模型的参数数量和参数的存储形式决定:

卷积层

卷积层的参数数量就是一个卷积核的参数乘上卷积核的个数:

P

n

=

(

w

×

h

×

c

i

+

1

)

×

c

o

P_{n}=(w\times h\times c_{i}+1)\times c_{o}

Pn=(w×h×ci+1)×co

w

w

w,

h

h

h和 c_{i}是卷积核的尺寸,

c

o

c_{o}

co是卷积核个数,也就是输出通道数,1是偏置。

全连接层

全连接层的参数数量输入输出的神经元连接的那个权重:

P

n

=

(

o

1

+

1

)

×

o

2

P_{n}=(o_{1}+1)\times o_{2}

Pn=(o1+1)×o2

o

1

o_{1}

o1是输入神经元个数,和

o

2

o_{2}

o2是输出神经元个数,1是偏置。

AlexNet的参数数量由60M个,也就是六千万个,参数只在卷积层和全连接层出现,下面还是只计算第一层卷积的参数:

96

×

11

×

11

×

3

+

96

=

34944

=

35

K

96\times11\times11\times3+96=34944=35K

96×11×11×3+96=34944=35K

最后还剩下一个转换就是参数的数量,怎么转成存储的大小,一般情况下模型的参数是按照float形式存储的,占4个字节,AlexNet模型大小是238147KB:

60

M

×

4

=

240000000

B

=

234375

K

B

60M\times4=240000000B=234375KB

60M×4=240000000B=234375KB

因为60M这个数是一个约等,所以计算出来是234375KB,而实际上是238147KB。

1677

1677

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?