目标:

在idea中用scala编写简单代码,从本地hdfs中(或本地目录)读取文件,通过spark处理后,结果输出到本地dhfs或本地目录。

然后修改代码,将项目打成jar包,上传到linux中,在spark集群上运行。

环境:hadoop2.7.2 +spark2.2.3 +scala 2.11.8 +idea2018

以上环境的具体安装配置和idea的基本操作分别见:

windows上 IntelliJ IDEA安装scala环境 : https://blog.csdn.net/csdn_dengfan/article/details/88363224

windows 安装 配置 hadoop2.7.2 spark2.2.3 :https://blog.csdn.net/csdn_dengfan/article/details/88375313

1.编写代码

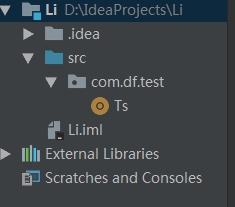

目录结构:

Ts的代码:

val conf = new SparkConf().setAppName("Ts").setMaster("local[1]")

//创建spark执行的入口

val sc = new SparkContext(conf)

//指定以后从哪里读取数据创建RDD

//val lines: R

本文详细介绍了在Windows上的IntelliJ IDEA中使用Scala编写代码,操作本地Hadoop和Spark集群的过程。首先,创建项目并编写读取和处理文件的代码。接着,通过Hadoop集群运行程序并查看结果。然后,将项目打包成jar文件,并上传到Linux服务器执行。最后,提供了解决方案以确保在Spark集群上成功运行jar包。

本文详细介绍了在Windows上的IntelliJ IDEA中使用Scala编写代码,操作本地Hadoop和Spark集群的过程。首先,创建项目并编写读取和处理文件的代码。接着,通过Hadoop集群运行程序并查看结果。然后,将项目打包成jar文件,并上传到Linux服务器执行。最后,提供了解决方案以确保在Spark集群上成功运行jar包。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

634

634

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?