### Rstudio环境配置

1 更新R

在R原软件中逐个运行下面的代码(仅适用Windows系统)。macOS直接打开CRAN官网下载最新版本的R覆盖安装,重启RStudio即可完成R的更新,原R包都在。

install.packages("installr")

library(installr)

updateR()2 更新R包

运行下面的代码或通过右下角的Packages选项卡进行R包的更新

old.packages() # 检查是否有需要更新的R包

update.packages(ask = F) # 更新所有R包

news(package = "limma") # 参看R包的更新内容

BiocManager::valid() # 查看是否有需要更新的bioconductor包。根据提示安装更新3 从bioconductor安装R包

BiocManager::install("biomaRt",update = TRUE,ask = FALSE)4 清除当前加载的程序包

detach("package:dplyr", unload=TRUE)

# 或用pacman包内的p_unload函数

pacman::p_unload("dplyr")如果要从环境中移除所有用户包,则可通过pacman包的p_loaded()+p_unload()函数实现:

pacman::p_unload(pacman::p_loaded(), character.only = TRUE)5 更改当前R脚本运行目录

setwd("/Users/totoshihiro/Library/Mobile Documents/com~apple~CloudDocs/Documents/科研/医学统计学/数据基本处理与标准化")

getwd()#查看当前R脚本运行目录6 环境查看和清理

rm(mydata)

rm(list = ls())#移除当前环境中的所有对象

cat("\014")#清空所有输出结果

sessionInfo()#收集有关当前R项目的信息7 自动安装所需的R包

packages <-c("GEOquery", "limma","ggplot2", "pheatmap")#列出所需的R包

#检查所需的R包是否已安装,若未安装则从CRAN或Bioconductor安装包

packagecheck <- function(x) {

if (!require("BiocManager")) {

install.packages("BiocManager")

} else if (!require(x, character.only = T)) {

CRANpackages <- available.packages()

if (x %in% rownames(CRANpackages)) {

install.packages(x)

} else {

BiocManager::install(x, update = TRUE, ask = FALSE)

}

}

}

lapply(packages, packagecheck)8 调整矢量/内存分配上限

8.1 提高矢量大小上限

在R语言中如果我们要处理的数据集较大,如在处理单细胞数据时,可能会出现如下报错:

Error: cannot allocate vector of size *** Mb这是因为 R 中有对象大小的限制(默认值为 500 1024 ^ 2 = 500 Mb)。可以通过如下代码进行调整:

# 调整允许对象大小限制为6GB

options(future.globals.maxSize = 6 * 1024 * 1024^2)8.2 提高R内存分配上限(macOS)

如果在运行大量的数据处理时,出现如下报错:

Error: vector memory exhausted (limit reached?)那么说明脚本的运行超出了R语言内存分配的上限,这一般就是Mac的物理内存大小。但是,我们可以通过如下的方式来通过分配SWAP虚拟内存的方式,使得代码能够继续运行(来自stackoverflow上的这篇帖子)。

【方法一:通过usethis包配置】

在R中运行:

usethis::edit_r_environ()Tip

usethis is a package that facilitates interactive workflows for R project creation and development

运行后会在RStudio中以新标签页的方式打开一个.Renviron文件。在其中输入:

R_MAX_VSIZE=50GbCaution

注意这里的内存数值包括了物理内存和虚拟内存,所以如果你的电脑的实际内存为16GB,那么在这里需要输入比16GB更大的数值,输入16GB是不会有帮助的。

保存这个文件后,重启RStudio,这时候内存上限就被修改好了。

RStudio调用虚拟内存执行脚本

【方法二:通过终端配置】

打开终端(Terminal),在其中输入:

cd ~

touch .Renviron

open .Renviron这时会打开.Renviron文件,在其中输入:

R_MAX_VSIZE=50Gb保存文件,重启RStudio。

9 RStudio常用快捷键

| 操作 | MacOS快捷键 |

|---|---|

| 新建R脚本 | Command + Shift + N |

| 重启R | Command + Shift + 0。或点击菜单栏 Session > Restart R。 |

| 复制并粘贴代码 | 在一行代码末尾或者选中需要复制的代码后按Command + Shift + D |

| 多行注释 | 先选中所要注释的代码,然后按Command + Shift + C。如果想取消注销,再选中代码,再后按 Command + Shift + C。 |

| 创建可折叠注释 | Command + Shift + R |

| 插入管道函数 | Command + Shift + M |

| 赋值 | Option + - |

| 打开帮助 | 将光标放到函数中间,然后按F1键 |

| 查找此前运行过的代码 | 在Console面板中,按 Command + 方向上键,就可以浏览此前运行过的代码。 |

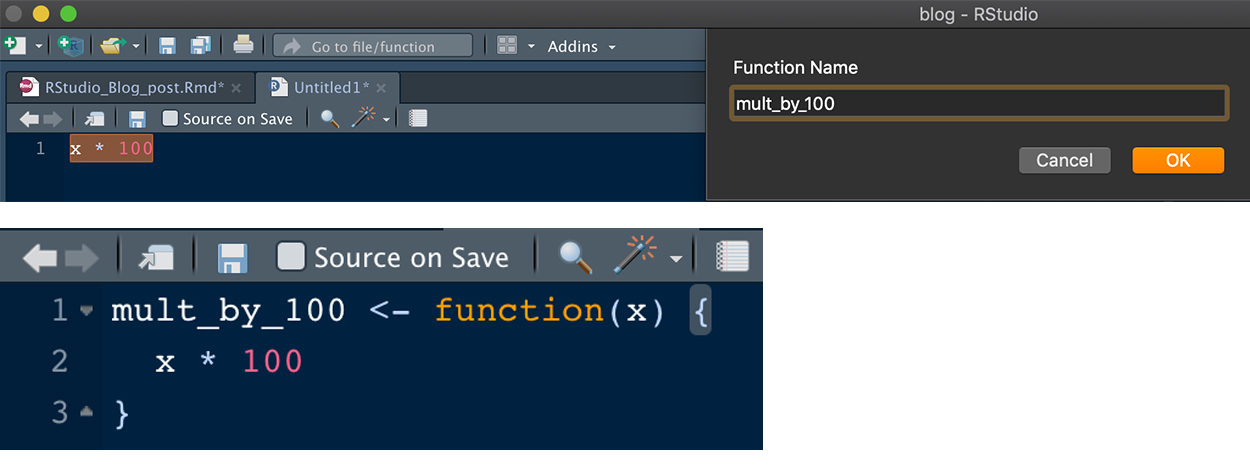

| 自动包装函数 | 选中需要包装成函数的代码后,按 Option + Command + X,会弹出对话框,填写自定义函数的名称后,选中的代码被自动转换成函数,并且其中需要输入的变量会被自动识别并填写到函数名后的括号中(见 Figure 1 )。 |

| 批量更改自定义函数内的输入变量名 | 有时候我们需要修改自定义函数中的某个输入变量的名称,如果手动修改可能会发生遗漏。这时我们可选中需要修改名称的输入变量,然后按 如果记不住该快捷键,也可以在RStudio的菜单栏中选择 |

| 批量添加逗号 | 如果有一连串对象需要添加逗号,则可以在按住 Option 的同时用鼠标在这些对象的后方下拉拖拽,这时候可以发现有多个光标被定位到了这些对象之后,然后就可以输入逗号(见 Figure 3 )。 |

Figure 1: 自动包装函数示例

Figure 2: Rename in scope示例

Figure 3: 批量添加逗号示例

Tip

-

在Windows中相应的快捷键把上面的

Command替换成Control,Option替换成Alt即可。 -

记不住快捷键?可以通过在RStudio的菜单栏中选择

Tools>Keyboard Shortcuts Help来显示所有快捷键。

10 自动整理代码

The tidyverse style guide对代码编写时的规范格式进行了详细说明。通过styler包可以实现对代码的自动整理,有助于保持不同项目之间的代码风格一致,并促进协作。安装styler后通过运行下面的命令即可自动整理当前打开的文档的代码。

install.packages("styler")

styler:::style_active_file()也可以用通过打开Rstudio的插件(Addins),选择”Style active file”来实现对当前R脚本的代码整理。或者选择一段代码后,点击”Style selection”来对选中的代码进行整理。

Figure 4: Rstudio插件

Tip

R for Data Science中详细说明了规范的代码风格。

11 Rstudio主题

rsthemes包提供了多种额外的主题。

该包通过r-universe进行安装:

install.packages(

"rsthemes",

repos = c(gadenbuie = 'https://gadenbuie.r-universe.dev', getOption("repos"))

)然后安装主题:

rsthemes::install_rsthemes()使用:

# 列出所有来自rsthemes的主题

rsthemes::list_rsthemes()

# 依次尝试所有主题

rsthemes::try_rsthemes()

# 只尝试浅色主题

rsthemes::try_rsthemes("light")通过Tools > Global Options > Appearance也可以浏览和应用这些主题。

安装该包后还会在Rstudio的插件中显示,可以方便的进行深色和浅色模式的切换。要实现这一点,需要打开R的配置文件(~/.Rprofile),可以通过下面的方式快速打开:

usethis::edit_r_profile()然后将下面的代码粘贴进配置文件:

if (interactive()) {

rsthemes::set_theme_light("Chrome") # 默认的浅色主题

rsthemes::set_theme_dark("Cobalt") # 默认的深色主题

rsthemes::set_theme_favorite( # 再添加一些主题作为备选

c(

"GitHub {rsthemes}",

"Material Palenight {rsthemes}"

)

)

}现在就可以通过点击插件中的”Toggle Dark Mode”来一键切换深色和浅色主题了(Figure 4 )。同时,点击”Next Favorite Theme”可以切换上面设置的set_theme_favorite()里面的主题。

### 数据的读取与输出

1 基于R基础包的数据读取

1.1 读取.CSV数据文件

read.csv或read.table均可

csvdata <- read.csv(

file = "ovary_data.csv",

header = T,

sep = ",",

stringsAsFactors = F

) -

header:第一行是否是列名 -

sep:字段分隔符。文件每行上的值由此字符分隔。read.table的默认值为sep = “”,表示分隔符为‘空白’,即一个或多个空格、制表符、换行符或回车。read.csv的默认值为sep = ",",表示分隔符为英文逗号 -

stringsAsFactors:是否将字符向量转换为因子

csvdata <- read.table(

"ovary_data.csv",

header = T,

sep = ",",

row.names = "patientID",

colClasses = c("character", "character", "character", "numeric", "numeric", "numeric")

) colClasses: (可选)指定每一列的变量类型as.is:该参数用于确定read.table()函数读取字符型数据时是否转换为因子型变量。当其取值为FALSE时,该函数将把字符型数据转换为因子型数据,取值为TRUE时,仍将其保留为字符型数据。

1.2 读取.txt文件

refGene <- read.table(

"refGene.txt",

header = F,

sep = "\t"

)1.3 读取.xlsx/.xls文件

MacOS 首选 gdata 包(因自带perl语言);Windows首选 xlsx 包

library(gdata)

xlsdata <- read.xls(

"ovary_data.xlsx",

sheet = 1 # 要读取的工作表的名称或编号

)1.4 读取.sav文件

.sav文件是SPSS的输出文件,可以通过foreign包的read.spss()函数来读取。

library(foreign)

savdata <- read.spss(

"lweight.sav",

to.data.frame = T # 将.sav格式数据转换成数据框

) 1.5 读取程序包中的案例数据集

data(Arthritis, package="vcd")

#或

mydata <- vcd::Arthritis1.6 下载和读取压缩包

1.6.1 解压.zip文件

unzip(

zipfile = "test.zip",

files = "ferroptosis_suppressor.csv",

overwrite = T

)-

zipfile:压缩包的位置及文件名 -

files:(可选)需要提取的文件的文件名,默认解压压缩包内的所有文件 -

overwrite:解压后是否覆盖同名文件

1.6.2 解压.tar文件

untar(

"test.tar", # 压缩包的位置及文件名

files = "ferroptosis_suppressor.csv" # 提取指定文件,默认解压压缩包内的所有文件

) 1.6.3 下载和解压.gz或.bz2文件

这两个压缩文件与前面的相比比较特别,因为.gz或.bz2文件,可以称之为压缩文件,也可以直接作为一个数据文件进行读取。

#下载gz文件

download.file(

"http://hgdownload.soe.ucsc.edu/goldenPath/hg38/database/refGene.txt.gz",

destfile = "refGene.txt.gz") # 目标下载位置,注意需要添加后缀名

#直接以数据的形式读取.gz文件

mydata <- read.table("refGene.txt.gz")列出指定目录中的文件

list.files()在批量读取文件时十分有用,因为它能够获取指定目录下的文件名

list.files(

path = "folder_name",

pattern = ".docx$",

full.names = T

)-

path:需要列出的文件所在的路径,若忽略此项则列出当前工作路径下的所有文件 -

pattern:列出目录中包含指定字符的文件。如pattern = "\\.docx$"表示列出所有以“.docx”为后缀的文件;pattern = "^G"列出所有文件名以“G”开头的文件 -

full.names:FALSE:仅输出文件名;TRUE(默认):输出路径+文件名

1.7 手动生成数据框

framdata <- data.frame(

y = c(6, 8, 12, 14, 14, 15, 17, 22, 24, 23),

x1 = c(2, 5, 4, 3, 4, 6, 7, 5, 8, 9),

x2 = c(14, 12, 12, 13, 7, 8, 7, 4, 6, 5)

)

framdata y x1 x2

1 6 2 14

2 8 5 12

3 12 4 12

4 14 3 13

5 14 4 7

6 15 6 8

7 17 7 7

8 22 5 4

9 24 8 6

10 23 9 5# 使用文本编辑器直接在窗口中编辑数据。macOS需要安装XQuartz(www.xquartz.org)才能运行此代码。

framdata <- edit(framdata)2 基于readr包的数据读取

readr包是tidyverse中用于数据读取的R包。相较于R基础包自带的数据读取函数,基于readr包的数据读取有以下优势:

-

一般来说,

readr比基础包中的函数要更快(快大约10-100倍);如果只要求快速读取大容量数据的话,也可以使用data.tabale包中的fread()函数。在某些情况下fread()比readr的读取速度略快,但是readr能够更好的兼容基于tidyverse的数据处理流程。 -

readr可以生成数据框tibble,并且不会将字符向量转换为因子,不使用行名称,也不会随意改动列名称。这些都是R基础包使用中令人沮丧的事情。 -

readr更易于重复使用。R基础包则需要继承操作系统的功能,并依赖环境变量,同样的代码在另一个电脑上不一定能正常运行。

library(tidyverse)2.1 读取.csv文件

这里我们使用students.csv案例数据,该数据可以从此处下载。对于.csv文件,我们可以通过read_csv()读取:

students <- read_csv("data/r_basic/students.csv")# 也可以直接从URL读取

students <- read_csv("https://pos.it/r4ds-students-csv")当运行 read_csv() 时,它会打印出一条消息,报告数据的行数和列数、使用的分隔符和列类型。int 代表整数型数据,dbl 代表数值型数据,chr 代表字符型数据,dttm 代表日期时间型数据。这些变量非常重要,因为对列进行的操作在很大程度上取决于该列的 “类型”。它还告诉我们可以通过spec()来提取所有列的类型信息。

students# A tibble: 6 × 6

...1 `Student ID` `Full Name` favourite.food mealPlan AGE

<dbl> <dbl> <chr> <chr> <chr> <chr>

1 1 1 Sunil Huffmann Strawberry yoghurt Lunch only 4

2 2 2 Barclay Lynn French fries Lunch only 5

3 3 3 Jayendra Lyne N/A Breakfast and lu… 7

4 4 4 Leon Rossini Anchovies Lunch only <NA>

5 5 5 Chidiegwu Dunkel Pizza Breakfast and lu… five

6 6 6 Güvenç Attila Ice cream Lunch only 6 同时,我们注意到通过read_csv读取后的数据是一个 tibble,这是一种升级版的data.frame,被 tidyverse 用来避免一些data.frame的常见问题。Tibbles 和data.frame之间的一个重要的区别在于 tibbles 打印数据的方式:tibbles 是为大型数据集设计的,因此只显示前几行和适应屏幕宽度的列。可以使用 print(flights, width = Inf) 显示所有列,或者使用 glimpse()(见基于dplyr包的数据处理)。因为这里的数据本身只有6行6列,所以所有数据都被显示了出来。

另一个问题是,“Student ID”和“Full Name”列名被单引号扩起来。这是因为这两列的列名中包含了空格,这不符合R语言列名规范,也体现了tibble不会改变原有列名的特点。如果是用read.csv()读取的话,这两列中间的空格会被”.”替换。下面我们将这两个列名中的空格用下划线“_”替换以符合规范:

rename(

students,

student_id = `Student ID`,

full_name = `Full Name`

)# A tibble: 6 × 6

...1 student_id full_name favourite.food mealPlan AGE

<dbl> <dbl> <chr> <chr> <chr> <chr>

1 1 1 Sunil Huffmann Strawberry yoghurt Lunch only 4

2 2 2 Barclay Lynn French fries Lunch only 5

3 3 3 Jayendra Lyne N/A Breakfast and lunch 7

4 4 4 Leon Rossini Anchovies Lunch only <NA>

5 5 5 Chidiegwu Dunkel Pizza Breakfast and lunch five

6 6 6 Güvenç Attila Ice cream Lunch only 6 rename()要求新变量名在 = 的左侧,旧变量名在右侧。和其他dplyr中的函数一样,rename不会对原始数据进行修改,因此需要将rename后的数据重新赋值给新的对象或覆盖原来的对象以应用对变量名的修改(更多关于rename()的说明详见后续章节)。这里为了后续演示,没有重新赋值。

另一种方法是使用 janitor 包中的 clean_names() 函数,一次性将不符合规范的列名规范化重命名:

janitor::clean_names(students)2.1.1 定义缺失值

通过检查该数据,发现”favourite.food“一列中有一个“N/A”字符,这在原始数据的录入时表示缺失值。但是read_csv()默认将空字符串(“”)识别为缺失值NA。我们可以在读取数据时添加额外的参数让read_csv()能够将“N/A”识别为缺失值:

students <- read_csv(

"data/r_basic/students.csv",

na = c("N/A", "")

)

students# A tibble: 6 × 5

`Student ID` `Full Name` favourite.food mealPlan AGE

<dbl> <chr> <chr> <chr> <chr>

1 1 Sunil Huffmann Strawberry yoghurt Lunch only 4

2 2 Barclay Lynn French fries Lunch only 5

3 3 Jayendra Lyne <NA> Breakfast and lunch 7

4 4 Leon Rossini Anchovies Lunch only NA

5 5 Chidiegwu Dunkel Pizza Breakfast and lunch five

6 6 Güvenç Attila Ice cream Lunch only 6 2.1.2 定义列类别

读入数据后的另一个常见操作是更改变量/列类型。例如,这个数据中“favourite_food”,“meal_plan”应该是因子型变量;“age”应该是数值型变量,因此我们需要对其进行转换。

这里我们使用管道符|>来简化代码,对其的详细说明参考后续章节。mutate()的作用是根据现有列计算并添加新列(见基于dplyr包的数据处理-mutate())。对于因子变量的转换,使用base包的factor(),转换后的变量仍命名为“meal_plan”,所以它会覆盖原有的“meal_plan”变量。对于数值型变量的转换,这里用readr中的parse_number()函数:

students |>

janitor::clean_names() |>

mutate(

favourite_food = factor(favourite_food),

meal_plan = factor(meal_plan),

age = parse_number(age)

)Warning: There was 1 warning in `mutate()`.

ℹ In argument: `age = parse_number(age)`.

Caused by warning:

! 1 parsing failure.

row col expected actual

5 -- a number five# A tibble: 6 × 5

student_id full_name favourite_food meal_plan age

<dbl> <chr> <fct> <fct> <dbl>

1 1 Sunil Huffmann Strawberry yoghurt Lunch only 4

2 2 Barclay Lynn French fries Lunch only 5

3 3 Jayendra Lyne <NA> Breakfast and lunch 7

4 4 Leon Rossini Anchovies Lunch only NA

5 5 Chidiegwu Dunkel Pizza Breakfast and lunch NA

6 6 Güvenç Attila Ice cream Lunch only 6⚠️注意,此时的输出结果中出现了警告信息。提示部分“age”数据出现了解析失败,具体在第五行,是一个“five”值,它不能被解析成数值,所以我们对其进行以下处理:

students <- students |>

janitor::clean_names() |>

mutate(

favourite_food = factor(favourite_food),

meal_plan = factor(meal_plan),

age = parse_number(if_else(age == "five", "5", age))

)

students# A tibble: 6 × 5

student_id full_name favourite_food meal_plan age

<dbl> <chr> <fct> <fct> <dbl>

1 1 Sunil Huffmann Strawberry yoghurt Lunch only 4

2 2 Barclay Lynn French fries Lunch only 5

3 3 Jayendra Lyne <NA> Breakfast and lunch 7

4 4 Leon Rossini Anchovies Lunch only NA

5 5 Chidiegwu Dunkel Pizza Breakfast and lunch 5

6 6 Güvenç Attila Ice cream Lunch only 6readr提供了一系列函数用于转换变量类型:

-

parse_factor():类似于base包的factor(),但是如果通过levels参数指定了因子水平,并且该变量的某些值在这些水平中找不到,则会给出警告并将这些值转换成缺失值NA。而factor()则不会给出警告信息。x <- c("cat", "dog", "caw") animals <- c("cat", "dog", "cow") factor(x, levels = animals)[1] cat dog <NA> Levels: cat dog cowparse_factor(x, levels = animals)[1] cat dog <NA> attr(,"problems") # A tibble: 1 × 4 row col expected actual <int> <int> <chr> <chr> 1 3 NA value in level set caw Levels: cat dog cow -

parse_number():转换数值型变量。这个函数会解析它找到的第一个数字,然后删除第一个数字之前的所有非数字字符和第一个数字之后的所有字符,同时也会忽略千分位分隔符“,”。parse_number("$1,000") # leading `$` and grouping character `,` ignored[1] 1000parse_number("euro1,000") # leading non-numeric euro ignored[1] 1000parse_number("t1000t1000") # only parses first number found[1] 1000parse_number("1,234.56")[1] 1234.56# explicit locale specifying European grouping and decimal marks parse_number("1.234,56", locale = locale(decimal_mark = ",", grouping_mark = "."))[1] 1234.56# SI/ISO 31-0 standard spaces for number grouping parse_number("1 234.56", locale = locale(decimal_mark = ".", grouping_mark = " "))[1] 1234.56 -

parse_integer():转换整数型变量。较少使用,因为整数型变量和数值型变量或称doubles型变量的本质是一样的。 -

parse_datetime():转换日期/时间变量。parse_datetime("01/02/2010", "%d/%m/%Y")[1] "2010-02-01 UTC"parse_datetime("01/02/2010", "%m/%d/%Y")[1] "2010-01-02 UTC"parse_datetime("2010/01/01 12:00 US/Central", "%Y/%m/%d %H:%M %Z")[1] "2010-01-01 18:00:00 UTC"

Tip

这些变量类型转换函数都通过了缺失值定义参数,如:

# Specifying strings for NAs

parse_number(c("1", "2", "3", "NA"))[1] 1 2 3 NAparse_number(c("1", "2", "3", "NA", "Nothing"), na = c("NA", "Nothing"))[1] 1 2 3 NA NA因此,既可以像上面的定义缺失值中一样在数据读取时就定义数据集中的缺失值,也可以在转换变量类型时分别定义每一列的缺失值。

2.1.3 非标准数据的读取

通常,read_csv()使用数据的第一行作为列名,这是一种非常常见的约定。但在有时候数据的顶部可能包含几行元数据。这时候可以通过添加skip参数让read_csv()跳过前n行,也可以通过comment参数让其跳过以特定字符(例如“#”)开头的所有行。

read_csv(

"The first line of metadata

The second line of metadata

x,y,z

1,2,3",

skip = 2

)# A tibble: 1 × 3

x y z

<dbl> <dbl> <dbl>

1 1 2 3read_csv(

"# A comment I want to skip

x,y,z

1,2,3",

comment = "#" # 跳过以“#”开头的行

)# A tibble: 1 × 3

x y z

<dbl> <dbl> <dbl>

1 1 2 3在其他情况下,数据可能没有列名。可以使用 col_names = FALSE 告知 read_csv() 不要将第一行视为列名,而是按从 “X1” 到 “Xn” 的顺序标记它们:

read_csv(

"1,2,3

4,5,6",

col_names = FALSE

)# A tibble: 2 × 3

X1 X2 X3

<dbl> <dbl> <dbl>

1 1 2 3

2 4 5 6或者,可以用 col_names 参数以包含列名的字符向量来自定义列名:

read_csv(

"1,2,3

4,5,6",

col_names = c("x", "y", "z")

)# A tibble: 2 × 3

x y z

<dbl> <dbl> <dbl>

1 1 2 3

2 4 5 62.2 其他类型数据文件的读取

一旦掌握了read_csv()的语法,其他数据格式的读取只需调用特定的函数即可,语法和read_csv()类似:

-

read_csv2():读取以分号“;”分隔的数据。

-

read_tsv()和read_table():读取以制表符分隔的数据。 -

read_fwf():读取固定宽度数据文件,其中列以空格分隔。

-

read_delim():读取以任意分隔符(例如“|”)分隔的数据。如果没有指定分隔符那么read_delim()会尝试自动猜测分隔符。

2.3 从多个文件读取数据

有时,数据会拆分到多个文件中,而不是包含在单个文件中。例如,假设这里有多个月的销售数据,每个月的数据都在一个单独的文件中,分别是: 1月的销售数据“01-sales.csv”、2月的销售数据“02-sales.csv”和三月的销售数据“03-sales.csv”。通过使用 read_csv() ,可以一次读取这些数据,并合并成一个数据。

list.files(

"data/r_basic",

pattern = "sales\\.csv$",

full.names = TRUE

) %>%

read_csv(id = "file")# A tibble: 19 × 6

file month year brand item n

<chr> <chr> <dbl> <dbl> <dbl> <dbl>

1 data/r_basic/01-sales.csv January 2019 1 1234 3

2 data/r_basic/01-sales.csv January 2019 1 8721 9

3 data/r_basic/01-sales.csv January 2019 1 1822 2

4 data/r_basic/01-sales.csv January 2019 2 3333 1

5 data/r_basic/01-sales.csv January 2019 2 2156 9

6 data/r_basic/01-sales.csv January 2019 2 3987 6

7 data/r_basic/01-sales.csv January 2019 2 3827 6

8 data/r_basic/02-sales.csv February 2019 1 1234 8

9 data/r_basic/02-sales.csv February 2019 1 8721 2

10 data/r_basic/02-sales.csv February 2019 1 1822 3

11 data/r_basic/02-sales.csv February 2019 2 3333 1

12 data/r_basic/02-sales.csv February 2019 2 2156 3

13 data/r_basic/02-sales.csv February 2019 2 3987 6

14 data/r_basic/03-sales.csv March 2019 1 1234 3

15 data/r_basic/03-sales.csv March 2019 1 3627 1

16 data/r_basic/03-sales.csv March 2019 1 8820 3

17 data/r_basic/03-sales.csv March 2019 2 7253 1

18 data/r_basic/03-sales.csv March 2019 2 8766 3

19 data/r_basic/03-sales.csv March 2019 2 8288 6这些数据可以从https://pos.it/r4ds-01-sales, https://pos.it/r4ds-02-sales, https://pos.it/r4ds-03-sales下载。下载后的数据被翻到了”data”文件夹下的“r_basic”子文件夹内。因此,我们可以通过list.files()并结合pattern参数列出我们需要的销售数据文件,pattern中应用了正则表达式,这在接下来的章节中会详细说明。read_csv中的id参数会在结果数据中添加一个新列,用于标识数据来自哪个文件。

2.4 手动生成tibble

有时需要在R脚本中“手动”输入一些数据来生成一个tibble。有两个函数可以做到这一点,这两个函数的不同之处在于是按列还是按行布局tibble。其中 tibble() 按列工作,类似于base包中的data.fram():

tibble(

x = c(1, 2, 5),

y = c("h", "m", "g"),

z = c(0.08, 0.83, 0.60)

)# A tibble: 3 × 3

x y z

<dbl> <chr> <dbl>

1 1 h 0.08

2 2 m 0.83

3 5 g 0.6 按列布局数据很难看到行之间是如何关联的,因此可以选择 tribble() ,这是“Transsposed Tibble”的缩写,它允许逐行布局数据。列标题以 ~ 开头,条目之间用逗号分隔。这使得以易于阅读的形式布局少量数据成为可能:

tribble(

~x, ~y, ~z,

1, "h", 0.08,

2, "m", 0.83,

5, "g", 0.60

)# A tibble: 3 × 3

x y z

<dbl> <chr> <dbl>

1 1 h 0.08

2 2 m 0.83

3 5 g 0.6 3 数据的导出

3.1 基于base包的数据导出

3.1.1 导出.csv文件

write.csv(

mydata,

row.names = F,#是否输出行名称

"mydata.csv"

)3.1.2 导出.xlsx/.xls文件

library(openxlsx2)

write_xlsx(

coxtable1,

"coxtable1.xlsx"

)3.1.3 储存为.Rdata/.RDS文件

在R中保存数据的更好的方法是通过save()将数据导出为.Rdata文件或通过saveRDS()保存为.RDS文件,它们以R的定制二进制格式存储数据。这意味着当重新加载这些对象时,加载的是与当时存储时的完全相同的R对象。它们能够最大程度的保持数据的原貌,如对变量类型的定义,同时可以将图像、列表等对象导出。

# 保存为.Rdata文件

save(object1, object2, file = "filepath/name.rdata")

# 保存目前环境中的所有对象

save(list = ls(), file = "filepath/name.rdata")

# 保存为.RDS文件

saveRDS(object, file = "filepath/name.rds")-

.Rdata文件的读取是通过load()函数,该函数不能对读取的对象重命名,它会保留当时在储存这些对象时原本的名称;而读取.RDS文件是通过

readRDS()函数,支持重命名:

# 载入.Rdata文件

load("filepath/name.rdata")

# 载入.RDS文件

new_object <- readRDS("filepath/name.rds")3.2 基于readr包的数据导出

3.2.1 导出.csv/.txt文件

Readr提供了两个用于将数据写回磁盘的函数: write_csv() 和 write_tsv() 。这些函数最重要的参数是 x (要保存的数据集的名字)和 file (要保存的位置)。还可以使用 na 指定如何写入缺失值,以及通过 append 定义是否覆盖写入现有文件。

现在我们将之前的“students”数据导出,然后重新读取:

write_csv(students, file = "output/r_basic/students.csv")

read_csv("output/r_basic/students.csv")用这种方式导出的文件无法保留我们定义的变量类型信息。因此,更好的方式是和上面一样保存为.Rdata文件或.RDS文件。和base包的saveRDS()和readRDS()对应的,readr包中也有两个函数,write_rds() 和 read_rds():

write_rds(students, "output/r_basic/students.rds")

students <- read_rds("output/r_basic/students.rds")### 数据处理基本函数

1 加载包

library(tidyverse)

library(nycflights13)2 数据展示

载入示例数据:

mydata <- readRDS("data/r_basic/lms_ess.rds")2.1 展示最大值、最小值、平均数、中位数、缺失值数量

summary(mydata) year year2 age race marriage

2010:111 2010-2011:216 Min. :23.00 White :554 Married :386

2011:105 2012-2013:217 1st Qu.:48.00 Black : 99 Single/Unmarried:166

2012:118 2014-2016:300 Median :55.00 Others: 76 Others :148

2013: 99 Mean :55.77 NA's : 4 NA's : 33

2014:100 3rd Qu.:64.00

2015:101 Max. :95.00

2016: 99

grade grade2 tumor_size

Well differentiated; Grade I : 58 Low-grade :181 Min. : 4.0

Moderately differentiated; Grade II :123 High-grade:323 1st Qu.: 60.0

Poorly differentiated; Grade III :105 Gx :229 Median : 95.0

Undifferentiated; anaplastic; Grade IV:218 Mean :107.9

NA's :229 3rd Qu.:135.0

Max. :950.0

NA's :79

his T_stage T_stage_plus N_stage M_stage figo figo_plus

LMS:448 T1:499 T1b :340 N0 :680 M0:628 I :442 IB :290

ESS:285 T2:131 T1a :114 N1 : 49 M1:105 II : 82 IA :109

T3: 85 T2a : 67 NA's: 4 III: 89 IVB :105

T4: 18 T3a : 57 IV :120 IIIA : 39

T2b : 55 IIIC : 32

T1 : 45 (Other): 30

(Other): 55 NA's :128

peri surg alnd plnd lnd rad

Negtive :674 TH+BSO:629 No :586 No :417 No :412 No :609

Malignant: 59 TH : 47 Yes :111 Yes :282 Yes :288 Yes :117

RH/EH : 57 NA's: 36 NA's: 34 NA's: 33 NA's: 7

chem dead status time income

No :365 0:365 0 :365 Min. : 2.00 <$60,000 :186

Yes :314 1:368 1 :332 1st Qu.: 15.00 $60,000-$74,999:293

NA's: 54 2 : 29 Median : 43.00 >$75,000 :254

NA's: 7 Mean : 47.53

3rd Qu.: 76.00

Max. :119.00

2.2 展示变量数量和样本数量

2.2.1 展示变量(列)数

dim(mydata)[2]#dim()函数获取数据的维度,即行、列数。所以[1]输出行数,[2]输出列数[1] 26ncol(mydata)#另一种方式[1] 262.2.2 展示行数

dim(mydata)[1][1] 733#或者

nrow(mydata)[1] 7332.2.3 综合展示

print(paste0("该数据集有 ",dim(mydata)[1]," 个样本; ",dim(mydata)[2]," 个变量"))[1] "该数据集有 733 个样本; 26 个变量"2.2.4 展示所有变量名

colnames(mydata) [1] "year" "year2" "age" "race" "marriage"

[6] "grade" "grade2" "tumor_size" "his" "T_stage"

[11] "T_stage_plus" "N_stage" "M_stage" "figo" "figo_plus"

[16] "peri" "surg" "alnd" "plnd" "lnd"

[21] "rad" "chem" "dead" "status" "time"

[26] "income" #或者通过dput函数将所有变量名输出为向量

dput(names(mydata))c("year", "year2", "age", "race", "marriage", "grade", "grade2",

"tumor_size", "his", "T_stage", "T_stage_plus", "N_stage", "M_stage",

"figo", "figo_plus", "peri", "surg", "alnd", "plnd", "lnd", "rad",

"chem", "dead", "status", "time", "income")2.2.5 展示所有行名称

```{r}

#| eval: false

rownames(mydata)

```2.2.6 展示某个变量的所有值及其频数

table(mydata$his)

LMS ESS

448 285 hist(mydata$age, col="coral")#以直方图的形式展示

3 数据整理

3.1 排序

library(dplyr)

mydata <- arrange(mydata, age)#按照某列升序排序

mydata$age[1:10] [1] 23 24 24 24 26 27 27 27 27 28mydata <- arrange(mydata, desc(age))#按照某列降序排序

mydata$age[1:10] [1] 95 92 89 87 85 85 85 84 82 82mydata <- arrange(mydata, his, tumor_size)#根据多列排序

mydata[1:5,c("his", "tumor_size")] his tumor_size

1 LMS 10

2 LMS 12

3 LMS 12

4 LMS 15

5 LMS 17mydata[445:455,c("his", "tumor_size")] his tumor_size

445 LMS NA

446 LMS NA

447 LMS NA

448 LMS NA

449 ESS 4

450 ESS 5

451 ESS 5

452 ESS 9

453 ESS 10

454 ESS 10

455 ESS 12也可用自带base包内的order()函数排序:

mydata <- mydata[order(mydata$age),]

mydata <- mydata[order(-mydata$age),]

mydata <- mydata[order(mydata$age, mydata$his, mydata$tumor_size),]3.2 重新命名行、列

3.2.1 重新命名变量(列)

names(mydata) <- c("N","patient_ID","diagnosis") # 连续命名

colnames(mydata)[2] <- 'patient_ID'# 重新命名指定列名3.2.2 设置行名

rownames(mydata) <- mydata$ID # 将ID列设置为行名(注意不能有重复值)3.3 数据筛选

3.3.1 提取某几列数据形成新的数据集

vnumber <- mydata[, 4:16] # 提取第4-16列的数据形成新的“vnumber”数据集

vnumber <- mydata[,c(2:12,16)] # 提取2-12列和第16列的数据3.3.2 提取指定行数的数据

mydata_less <- mydata[1:100, ]#提取1-100行的数据3.3.3 筛选数据

筛选出低级别、接受了放疗的病例,并生成新的”new_data”数据集

#方法一

new_data<-subset(mydata,grade == "Well differentiated; Grade I" & rad == "Yes")

new_data[,c("grade", "rad")] grade rad

140 Well differentiated; Grade I Yes

160 Well differentiated; Grade I Yes

486 Well differentiated; Grade I Yes

541 Well differentiated; Grade I Yes

593 Well differentiated; Grade I Yes

697 Well differentiated; Grade I Yes#也可用“|”(或者),“!”(NOT)连接

#方法二

new_data <- mydata[which((mydata$grade == "Well differentiated; Grade I") &

(mydata$rad == "Yes")),]

new_data[,c("grade", "rad")] grade rad

140 Well differentiated; Grade I Yes

160 Well differentiated; Grade I Yes

486 Well differentiated; Grade I Yes

541 Well differentiated; Grade I Yes

593 Well differentiated; Grade I Yes

697 Well differentiated; Grade I Yes3.4 合并两个数据集

3.4.1 纵向合并

即增加个案,要求两个数据集具有相同的列名及列数

rbind_data <- rbind(mydata, mydata2)3.4.2 横向合并

直接通过cbind()函数合并数据集,要求两个数据集具有相同的行数及顺序

total <- cbind(dataframeA, dataframeB)3.4.3 以某一列(如学号等)匹配两个数据集

详细解读:merge()函数--R语言_merge函数-CSDN博客

# 以"probe_id"为匹配标准匹配探针id和gene symbol

exptab1 <- merge(x = ids,

y = expset1,#x、y为要合并的数据框或者对象

by ="probe_id", #指定以哪一列为标准匹配两个数据集。

#如果有多个匹配项,则所有可能的匹配项各贡献一行。

all.x=F,#是否将没有匹配到y数据集的行也保留下来,并以NA替代。

#默认为FALSE,只有x与y数据框相匹配的行会被包含在输出结果中

all.y=F)#与上面类似如果两个数据集要用来匹配的列的列名不同则可用by.x和by.y指定。如下面的代码就是用id2symbol数据集中的ENSEMBL列去匹配rawcount数据集中的GeneID列

rawcount <- merge(id2symbol,

rawcount,

by.x="ENSEMBL",

by.y="GeneID",

all.y=T)#对于没有匹配到的GeneID以NA替代

3.5 去重(保留唯一值)

生成带有重复值的示例数据

set.seed(123)

mydata = data.frame(ID = c(1:10,9,4,4,9,9,2), y = rnorm(16))

mydata <- rbind(mydata, mydata)

mydata ID y

1 1 -0.56047565

2 2 -0.23017749

3 3 1.55870831

4 4 0.07050839

5 5 0.12928774

6 6 1.71506499

7 7 0.46091621

8 8 -1.26506123

9 9 -0.68685285

10 10 -0.44566197

11 9 1.22408180

12 4 0.35981383

13 4 0.40077145

14 9 0.11068272

15 9 -0.55584113

16 2 1.78691314

17 1 -0.56047565

18 2 -0.23017749

19 3 1.55870831

20 4 0.07050839

21 5 0.12928774

22 6 1.71506499

23 7 0.46091621

24 8 -1.26506123

25 9 -0.68685285

26 10 -0.44566197

27 9 1.22408180

28 4 0.35981383

29 4 0.40077145

30 9 0.11068272

31 9 -0.55584113

32 2 1.78691314通过duplicated()函数检查某一列是否有重复值,及有多少重复值

table(duplicated(mydata$ID))

FALSE TRUE

10 22 通过unique()函数去除完全相同的行。unique()函数:一行的所有数据都相同认定为重复

mydata <- unique(mydata)

mydata ID y

1 1 -0.56047565

2 2 -0.23017749

3 3 1.55870831

4 4 0.07050839

5 5 0.12928774

6 6 1.71506499

7 7 0.46091621

8 8 -1.26506123

9 9 -0.68685285

10 10 -0.44566197

11 9 1.22408180

12 4 0.35981383

13 4 0.40077145

14 9 0.11068272

15 9 -0.55584113

16 2 1.78691314通过distinct()函数,去除ID列重复的数据

library(dplyr)

mydata <- distinct(mydata, # 需要去重的数据集名称

ID, # 按照哪一列去重(可为多个条件)

.keep_all = T) # 去重后保留所有列

mydata ID y

1 1 -0.56047565

2 2 -0.23017749

3 3 1.55870831

4 4 0.07050839

5 5 0.12928774

6 6 1.71506499

7 7 0.46091621

8 8 -1.26506123

9 9 -0.68685285

10 10 -0.445661973.6 转换变量类型

将结局变量转换成因子变量,ordered=F,用于定义无序多分类变量,起到设置哑变量的作用;ordered=T用于定义有序多分类变量。如果变量的取值以英文字符表示,那么默认以变量首字母的顺序编号赋值;如果变量的取值已经转换成数字,那么默认按照编号的大小依次赋值。可以通过指定”levels”选项来覆盖默认排序。

savdata$stage <- factor(savdata$stage,

levels = c(1,2,3,4),

labels = c("I","II","III","IV"),

ordered = T)

savdata$stage <- relevel(savdata$stage,ref="IV") # 设置因子的参照水平,仅限无序因子变量通过lapply函数批量转换因子变量

mydata[2:14] <- lapply(mydata[2:14], factor) # 转换几个连续列的因子变量批量转换多个指定因子变量

catvars<-c("year", "race", "single", "grade", "T_stage", "N_stage", "M_stage",

"surgery", "lymphadenectomy", "radiotherapy", "chemotherapy")

mydata[catvars] <- lapply(mydata[catvars], factor)转换为数值型变量

mydata$grade <- as.numeric(mydata$grade)

mydata = lapply(mydata, as.numeric) # 将所有的变量转换成数值型3.7 哑变量设置

# 因种族为无序多分类变量,需要设置三个哑变量(race1~3)

savdata$race1 <- ifelse(savdata$race == "白种人", 1, 0)

savdata$race2 <- ifelse(savdata$race == "黑种人", 1, 0)

savdata$race3 <- ifelse(savdata$race == "其他种族", 1, 0)4 数学函数

abs(-4) #取绝对值[1] 4sqrt(16) #开平方根[1] 4log(4,base=2) #取2为底的对数[1] 2log10(100) #取10为底的对数[1] 2log(2) #取2的自然对数[1] 0.6931472exp(2) #取e的指数函数[1] 7.389056#设置小数位数

ceiling(3.14159) #取不小于x的最小整数(有小数点一律进一位)[1] 4floor(3.99999) #取不大于x的最大整数(忽略小数点)[1] 3sprintf("%0.3f", 3.14159) #四舍五入保留3位小数[1] "3.142"round(3.14159,digits=3) #同上。注意该函数在处理科学计数法时无法有效保留目标小数位数[1] 3.1425 自定义函数

R语言可以自定义函数,也可以使用其自带的函数。

R语言中,自定义函数的一般格式为:

函数名 <- function(输入1,……,输入n){

函数体

return(返回值)

}其中,return并不是必需的,默认函数体最后一行的值作为返回值,即return完全可以换成”返回值”。下面以判断score为优良及格差的代码进行讲解。案例来源:https://zhuanlan.zhihu.com/p/441710174。

首先对于不用函数的情况

score = 73

if(score >= 90){

res = "优"

}else if(score >=70){

res = "良"

}else if(score >= 60){

res = "及格"

}else{

res = "不及格"

}

res#输出判断结果[1] "良"接下来我们自定义一个scorejudge()函数实现对单个成绩对判断。实际上就是把上面的代码封装起来

scorejudge<-function(x){

if(score >= 90){

res = "优"

}else if(score >=70){

res = "良"

}else if(score >= 60){

res = "及格"

}else{

res = "不及格"

}

paste0("该同学的分数等级为",res)

}

scorejudge(score)#就像调用R自带函数一样调用我们自己编写的函数[1] "该同学的分数等级为良"如若想要同时查询多个分数,则需要对原来的代码进行修改,加入for循环语句

scorejudge<-function(x){

n = length(x)#首先确定循环次数,即x中有多少个分数,下面的for循环就要运行多少次

res = vector("character",n)#建立一个和输入的分数个数相同的空向量,用来放每次for循环的输出结果

for(i in 1:n){

if(x[i] >= 90){

res[i] = paste0(i,"号同学的分数等级为","优")

} else if(x[i] >=70){

res[i] = paste0(i,"号同学的分数等级为","良")

} else if(x[i] >= 60){

res[i] = paste0(i,"号同学的分数等级为","及格")

} else{

res[i] = paste0(i,"号同学的分数等级为","不及格")

}

}

res #输出最终的res向量

}

scorejudge(c(34,67,89,95))[1] "1号同学的分数等级为不及格" "2号同学的分数等级为及格"

[3] "3号同学的分数等级为良" "4号同学的分数等级为优" ### 基于dplyr包的数据整理

Code

参考:

Data transformation chapter in R for Data Science

1 介绍

dplyr包是tidyverse的核心包之一,为数据处理提供了一系列方便快捷的函数。本章将以nycflights13包中的flights案例数据来介绍基于dplyr包的数据处理语法。该数据集包含 2013 年从纽约市起飞的所有 336,776 次航班的信息。

library(dplyr)

data(flights, package = "nycflights13")

flights# A tibble: 336,776 × 19

year month day dep_time sched_dep_time dep_delay arr_time sched_arr_time

<int> <int> <int> <int> <int> <dbl> <int> <int>

1 2013 1 1 517 515 2 830 819

2 2013 1 1 533 529 4 850 830

3 2013 1 1 542 540 2 923 850

4 2013 1 1 544 545 -1 1004 1022

5 2013 1 1 554 600 -6 812 837

6 2013 1 1 554 558 -4 740 728

7 2013 1 1 555 600 -5 913 854

8 2013 1 1 557 600 -3 709 723

9 2013 1 1 557 600 -3 838 846

10 2013 1 1 558 600 -2 753 745

# ℹ 336,766 more rows

# ℹ 11 more variables: arr_delay <dbl>, carrier <chr>, flight <int>,

# tailnum <chr>, origin <chr>, dest <chr>, air_time <dbl>, distance <dbl>,

# hour <dbl>, minute <dbl>, time_hour <dttm>这里的flights数据是一个 tibble,这是一种升级版的data.frame,被 tidyverse 用来避免一些data.frame的常见问题。Tibbles 和data.frame之间的一个重要的区别在于 tibbles 打印数据的方式:tibbles 是为大型数据集设计的,因此只显示前几行和适应屏幕宽度的列(如上)。可以使用 print(flights, width = Inf) 显示所有列,或者使用 glimpse():

glimpse(flights)Rows: 336,776

Columns: 19

$ year <int> 2013, 2013, 2013, 2013, 2013, 2013, 2013, 2013, 2013, 2…

$ month <int> 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1…

$ day <int> 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1, 1…

$ dep_time <int> 517, 533, 542, 544, 554, 554, 555, 557, 557, 558, 558, …

$ sched_dep_time <int> 515, 529, 540, 545, 600, 558, 600, 600, 600, 600, 600, …

$ dep_delay <dbl> 2, 4, 2, -1, -6, -4, -5, -3, -3, -2, -2, -2, -2, -2, -1…

$ arr_time <int> 830, 850, 923, 1004, 812, 740, 913, 709, 838, 753, 849,…

$ sched_arr_time <int> 819, 830, 850, 1022, 837, 728, 854, 723, 846, 745, 851,…

$ arr_delay <dbl> 11, 20, 33, -18, -25, 12, 19, -14, -8, 8, -2, -3, 7, -1…

$ carrier <chr> "UA", "UA", "AA", "B6", "DL", "UA", "B6", "EV", "B6", "…

$ flight <int> 1545, 1714, 1141, 725, 461, 1696, 507, 5708, 79, 301, 4…

$ tailnum <chr> "N14228", "N24211", "N619AA", "N804JB", "N668DN", "N394…

$ origin <chr> "EWR", "LGA", "JFK", "JFK", "LGA", "EWR", "EWR", "LGA",…

$ dest <chr> "IAH", "IAH", "MIA", "BQN", "ATL", "ORD", "FLL", "IAD",…

$ air_time <dbl> 227, 227, 160, 183, 116, 150, 158, 53, 140, 138, 149, 1…

$ distance <dbl> 1400, 1416, 1089, 1576, 762, 719, 1065, 229, 944, 733, …

$ hour <dbl> 5, 5, 5, 5, 6, 5, 6, 6, 6, 6, 6, 6, 6, 6, 6, 5, 6, 6, 6…

$ minute <dbl> 15, 29, 40, 45, 0, 58, 0, 0, 0, 0, 0, 0, 0, 0, 0, 59, 0…

$ time_hour <dttm> 2013-01-01 05:00:00, 2013-01-01 05:00:00, 2013-01-01 0…在这两种视图中,变量名下方或后面都有相应的缩写,代表每个变量的类型:<int> 代表整数型数据, 代表数值型数据, 代表字符型数据, 代表日期时间型数据。这些变量非常重要,因为对列进行的操作在很大程度上取决于该列的 “类型”。更多关于tibble的说明参考tibble包的官方文档。

dplyr语法的共同特点:

-

第一个参数始终是数据集(tibble或data.frame)的名字。

-

后面的参数通常使用变量名(不带引号)来描述要对哪些列进行操作。

-

输出总是一个新的tibble或data.frame。

dplyr 的函数可以根据它们的操作对象分为四类:分别是对行进行操作的函数、对列进行操作的函数、对表进行操作的函数以及分组统计函数,同时还包括一个特殊的管道符号%>%。本章将介绍除对表进行操作之外的函数。

2 管道操作符

R中有两种管道操作符(pipe operator),分别是R自带的来自base包的|>,和来自magrittr包(上级包是dplyr和tidyverse)的%>%。我们可以将管道操作符理解为车间里的流水线,经过前一步加工的产品才能进入后一步进一步加工,其作用是将上一步的结果直接传参给下一步的函数,从而省略了中间的赋值步骤,可以大量减少中间变量,节省内存。例如:

# 不使用管道操作服

x <- rnorm(10)

y <- sort(x)

plot(y)

# 管道调用

rnorm(10) |> sort() |> plot()

# or

10 |> rnorm() |> sort() |> plot()如果x, y并不会被后面的代码用到的话,那么减少这种中间变量的产生是有利于代码的整洁和降低变量冲突的风险的。

如果不使用管道操作,同时要避免产生中间变量的话就需要嵌套代码,而管道操作则通过一种链式调用的方式去写嵌套调用的代码,使代码更清晰和易于理解。比如:

# 嵌套调用

plot(sort(rnorm(10)))

# 管道调用

rnorm(10) |> sort() |> plot()很明显管道的调用逻辑要比嵌套调用更加清晰而符合直觉。

Tip

-

来自

magrittr包的管道符%>%和base包的|>存在一些语法上的区别,%>%的功能更多(见下文)。 -

在一般使用时,如果不需要

%>%的高级功能,建议直接用从2021年的R 4.1.0开始原生支持的|>作为默认管道符。如果需要用到高级功能,或习惯tidyverse包的数据处理语法,则再考虑使用%>%。 -

RStudio目前通过快捷键

Command+Shift+M默认插入的是%>%符号,可以通过在设置中勾选如下选项来让该快捷键默认插入|>。

2.1 管道的基本用法

管道的用法就是通过管道符|>或%>%串联起来前后的两个函数调用,先计算管道符号左边的函数调用,然后将其结果自动传递给管道符号右边函数的第一个参数(默认),然后对运行这个函数,正如上面的例子中提到的一样。如果不想把值传递给第一个参数,则可以用占位符_(适用于|>)或.(适用于%>%)的形式指定把前面的运算结果传递给哪个参数。

比如想在mtcars数据集的车名中寻找所有以“M”开头的车名,则可以通过如下方式寻找:

mtcars |> rownames() |> grep("^M", x = _) [1] 1 2 8 9 10 11 12 13 14 31#或用%>%形式

library(magrittr) # 也可以直接加载dplyr或tidyverse包,便于后续调用其他tidyverse函数

mtcars %>% rownames() %>% grep(pattern = "^M", x = .) [1] 1 2 8 9 10 11 12 13 14 31解释如下:在grep函数那里,由于我们想在车名(这里是行名)中找到符合特定pattern的车名位置,因此需要把车名传给grep的第二个参数x,所以就可以.或_的形式将前面的值传给grep的x。

⚠️注意:传给其他位置的.必须是独立的,不能在一个表达式(函数)中,比如如下情况,我只想寻找前10个车名中以“M”开头的车名位置:

# 错误 ---------------

mtcars %>% rownames %>% grep("^M", x = .[1:10])Warning in grep(., "^M", x = .[1:10]): argument 'pattern' has length > 1 and

only the first element will be used[1] 1 2# 正确 ---------------

mtcars[1:10, ] %>% rownames %>% grep("^M", x = .)[1] 1 2 8 9 10上面的错误调用中,传递给grep的x参数的是一个表达式.[1:10],不是一个单独的.了,因此失去了调整前面值的位置的作用,它就等价于如下调用:

# 错误 ---------------

mtcars %>% rownames %>% grep("^M", x = .[1:10])

# 等价于 --------------

# 还是把前面的值传递给第一个参数:

mtcars %>% rownames %>% grep(., "^M", x = .[1:10])2.2 管道的进阶用法

我们可以通过“{}”符号包裹后续函数,在“{}”内的代码,可以任意的使用多个占位符.去传递管道前的值。还是上面的例子:

mtcars[1:10, ] %>% rownames() %>% grep("^M", x = .) %>% plot()

# 用“{}”的形式 ---------------

mtcars %>% rownames %>% {

grep("^M", x = .[1:10])} %>% plot()⚠️注意,|>不支持“{}”形式:

# 错误:

mtcars |> rownames() |> {grep("^M", x = _[1:10])}这也反映出base包|>功能的局限性。

本质上“{}”是magrittr改写的一个匿名函数,只有唯一的一个参数,也就是. :

function(.) {

# any code

}比如想要获取mtcars的前5行前5列,然后更改行名和列名后,再返回这个数据框:

df <- mtcars %>% .[1:5, 1:5] %>%

{

rownames(.) <- paste0("row", 1:5)

colnames(.) <- paste0("col", 1:5)

. # <---------- 不要忘了返回这个数据框

}

df col1 col2 col3 col4 col5

row1 21.0 6 160 110 3.90

row2 21.0 6 160 110 3.90

row3 22.8 4 108 93 3.85

row4 21.4 6 258 110 3.08

row5 18.7 8 360 175 3.15⚠️注意,在整个“{}”包括的语句中,如果再使用管道要注意这时的占位符.代表的是“{}”内的对象。

mtcars %>% .[1:5, 1:5] %>%

{

rownames(.) <- paste0("row", 1:5)

colnames(.) <- paste0("col", 1:5)

.[1:3, ] %>% cbind(., .) # cbind里面的.不指代{}外面的值

} col1 col2 col3 col4 col5 col1 col2 col3 col4 col5

row1 21.0 6 160 110 3.90 21.0 6 160 110 3.90

row2 21.0 6 160 110 3.90 21.0 6 160 110 3.90

row3 22.8 4 108 93 3.85 22.8 4 108 93 3.85# 等价:

mtcars %>% .[1:5, 1:5] %>%

{

rownames(.) <- paste0("row", 1:5)

colnames(.) <- paste0("col", 1:5)

.

} %>%

.[1:3, ] %>%

cbind(., .) col1 col2 col3 col4 col5 col1 col2 col3 col4 col5

row1 21.0 6 160 110 3.90 21.0 6 160 110 3.90

row2 21.0 6 160 110 3.90 21.0 6 160 110 3.90

row3 22.8 4 108 93 3.85 22.8 4 108 93 3.852.3 特殊管道符

magrittr包内除了%>%管道符外,还提供了%$%、%<>%、%T>%、%!>%,他们的作用简述如下:

2.3.1 %$%

用于传递管道左侧数据的names:

colnames(mtcars) [1] "mpg" "cyl" "disp" "hp" "drat" "wt" "qsec" "vs" "am" "gear"

[11] "carb"# mtcars的每个元素都可以被后面的函数所使用

mtcars %$% plot(mpg, cyl)

# 等价于

mtcars %>% {

plot(.[,"mpg"], .[, "cyl"])}

sum(mtcars$mpg, mtcars$cyl)[1] 840.92.3.2 %<>%

将管道的结果最终再赋值回最左侧的变量:

set.seed(1234)

x <- rnorm(5)

x[1] -1.2070657 0.2774292 1.0844412 -2.3456977 0.4291247# x排序后加上10,最后再赋值给x

x %<>% sort() %>% {. + 10}

x[1] 7.654302 8.792934 10.277429 10.429125 11.084441# 等价于

x <- x %>% sort() %>% {. + 10}2.3.3 %T>%

分支管道,传入左侧的值并运算后将原始值而不是运算结果传递给后续管道。这在多个管道中间使用print()、plot()或summary()这些函数返回信息时非常有用。

1:5 %>% plot() %>% sum() # 传递给sum()的是前面所有函数的运算结果,由于plot()不返回任何数值,所以sum()的结果为0[1] 01:5 %T>% plot() %>% sum() # 传递给sum()的是1:5

[1] 15# 另一个例子

rnorm(200) %>%

matrix(ncol = 2) %T>%

plot %>%

colSums() # 传递给colSums()的是“rnorm(200) %>% matrix(ncol = 2)”

[1] -15.23708 7.826923 对行的操作

3.1 filter()

用于提取满足某(些)条件的行,基本等同于subset()。

# 查找所有晚点 120 分钟(两小时)以上起飞的航班:

filter(flights, dep_delay > 120)# A tibble: 9,723 × 19

year month day dep_time sched_dep_time dep_delay arr_time sched_arr_time

<int> <int> <int> <int> <int> <dbl> <int> <int>

1 2013 1 1 848 1835 853 1001 1950

2 2013 1 1 957 733 144 1056 853

3 2013 1 1 1114 900 134 1447 1222

4 2013 1 1 1540 1338 122 2020 1825

5 2013 1 1 1815 1325 290 2120 1542

6 2013 1 1 1842 1422 260 1958 1535

7 2013 1 1 1856 1645 131 2212 2005

8 2013 1 1 1934 1725 129 2126 1855

9 2013 1 1 1938 1703 155 2109 1823

10 2013 1 1 1942 1705 157 2124 1830

# ℹ 9,713 more rows

# ℹ 11 more variables: arr_delay <dbl>, carrier <chr>, flight <int>,

# tailnum <chr>, origin <chr>, dest <chr>, air_time <dbl>, distance <dbl>,

# hour <dbl>, minute <dbl>, time_hour <dttm># 查找一月或二月起飞的航班

filter(flights, month %in% c(1, 2))# A tibble: 51,955 × 19

year month day dep_time sched_dep_time dep_delay arr_time sched_arr_time

<int> <int> <int> <int> <int> <dbl> <int> <int>

1 2013 1 1 517 515 2 830 819

2 2013 1 1 533 529 4 850 830

3 2013 1 1 542 540 2 923 850

4 2013 1 1 544 545 -1 1004 1022

5 2013 1 1 554 600 -6 812 837

6 2013 1 1 554 558 -4 740 728

7 2013 1 1 555 600 -5 913 854

8 2013 1 1 557 600 -3 709 723

9 2013 1 1 557 600 -3 838 846

10 2013 1 1 558 600 -2 753 745

# ℹ 51,945 more rows

# ℹ 11 more variables: arr_delay <dbl>, carrier <chr>, flight <int>,

# tailnum <chr>, origin <chr>, dest <chr>, air_time <dbl>, distance <dbl>,

# hour <dbl>, minute <dbl>, time_hour <dttm>3.2 arrange()

排序,以某列为依据对行进行排序(在前面的数据处理基本函数一章中已涉及该函数)。对应的功能在base包中是order()函数。如果提供的列名不止一个,则依次根据提供的列的顺序对数据进行排序。例如,下面的代码按航班出发时间排序,出发时间分布在四列中。我们首先得到最早的年份,然后在一年内得到最早的月份,依此类推。

arrange(flights, year, month, day, dep_time)# A tibble: 336,776 × 19

year month day dep_time sched_dep_time dep_delay arr_time sched_arr_time

<int> <int> <int> <int> <int> <dbl> <int> <int>

1 2013 1 1 517 515 2 830 819

2 2013 1 1 533 529 4 850 830

3 2013 1 1 542 540 2 923 850

4 2013 1 1 544 545 -1 1004 1022

5 2013 1 1 554 600 -6 812 837

6 2013 1 1 554 558 -4 740 728

7 2013 1 1 555 600 -5 913 854

8 2013 1 1 557 600 -3 709 723

9 2013 1 1 557 600 -3 838 846

10 2013 1 1 558 600 -2 753 745

# ℹ 336,766 more rows

# ℹ 11 more variables: arr_delay <dbl>, carrier <chr>, flight <int>,

# tailnum <chr>, origin <chr>, dest <chr>, air_time <dbl>, distance <dbl>,

# hour <dbl>, minute <dbl>, time_hour <dttm>可以加上desc()实现降序排列:

arrange(flights, desc(dep_delay))# A tibble: 336,776 × 19

year month day dep_time sched_dep_time dep_delay arr_time sched_arr_time

<int> <int> <int> <int> <int> <dbl> <int> <int>

1 2013 1 9 641 900 1301 1242 1530

2 2013 6 15 1432 1935 1137 1607 2120

3 2013 1 10 1121 1635 1126 1239 1810

4 2013 9 20 1139 1845 1014 1457 2210

5 2013 7 22 845 1600 1005 1044 1815

6 2013 4 10 1100 1900 960 1342 2211

7 2013 3 17 2321 810 911 135 1020

8 2013 6 27 959 1900 899 1236 2226

9 2013 7 22 2257 759 898 121 1026

10 2013 12 5 756 1700 896 1058 2020

# ℹ 336,766 more rows

# ℹ 11 more variables: arr_delay <dbl>, carrier <chr>, flight <int>,

# tailnum <chr>, origin <chr>, dest <chr>, air_time <dbl>, distance <dbl>,

# hour <dbl>, minute <dbl>, time_hour <dttm>3.3 distinct()

查找数据集中所有唯一的行。

# 移除所有完全相同的行

distinct(flights)# A tibble: 336,776 × 19

year month day dep_time sched_dep_time dep_delay arr_time sched_arr_time

<int> <int> <int> <int> <int> <dbl> <int> <int>

1 2013 1 1 517 515 2 830 819

2 2013 1 1 533 529 4 850 830

3 2013 1 1 542 540 2 923 850

4 2013 1 1 544 545 -1 1004 1022

5 2013 1 1 554 600 -6 812 837

6 2013 1 1 554 558 -4 740 728

7 2013 1 1 555 600 -5 913 854

8 2013 1 1 557 600 -3 709 723

9 2013 1 1 557 600 -3 838 846

10 2013 1 1 558 600 -2 753 745

# ℹ 336,766 more rows

# ℹ 11 more variables: arr_delay <dbl>, carrier <chr>, flight <int>,

# tailnum <chr>, origin <chr>, dest <chr>, air_time <dbl>, distance <dbl>,

# hour <dbl>, minute <dbl>, time_hour <dttm># 查找所有唯一的出发地和目的地配对

distinct(flights, origin, dest)# A tibble: 224 × 2

origin dest

<chr> <chr>

1 EWR IAH

2 LGA IAH

3 JFK MIA

4 JFK BQN

5 LGA ATL

6 EWR ORD

7 EWR FLL

8 LGA IAD

9 JFK MCO

10 LGA ORD

# ℹ 214 more rows可以看到,如果根据某列或某几列为依据来查找非重复值,那么默认只输出这几列,我们可以通过加入.keep_all = TRUE参数来保留其他列。.表示 .keep_all 是函数的一个参数,而不是另一个变量的名称。

distinct(flights, origin, dest, .keep_all = TRUE)# A tibble: 224 × 19

year month day dep_time sched_dep_time dep_delay arr_time sched_arr_time

<int> <int> <int> <int> <int> <dbl> <int> <int>

1 2013 1 1 517 515 2 830 819

2 2013 1 1 533 529 4 850 830

3 2013 1 1 542 540 2 923 850

4 2013 1 1 544 545 -1 1004 1022

5 2013 1 1 554 600 -6 812 837

6 2013 1 1 554 558 -4 740 728

7 2013 1 1 555 600 -5 913 854

8 2013 1 1 557 600 -3 709 723

9 2013 1 1 557 600 -3 838 846

10 2013 1 1 558 600 -2 753 745

# ℹ 214 more rows

# ℹ 11 more variables: arr_delay <dbl>, carrier <chr>, flight <int>,

# tailnum <chr>, origin <chr>, dest <chr>, air_time <dbl>, distance <dbl>,

# hour <dbl>, minute <dbl>, time_hour <dttm>可以发现所有这些不同的航班都是在 1 月 1 日,这绝非巧合:distinct() 会在数据集中找到唯一值第一次出现的那一行,并舍弃其他行。

如果要得到每种出发地和目的地配对出现的次数,可以将 distinct() 换成 count(),并可使用 sort = TRUE 参数按出现次数降序排列。count()同样来自dplyr包,用于快速统计一个或多个变量的唯一值的出现次数。

count(flights, origin, dest, sort = TRUE)# A tibble: 224 × 3

origin dest n

<chr> <chr> <int>

1 JFK LAX 11262

2 LGA ATL 10263

3 LGA ORD 8857

4 JFK SFO 8204

5 LGA CLT 6168

6 EWR ORD 6100

7 JFK BOS 5898

8 LGA MIA 5781

9 JFK MCO 5464

10 EWR BOS 5327

# ℹ 214 more rows3.4 nth()

first(x) 、 last(x) 和 nth(x, n) 都是用于从向量中提取特定位置的值的函数。

-

first(x):提取x中的第一个值 -

last(x):提取x中最后一个值 -

nth(x, n):提取x中的第n个值

它们有共同的可选参数:

-

order_by:提供一个和x相同长度的向量,按照这个向量的顺序对x排序。默认是按照x的原始顺序取值。 -

na_rm:在取值前是否忽略x中的缺失值。⚠️注意不要写成了na.rm。

例如,提取每天数据中的第一个、第五个和最后一个“dep_time”记录:

flights %>%

group_by(year, month, day) |>

summarize(

first_dep = first(dep_time, na_rm = TRUE),

fifth_dep = nth(dep_time, 5, na_rm = TRUE),

last_dep = last(dep_time, na_rm = TRUE)

)# A tibble: 365 × 6

# Groups: year, month [12]

year month day first_dep fifth_dep last_dep

<int> <int> <int> <int> <int> <int>

1 2013 1 1 517 554 2356

2 2013 1 2 42 535 2354

3 2013 1 3 32 520 2349

4 2013 1 4 25 531 2358

5 2013 1 5 14 534 2357

6 2013 1 6 16 555 2355

7 2013 1 7 49 536 2359

8 2013 1 8 454 544 2351

9 2013 1 9 2 524 2252

10 2013 1 10 3 530 2320

# ℹ 355 more rows在R语言的基础函数中实现 nth(x, n) 类似效果的是“[]”。下面的代码用“[]”输出和上面相同的结果:

flights %>%

group_by(year, month, day) %>%

filter(is.na(dep_time) == F) %>%

summarize(

first_dep = dep_time[1],

fifth_dep = dep_time[5],

last_dep = dep_time[n()]

)# A tibble: 365 × 6

# Groups: year, month [12]

year month day first_dep fifth_dep last_dep

<int> <int> <int> <int> <int> <int>

1 2013 1 1 517 554 2356

2 2013 1 2 42 535 2354

3 2013 1 3 32 520 2349

4 2013 1 4 25 531 2358

5 2013 1 5 14 534 2357

6 2013 1 6 16 555 2355

7 2013 1 7 49 536 2359

8 2013 1 8 454 544 2351

9 2013 1 9 2 524 2252

10 2013 1 10 3 530 2320

# ℹ 355 more rows但是由于 first(x) 、 last(x) 和 nth(x, n) 可以定义order_by 和 na_rm 等额外参数,因此能够实现更多的应用场景。

4 对列的操作

4.1 mutate()

mutate()的作用是根据现有列计算并添加新列。

# 计算延误航班在空中停留的时间(gain)以及平均速度(speed,英里/小时):

mutate(

flights,

gain = dep_delay - arr_delay,

speed = distance / air_time * 60

)# A tibble: 336,776 × 21

year month day dep_time sched_dep_time dep_delay arr_time sched_arr_time

<int> <int> <int> <int> <int> <dbl> <int> <int>

1 2013 1 1 517 515 2 830 819

2 2013 1 1 533 529 4 850 830

3 2013 1 1 542 540 2 923 850

4 2013 1 1 544 545 -1 1004 1022

5 2013 1 1 554 600 -6 812 837

6 2013 1 1 554 558 -4 740 728

7 2013 1 1 555 600 -5 913 854

8 2013 1 1 557 600 -3 709 723

9 2013 1 1 557 600 -3 838 846

10 2013 1 1 558 600 -2 753 745

# ℹ 336,766 more rows

# ℹ 13 more variables: arr_delay <dbl>, carrier <chr>, flight <int>,

# tailnum <chr>, origin <chr>, dest <chr>, air_time <dbl>, distance <dbl>,

# hour <dbl>, minute <dbl>, time_hour <dttm>, gain <dbl>, speed <dbl>默认情况下,mutate() 会在数据集的最右侧添加计算后的新列,因此很难看到这里发生了什么。我们可以使用 .before 参数将变量添加到数据集的左侧:

mutate(

flights,

gain = dep_delay - arr_delay,

speed = distance / air_time * 60,

.before = 1 # 添加到第一列

)# A tibble: 336,776 × 21

gain speed year month day dep_time sched_dep_time dep_delay arr_time

<dbl> <dbl> <int> <int> <int> <int> <int> <dbl> <int>

1 -9 370. 2013 1 1 517 515 2 830

2 -16 374. 2013 1 1 533 529 4 850

3 -31 408. 2013 1 1 542 540 2 923

4 17 517. 2013 1 1 544 545 -1 1004

5 19 394. 2013 1 1 554 600 -6 812

6 -16 288. 2013 1 1 554 558 -4 740

7 -24 404. 2013 1 1 555 600 -5 913

8 11 259. 2013 1 1 557 600 -3 709

9 5 405. 2013 1 1 557 600 -3 838

10 -10 319. 2013 1 1 558 600 -2 753

# ℹ 336,766 more rows

# ℹ 12 more variables: sched_arr_time <int>, arr_delay <dbl>, carrier <chr>,

# flight <int>, tailnum <chr>, origin <chr>, dest <chr>, air_time <dbl>,

# distance <dbl>, hour <dbl>, minute <dbl>, time_hour <dttm>也可以使用 .after 指定新变量应该在哪个变量后添加,在 .before 和 .after 中,都可以使用变量名和列数两种方法指定新变量出现的位置。例如,我们可以在 “day” 之后添加新变量:

mutate(

flights,

gain = dep_delay - arr_delay,

speed = distance / air_time * 60,

.after = day # 在 “day” 之后添加新变量

)# A tibble: 336,776 × 21

year month day gain speed dep_time sched_dep_time dep_delay arr_time

<int> <int> <int> <dbl> <dbl> <int> <int> <dbl> <int>

1 2013 1 1 -9 370. 517 515 2 830

2 2013 1 1 -16 374. 533 529 4 850

3 2013 1 1 -31 408. 542 540 2 923

4 2013 1 1 17 517. 544 545 -1 1004

5 2013 1 1 19 394. 554 600 -6 812

6 2013 1 1 -16 288. 554 558 -4 740

7 2013 1 1 -24 404. 555 600 -5 913

8 2013 1 1 11 259. 557 600 -3 709

9 2013 1 1 5 405. 557 600 -3 838

10 2013 1 1 -10 319. 558 600 -2 753

# ℹ 336,766 more rows

# ℹ 12 more variables: sched_arr_time <int>, arr_delay <dbl>, carrier <chr>,

# flight <int>, tailnum <chr>, origin <chr>, dest <chr>, air_time <dbl>,

# distance <dbl>, hour <dbl>, minute <dbl>, time_hour <dttm>另外,也可以使用 .keep 参数来控制在计算新变量后哪些变量会被保留:

-

.keep = "all":默认。保留所有变量 -

.keep = "used":保留用于计算新变量的旧变量。这可以用于检查我们的新变量是否计算正确,因为它和原始变量一起展示。 -

.keep = "unused":保留其他不用于计算新变量的旧变量。

例如,下面的输出将只包含旧变量 “dep_delay”、“arr_delay”、“distance”、“air_time”,以及新变量“gain”、“speed”:

mutate(

flights,

gain = dep_delay - arr_delay,

speed = distance / air_time * 60,

.keep = "used"

)# A tibble: 336,776 × 6

dep_delay arr_delay air_time distance gain speed

<dbl> <dbl> <dbl> <dbl> <dbl> <dbl>

1 2 11 227 1400 -9 370.

2 4 20 227 1416 -16 374.

3 2 33 160 1089 -31 408.

4 -1 -18 183 1576 17 517.

5 -6 -25 116 762 19 394.

6 -4 12 150 719 -16 288.

7 -5 19 158 1065 -24 404.

8 -3 -14 53 229 11 259.

9 -3 -8 140 944 5 405.

10 -2 8 138 733 -10 319.

# ℹ 336,766 more rows4.2 select()

选择并输出某几列。

# 根据列名选择某几列

select(flights, year, month, day)# A tibble: 336,776 × 3

year month day

<int> <int> <int>

1 2013 1 1

2 2013 1 1

3 2013 1 1

4 2013 1 1

5 2013 1 1

6 2013 1 1

7 2013 1 1

8 2013 1 1

9 2013 1 1

10 2013 1 1

# ℹ 336,766 more rows# 选择“year”和“day”及其之间的所有列

select(flights, year:day)# A tibble: 336,776 × 3

year month day

<int> <int> <int>

1 2013 1 1

2 2013 1 1

3 2013 1 1

4 2013 1 1

5 2013 1 1

6 2013 1 1

7 2013 1 1

8 2013 1 1

9 2013 1 1

10 2013 1 1

# ℹ 336,766 more rows# 选择不在“year”和“day”及其之间的所有列

select(flights, !year:day)# A tibble: 336,776 × 16

dep_time sched_dep_time dep_delay arr_time sched_arr_time arr_delay carrier

<int> <int> <dbl> <int> <int> <dbl> <chr>

1 517 515 2 830 819 11 UA

2 533 529 4 850 830 20 UA

3 542 540 2 923 850 33 AA

4 544 545 -1 1004 1022 -18 B6

5 554 600 -6 812 837 -25 DL

6 554 558 -4 740 728 12 UA

7 555 600 -5 913 854 19 B6

8 557 600 -3 709 723 -14 EV

9 557 600 -3 838 846 -8 B6

10 558 600 -2 753 745 8 AA

# ℹ 336,766 more rows

# ℹ 9 more variables: flight <int>, tailnum <chr>, origin <chr>, dest <chr>,

# air_time <dbl>, distance <dbl>, hour <dbl>, minute <dbl>, time_hour <dttm># 选择所有字符型的列

select(flights, where(is.character))# A tibble: 336,776 × 4

carrier tailnum origin dest

<chr> <chr> <chr> <chr>

1 UA N14228 EWR IAH

2 UA N24211 LGA IAH

3 AA N619AA JFK MIA

4 B6 N804JB JFK BQN

5 DL N668DN LGA ATL

6 UA N39463 EWR ORD

7 B6 N516JB EWR FLL

8 EV N829AS LGA IAD

9 B6 N593JB JFK MCO

10 AA N3ALAA LGA ORD

# ℹ 336,766 more rowsTip

在 select() 内有许多经常可以组合使用的函数:

-

starts_with("abc"): 以特定字符开头的列名. -

ends_with("xyz"): 以特定字符结尾的列名. -

contains("ijk"): 包含特定字符的列名. -

num_range("x", 1:3): 列名x1,x2和x3.

通过 ?tidyselect::language 获取更多 tidyselect 内的选择函数。

⚠️这些函数只能在 select() 内使用。与之相反,base 包中也有两个类似的函数 startsWith() 和 endsWith() 可以独立使用,它们返回逻辑向量。

可以在选择变量的同时使用 = 对这些变量进行重命名。新变量名在 = 的左侧,旧变量名在右侧(new_name = old_name):

select(flights, tail_num = tailnum)# A tibble: 336,776 × 1

tail_num

<chr>

1 N14228

2 N24211

3 N619AA

4 N804JB

5 N668DN

6 N39463

7 N516JB

8 N829AS

9 N593JB

10 N3ALAA

# ℹ 336,766 more rows4.3 rename()

重命名列。新变量名在 = 的左侧,旧变量名在右侧(new_name = old_name)。

rename(

flights,

years = year,

months = month

)# A tibble: 336,776 × 19

years months day dep_time sched_dep_time dep_delay arr_time sched_arr_time

<int> <int> <int> <int> <int> <dbl> <int> <int>

1 2013 1 1 517 515 2 830 819

2 2013 1 1 533 529 4 850 830

3 2013 1 1 542 540 2 923 850

4 2013 1 1 544 545 -1 1004 1022

5 2013 1 1 554 600 -6 812 837

6 2013 1 1 554 558 -4 740 728

7 2013 1 1 555 600 -5 913 854

8 2013 1 1 557 600 -3 709 723

9 2013 1 1 557 600 -3 838 846

10 2013 1 1 558 600 -2 753 745

# ℹ 336,766 more rows

# ℹ 11 more variables: arr_delay <dbl>, carrier <chr>, flight <int>,

# tailnum <chr>, origin <chr>, dest <chr>, air_time <dbl>, distance <dbl>,

# hour <dbl>, minute <dbl>, time_hour <dttm>Caution

和其他dplyr中的函数一样,rename不会对原始数据进行修改,因此需要将rename后的数据重新赋值给新的对象或覆盖原来的对象以应用对变量名的修改。

如果我们有一个提供了重命名依据的字符串向量,那么可以通过all_of()来基于这个字符串向量对数据集的列进行重命名:

lookup <- c(

years = "year",

months = "month"

)

rename(flights, all_of(lookup))# A tibble: 336,776 × 19

years months day dep_time sched_dep_time dep_delay arr_time sched_arr_time

<int> <int> <int> <int> <int> <dbl> <int> <int>

1 2013 1 1 517 515 2 830 819

2 2013 1 1 533 529 4 850 830

3 2013 1 1 542 540 2 923 850

4 2013 1 1 544 545 -1 1004 1022

5 2013 1 1 554 600 -6 812 837

6 2013 1 1 554 558 -4 740 728

7 2013 1 1 555 600 -5 913 854

8 2013 1 1 557 600 -3 709 723

9 2013 1 1 557 600 -3 838 846

10 2013 1 1 558 600 -2 753 745

# ℹ 336,766 more rows

# ℹ 11 more variables: arr_delay <dbl>, carrier <chr>, flight <int>,

# tailnum <chr>, origin <chr>, dest <chr>, air_time <dbl>, distance <dbl>,

# hour <dbl>, minute <dbl>, time_hour <dttm>如果提供重命名依据的字符串向量中有的变量是原数据集中不存在的,那么可以用 any_of()代替 all_of() 来实现:

lookup <- c(

years = "year",

months = "month",

new = "unknown"

)

rename(flights, any_of(lookup))# A tibble: 336,776 × 19

years months day dep_time sched_dep_time dep_delay arr_time sched_arr_time

<int> <int> <int> <int> <int> <dbl> <int> <int>

1 2013 1 1 517 515 2 830 819

2 2013 1 1 533 529 4 850 830

3 2013 1 1 542 540 2 923 850

4 2013 1 1 544 545 -1 1004 1022

5 2013 1 1 554 600 -6 812 837

6 2013 1 1 554 558 -4 740 728

7 2013 1 1 555 600 -5 913 854

8 2013 1 1 557 600 -3 709 723

9 2013 1 1 557 600 -3 838 846

10 2013 1 1 558 600 -2 753 745

# ℹ 336,766 more rows

# ℹ 11 more variables: arr_delay <dbl>, carrier <chr>, flight <int>,

# tailnum <chr>, origin <chr>, dest <chr>, air_time <dbl>, distance <dbl>,

# hour <dbl>, minute <dbl>, time_hour <dttm>4.3.1 rename_with()

根据函数批量重命名列。

# 将所有列名变为大写

rename_with(flights, toupper)# A tibble: 336,776 × 19

YEAR MONTH DAY DEP_TIME SCHED_DEP_TIME DEP_DELAY ARR_TIME SCHED_ARR_TIME

<int> <int> <int> <int> <int> <dbl> <int> <int>

1 2013 1 1 517 515 2 830 819

2 2013 1 1 533 529 4 850 830

3 2013 1 1 542 540 2 923 850

4 2013 1 1 544 545 -1 1004 1022

5 2013 1 1 554 600 -6 812 837

6 2013 1 1 554 558 -4 740 728

7 2013 1 1 555 600 -5 913 854

8 2013 1 1 557 600 -3 709 723

9 2013 1 1 557 600 -3 838 846

10 2013 1 1 558 600 -2 753 745

# ℹ 336,766 more rows

# ℹ 11 more variables: ARR_DELAY <dbl>, CARRIER <chr>, FLIGHT <int>,

# TAILNUM <chr>, ORIGIN <chr>, DEST <chr>, AIR_TIME <dbl>, DISTANCE <dbl>,

# HOUR <dbl>, MINUTE <dbl>, TIME_HOUR <dttm># 将所有以“dep_"开头的列名转换为大写

rename_with(flights, toupper, .cols = starts_with("dep_"))# A tibble: 336,776 × 19

year month day DEP_TIME sched_dep_time DEP_DELAY arr_time sched_arr_time

<int> <int> <int> <int> <int> <dbl> <int> <int>

1 2013 1 1 517 515 2 830 819

2 2013 1 1 533 529 4 850 830

3 2013 1 1 542 540 2 923 850

4 2013 1 1 544 545 -1 1004 1022

5 2013 1 1 554 600 -6 812 837

6 2013 1 1 554 558 -4 740 728

7 2013 1 1 555 600 -5 913 854

8 2013 1 1 557 600 -3 709 723

9 2013 1 1 557 600 -3 838 846

10 2013 1 1 558 600 -2 753 745

# ℹ 336,766 more rows

# ℹ 11 more variables: arr_delay <dbl>, carrier <chr>, flight <int>,

# tailnum <chr>, origin <chr>, dest <chr>, air_time <dbl>, distance <dbl>,

# hour <dbl>, minute <dbl>, time_hour <dttm># 将列名中所有的"_"替换成“.”,并将所有列名转换成大写

rename_with(

flights,

function(x) {

gsub(pattern = "_", replacement = ".", x = x) %>%

toupper()

}

)# A tibble: 336,776 × 19

YEAR MONTH DAY DEP.TIME SCHED.DEP.TIME DEP.DELAY ARR.TIME SCHED.ARR.TIME

<int> <int> <int> <int> <int> <dbl> <int> <int>

1 2013 1 1 517 515 2 830 819

2 2013 1 1 533 529 4 850 830

3 2013 1 1 542 540 2 923 850

4 2013 1 1 544 545 -1 1004 1022

5 2013 1 1 554 600 -6 812 837

6 2013 1 1 554 558 -4 740 728

7 2013 1 1 555 600 -5 913 854

8 2013 1 1 557 600 -3 709 723

9 2013 1 1 557 600 -3 838 846

10 2013 1 1 558 600 -2 753 745

# ℹ 336,766 more rows

# ℹ 11 more variables: ARR.DELAY <dbl>, CARRIER <chr>, FLIGHT <int>,

# TAILNUM <chr>, ORIGIN <chr>, DEST <chr>, AIR.TIME <dbl>, DISTANCE <dbl>,

# HOUR <dbl>, MINUTE <dbl>, TIME.HOUR <dttm># 匿名函数形式

rename_with(flights, ~ gsub(pattern = "_", replacement = ".", x= .x) %>% toupper())# A tibble: 336,776 × 19

YEAR MONTH DAY DEP.TIME SCHED.DEP.TIME DEP.DELAY ARR.TIME SCHED.ARR.TIME

<int> <int> <int> <int> <int> <dbl> <int> <int>

1 2013 1 1 517 515 2 830 819

2 2013 1 1 533 529 4 850 830

3 2013 1 1 542 540 2 923 850

4 2013 1 1 544 545 -1 1004 1022

5 2013 1 1 554 600 -6 812 837

6 2013 1 1 554 558 -4 740 728

7 2013 1 1 555 600 -5 913 854

8 2013 1 1 557 600 -3 709 723

9 2013 1 1 557 600 -3 838 846

10 2013 1 1 558 600 -2 753 745

# ℹ 336,766 more rows

# ℹ 11 more variables: ARR.DELAY <dbl>, CARRIER <chr>, FLIGHT <int>,

# TAILNUM <chr>, ORIGIN <chr>, DEST <chr>, AIR.TIME <dbl>, DISTANCE <dbl>,

# HOUR <dbl>, MINUTE <dbl>, TIME.HOUR <dttm>4.4 relocate()

调整列的顺序。

# 将“day”和“year”放到最前面

relocate(flights, day, year)# A tibble: 336,776 × 19

day year month dep_time sched_dep_time dep_delay arr_time sched_arr_time

<int> <int> <int> <int> <int> <dbl> <int> <int>

1 1 2013 1 517 515 2 830 819

2 1 2013 1 533 529 4 850 830

3 1 2013 1 542 540 2 923 850

4 1 2013 1 544 545 -1 1004 1022

5 1 2013 1 554 600 -6 812 837

6 1 2013 1 554 558 -4 740 728

7 1 2013 1 555 600 -5 913 854

8 1 2013 1 557 600 -3 709 723

9 1 2013 1 557 600 -3 838 846

10 1 2013 1 558 600 -2 753 745

# ℹ 336,766 more rows

# ℹ 11 more variables: arr_delay <dbl>, carrier <chr>, flight <int>,

# tailnum <chr>, origin <chr>, dest <chr>, air_time <dbl>, distance <dbl>,

# hour <dbl>, minute <dbl>, time_hour <dttm>也可以和上面的[mutate()]一样通过.before 和 .after 参数指定放置位置:

# 将“year”和“dep_time”及其之间的列放到“sched_dep_time”之后

relocate(flights, year:dep_time, .after = sched_dep_time)# A tibble: 336,776 × 19

sched_dep_time year month day dep_time dep_delay arr_time sched_arr_time

<int> <int> <int> <int> <int> <dbl> <int> <int>

1 515 2013 1 1 517 2 830 819

2 529 2013 1 1 533 4 850 830

3 540 2013 1 1 542 2 923 850

4 545 2013 1 1 544 -1 1004 1022

5 600 2013 1 1 554 -6 812 837

6 558 2013 1 1 554 -4 740 728

7 600 2013 1 1 555 -5 913 854

8 600 2013 1 1 557 -3 709 723

9 600 2013 1 1 557 -3 838 846

10 600 2013 1 1 558 -2 753 745

# ℹ 336,766 more rows

# ℹ 11 more variables: arr_delay <dbl>, carrier <chr>, flight <int>,

# tailnum <chr>, origin <chr>, dest <chr>, air_time <dbl>, distance <dbl>,

# hour <dbl>, minute <dbl>, time_hour <dttm># 将所有以“dep_”开头的列放到“sched_dep_time”之前

relocate(flights, starts_with("dep_"), .before = sched_dep_time)# A tibble: 336,776 × 19

year month day dep_time dep_delay sched_dep_time arr_time sched_arr_time

<int> <int> <int> <int> <dbl> <int> <int> <int>

1 2013 1 1 517 2 515 830 819

2 2013 1 1 533 4 529 850 830

3 2013 1 1 542 2 540 923 850

4 2013 1 1 544 -1 545 1004 1022

5 2013 1 1 554 -6 600 812 837

6 2013 1 1 554 -4 558 740 728

7 2013 1 1 555 -5 600 913 854

8 2013 1 1 557 -3 600 709 723

9 2013 1 1 557 -3 600 838 846

10 2013 1 1 558 -2 600 753 745

# ℹ 336,766 more rows

# ℹ 11 more variables: arr_delay <dbl>, carrier <chr>, flight <int>,

# tailnum <chr>, origin <chr>, dest <chr>, air_time <dbl>, distance <dbl>,

# hour <dbl>, minute <dbl>, time_hour <dttm>5 分组统计

5.1 group_by()

根据某一列或几列将数据分组,便于后续的分组统计/运算。

group_by(flights, month)# A tibble: 336,776 × 19

# Groups: month [12]

year month day dep_time sched_dep_time dep_delay arr_time sched_arr_time

<int> <int> <int> <int> <int> <dbl> <int> <int>

1 2013 1 1 517 515 2 830 819

2 2013 1 1 533 529 4 850 830

3 2013 1 1 542 540 2 923 850

4 2013 1 1 544 545 -1 1004 1022

5 2013 1 1 554 600 -6 812 837

6 2013 1 1 554 558 -4 740 728

7 2013 1 1 555 600 -5 913 854

8 2013 1 1 557 600 -3 709 723

9 2013 1 1 557 600 -3 838 846

10 2013 1 1 558 600 -2 753 745

# ℹ 336,766 more rows

# ℹ 11 more variables: arr_delay <dbl>, carrier <chr>, flight <int>,

# tailnum <chr>, origin <chr>, dest <chr>, air_time <dbl>, distance <dbl>,

# hour <dbl>, minute <dbl>, time_hour <dttm>group_by()本身不会改变数据,除了在输出结果中出现了# Groups: month [12],提示我们该数据集进行了分组。这意味着随后的操作将按不同的月份分别进行。group_by()向数据添加了这个分组特性(称为类),从而改变了接下来对数据应用的函数的行为。

5.2 summarize()

分组汇总数据。根据某列或某几列的数据汇总一个包含了统计数据的新表。

# 计算每月的平均起飞延误时间

group_by(flights, month) |>

summarise(avg_delay = mean(dep_delay))# A tibble: 12 × 2

month avg_delay

<int> <dbl>

1 1 NA

2 2 NA

3 3 NA

4 4 NA

5 5 NA

6 6 NA

7 7 NA

8 8 NA

9 9 NA

10 10 NA

11 11 NA

12 12 NA可以看到,这里出现了问题,所有的结果都是“NA”。这是因为一些航班在延误时间(dep_delay)列中有缺失数据,所以当我们计算包括这些缺失值的平均值时,得到了一个NA结果。所以需要在mean()中设置参数 na.rm = TRUE 来忽略所有缺失值:

# 计算每月的平均起飞延误时间

group_by(flights, month) |>

summarise(avg_delay = mean(dep_delay, na.rm = TRUE))# A tibble: 12 × 2

month avg_delay

<int> <dbl>

1 1 10.0

2 2 10.8

3 3 13.2

4 4 13.9

5 5 13.0

6 6 20.8

7 7 21.7

8 8 12.6

9 9 6.72

10 10 6.24

11 11 5.44

12 12 16.6 可以在单次对summarize()的调用中创建任意数量的数据汇总。但其中一个非常有用的汇总函数是n(),它返回每个组中行数:

# 计算每月的平均起飞延误时间和延误航班数量

flights |>

group_by(month) |>

summarize(

avg_delay = mean(dep_delay, na.rm = TRUE),

n = n()

)# A tibble: 12 × 3

month avg_delay n

<int> <dbl> <int>

1 1 10.0 27004

2 2 10.8 24951

3 3 13.2 28834

4 4 13.9 28330

5 5 13.0 28796

6 6 20.8 28243

7 7 21.7 29425

8 8 12.6 29327

9 9 6.72 27574

10 10 6.24 28889

11 11 5.44 27268

12 12 16.6 281355.3 slice_系列函数

分组提取n行数据。

-

df |> slice_head(n = 1)从每一组中取前n行数据. -

df |> slice_tail(n = 1)从每一组中取后n行数据. -

df |> slice_min(x, n = 1)从每一组中取x列的值最小的n行数据. -

df |> slice_max(x, n = 1)从每一组中取x列的值最大的n行数据. -

df |> slice_sample(n = 1)从每一组中随机取n行数据.

其中的n参数指定需要提取的行数,同时,也可以用prop参数指定从每组中提取多少比例的行。例如,prop = 0.1 表示从每组中提取10%的行。

# 找出到达每个目的地的延误最严重的航班

flights %>%

group_by(dest) %>%

slice_max(order_by = arr_delay, n = 1) %>%

relocate(dest, arr_delay) %T>%

print() %>%

nrow()# A tibble: 108 × 19

# Groups: dest [105]

dest arr_delay year month day dep_time sched_dep_time dep_delay arr_time

<chr> <dbl> <int> <int> <int> <int> <int> <dbl> <int>

1 ABQ 153 2013 7 22 2145 2007 98 132

2 ACK 221 2013 7 23 1139 800 219 1250

3 ALB 328 2013 1 25 123 2000 323 229

4 ANC 39 2013 8 17 1740 1625 75 2042

5 ATL 895 2013 7 22 2257 759 898 121

6 AUS 349 2013 7 10 2056 1505 351 2347

7 AVL 228 2013 8 13 1156 832 204 1417

8 BDL 266 2013 2 21 1728 1316 252 1839

9 BGR 238 2013 12 1 1504 1056 248 1628

10 BHM 291 2013 4 10 25 1900 325 136

# ℹ 98 more rows

# ℹ 10 more variables: sched_arr_time <int>, carrier <chr>, flight <int>,

# tailnum <chr>, origin <chr>, air_time <dbl>, distance <dbl>, hour <dbl>,

# minute <dbl>, time_hour <dttm>[1] 108nrow(flights)[1] 336776上面的例子中,relocate()函数后用到了分支管道[%T>%],先通过print()把分组统计的结果打印出来,然后通过nrow()返回分组统计数据的行数。结果发现有108行,和原来数据的105行不符合,这是因为有的目的地可能有几架次并列延误最严重的航班。例如,第22行和23行的航班信息:

flights |>

group_by(dest) |>

slice_max(order_by = arr_delay, n = 1) |>

relocate(dest, arr_delay) |>

_[22:23,]# A tibble: 2 × 19

# Groups: dest [1]

dest arr_delay year month day dep_time sched_dep_time dep_delay arr_time

<chr> <dbl> <int> <int> <int> <int> <int> <dbl> <int>

1 CHS 331 2013 3 8 1202 751 251 1530

2 CHS 331 2013 9 2 1906 1359 307 2134

# ℹ 10 more variables: sched_arr_time <int>, carrier <chr>, flight <int>,

# tailnum <chr>, origin <chr>, air_time <dbl>, distance <dbl>, hour <dbl>,

# minute <dbl>, time_hour <dttm>5.4 多变量分组统计

例如分别统计每个日期(年+月+日)的航班数量:

daily <- flights |>

group_by(year, month, day)

daily |>

summarize(flights = n())# A tibble: 365 × 4

# Groups: year, month [12]

year month day flights

<int> <int> <int> <int>

1 2013 1 1 842

2 2013 1 2 943

3 2013 1 3 914

4 2013 1 4 915

5 2013 1 5 720

6 2013 1 6 832

7 2013 1 7 933

8 2013 1 8 899

9 2013 1 9 902

10 2013 1 10 932

# ℹ 355 more rows需要注意到结果中的第二行提示我们 summarise() 后的数据按照“year”和“month”进行了group处理。这是因为summarise() 在处理超过一个分组的数据时,输出的结果默认去除最后一个分组依据。这一行为可以通过设定.groups参数进行修改:

-

.groups = "drop_last":默认。summarise()后丢掉最后一个分组依据。 -

.groups = "drop":summarise()后取消分组。 -

.groups = "keep":summarise()后保留原分组。

flights |>

group_by(year, month, day) |>

summarize(

flights = n(),

.groups = "keep"

) # A tibble: 365 × 4

# Groups: year, month, day [365]

year month day flights

<int> <int> <int> <int>

1 2013 1 1 842

2 2013 1 2 943

3 2013 1 3 914

4 2013 1 4 915

5 2013 1 5 720

6 2013 1 6 832

7 2013 1 7 933

8 2013 1 8 899

9 2013 1 9 902

10 2013 1 10 932

# ℹ 355 more rows5.5 ungroup()

取消分组。

daily |>

ungroup() |>

summarize(

avg_delay = mean(dep_delay, na.rm = TRUE),

flights = n()

)# A tibble: 1 × 2

avg_delay flights

<dbl> <int>

1 12.6 3367765.6 .by

dplyr从1.1.0版本开始包括了一个新的实验性语法,用于直接在统计函数中指定分组依据,即 .by 参数。group_by() 和 ungroup() 不会消失,但现在也可以使用 .by 参数来在单个操作中进行分组:

flights |>

summarize(

avg_delay = mean(dep_delay, na.rm = TRUE),

flights = n(),

.by = month # 按“month”分组统计

) |>

arrange(month)# A tibble: 12 × 3

month avg_delay flights

<int> <dbl> <int>

1 1 10.0 27004

2 2 10.8 24951

3 3 13.2 28834

4 4 13.9 28330

5 5 13.0 28796

6 6 20.8 28243

7 7 21.7 29425

8 8 12.6 29327

9 9 6.72 27574

10 10 6.24 28889

11 11 5.44 27268

12 12 16.6 28135# 等价于:

flights |>

group_by(month) |>

summarise(

avg_delay = mean(dep_delay, na.rm = TRUE),

flights = n()

)# A tibble: 12 × 3

month avg_delay flights

<int> <dbl> <int>

1 1 10.0 27004

2 2 10.8 24951

3 3 13.2 28834

4 4 13.9 28330

5 5 13.0 28796

6 6 20.8 28243

7 7 21.7 29425

8 8 12.6 29327

9 9 6.72 27574

10 10 6.24 28889

11 11 5.44 27268

12 12 16.6 28135# 支持指定多个分组依据

flights |>

summarize(

avg_delay = mean(dep_delay, na.rm = TRUE),

flights = n(),

.by = c(origin, dest)

) |>

arrange(origin, dest)# A tibble: 224 × 4

origin dest avg_delay flights

<chr> <chr> <dbl> <int>

1 EWR ALB 23.6 439

2 EWR ANC 12.9 8

3 EWR ATL 15.5 5022

4 EWR AUS 11.5 968

5 EWR AVL 8.62 265

6 EWR BDL 17.7 443

7 EWR BNA 17.7 2336

8 EWR BOS 12.5 5327

9 EWR BQN 23.9 297

10 EWR BTV 17.8 931

# ℹ 214 more rows# 等价于:

flights |>

group_by(origin, dest) |>

summarize(

avg_delay = mean(dep_delay, na.rm = TRUE),

flights = n()

) |>

ungroup()# A tibble: 224 × 4

origin dest avg_delay flights

<chr> <chr> <dbl> <int>

1 EWR ALB 23.6 439

2 EWR ANC 12.9 8

3 EWR ATL 15.5 5022

4 EWR AUS 11.5 968

5 EWR AVL 8.62 265

6 EWR BDL 17.7 443

7 EWR BNA 17.7 2336

8 EWR BOS 12.5 5327

9 EWR BQN 23.9 297

10 EWR BTV 17.8 931

# ℹ 214 more rows

### 基于tidyr的长/宽数据转换

Tidyr是tidyverse的核心包之一,其目标是帮助创建整洁的数据。整洁的数据是具有以下特征的数据:

-

每个变量都是一列

-

每个观测值是一行

-

每个值是一个单元格

Figure 1: 整洁数据的基本特征

1 加载包

library(tidyverse)

library(nycflights13)这里的案例数据显示了以三种不同方式组织的相同数据。每个数据集都有相同的四个变量:country(国家)、year(年份)、population(总人口)和cases(结核病病例数),但每个数据集以不同的方式组织这些值。

table1# A tibble: 6 × 4

country year cases population

<chr> <dbl> <dbl> <dbl>

1 Afghanistan 1999 745 19987071

2 Afghanistan 2000 2666 20595360

3 Brazil 1999 37737 172006362

4 Brazil 2000 80488 174504898

5 China 1999 212258 1272915272

6 China 2000 213766 1280428583table2# A tibble: 12 × 4

country year type count

<chr> <dbl> <chr> <dbl>

1 Afghanistan 1999 cases 745

2 Afghanistan 1999 population 19987071

3 Afghanistan 2000 cases 2666

4 Afghanistan 2000 population 20595360

5 Brazil 1999 cases 37737

6 Brazil 1999 population 172006362

7 Brazil 2000 cases 80488

8 Brazil 2000 population 174504898

9 China 1999 cases 212258

10 China 1999 population 1272915272

11 China 2000 cases 213766

12 China 2000 population 1280428583table3# A tibble: 6 × 3

country year rate

<chr> <dbl> <chr>

1 Afghanistan 1999 745/19987071

2 Afghanistan 2000 2666/20595360

3 Brazil 1999 37737/172006362

4 Brazil 2000 80488/174504898

5 China 1999 212258/1272915272

6 China 2000 213766/1280428583table1中的数据符合 Figure 1 中的整洁数据规范。

2 pivot_longer():转换成长数据

这里我们以billboard数据集为例。该数据记录了 2000 年歌曲在广告牌上的排名情况:

billboard# A tibble: 317 × 79

artist track date.entered wk1 wk2 wk3 wk4 wk5 wk6 wk7 wk8

<chr> <chr> <date> <dbl> <dbl> <dbl> <dbl> <dbl> <dbl> <dbl> <dbl>

1 2 Pac Baby… 2000-02-26 87 82 72 77 87 94 99 NA

2 2Ge+her The … 2000-09-02 91 87 92 NA NA NA NA NA

3 3 Doors D… Kryp… 2000-04-08 81 70 68 67 66 57 54 53

4 3 Doors D… Loser 2000-10-21 76 76 72 69 67 65 55 59

5 504 Boyz Wobb… 2000-04-15 57 34 25 17 17 31 36 49

6 98^0 Give… 2000-08-19 51 39 34 26 26 19 2 2

7 A*Teens Danc… 2000-07-08 97 97 96 95 100 NA NA NA

8 Aaliyah I Do… 2000-01-29 84 62 51 41 38 35 35 38

9 Aaliyah Try … 2000-03-18 59 53 38 28 21 18 16 14

10 Adams, Yo… Open… 2000-08-26 76 76 74 69 68 67 61 58

# ℹ 307 more rows

# ℹ 68 more variables: wk9 <dbl>, wk10 <dbl>, wk11 <dbl>, wk12 <dbl>,

# wk13 <dbl>, wk14 <dbl>, wk15 <dbl>, wk16 <dbl>, wk17 <dbl>, wk18 <dbl>,

# wk19 <dbl>, wk20 <dbl>, wk21 <dbl>, wk22 <dbl>, wk23 <dbl>, wk24 <dbl>,

# wk25 <dbl>, wk26 <dbl>, wk27 <dbl>, wk28 <dbl>, wk29 <dbl>, wk30 <dbl>,

# wk31 <dbl>, wk32 <dbl>, wk33 <dbl>, wk34 <dbl>, wk35 <dbl>, wk36 <dbl>,

# wk37 <dbl>, wk38 <dbl>, wk39 <dbl>, wk40 <dbl>, wk41 <dbl>, wk42 <dbl>, …在这个数据集中,每个观测(行)都是一首歌曲。前三列(“artist”、“track”和“date.entered”)是描述歌曲的变量。在此之后的76 列(“wk1”-“wk76”)描述了该歌曲在发行后每周的排名信息(仅在进入前100名时记录名次信息)。因此,对于“wk1”-“wk76”中的数据,所有的列名是一个变量(周数),每个单元格值则是另一个变量(每周的排名)。因此,这个数据集是不符合整洁数据的要求的。

下面,我们通过pivot_longer()将该数据转换成一个长数据,使其符合整洁数据:

billboard |>

pivot_longer(

cols = starts_with("wk"),

names_to = "week",

values_to = "rank"

)# A tibble: 24,092 × 5

artist track date.entered week rank

<chr> <chr> <date> <chr> <dbl>

1 2 Pac Baby Don't Cry (Keep... 2000-02-26 wk1 87

2 2 Pac Baby Don't Cry (Keep... 2000-02-26 wk2 82

3 2 Pac Baby Don't Cry (Keep... 2000-02-26 wk3 72

4 2 Pac Baby Don't Cry (Keep... 2000-02-26 wk4 77

5 2 Pac Baby Don't Cry (Keep... 2000-02-26 wk5 87

6 2 Pac Baby Don't Cry (Keep... 2000-02-26 wk6 94

7 2 Pac Baby Don't Cry (Keep... 2000-02-26 wk7 99

8 2 Pac Baby Don't Cry (Keep... 2000-02-26 wk8 NA

9 2 Pac Baby Don't Cry (Keep... 2000-02-26 wk9 NA

10 2 Pac Baby Don't Cry (Keep... 2000-02-26 wk10 NA

# ℹ 24,082 more rows-

cols:指定需要转换哪些列,即哪些列不是变量。此参数使用与select()相同的语法(见此前章节),因此在这里我们可以使用!c(artist, track, date.entered)或starts_with("wk")来选择“wk1”到“wk76”列。 -

names_to:转换后的列的列名,即新变量名。这里我们将该变量命名为 “week” 。 -

values_to:指定单元格值所代表的变量的变量名。我们将该变量命名为 “rank”。⚠️注意”week”和”rank”加了引号。

现在,让我们聚焦生成的长数据。如果一首歌进入前 100 名的时间少于 76 周,会发生什么情况?以 2 Pac 的《Baby Don’t Cry》为例。上面的输出结果表明,这首歌在前 100 名中只停留了 7 周,其余的周数都是缺失值。这些缺失值其实并不代表未知观测值,而是转换后的长数据集的结构迫使它们存在,因此我们可以通过设置 values_drop_na = TRUE 来要求 pivot_longer()去掉它们:

billboard |>

pivot_longer(

cols = starts_with("wk"),

names_to = "week",

values_to = "rank",

values_drop_na = TRUE

)# A tibble: 5,307 × 5

artist track date.entered week rank

<chr> <chr> <date> <chr> <dbl>

1 2 Pac Baby Don't Cry (Keep... 2000-02-26 wk1 87

2 2 Pac Baby Don't Cry (Keep... 2000-02-26 wk2 82

3 2 Pac Baby Don't Cry (Keep... 2000-02-26 wk3 72

4 2 Pac Baby Don't Cry (Keep... 2000-02-26 wk4 77

5 2 Pac Baby Don't Cry (Keep... 2000-02-26 wk5 87

6 2 Pac Baby Don't Cry (Keep... 2000-02-26 wk6 94

7 2 Pac Baby Don't Cry (Keep... 2000-02-26 wk7 99

8 2Ge+her The Hardest Part Of ... 2000-09-02 wk1 91

9 2Ge+her The Hardest Part Of ... 2000-09-02 wk2 87

10 2Ge+her The Hardest Part Of ... 2000-09-02 wk3 92

# ℹ 5,297 more rows注意到“week”目前为字符型变量,可以通过readr包中的parse_number()将其转换成数值型变量(详见此前章节),便于后续分析:

billboard_longer <- billboard |>

pivot_longer(

cols = starts_with("wk"),

names_to = "week",

values_to = "rank",

values_drop_na = TRUE

) |>

mutate(

week = parse_number(week)

)

billboard_longer# A tibble: 5,307 × 5

artist track date.entered week rank

<chr> <chr> <date> <dbl> <dbl>

1 2 Pac Baby Don't Cry (Keep... 2000-02-26 1 87

2 2 Pac Baby Don't Cry (Keep... 2000-02-26 2 82

3 2 Pac Baby Don't Cry (Keep... 2000-02-26 3 72

4 2 Pac Baby Don't Cry (Keep... 2000-02-26 4 77

5 2 Pac Baby Don't Cry (Keep... 2000-02-26 5 87

6 2 Pac Baby Don't Cry (Keep... 2000-02-26 6 94

7 2 Pac Baby Don't Cry (Keep... 2000-02-26 7 99

8 2Ge+her The Hardest Part Of ... 2000-09-02 1 91

9 2Ge+her The Hardest Part Of ... 2000-09-02 2 87

10 2Ge+her The Hardest Part Of ... 2000-09-02 3 92

# ℹ 5,297 more rows现在,我们在一个变量中拥有了所有的周数,在另一个变量中拥有了所有的排名值,这样我们就可以很好地直观显示歌曲排名随时间的变化情况。代码如下,结果如 Figure 2 所示。我们可以看到,很少有歌曲能在前 100 名中停留 20 周以上。

billboard_longer |>

ggplot(aes(x = week,

y = rank,

group = track)) +

geom_line(alpha = 0.25) +

scale_y_reverse() +

theme_bw()

Figure 2: 显示歌曲排名随时间变化的折线图

2.1 pivot_longer()的转换原理

假设我们有三个病人,id 分别为 A、B 和 C,我们为每个病人测量了两次血压。这里我们用在此前章节中已经介绍过的 tribble() 来创建这个数据:

df <- tribble(

~id, ~bp1, ~bp2,

"A", 100, 120,

"B", 140, 115,

"C", 120, 125

)该数据集的“bp1”和“bp2”列不符合整洁数据的要求。因此,我们通过pivot_longer()将该数据转换成包含三个变量:id(已存在)、measurement(血压测定次数)和 value(血压值)的新数据:

df |>

pivot_longer(

cols = bp1:bp2,

names_to = "measurement",

values_to = "value"

)# A tibble: 6 × 3

id measurement value

<chr> <chr> <dbl>

1 A bp1 100

2 A bp2 120

3 B bp1 140

4 B bp2 115

5 C bp1 120

6 C bp2 125转换是如何进行的呢?如果我们逐列考虑,就会比较容易理解。如下图所示,在原始数据集中已经是变量的一列(id)的值需要重复,重复的次数等于需要转换的列数。这里我们需要转换的列是“bp1”和“bp2”,因此每个“id”需要重复两次。

旧列名将成为新变量的值,该变量的名称由 names_to 参数定义。

单元格值也会变成一个新变量的值,其名称由 values_to 定义。这些值将逐行填充。

2.2 包含多个变量信息的列名

更具挑战性的情况是,列名中包含了多个变量信息,而我们希望将这些信息分别存储在不同的新变量中。以 who2 数据集为例,该数据集由世界卫生组织收集,记录了肺结核诊断的相关信息:

Table 1: 肺结核病例信息-列名包含多个变量信息

who2# A tibble: 7,240 × 58

country year sp_m_014 sp_m_1524 sp_m_2534 sp_m_3544 sp_m_4554 sp_m_5564

<chr> <dbl> <dbl> <dbl> <dbl> <dbl> <dbl> <dbl>

1 Afghanistan 1980 NA NA NA NA NA NA

2 Afghanistan 1981 NA NA NA NA NA NA

3 Afghanistan 1982 NA NA NA NA NA NA

4 Afghanistan 1983 NA NA NA NA NA NA

5 Afghanistan 1984 NA NA NA NA NA NA

6 Afghanistan 1985 NA NA NA NA NA NA

7 Afghanistan 1986 NA NA NA NA NA NA

8 Afghanistan 1987 NA NA NA NA NA NA

9 Afghanistan 1988 NA NA NA NA NA NA

10 Afghanistan 1989 NA NA NA NA NA NA

# ℹ 7,230 more rows

# ℹ 50 more variables: sp_m_65 <dbl>, sp_f_014 <dbl>, sp_f_1524 <dbl>,

# sp_f_2534 <dbl>, sp_f_3544 <dbl>, sp_f_4554 <dbl>, sp_f_5564 <dbl>,

# sp_f_65 <dbl>, sn_m_014 <dbl>, sn_m_1524 <dbl>, sn_m_2534 <dbl>,

# sn_m_3544 <dbl>, sn_m_4554 <dbl>, sn_m_5564 <dbl>, sn_m_65 <dbl>,

# sn_f_014 <dbl>, sn_f_1524 <dbl>, sn_f_2534 <dbl>, sn_f_3544 <dbl>,

# sn_f_4554 <dbl>, sn_f_5564 <dbl>, sn_f_65 <dbl>, ep_m_014 <dbl>, …# 查看3:56的列名规则

colnames(who2)[3:56] %>%

str_split(

pattern = "_",

simplify = T

) %>%

apply(MARGIN = 2, unique)[[1]]

[1] "sp" "sn" "ep" "rel"

[[2]]

[1] "m" "f"

[[3]]

[1] "014" "1524" "2534" "3544" "4554" "5564" "65" 可以看到,该数据的前两列“country”和“year”是正常的变量。剩余的56列,每一列的名称都由三个部分组成,中间用 “_” 分隔:

-

第一部分为“sp/rel/ep”,代表采用的诊断方法;

-

第二部分为“m/f” ,代表性别;

-